一篇发表在2025年《自然·机器智能》(Nature Machine Intelligence)上的研究,像一颗深水炸弹,炸开了人工智能和人类认知之间最深的那道墙。

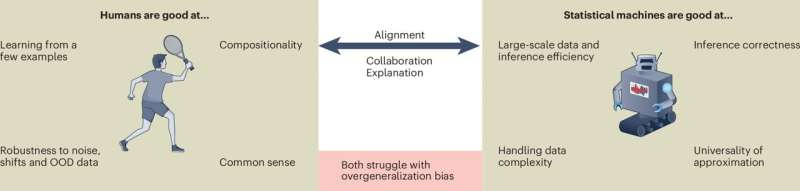

这篇由二十多位国际顶尖专家联手的研究,它告诉我们,AI和人类在“泛化能力”上,压根就不是一回事。

什么叫泛化能力?说白了,就是举一反三、活学活用的本事。

你给一个小孩看几把椅子,他就能认识世界上所有的椅子,甚至能把一个没见过的墩子也叫“椅子”,因为他理解了“椅子是用来坐的”这个抽象概念。

AI呢?你给它看一百万张椅子的照片,它能以极高的精度认出第一百万零一张椅子。但如果这张椅子是一个没见过的墩子,它可能就懵了。

咱们聊的不是一回事

研究牵头人之一,Benjamin Paassen教授一针见血地指出:“‘泛化’对AI和人类来说,意味着完全不同的事情”。

这就是问题的核心。

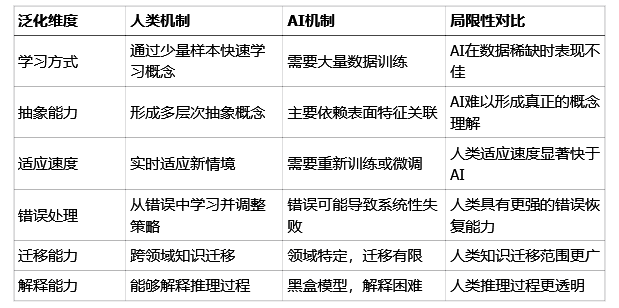

人类的泛化,走的是一条“抽象”的路。我们看世界,会自动忽略掉那些不重要的细节,比如椅子的颜色、材质、高矮,然后抓住最本质的特征——“有个平面能支撑屁股”。这个过程,是概念思维。我们的大脑里形成了一个关于“椅子”的灵活框架,可以套用在任何新事物上。

AI的泛化,走的是一条“统计”的路。它没有“概念”,只有“模式”。在它眼里,椅子不是一个功能性的东西,而是一堆像素点的特定组合。它通过学习海量数据,记住哪些像素组合最可能被标记为“椅子”。这更像是暴力破解,而不是真正的理解。

所以,人类的学习是高效的。一个概念,看几个例子就通了。

AI的学习是笨重的。一个概念,需要成千上万,甚至数百万个数据样本去喂养,才能勉强“记住”模式。

这就引出了一个更深层的问题:大脑和算法的底层逻辑,到底有什么不同?

一个灵活一个死板

我们的大脑里,有个叫“前额叶皮层”的地方,它就像一个总指挥官,负责认知灵活性。当老办法行不通时,它会立刻跳出来,抑制住你的习惯性动作,让你尝试新的解决方案。那些前额叶受损的病人,做日常老一套的事情没问题,但凡需要一点创新或适应新规则,就抓瞎了。

大脑还有一套非常聪明的“双过程系统”。

系统1,是直觉系统,快、自动、不费脑子,凭感觉走。比如你一眼认出朋友,或者开车时下意识地踩刹车。

系统2,是分析系统,慢、刻意、非常费劲,负责逻辑推理。比如你做一道复杂的数学题,或者规划一次长途旅行。

人类牛就牛在,我们能在这两个系统之间无缝切换,根据情况决定是“凭感觉”还是“过脑子”。

AI系统呢?它基本上只有一个“系统1”,而且还是个固化版的。它的模型在训练好之后,参数就基本固定了,形成一个固定的解决方案。遇到新问题,它不会灵活切换策略,最多就是在原有模式里找一个最像的答案。想让它真正适应,唯一的办法就是“回炉重造”——用新的数据重新训练一遍。

这种底层架构的差异,直接导致了性能上的天壤之别。

AI与人类PK

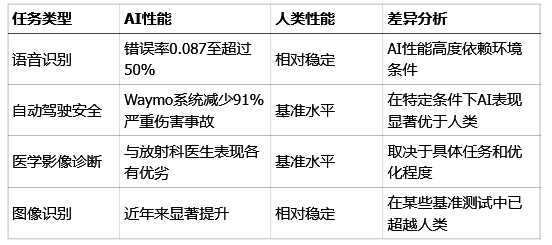

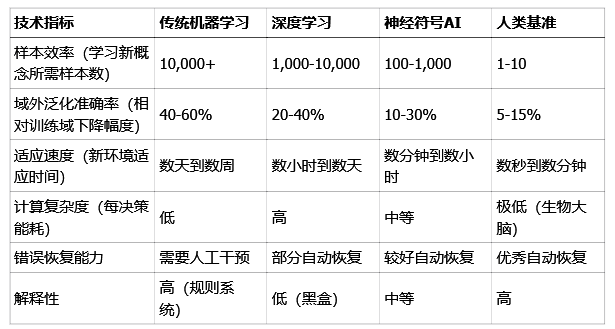

看看下面这张表,AI和人类在几个关键任务上的表现,差异一目了然。

表1:AI与人类在不同任务上的性能对比

你看,在规则明确、环境可控的场景下,AI是神。比如自动驾驶,谷歌的Waymo系统在特定条件下,能把严重伤害事故减少91%,比人类司机稳多了。

可一旦环境变得复杂多变,AI就立刻“拉胯”。比如语音识别,在安静的实验室里,AI的错误率可能极低,可一到嘈杂的马路边,它的错误率能飙升到50%以上,连话都听不清了。人类却没这个问题,我们在菜市场照样能聊天。

为什么?因为AI的泛化是“域内”的,它只能处理和训练数据分布相似的情况。一旦遇到“域外”(Out-of-Domain)的情况,比如没见过的口音、突如其来的噪音,它的性能就会断崖式下跌。

这背后的机制差异,下面这张表总结得更清楚。

表2:AI与人类泛化机制对比

AI是个偏科严重的“天才书呆子”,在它擅长的领域能碾压人类,但综合素质和适应能力被人类吊打。

为了更精确地量化这种差异,我们还可以看一些更硬核的技术参数。

表3:AI系统在不同泛化任务上的性能参数

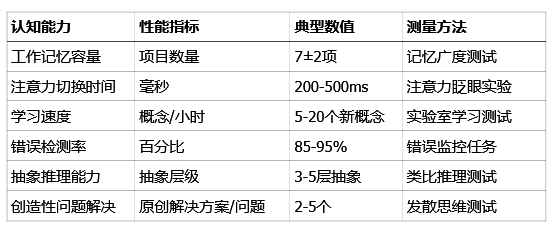

再看看人类大脑这个“生物处理器”的性能参数。

表4:人类认知系统性能参数

对比这两张表,你会发现,AI在算力上是怪物,但在效率、适应性和抽象能力上,离人脑还差得远。

那么,搞清楚这些差异,到底有什么用?

未来是人机协作,不是谁取代谁

用处太大了。它彻底改变了我们设计人机协作系统的思路。

以前,我们总想让AI变得更像人,甚至取代人。现在我们明白了,这是条死胡同。它们根本就不是一个“物种”。

未来的方向,不是替代,而是互补。

就像一个完美的搭档,AI负责它擅长的:处理海量数据、执行重复性任务、在规则明确的领域里做决策。人类则负责我们擅长的:处理模糊和不确定的情况、进行创造性思考、做出涉及伦理和价值观的判断。

在医疗领域,AI可以像个不知疲倦的显微镜,在成千上万张医学影像中标记出可疑的病灶,但最终的诊断和治疗方案,必须由医生来定夺。因为医生不仅看片子,还看病人,他需要结合病人的情绪、家庭状况和伦理考量来做决策,这些是AI无法量化的。

在自动驾驶领域,AI可以处理99%的常规路况,遵守交通规则比任何人都严格。但当遇到一个皮球滚到马路上,后面可能跟着一个孩子的极端场景时,需要人类的常识和瞬间决断力来介入。

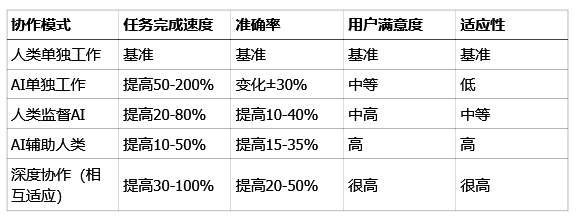

这种“AI辅助人类”或“人类监督AI”的协作模式,效果惊人。

表5:人机协作系统性能参数

数据清晰地显示,当人机形成有效协作时,无论是速度、准确率还是适应性,都远超任何一方单打独斗。

这篇《自然·机器智能》的研究,为我们指明了方向。未来的AI发展,重点不再是单纯地刷榜、追求更高的测试分数,而是要研究如何让AI更好地理解人类,如何设计出更透明、更可解释的系统,让人类能够信任并与之高效协作。

这需要计算机科学家、认知科学家、神经科学家甚至人文社科学者一起努力。

你觉得在你的工作领域,AI应该扮演一个什么样的角色?