据介绍,作为业界首个 13B 级别的 MoE 开源混合推理模型,混元-A13B(Hunyuan-A13B)总参数量达 800 亿,激活参数为 130 亿,不仅在效果上达到了高标准,而且在尺寸上也做到了极致的优化,成功平衡了模型性能与资源占用。

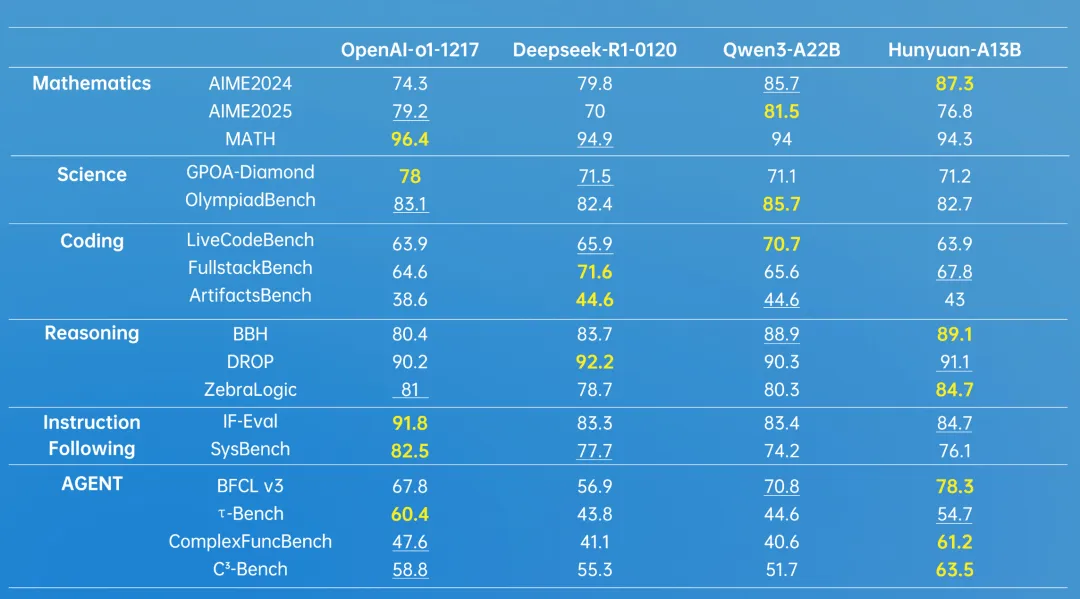

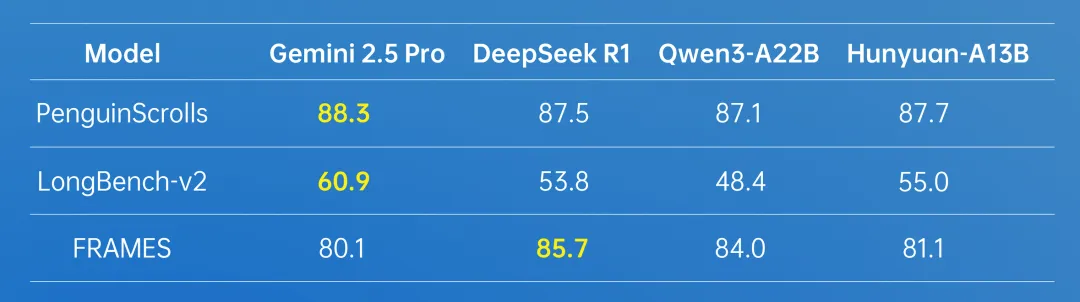

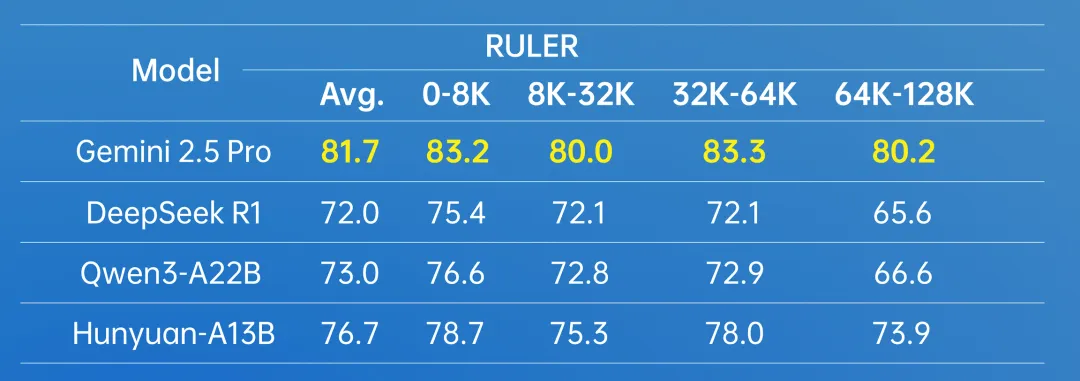

从混元官方发布的 benchmark 测试结果来看:Hunyuan-A13B 在多个代码和数学任务上都取得了最高分数。在 MMLU、MMLU-PRO 等诸多众聚合任务上,Hunyuan-A13B 达到了与 Qwen3-A22B 模型同等的水平,表现出优秀的综合能力。

摩尔线程积极响应开源社区的号召,旨在让更多开发者基于国产全功能 GPU 进行 AI 应用创新。此前,摩尔线程在深度求索 DeepSeek、通义千问 QwQ-32B 和 Qwen3 等模型的发布当日,就成功实现了 Day-0 支持。

关于腾讯混元-A13B 模型的详细信息,AI在线此前进行了详细报道,感兴趣的朋友可以自行查看。