据介绍,MT-MegatronLM 是面向全功能 GPU 的开源混合并行训练框架,支持 dense 模型、多模态模型及 MoE(混合专家)模型的高效训练;MT-TransformerEngine 主要用于 Transformer 模型的训练与推理优化,通过算子融合、并行加速策略等技术,释放摩尔线程全功能 GPU 高密度计算的潜力和 memory bound 算子效率。两大框架的技术突破体现在硬件适配与算法创新的深度协同:

混合并行训练:支持 Dense、多模态及 MoE 模型的混合并行训练,可灵活应对不同模型架构的复杂运算场景;

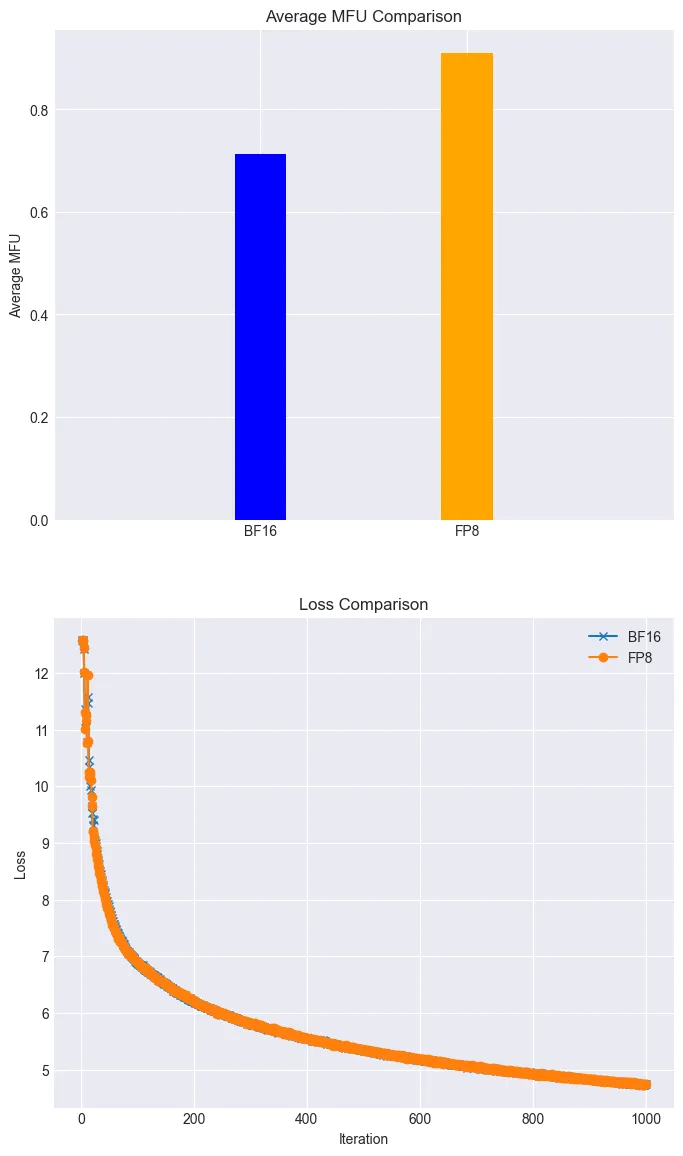

FP8 混合训练策略:结合摩尔线程 GPU 原生支持的 FP8 混合精度训练策略,能够有效提升训练效率;

高性能算子库:通过高性能算子库 muDNN 与通信库 MCCL 的深度集成,系统性优化了计算密集型任务与多卡协同的通信开销;同时结合摩尔线程开源 Simumax 库,可自动进行并行策略搜索,并针对不同模型和加速环境 spec 最大化并行训练性能;

异常训练处理:框架内置的 rewind 异常恢复机制,可自动回滚至最近稳定节点继续训练,大幅提升大规模训练的稳定性;

完整的兼容性:两个框架兼容 GPU 主流生态,既保障了现有生态的平滑迁移,也为开发者构建自有的 AI 技术栈提供了底层支撑。

实际应用效果如下:

高效训练:在全功能 GPU 集群上,Llama3 8B 模型的训练任务,可以利用 FP8 在 loss 几乎无损的情况下 MFU 达到 90% 以上;(如下图所示)

▲ 利用摩尔线程 FP8 混合精度加速技术在 loss 无损的情况下得到 28% 的加速

复现 DeepSeek 满血版训练:摩尔线程已深度集成并开源对 DeepSeek 并行算法 DualPipe 的高效支持,MT-DualPipe 可以完整接入 MT-Megatron 框架和 MT-TransformerEngine 框架,成功实现 DeepSeek V3 训练流程的完整复现,支持 MLA、MTP 及多种专家平衡策略;

性能大幅优化:通过多种 Transformer 算子融合技术,显著提升了内存带宽利用率,有效缓解 memory bound 瓶颈,进一步释放国产 GPU 的硬件潜力。

摩尔线程官方表示将持续优化 MT-MegatronLM 与 MT-TransformerEngine 框架,并引入系列功能,具体如下:

Dual Pipe / ZeroBubble 并行策略:进一步降低气泡率,提升并行训练效率;

多种 FP8 优化策略:独创的 FP8 优化策略,提高训练的性能和稳定性;

异步 checkpoint 策略:提高训练过程中的容错能力和效率;

优化后的重计算策略:减少计算和显存开销,提高训练速度;

容错训练策略:独创的容错训练算法,增强训练过程中的容错能力;

集成摩尔线程 FlashMLA 和 DeepGemm 库:进一步释放摩尔线程 GPU 的算力和 FP8 计算能力,提升计算性能和效率。

AI在线附开源地址如下:

MT-MegatronLM 开源地址:https://github.com/MooreThreads/MT-MegatronLM

MT-TransformerEngine 开源地址:https://github.com/MooreThreads/MT-TransformerEngine

摩尔线程 Simumax 开源地址:https://github.com/MooreThreads/SimuMax