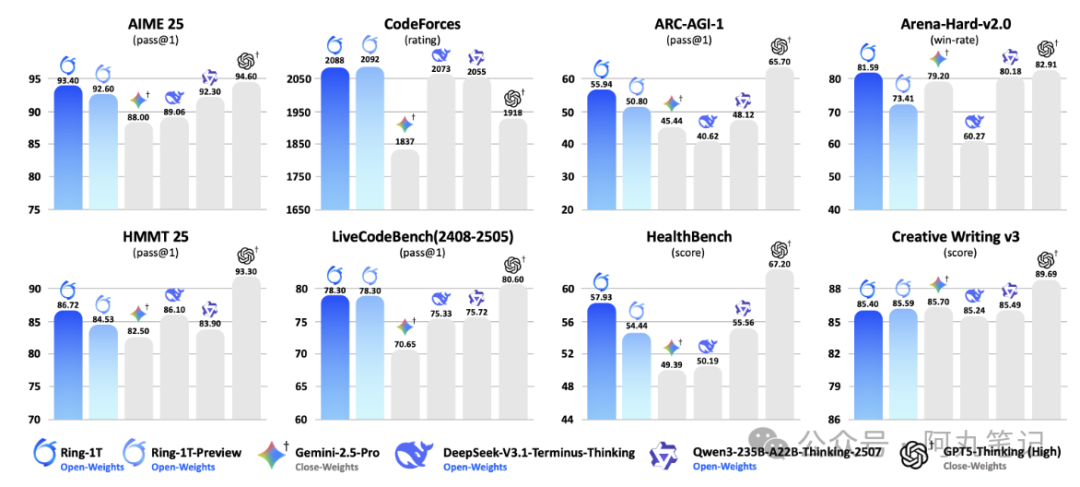

92.6分 vs 94.6分——当我看到蚂蚁集团刚发布的Ring-1T模型在AIME25测试中的成绩时,第一反应是有点不敢相信。一个国产开源模型,居然能在数学推理上逼近GPT-5的水平?

更震撼的是,这个叫Ring-1T的模型在模拟IMO(国际数学奥林匹克)近十年真题的测试中,正确率达到了银牌选手平均水平的93%。要知道,IMO可是被誉为"数学天才摇篮"的顶级竞赛,能在这里拿银牌的,基本都是各国数学界的未来之星。

我特意去查了一下这个模型的技术细节。Ring-1T采用了万亿参数规模,但实际激活的只有约51B参数,这种MoE(专家混合)架构让它既有大模型的能力,又保持了相对高效的推理速度。

国产AI的"奥数银牌"有多厉害?

说实话,刚开始我对这个"银牌水平"也没什么概念。后来仔细了解了一下,才发现这个成绩有多震撼。

IMO每年只有大约600名选手参赛,代表的是全球100多个国家和地区的数学尖子生。能拿到银牌,意味着在这600人中排进前40%左右。而Ring-1T能达到银牌选手93%的正确率,基本上就是说它的数学推理能力已经超越了全球大部分的数学天才。

更有意思的是,Ring-1T在组合数学和不等式证明这两个最难的题型上表现尤其突出。这些题目往往需要很强的逻辑推理能力和创新思维,不是简单的公式套用就能解决的。

开源vs闭源:一场认知的较量

这里有个很有意思的对比。OpenAI的GPT-5、Google的Gemini这些顶级模型,基本都是闭源的,你只能通过API调用,看不到内部的技术细节。而蚂蚁这次直接把Ring-1T开源了,代码、模型权重、训练数据全部公开。

从商业角度看,这确实有点"反直觉"。毕竟训练一个万亿参数的模型,成本少说也得几千万美元。但从技术发展的角度,这种开源策略可能更有远见。

全球开发者可以基于Ring-1T进行二次开发,这意味着这个模型的能力会在无数人的贡献下快速迭代和提升。

我想起了Linux和Android的发展历程。正是因为开源,它们才能在短时间内聚集全球最优秀的开发者,最终在各自领域占据主导地位。

技术细节:万亿参数背后的巧思

Ring-1T的技术架构挺有意思的。它采用了Ling 2.0架构,前4层是密集结构,后76层是MoE结构,总共有256个专家模块。

这种设计的好处是什么呢?简单来说,就是让模型既聪明又高效。万亿参数听起来很吓人,但实际推理时只激活51B参数,这样既保证了能力,又控制了计算成本。就像一个超级图书馆,虽然有无数本书,但你每次只需要找到最相关的那几本就够了。

更厉害的是,蚂蚁还自研了一套叫"棒冰"(Icepop)的训练方法,结合高效强化学习系统ASystem,专门针对推理能力进行了多阶段训练。这就解释了为什么Ring-1T在数学推理上表现这么突出。

实测体验:不只是数学天才

我看到有开发者已经开始测试Ring-1T了,发现它不只是在数学推理上厉害,在代码生成、逻辑推理、创意写作等方面也表现不错。

比如让它写一个贪吃蛇小游戏,Ring-1T不仅能生成完整的代码,还会主动优化游戏逻辑,添加一些有趣的功能。在处理复杂的逻辑推理题时,它的思路也很清晰,不会像有些模型那样绕来绕去。

当然,作为一个刚发布的模型,Ring-1T肯定还有一些不足。比如在某些需要大量背景知识的领域,它可能还不如GPT-4那么全面。但考虑到它是开源的,这些问题应该会在社区的贡献下快速改善。

这意味着什么?

Ring-1T的发布,我觉得有几个层面的意义。

首先,它证明了国产AI在技术上已经能够与国际顶级模型正面竞争。92.6分 vs 94.6分,这个差距已经小到可以忽略不计了。

其次,开源策略可能会改变整个AI行业的竞争格局。当一个接近GPT-5水平的模型完全免费开放时,那些收费的闭源模型就必须提供更大的价值才能维持竞争力。

最后,对于开发者来说,这绝对是个好消息。不用再为了使用顶级AI能力而支付高昂的API费用,可以直接在本地部署和定制化开发。

不过话说回来,技术突破只是第一步。Ring-1T能不能真正在应用层面挑战GPT-5,还要看它在实际使用中的表现,以及社区的接受程度。

但至少现在,我们可以说:国产AI在数学推理这个最能体现"智能"的领域,已经站到了世界第一梯队。这个银牌,拿得挺有分量的。