随着推理大模型和思维链的出现与普及,大模型具备了「深度思考」的能力,不同任务的泛用性得到了很大的提高。

借助思维链,大模型能够对任务进行深入分析,完成任务规划与拆解,从而胜任长周期、复杂度高的工作。同时,我们也能更直观地了解模型的推理与分析过程,从中发现执行环节中的问题,并有针对性地调整指令,以更高效地完成目标。

可以说,有了「深度思考」的推理模型,才有了现在拥有多种辅助功能与自主能力的 AI 智能体。

但现在的大模型渐渐有些偏科了。为了构建应用能力更强的智能体,对长周期的复杂任务能力的追求已经影响到了大模型的推理模式。

不知道大家在平常使用 AI 工具的时候有没有发现,打开了深度思考后,一些简单的任务也需要很多的思考,展示了非常冗长的思维链,而不打开深度思考的时候,又很难准确的得到想要的回复。

这种现象越来越明显了,尤其是当大模型进入工作流(例如编码工作)的时候,其负面效应就更加显著。

这不,AI 领域的大牛 Andrej Karpathy 也感觉到不对劲,发了长文推来指出这个令人无语的现象。

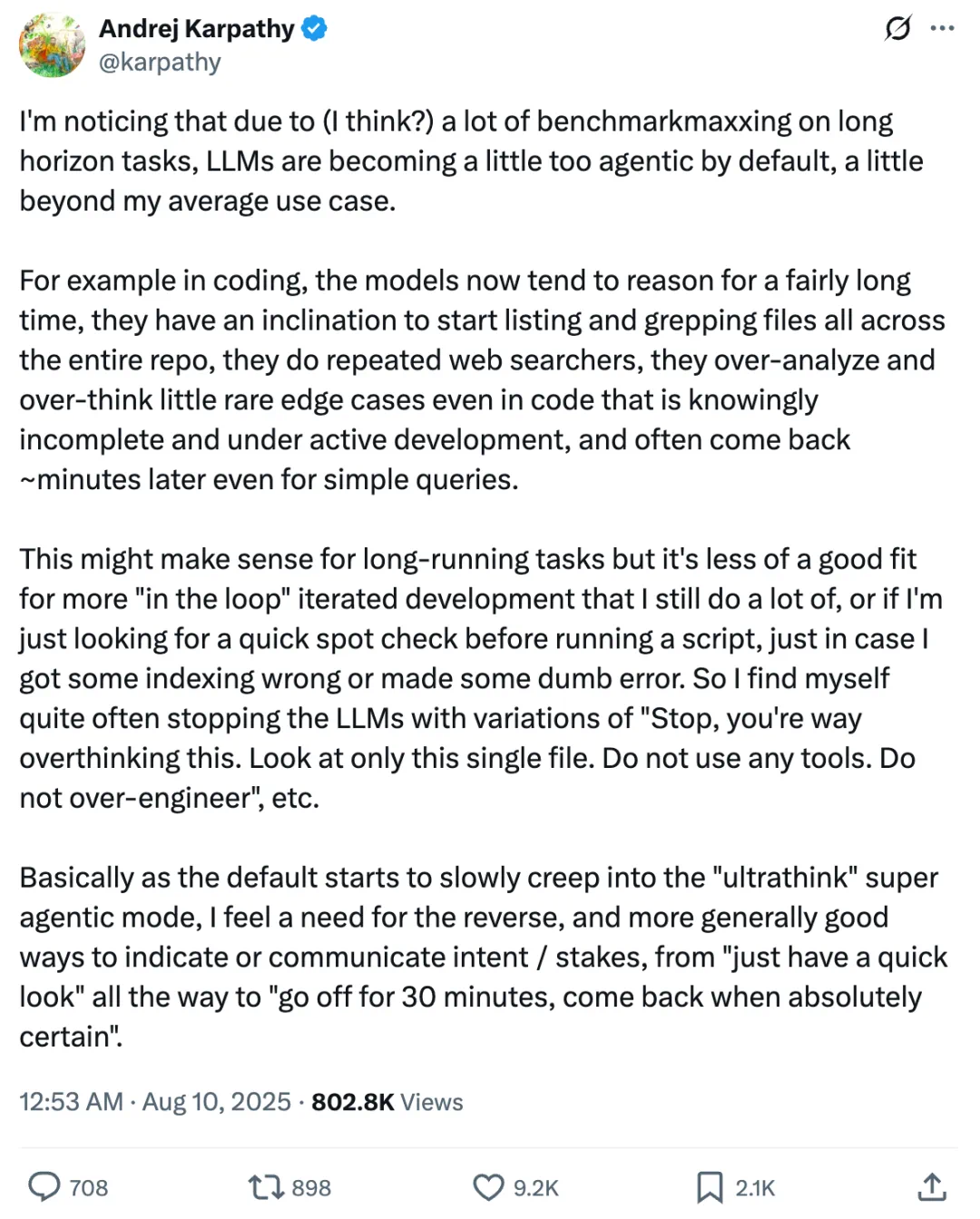

Karpathy 说,「LLM 在默认状态下正变得比我日常使用需求更具『自主代理(Agentic)』倾向,甚至有些超出了我的平均使用场景」。

最明显的的确是编码任务,模型现在往往会进行较长时间的推理,倾向于在整个代码库中列出并搜索(grep)文件,会反复进行网络搜索,对一些在开发中、且明显并不完整的代码里极少出现的边缘情况过度分析、过度思考,甚至在非常简单的查询中,也常常需要几分钟后才返回结果。

尤其是在简单的任务中,比如在运行脚本前快速检查索引错误或其他低级错误,根本不需要如此复杂的任务分析和代码处理。

因此 Karpathy 不得不经常打断 LLM,并用类似这样的指令限制它:「停,你想得太多了。只看这一份文件。不要用任何工具。不要过度设计。」

这带来了很多麻烦,不仅是在编码任务,我们发现日常使用 LLM 工具时候的类似打断情况也越来越多了。

简单拿刚发布几天的 GPT-5 举个例子,发布时 OpenAI 显然意识到深度思考的问题,所以他们强调 GPT-5 是一个集成模型,也就是说,你用它的时候不需要在不同模型之间切换,它会自己决定何时需要深入思考。

但这个问题显然没有这么简单。记得当时 GPT-4o 模型的图像编辑生成功能很好用,但在更新到新模型后就不太一样了。

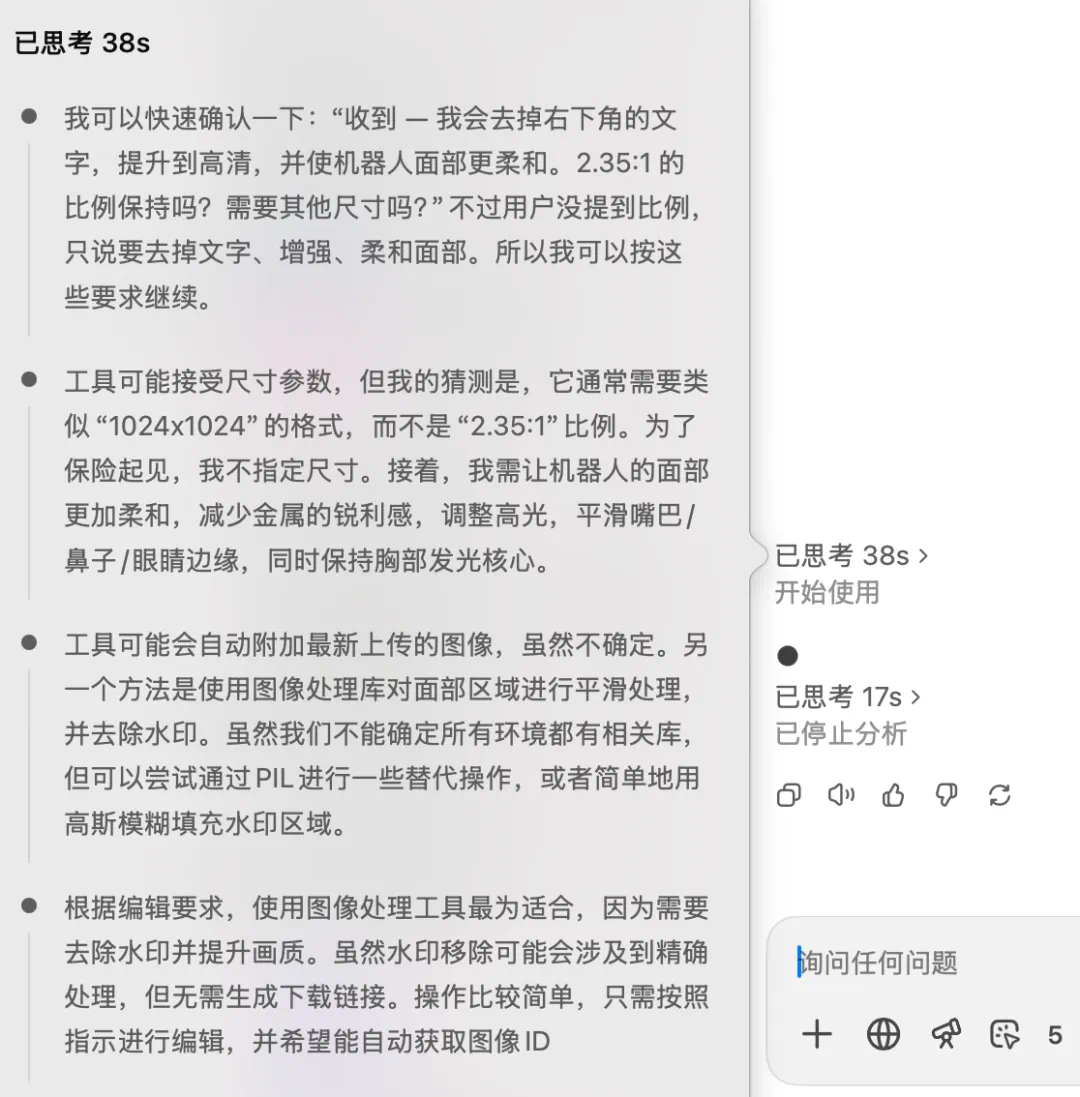

我们给了 GPT-5 这个指令:「去除图中文字,把这张图变得高清一些,机器人的脸看起来更温和一些」,希望它能够调用图像编辑的功能。

但结果它就开始进行「深度思考」了:

经过了 38 秒的思考,它考虑了很多细节,但仍然未能开始使用图像生成功能,导致不得不打断它的任务进程。

或许这也是用户们无比怀念 GPT-4o 的原因之一。

正如 Karpathy 指出的,随着默认模式逐渐向这种「超深度思考」的高代理化状态靠拢,我们反而更需要一个相反的选项 —— 一种更直接有效的方式去表达或传达我的意图和任务的紧迫程度,从「快速看一眼」到「花 30 分钟彻底确认后再回来」都能精确指定。

网友们也苦「过度思考」久矣,甚至为此回到了最朴素的使用方法。

对于这件事,Karpathy觉得罪魁祸首似乎是大模型「在长周期任务上进行了大量基准测试优化」,为了在基准测试上得到更好的成绩,LLM的思考就更倾向于长周期的复杂任务的实现,因此影响了普通任务的响应。

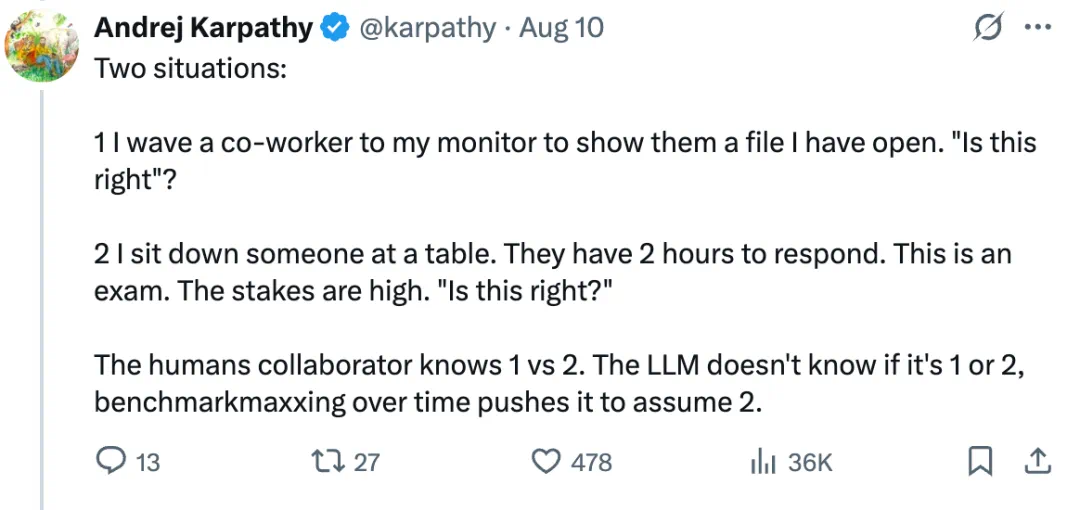

他指出了两种情境:

1. 我招呼同事过来看我屏幕上打开的一个文件,问他「这样对吗?」

2. 我让某人坐在桌前,他们有 2 个小时来作答。这是一场考试, 风险很高。题目是「这样对吗?」

人类协作者能很自然地区分情境 1 和情境 2。但 LLM 并不知道你问的是 1 还是 2,而随着时间推移、基准测试的不断「极限化」,它会越来越倾向于假设你问的是情境 2。

这指出了大模型过度思考,复杂化任务的可能原因,大模型的发展不能完全以基准测试分数作为追求。

关于大模型的「过度思考」,有相关经历和想法欢迎在评论区分享。