鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

Kimi K2 Thinking,现已发布并开源!

主打一个“模型即Agent”,不仅是Kimi“迄今能力最强的开源思考模型”,还掌握边思考,边使用工具的能力——

无需人工干预,即可执行200-300次连续工具调用。

作为今年最受关注的开源模型系列之一,Kimi K2的Thinking版本一上线,就成为热议对象:再次缩小了开源模型与闭源模型的差距。

更多技术细节速览在此:

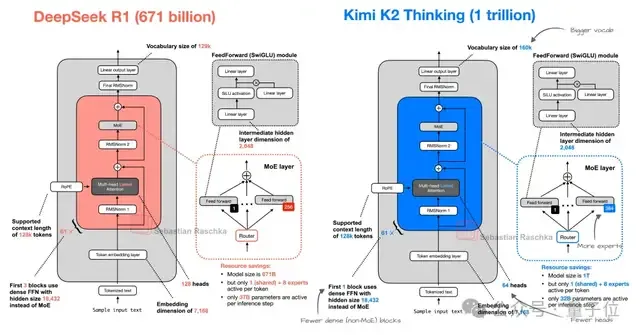

- 1TB参数,激活参数32B,采用INT4而非FP8。

- 256K上下文窗口。

- 更多专家,更少head,更多思考。

△与DeepSeek R1的架构对比,图源x@rasbt

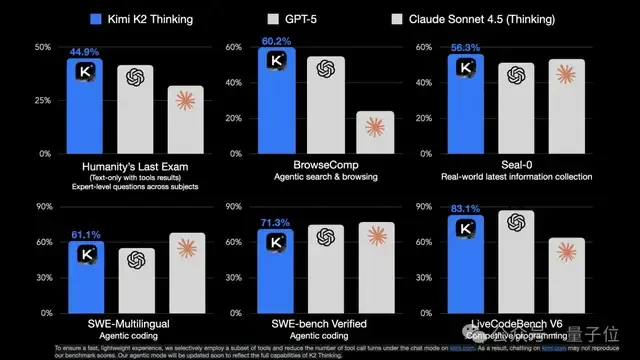

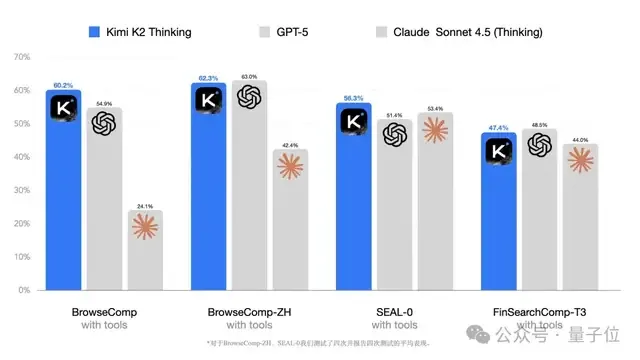

在人类最后的考试(HLE)、测试自主网络浏览能力的BrowseComp,和复杂信息收集推理基准测试SEAL-0等评测基准中,Kimi K2 Thinking都刷新了SOTA,超越GPT-5、Claude Sonnet 4.5(Thinking)等闭源模型。

Kimi K2 Thinking的代码和权重均遵循最为宽松的MIT协议。新模型也已第一时间上线kimi.com和最新版Kimi手机应用,即刻就能实测体验。API可通过Kimi开放平台访问。

官方提到,K2 Thinking是月之暗面在Test-Time Scaling(测试时扩展)领域的最新进展,通过同时扩展思考Token和工具调用轮次,模型实现了更强的Agent和推理性能。

智能体、推理能力全面提升

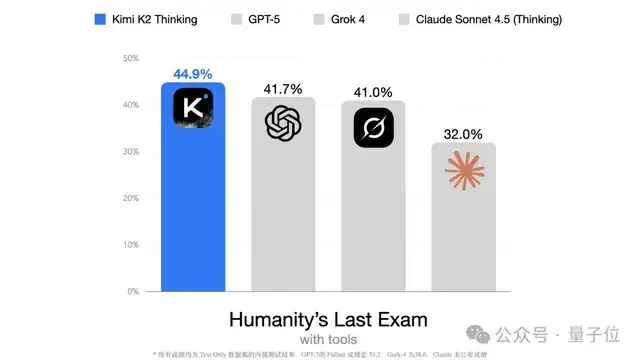

体现在测试上,在人类最后的考试(HLE)中,允许使用工具——搜索、Python、网络浏览工具的同等情况下,Kimi K2 Thinking取得了44.9%的SOTA成绩。

官方还放出了一个通过23次推理和工具调用,K2 Thinking成功解决博士级别数学问题的示例。

第三方测试也印证了其智能体能力的提升:

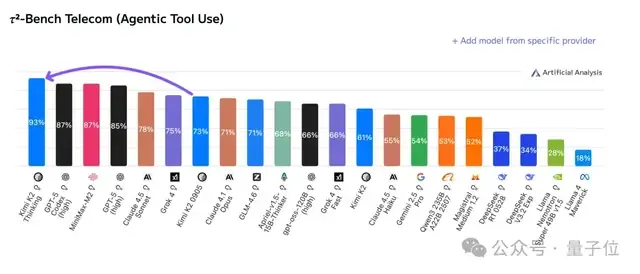

Artificial Analysis在²-Bench Telecom智能体工具使用基准中测试了Kimi K2 Thinking。

结果显示,Kimi K2 Thinking达到SOTA,在智能体场景下,比此前广受好评的K2 Instruct更进一大步(73%→93%)。

自主搜索与浏览能力全面提升

在复杂搜索和浏览场景中,Kimi K2 Thinking也表现出色。

在人类平均智能取得29.2%分数的BrowseComp上,Kimi K2 Thinking展现出“刨根问底”的钻研能力,以60.2%的成绩成为新的SOTA模型。

在长程规划和自主搜索能力的驱动下,Kimi K2 Thinking可借助多达上百轮的“思考→搜索→浏览网页→思考→编程”动态循环,持续地提出并完善假设、验证证据、进行推理,并构建出逻辑一致的答案。

这种边主动搜索边持续思考的能力,使Kimi K2 Thinking能够将模糊且开放式的问题分解为清晰、可执行的子任务。

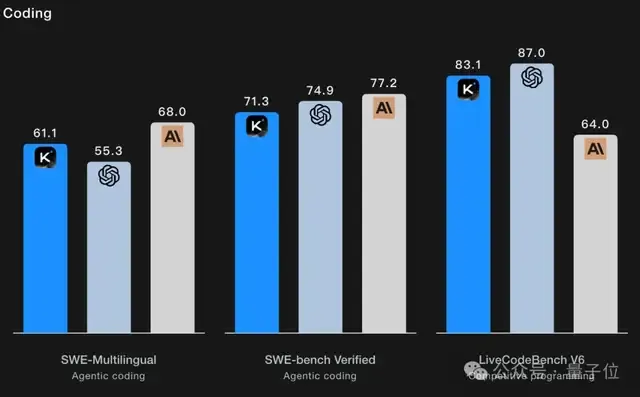

Agentic编程能力增强

编程方面,在SWE-Multilingual、SWE-bench验证集,和LiveCodeBench等测试基准中,Kimi K2 Thinking也能和最强闭源模型GPT-5、Claude Sonnet 4.5等打得有来有回。

官方提到,Kimi K2 Thinking在处理 HTML、React以及组件丰富的前端任务时性能有明显提升,能将创意转变为功能齐全、响应式的产品。

在Agentic Coding场景中,Kimi K2 Thinking能在调用各种工具的同时进行思考,灵活地融入software agents中,处理更复杂、多步骤的开发工作流。

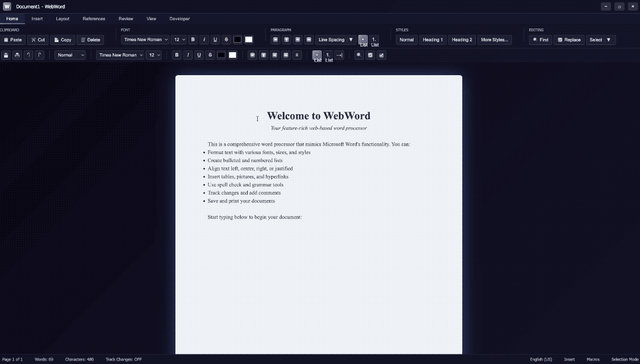

比如,复刻一个真实可用的Word文字编辑器。

又比如创造一个华丽风格的voxel art作品:

通用基础能力升级

在智能体和推理能力的主线之外,Kimi K2 Thinking的通用基础能力也获得了升级。

创意写作:Kimi K2 Thinking显著提升了写作能力,能将粗略的灵感转化为清晰、动人且意图明确的叙述,使其兼具韵律感和深度。它能驾驭微妙的文风差异和模糊的结构,并在长篇大论中保持风格的连贯性。在创意写作方面,它笔下的意象更生动,情感共鸣更强烈,将精准的表达与丰富的表现力融为一体。

学术与研究:在学术研究和专业领域,Kimi K2 Thinking在分析深度、信息准确性和逻辑结构方面均有显著提升。它能剖析复杂的指令,并以清晰严谨的方式拓展思路。这使其尤其擅长处理学术论文、技术摘要,以及那些对信息完整性和推理质量要求极高的长篇报告。

个人与情感:在回应个人或情感类问题时,Kimi K2 Thinking的回答更富同理心,立场也更中正平和。不仅思考更深入且明确,能提供细致入微的观点和切实可行的后续建议,还更有人情味。

值得注意的一点是,K2 Kimi Thinking用的是INT4而非FP8精度。

官方的解释是,思考模型会产生极长的解码长度,常规的量化手段往往会导致模型性能大幅下降。为了克服这一挑战,他们在后训练阶段采用了量化感知训练(QAT),并对MoE组件应用了INT4纯权重(weight-only)量化。

这使得Kimi K2 Thinking能够在复杂推理和Agentic任务中支持原生的INT4推理,并将生成速度提升了约2倍。

以及,INT4对推理硬件的兼容性更强,对国产加速计算芯片更友好。

p.s. Blackwell之前的英伟达GPU不支持FP4。

更多测试实例,可以在官方技术博客中查看,我们也第一时间简单测试了一波(仅开启长思考模式,未联网)。

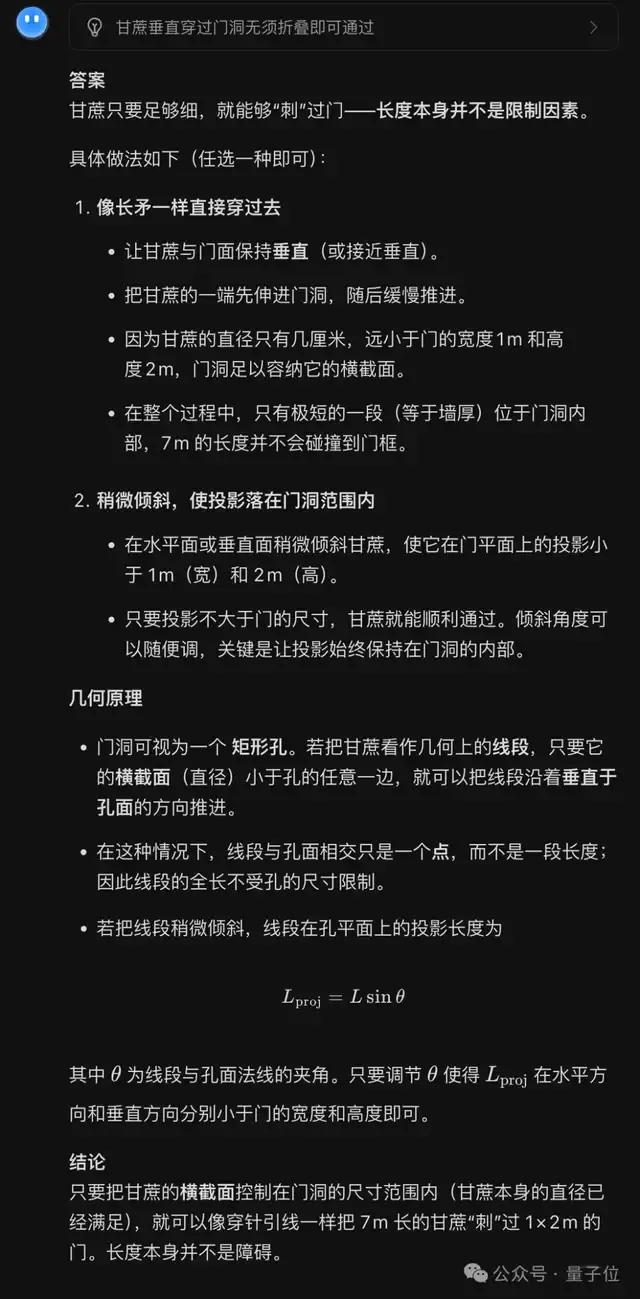

经典题:

一根7米长的甘蔗如何通过1×2米的门

思考了将近5分钟,Kimi给出的回答是:

思考的时间是有点长,但Kimi K2 Thinking成功绕过了这道题目中的陷阱,想到了门的长宽其实并不会限制甘蔗的通过。

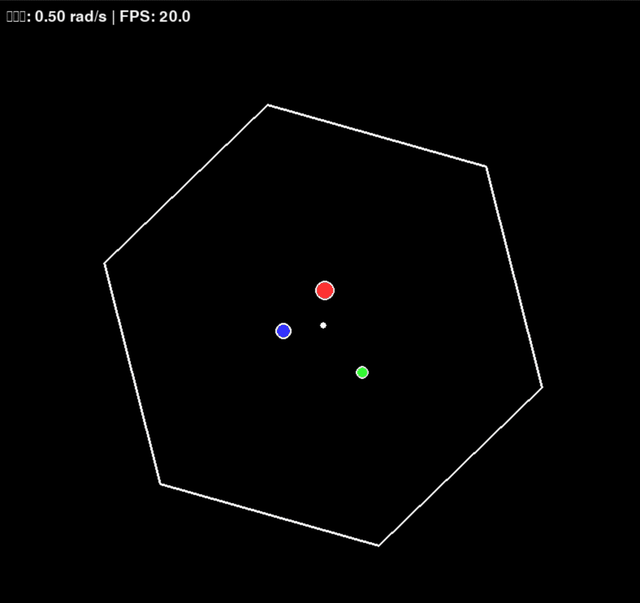

编程方面,我们测试的题目是:

编写一个Python程序,让一个小球在旋转的六边形内弹跳,小球运动遵循物理规律

这一次,Kimi K2 Thinking很快就开始上手编写代码了。

这个表现你觉得如何?

如果你也已经上手实测,欢迎在评论区与我们分享更多测试结果~

项目地址:https://huggingface.co/moonshotai/Kimi-K2-Thinking技术博客链接:https://moonshotai.github.io/Kimi-K2/thinking.html

参考链接:[1]https://x.com/Kimi_Moonshot/status/1986449512538513505[2]https://x.com/ArtificialAnlys/status/1986541785511043536[3]https://mp.weixin.qq.com/s/oQp1kFpoYFhYQ8GzbwZLyA

— 完 —