那个拒绝了小扎15亿美元薪酬包的机器学习大神,还是加入Meta了。

OpenAI前CTO Mira Murati创业公司Thinking Machines Lab证实,联创、首席架构师Andrew Tulloch已经离职去了Meta。

按照公司发言人的说法,Tulloch离职的理由是“出于个人原因决定走一条不同的道路”,其本人则未给出回应。

但对于Tulloch的离职,还是有网友感到不解,表示如果Thinking Machines Lab估值是120亿美元,Tulloch起码能拿到10%,实在是想象不到他的离职理由。

有人调侃说,可能是Tulloch“已经完成思考”了吧。

11年Meta老员工“重归故里”

Tulloch这次跳槽到Meta,也可以算是“重归故里”,之前他曾经在Meta(包括Facebook时期)干了11年。

曾与Tulloch共事的Facebook前高管Mike Vernal评价说,“他绝对是个天才”。

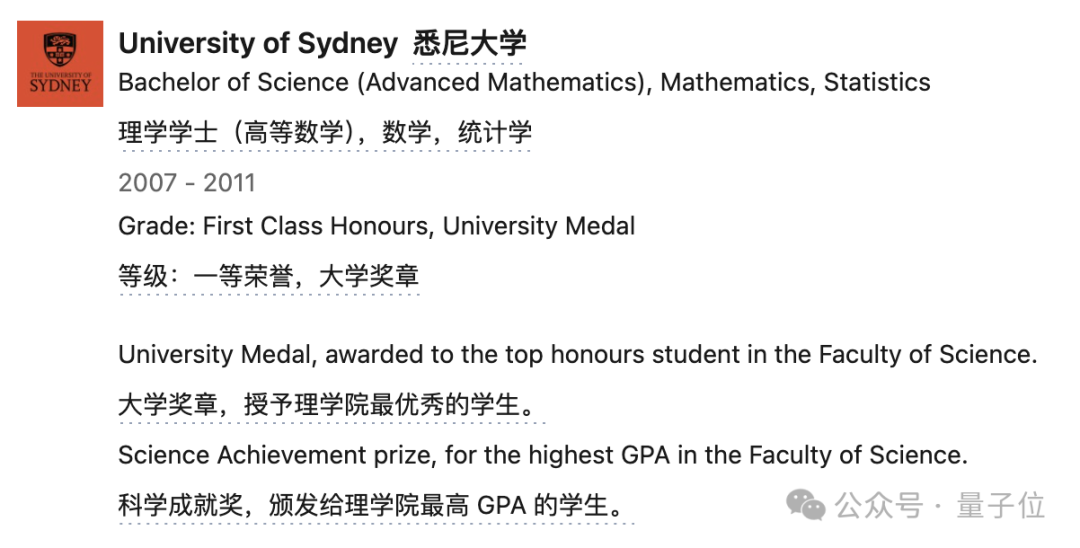

Tulloch来自澳大利亚,2011年本科毕业于悉尼大学,专业是数学与统计学,其间他是悉尼大学理学院最优秀的学生之一,获得过一等荣誉(First Class Honours)和大学奖章(University Medal)。

本科毕业前,Tulloch到金融巨头高盛实习,开发金融产品并制定交易策略,并一直工作到了毕业之后的2012年2月。

之后Tulloch的金融生涯便画上了句号,同年4月,他正式入职Facebook,从事了18个月的机器学习工作。

再然后又于2013-2014年攻读了剑桥大学的数理统计、统计学与机器学习硕士,表现优异,荣获三一学院颁发的奖项,并因在考试中取得最高分而获得荣誉。

在Facebook期间的另一个插曲是,Tulloch在2016年收到了OpenAI总裁Brockman的邀请,希望他成为OpenAI的首批员工。

但OpenAI当时开出的薪酬只有17.5万美元外加12.5万美元奖金,而彼时Facebook给他的年薪已经是80万美元,并且还有继续上涨的空间。

他坦率地讲自己对薪酬下降的担忧告诉了还没和OpenAI分道扬镳的马斯克,没有选择加入OpenAI。

直到2023年10月,OpenAI早已不同往日,Tulloch选择在OpenAI的极盛时期入职。

在OpenAI,Tulloch的工作依然是ML系统,涉及GPT4.5和4o的训练及o系列的推理。

不过Tulloch在OpenAI的工作时间就没有那么长了,今年1月,他跟随离职的前CTO Mira Murati等人一起创立了Thinking Machines Lab,直到这次重回Meta。

当然,小扎之前挖的一批人当中也有其他“回归用户”,比如从Anthropic挖到的Joel Pobar和Anton Bakhtin,之前分别是10年和5年的Meta老员工。

再说回Tulloch这次回归Meta,也是“真香定律”在他身上第二度上演。

两月前拒绝小扎15亿美元offer

两个月之前,Meta的挖人计划正进行得如火如荼,小扎亲自担任“首席招聘官”向Tulloch递出橄榄枝并给出15亿美元薪酬包时,后者选择了拒绝。

一开始,小扎想的是直接收购Thinking Machines Lab,还联系了Mira Murati,但遭到拒绝。

Meta转而发起了一场“全面突袭”,小扎先后联系了十几名Thinking Machines Lab员工,试探他们是否愿意跳槽,当然最主要的目标还是Tulloch。

小扎对同样从OpenAI出走创业的Ilya也采取了类似的套路,一开始想要收购他创立的Safe Superintelligence Inc,顺便把Ilya本人也招致麾下,被拒之后改成了挖联创,并成功挖走了CEO Daniel Gross。

不过这一波Meta发言人否认了收购Thinking Machines Lab和15亿美元挖Tulloch的说法——Meta对收购不感兴趣,薪酬数字也很荒谬,因为其中包含股票,具体价值要取决于股市情况。

但否认的只是数字,可并没有否认要挖人。

而且从结果上看,总之Tulloch现在是被挖来了,不过具体工作内容还不清楚。

有意思的是,这时Meta挖人的白热化阶段早已过去,内部改组也搞出了一地鸡毛,Tulloch这时选择入职,会是基于一种什么样的考虑?

有人说是薪酬包涨到了20亿美元,你觉得呢?