2025 年还有 10 天就要结束,这意味着是时候进行一波年终总结了。

2025 年还有 10 天就要结束,这意味着是时候进行一波年终总结了。

对于人工智能领域而言,2025 年是大语言模型(LLM)快速演进、重磅事件密集出现的一年。

就在昨天,知名 AI 学者 Karpathy 列出了一份清单,记录了他个人认为最重要、也多少有些出乎意料的「范式转变」。

这些真正改变了行业格局、并在概念层面让 Karpathy 印象深刻的变化会落在哪些领域呢?我们接下来一一来看(以第一人称)。

可验证奖励强化学习(RLVR)

2025 年初,几乎所有实验室的 LLM 生产训练流程都像下面这样:

预训练(类似 2020 年的 GPT-2/3);

监督微调(SFT,类似 2022 年的 InstructGPT)

基于人类反馈的强化学习(RLHF,约 2022 年)

这套流程稳定、可靠,曾长期被视为「工业级 LLM」的标准做法。

但在 2025 年,一种新的阶段浮出水面,并迅速成为事实上的标配:可验证奖励强化学习(Reinforcement Learning from Verifiable Rewards,RLVR)。

RLVR 的核心做法是,让模型在可自动验证的环境中接受强化学习训练,比如数学题、代码题、逻辑谜题等。在这些环境中,模型自发学会一些在人类看来非常像「推理」的策略:它会把复杂问题拆解成中间步骤,并反复试探、修正路径,逐步逼近答案(DeepSeek R1 的论文中有不少很好的例子)。

在以往的 SFT 或 RLHF 框架下,这类「推理轨迹」是极难人为设计出来的。这是因为我们并不知道对模型而言,什么才是「最优的思考过程」。而在 RLVR 中,模型可以通过优化奖励函数,自行摸索出对自己最有效的解题方式。

此外,与 SFT 和 RLHF 这种「计算量相对较小的薄层微调」不同,RLVR 使用的是客观、难以被投机取巧的奖励函数,这使得训练可以跑得非常久。结果就是:RLVR 提供了极高的能力 / 成本比,大量吞噬了原本准备用于预训练的算力。

因此,2025 年的大部分能力提升,并不是来自模型规模的暴涨,而是来自相似规模模型 + 更长时间的 RL 训练。这个阶段还带来了一个全新的「旋钮」:通过在推理时生成更长的思考链条、投入更多测试时算力,模型能力可以继续提升,并呈现出新的 scaling law。

OpenAI 的 o1(2024 年底)是第一个明确展示 RLVR 思路的模型,而 2025 年初的 o3,则是那个让人直观感受到质变拐点的版本。

幽灵 vs 动物:锯齿状智能

2025 年,是我(以及我认为整个行业)第一次真正直觉性地理解了 LLM 智能的「形状」。我们并不是在「培育或进化动物」,而是在「召唤幽灵」。

LLM 的一切都和人类不同:神经结构不同、训练数据不同、训练算法不同,最关键的是优化目标完全不同。人类神经系统,是为丛林生存、部落协作而优化的;而 LLM 是为模仿人类文本、在数学谜题中拿分、在 LM Arena 里获得点赞而优化的。

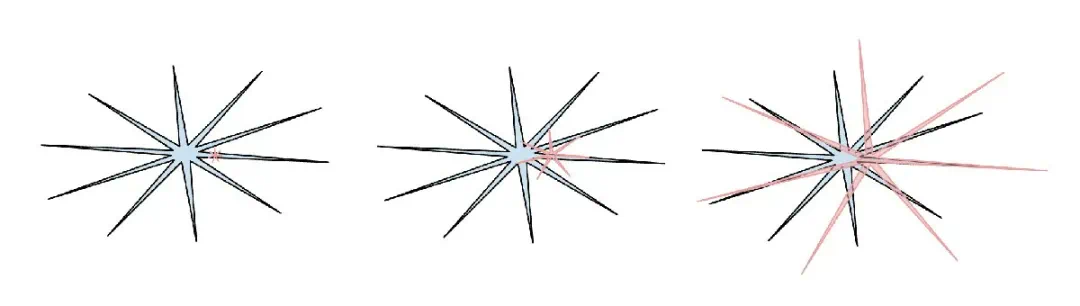

一旦某些领域具备可验证性,RLVR 就会在这些区域「长出尖刺」。于是我们看到的,是一种锯齿化(jagged)明显的能力分布:它们可以在某些领域表现得像博学的天才,同时又在另一些地方像困惑的小学生,甚至轻易被 jailbreak 套走隐私数据。

我很喜欢一张 meme:人类智能是蓝色曲线,AI 是红色曲线。它也提醒我们:人类智能本身,同样是锯齿状的,只是形状不同。

这也解释了我在 2025 年对基准普遍不当回事与不信任。问题在于:基准测试本质上就是可验证环境,因此天然容易被 RLVR 或弱化版本的「合成数据训练」所攻破。

在现实中,模型团队往往会在基准所在的嵌入空间附近「培育能力突起」,把 jaggies 精准地长到测试点上。「在测试集上训练」已经演变成了一门艺术。

那么问题来了:如果一个模型碾压了所有基准,却依然不是 AGI,那意味着什么?

Cursor:LLM 应用的新一层

Cursor 在 2025 年的爆发本身就很惊人,但对我而言,更重要的是:它清晰地揭示了一种全新的 LLM 应用层。

人们开始说,「这是某某领域的 Cursor」。在我今年 YC 演讲中提到过:像 Cursor 这样的 LLM 应用,本质是在为特定垂直领域打包和编排 LLM 能力:

上下文工程(context engineering);

在后台编排多次 LLM 调用,形成越来越复杂的 DAG,同时平衡成本与性能;

提供面向人的、领域专用的 GUI;

提供「自主性滑块」(autonomy slider)。

2025 年围绕着一个问题出现了大量讨论:这一层会有多厚?LLM 实验室会不会吞掉所有应用?还是说,LLM 应用层依然有广阔空间?

我个人的判断是:基础模型会趋向于「一个通用能力很强的大学毕业生」,而真正把他们组织成专业团队、在具体行业中落地的会是应用层,通过私有数据、传感器、执行器和反馈回路将模型组织并投入实际工作流程」。

Claude Code:住在你电脑里的 AI

Claude Code(CC)是我第一次觉得:「这才像一个真正的 LLM Agent。」它以循环方式将推理与工具调用串联起来,能持续解决长任务。

更重要的是:它运行在你的本地电脑上,直接使用你的环境、数据和上下文。

我认为 OpenAI 在这里判断失误了:他们把 agent /codex 的重心放在云端容器、由 ChatGPT 统一调度;而在一个能力锯齿、起飞缓慢的世界里,更合理的顺序其实是先让 agent 成为开发者身边的伙伴。

Claude Code 在这点上做对了,并且用一个极其优雅、极简、极具说服力的 CLI 形态呈现出来。

AI 不再只是一个你访问的网站,而是一个住在你电脑里的小幽灵。

这是一次全新的交互范式转变。

Vibe Coding(氛围编程)

2025 年,是 AI 跨过某个关键门槛的一年:人们可以只用英语构建复杂程序,甚至忘记代码本身的存在。

有趣的是,「vibe coding」这个词,最早只是我一条随手写的推文,完全没想到会流传这么广。

Vibe coding 让编程不再只是专业工程师的专利,任何人都可以上手;但同时,它也让专业工程师可以写出大量原本永远不会被写出来的软件。

在 nanochat 项目中,我直接用 vibe coding 写了一个高效的 Rust BPE tokenizer;我用它快速写了很多 demo 项目(比如 menugen、llm-council、reader3、HN time capsule);甚至为了定位一个 bug,我会 vibe coding 一个临时应用,用完即弃。

代码变得不值钱、短暂存在、并可随意改写与丢弃。

Vibe coding 在重塑软件形态之外,也会重塑工作角色。

Nano Banana:LLM 的 GUI

Google Gemini 的「Nano Banana」,是 2025 年最让我震撼的模型之一。

在我的世界观里,LLM 是类似 1970–80 年代计算机的新一代通用计算范式,因此我们必然会看到类似的演化路径:

个人计算

微控制器(认知核心)

Agent 网络(类似互联网)

而在 UI/UX 层面,「聊天」就像 80 年代的命令行。文本是计算机最偏好的表示形式,但并不是人类最喜欢的输入方式。人们更喜欢视觉化、空间化的信息 —— 这正是 GUI 出现的原因。

同理,LLM 也应该用我们偏好的形式与我们交流:图片、信息图、幻灯片、白板、动画、网页应用……

Emoji 和 Markdown 只是最早期、最粗糙的尝试。那么,谁会构建真正的 LLM GUI?在我看来,Nano Banana 是一个非常早期但重要的信号。

它的意义不只在于图像生成,而在于:文本、图像与世界知识在同一模型中深度纠缠。

最后总结

2025 年,是一个令人兴奋、也充满意外的大模型之年。

LLM 正在显现出一种全新的智能形态:它们既比我预期的聪明得多,又比我预期的愚蠢得多。

但无论如何,它们已经极其有用,而我认为行业甚至还没有发挥出它们 10% 的潜力。

想法太多,空间太大,这个领域仍然是开放的。

正如我今年在 Dwarkesh 播客中说过的那样:

我一方面相信进展会持续且迅猛,另一方面也清楚,还有大量艰苦而细致的工作要做。

「系好安全带」,接下来只会更快。

原推链接:https://x.com/karpathy/status/2002118205729562949