起猛了,苹果怎么搞起跨界AI模型了??

发布了一个基于流匹配的蛋白质折叠模型SimpleFold,被网友戏称为“iFold”。

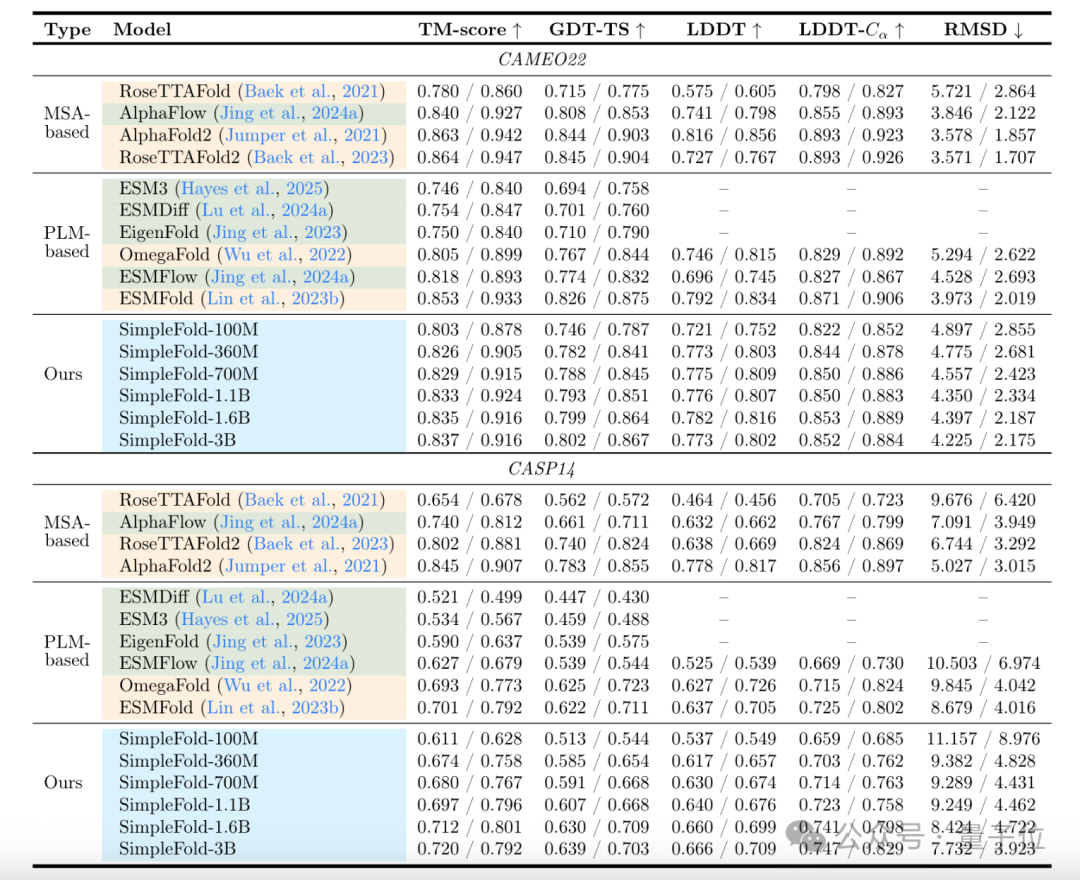

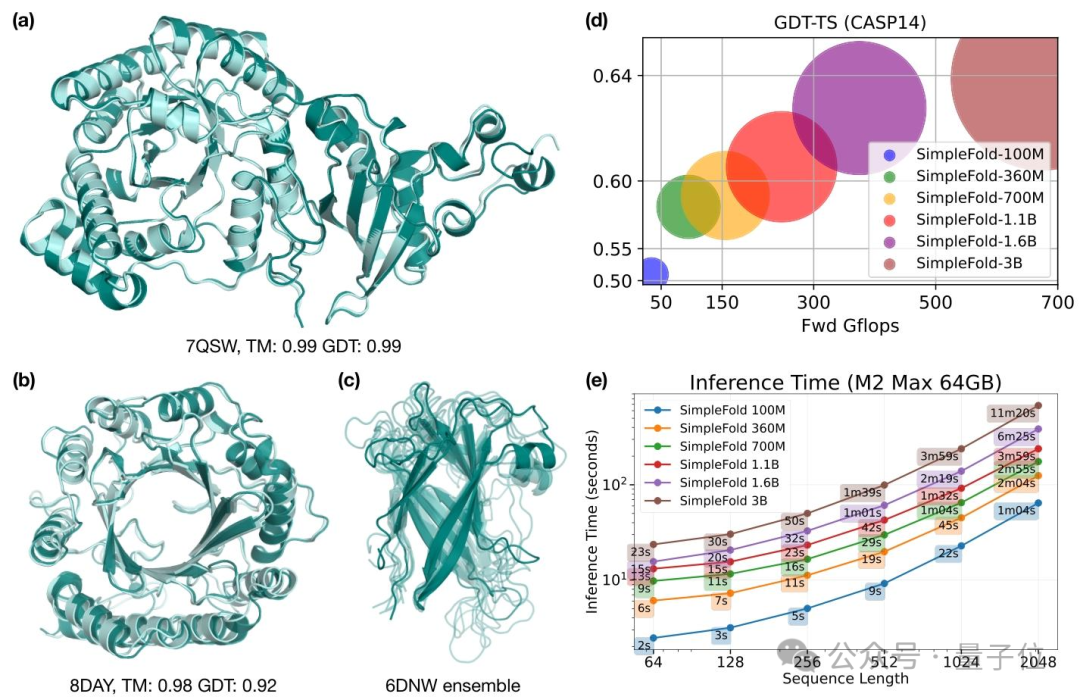

SimpleFold没有花里胡哨的专属模块设计,就靠通用的Transformer模块,搭配流匹配生成范式,3B参数版本追平了该领域顶流模型谷歌AlphaFold2的性能。

苹果这波跨界看来玩的是化繁为简。

MacBook Pro跑起来不费力

首先来说说蛋白质折叠是怎么一回事。

核心是将“一串”氨基酸折成特定的3D形状,这样蛋白质才能发挥作用。

而蛋白质折叠模型就是从氨基酸的一级序列预测它的三维空间构象。

之前最厉害的模型,比如谷歌的AlphaFold2,虽然实现了突破,但用了很多复杂的专属设计。

比如要分析大量相似蛋白质的序列,依赖多序列对比(MSA)构建进化信息、靠三角注意力优化空间约束、推理时需调用超算级算力,普通实验室不太能用得起。

但这款“iFold”用通用AI框架解决了这个问题。

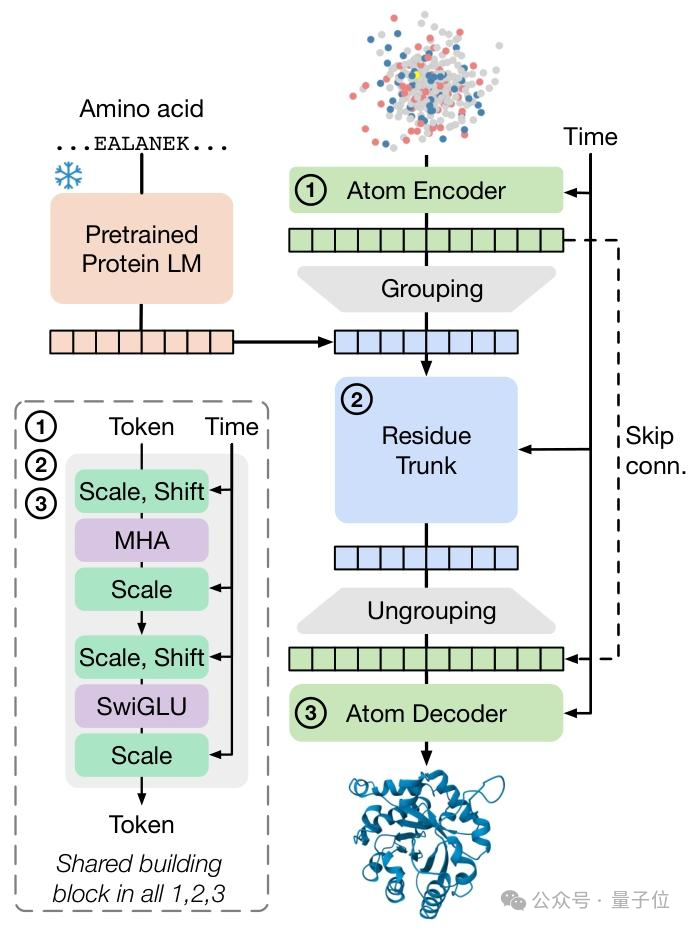

SimpleFold在架构上采用多层Transformer编码器作为核心骨干,仅通过自适应层归一化适配蛋白质序列特征,相当于用“通用工具箱”解决专属领域难题。

核心创新在于引入流匹配生成技术。

不同于扩散模型的逐步去噪,流匹配通过学习从随机噪声分布到蛋白质构象分布的光滑映射,实现一步式生成原子坐标。

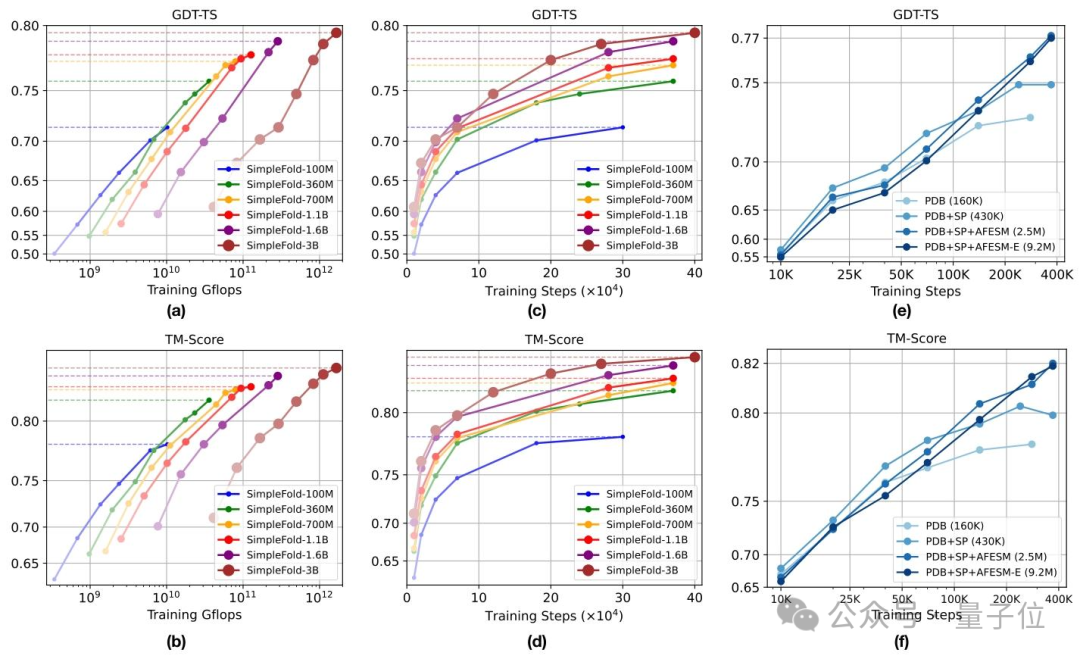

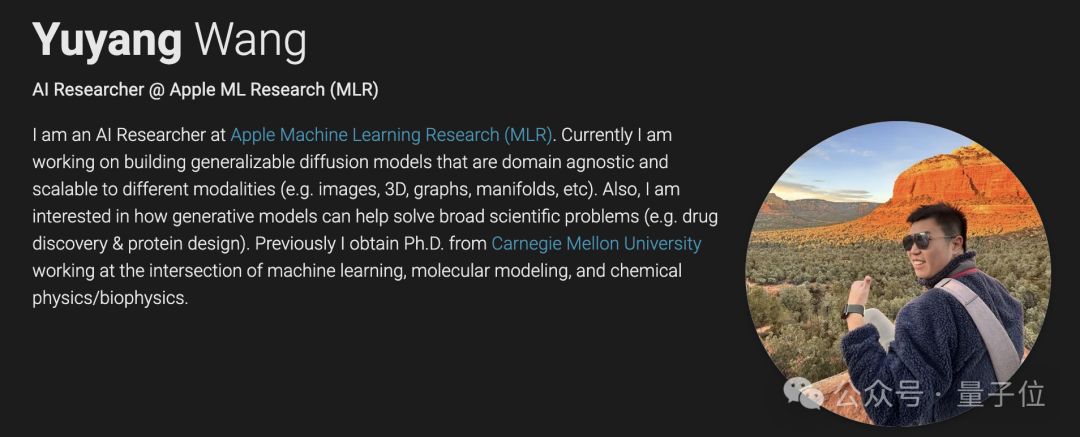

在训练阶段,团队构建了包含900万条数据的混合数据集,训练出了100M到3B参数的多尺度模型,其中SimpleFold-3B在CAMEO22 基准测试中,性能达到AlphaFold2的95%。

在CASP14高难度测试集上,超越同类流匹配模型ESMFold。

还值得一提的是效率,在搭载M2 Max芯片的MacBook Pro上,处理512残基序列的推理时间仅需两三分钟,远超传统模型的小时级耗时。

研究团队

这项研究的第一作者Yuyang Wang本科毕业于同济大学,后赴美国卡内基梅隆大学深造,陆续取得机械工程硕士、机器学习硕士以及机械工程博士学位,长期的学习为其相关领域研究筑牢根基。

他有在Momenta从事强化学习研发的实习经历,还曾在苹果公司担任AI/ML Resident,专注于扩散模型研究,之后成为苹果的机器学习研究员。

通讯作者是华人机器学习工程师Jiarui Lu,本科毕业于清华大学,就读期间还在朱军教授实验室中担任研究助理。

随后,Lu在卡内基梅隆大学取得了机器学习硕士学位,毕业后于2020年加入苹果公司。

曾经主导了一套关于大模型工具调用能力的Benchmark——ToolSandbox这一苹果开源成果。

关于这款“iFold”,有感兴趣的、想扒技术细节的朋友可戳文末链接~

论文地址:https://arxiv.org/abs/2509.18480

代码地址:https://github.com/apple/ml-simplefold