看到这个标题,你可能会想"又一个号称吊打GPT的模型"。但这次不一样,华中科技大学真的搞出了点名堂。

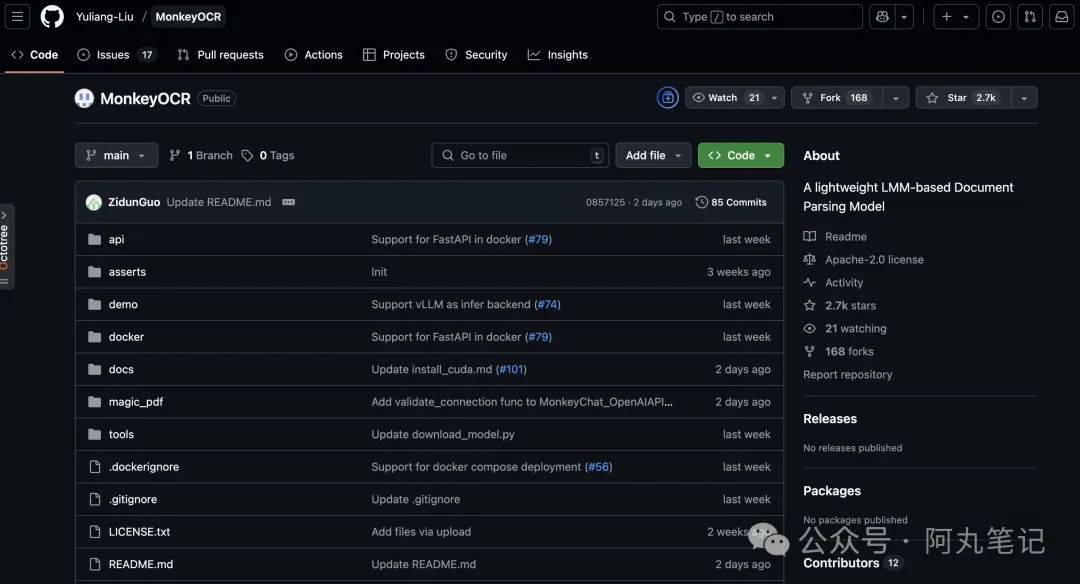

前几天,华科和金山办公联合开源了一个叫MonkeyOCR的文档解析模型。听名字挺可爱,但实力可不含糊。

图片

图片

这个只有3B参数的小模型,在文档解析任务上竟然超越了GPT-4o、Gemini 2.5 Pro这些巨头的产品。

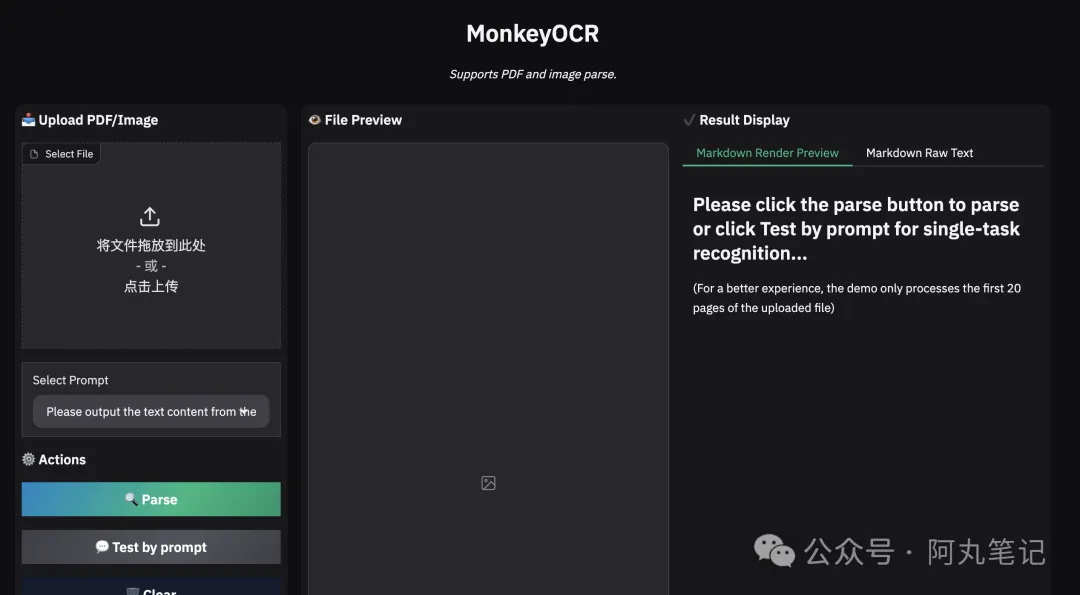

我特意去试了试他们的在线demo,确实有两把刷子。

图片

图片

最让我印象深刻的是它处理公式的能力。你知道,数学公式一直是OCR的老大难问题,那些复杂的分式、积分符号,传统OCR经常识别错。但MonkeyOCR在公式识别上比MinerU提升了15%,这个进步挺明显的。

表格处理也很出色。我测试了几张复杂的财务报表,它不仅能准确识别表格内容,还能保持原有的结构关系。相比之下,很多工具要么识别不准,要么把表格结构搞乱了。

从技术角度看,MonkeyOCR创新在于它的SRR三元组设计。简单说就是把文档解析分成三个问题:"Where is it?"(结构检测)、"What is it?"(内容识别)、"How is it organized?"(关系理解)。

这种设计很聪明。传统pipeline方法容易累积错误,端到端大模型又太笨重。MonkeyOCR找了个平衡点,既保证精度又控制了计算开销。

整体表现上,MonkeyOCR比MinerU平均提升了5.1%,在公式识别上提升15%,表格处理上提升8.6%。

更关键的是效率。MonkeyOCR处理多页文档的速度是0.84页/秒,MinerU是0.65页/秒,而Qwen2.5-VL-7B只有可怜的0.12页/秒。

这意味着什么?如果你要处理100页的PDF,MonkeyOCR只需要2分钟,而Qwen需要14分钟。在实际应用中,这种速度差异是致命的。

图片

图片

还有一个细节让我挺惊喜:这个3B的模型可以在单张RTX 3090上跑。要知道,现在动不动就几十GB的大模型,普通人根本跑不起来。MonkeyOCR这种"小而美"的设计,让更多开发者能够实际使用。

当然,也不是完美的。我在测试中发现,对于一些非常规排版的文档,比如古籍或者手写体,识别效果还是有限的。不过这也正常,毕竟这些场景的数据相对稀少。

从训练数据看,团队构建了MonkeyDoc数据集,包含390万个实例,覆盖十多种文档类型。这个数据规模在文档解析领域算是相当不错了。

华科在AI视觉这块确实有两把刷子。

他们之前的TextMonkey、Mini-Monkey都在OCR领域有不错的表现。这次的MonkeyOCR可以看作是这个系列一个重要迭代,技术越来越成熟了。

对于想要部署文档解析服务的公司来说,MonkeyOCR提供了一个很有吸引力的选择。既有不错的精度,又能控制成本,训练也只需要8张RTX 3090,门槛不算太高。

项目已经开源,GitHub上已经有2.5K的star了。代码、模型都能免费下载,还提供了在线demo可以直接测试。

只是有一点要注意,在线demo对大图片的处理似乎有些bug,测试时候最好控制下图片尺寸。

总的来说,MonkeyOCR是个不错的开源项目,特别是对于需要高效文档解析的场景。虽然不敢说真的"吊打"所有商业产品,但确实在某些方面有自己的优势。