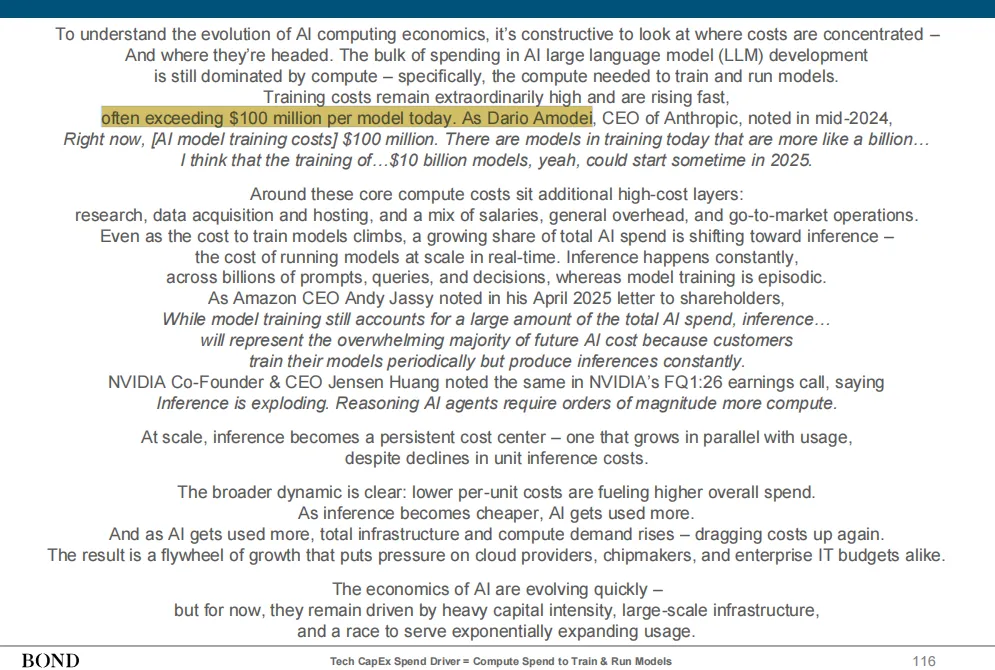

根据互联网女皇发布的AI趋势报告的深度分析,人工智能(AI)模型的计算经济学正经历着一场关键的转变。报告指出,训练最强大的大型语言模型(LLM)已成为人类历史上最昂贵、资本最密集的投入之一,目前每个模型的训练成本往往超过1亿美元。Anthropic首席执行官Dario Amodei在2024年中指出,目前有模型正在训练,其成本接近10亿美元,并预测到2025年,训练成本高达100亿美元的模型可能会出现。

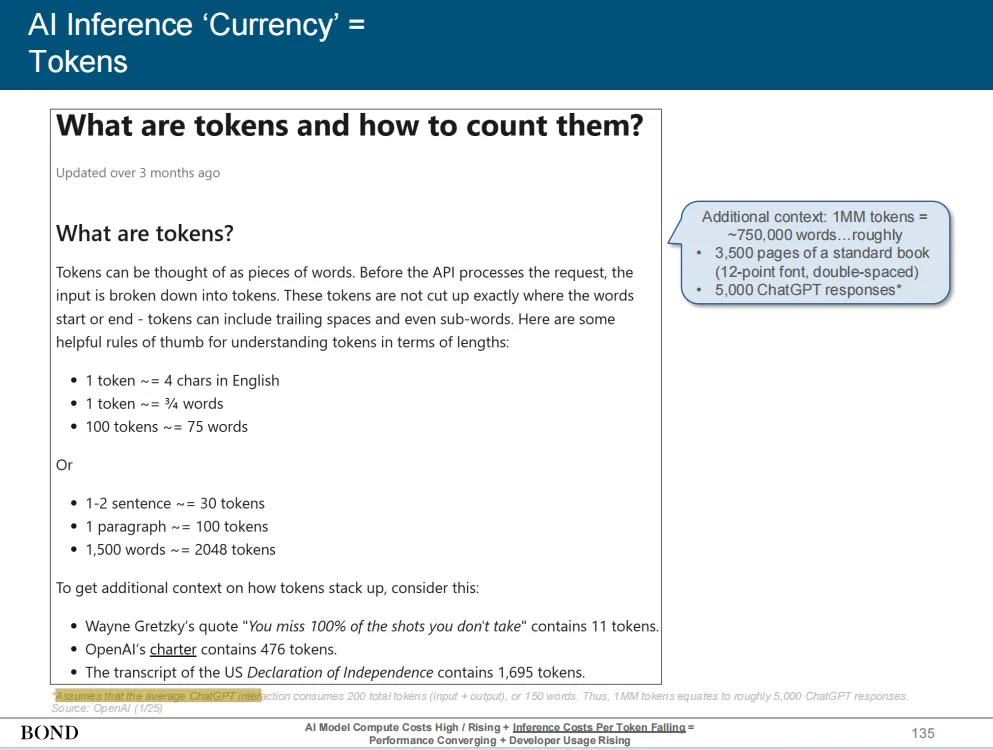

然而,互联网女皇AI趋势报告同时强调,运行模型的推理成本(即模型生成预测、答案或内容)正在迅速下降。报告引用英伟达的数据显示,其2024年发布的Blackwell GPU生成每个token所需的能量比2014年的Kepler GPU前身低了105,000倍。斯坦福HAI的数据进一步揭示,在两年内,AI推理的客户价格(每百万token)下降了99.7%。这种成本效益的提高,速度远超此前的电力和计算机内存等关键技术。

这种推理成本的急剧下降和模型可访问性的提高,使得AI的实验成本降低,迭代速度加快。互联网女皇AI趋势报告认为,这使得产品化对于几乎所有有想法的人都变得可行,从而导致了开发者活动的激增。例如,Meta的Llama模型在八个月内的下载量增加了3.4倍。此外,报告指出,尽管模型成本不同,但AI模型的性能正在迅速趋于收敛,顶级前沿模型与更小、更高效模型之间的差距正在缩小。

报告总结称,AI的这种经济学演变正在引发一场“创造力的大爆发”。开发者可以根据技术或财务需求选择最合适的模型,而非受限于单一供应商,这正在重塑AI模型提供商的商业模式,迫使它们重新思考如何实现盈利。