科技媒体 NeoWin 今天(6 月 27 日)发布博文,报道称在 2025 年 I/O 开发者大会上预览发布后,谷歌已正式推出 Gemma 3n 端侧多模态模型,支持在手机、平板和笔记本电脑上本地运行,处理音频、文本、图片和视频多种数据类型。

相比较 5 月发布的预览版,最新发布的 Gemma 3n 完整版进一步提升性能表现,支持在 2GB 内存的硬件上本地运行,重点提升了编码和推理方面的能力。

AI在线援引博文介绍,Gemma 3n 共有两种规模版本,其中 E2B 共有 50 亿(5B)参数,支持在 2GB 以上内存设备上运行;E4B 共有 80 亿(8B)参数,支持在 3GB 以上内存设备上运行,两者通过架构创新,内存占用相当于 20 亿(2B)和 40 亿(4B)模型。

在架构方面,Gemma 3n 创新采用 MatFormer 架构,来提供计算灵活性,此外使用 Per Layer Embeddings(PLE)以提升内存效率、MobileNet-v5 视觉编码器等等。

对于 MatFormer 架构,谷歌用一个俄罗斯套娃的比喻来描述:一个较大模型内部包含一个较小但完全功能的版本,让单一模型能够根据不同任务以不同大小运行。

Gemma 3n 在多语言(支持 140 种语言的文本和 35 种语言的多模态理解)、数学、编码和推理方面都实现了质量提升。

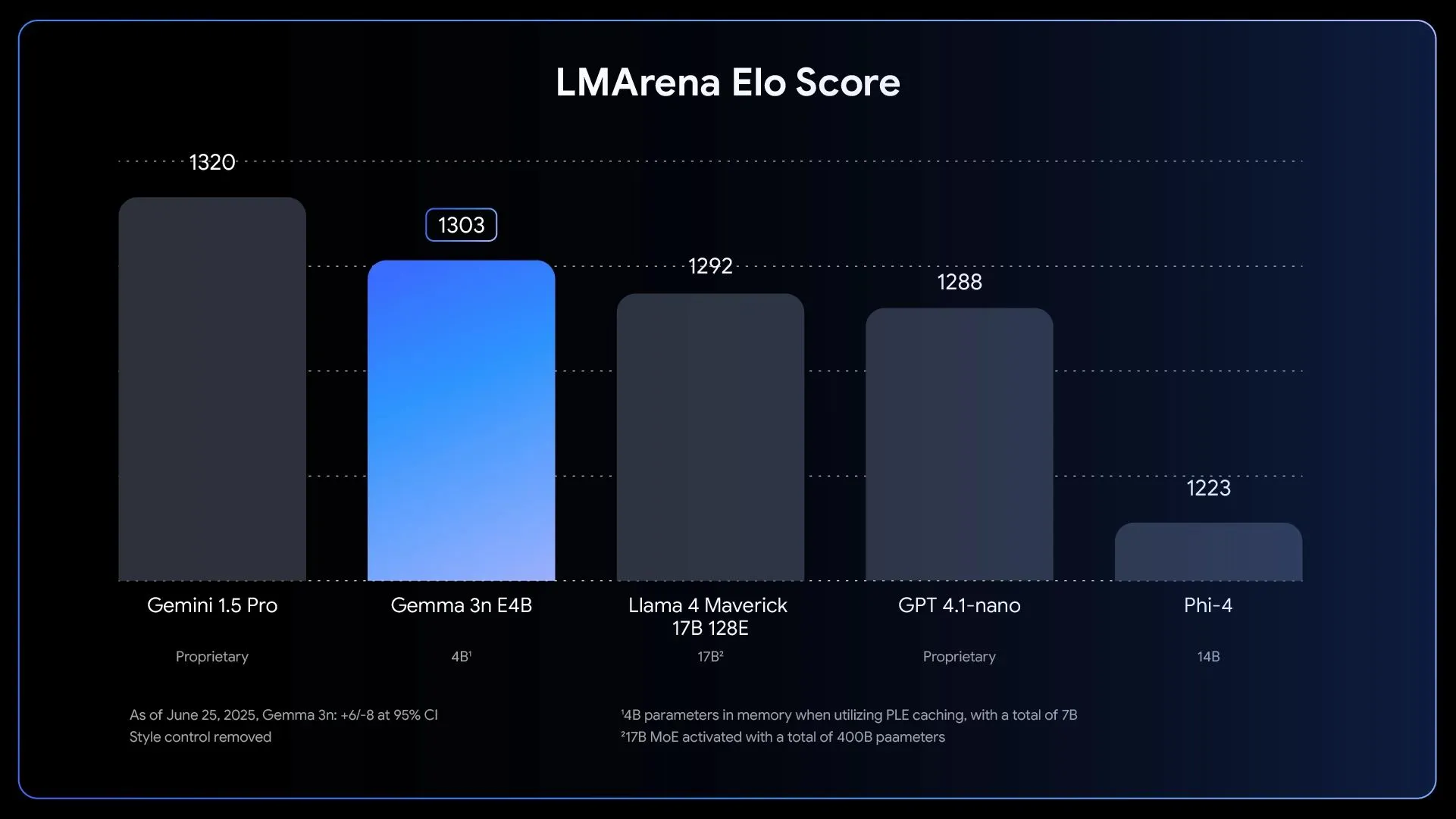

在性能基准方面,较大的 E4B 模型是首个参数量低于 10B 但 LMArena 得分超过 1300 的模型。

模型的音频能力现在支持设备上的语音转文本和翻译,使用一个能够处理细致语音的编码器。

视觉方面则由一个名为 MobileNet-V5 的新编码器提供动力,比前代更快、更高效。它能在 Google Pixel 设备上以最高 60FPS 处理视频。