谷歌今日在 Google Cloud Next 2025 大会上发布了其第七代 TPU 张量处理器 "Ironwood"。这是其 TPU 家族中首款专为 AI 推理而设计的型号,拥有迄今为止最强大的功能、能力和能效。

谷歌表示 "Ironwood" 代表了 AI 发展和推动其进步的基础设施的重大转变:从传统响应式 AI 模型转向提供主动生成的见解和解释的模型;AI 智能体(AI在线注:Agent)将主动去检索和生成数据,以协作提供见解和答案,而不仅仅是数据。

在芯片参数方面,每颗 "Ironwood" TPU 搭载了共计 192GB 的 7.2Tbps HBM 内存,峰值 FP8 AI 算力可达到 4614 TFLOP,支持 1.2Tbps 带宽的 ICI 芯片间互连,能效则达到了 TPU v6e "Trillium" 的两倍。

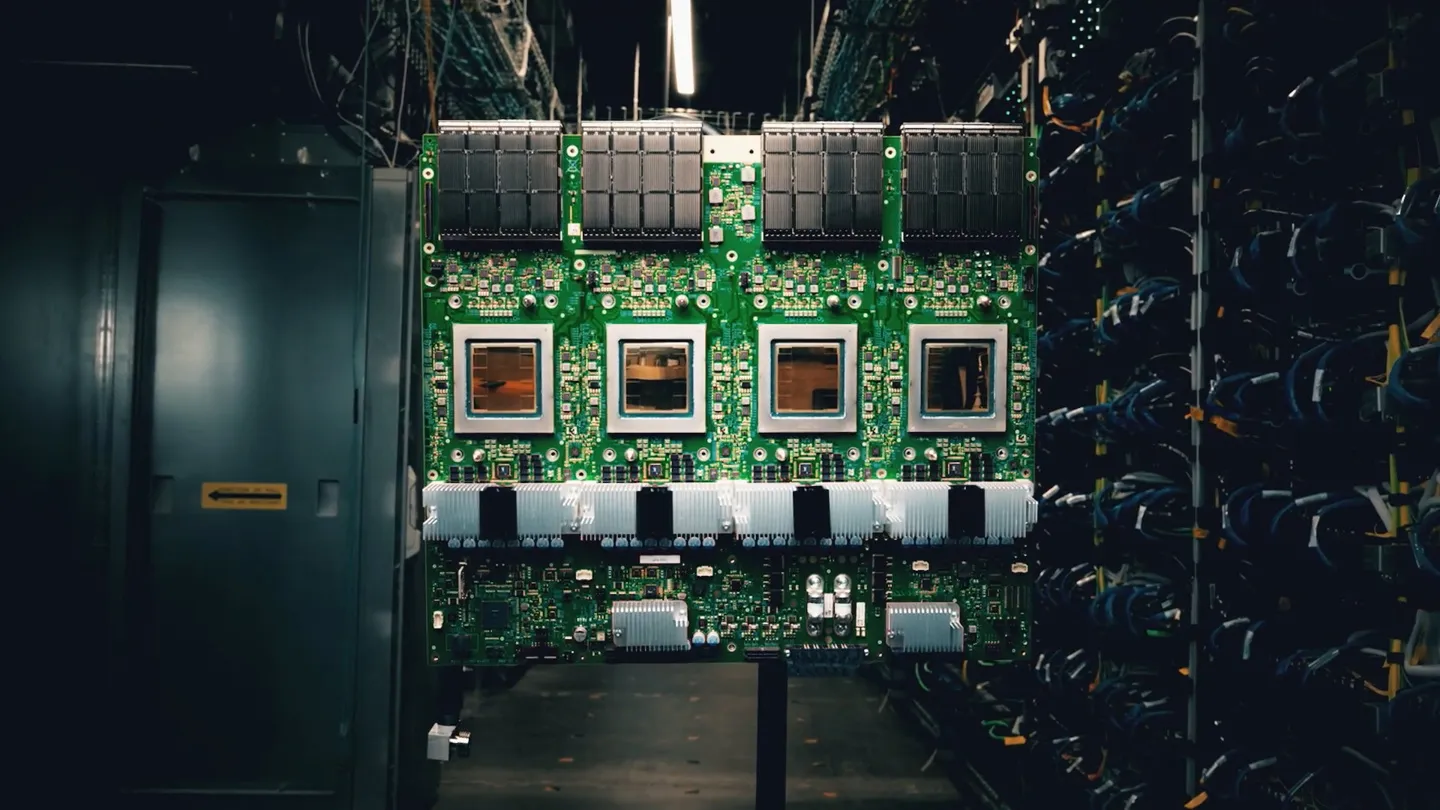

对于 Google Cloud 云客户,谷歌提供两种不同规模的 "Ironwood" TPU Pod 配置:256 芯片和 9216 芯片,后者的整体 AI 算力达到了惊人的 42.5 Exaflops。