近年来,大语言模型在「写得长、写得顺」这件事上进步飞快。但当任务升级到真正复杂的推理场景 —— 需要兵分多路探索、需要自我反思与相互印证、需要在多条线索之间做汇总与取舍时,传统的链式思维(Chain-of-Thought)往往就开始「吃力」:容易被早期判断带偏、发散不足、自我纠错弱,而且顺序生成的效率天然受限。

北京通用人工智能研究院(BIGAI)语言交互实验室(NLCo)最新工作 Native Parallel Reasoner(NPR,原生并行推理器),瞄准的正是这类瓶颈:

让智能体在一次思考中同时衍生并维护多条候选推理路径,并在关键节点「分支 + 聚合」,最终像拼图一样汇总线索,合成最优解。

更重要的是,NPR 的突破点不只是「并行生成的工程技巧」,而是提出了一套「自蒸馏 + 并行强化学习」三阶段训练范式,并配套专门的并行推理引擎,目标是让并行推理从外挂变为模型的原生认知能力。

论文标题:Native Parallel Reasoner: Reasoning in Parallelism via Self-Distilled Reinforcement Learning

论文连接:https://arxiv.org/pdf/2512.07461

展示页面:https://bigai-nlco.github.io/Native-Parallel-Reasoner

人们对语言智能体(Language Agent)的研究已经把关注从「单一思维链扩展」推广到了「多步深度推理」。模型能够进行更深层次的推理令人兴奋,但未来的超级智能真正需要的,是能更广泛地并行探索多条可能思考路径 —— 也就是在一次推理过程中同时尝试多种解法,然后再把结果合并校验。类似 MapReduce 的分而治之思路对进一步扩展智能体的测试时计算的能力边界至关重要,但想把它天然地整合进一个智能体中,存在巨大的挑战。

1. 算法与架构不匹配

现有推理引擎和 RL 算法很难原生地支持「分支 + 聚合」操作。推理引擎通常无法有效调度并行分支;常用的 RL 技术又会截断或削弱那些触发并行结构的特殊词元的梯度,阻碍模型学习严格的并行控制逻辑。

2. 低效的手工并行机制

早期把并行思路内化的尝试多依赖于手工设计的分治规则,无法充分复用共享的 KV Cache 状态,导致每个分支重复计算,时间复杂度退化到线性 O (N),难以满足实时或大规模部署的效率要求。

3. 对强监督蒸馏的依赖

像 Multiverse 这类方法虽能实现并行,但高度依赖于强教师模型蒸馏出的示例,无法通过自举的方式扩展自身的智能边界。学生模型不过是在模仿教师的串行拓扑并把它「塞入」并行格式,结果是把教师的局限也一并继承,短时间内难以产生新的、模型本身固有的并行策略 —— 达到了目前的「智能瓶颈」。

背景与痛点:为什么我们迫切需要并行推理?

人们对智能体的期待,正在从「能多想一步」的单一思维链,升级到「能多维思考」的深度推理。未来更强的智能体,必须具备广泛探索多条思考路径的能力 —— 这很像经典的 MapReduce 思想:把复杂问题拆开并行处理,再聚合结果完成全局最优的决策。

但要让模型真正学会这种「分身术」,现实里往往卡在三座大山:

1)并行思考数据极难获得:对强教师蒸馏的过度依赖

现有不少并行推理工作需要强教师模型提供高质量并行轨迹(如 Multiverse [4] 类方法)。问题在于学生模型更多是在模仿教师的串行拓扑再「塞进并行格式」,结果是把教师的局限一并继承,难以自举式扩展智能边界,很难真正涌现出「模型自身固有的并行策略」,形成新的智能瓶颈。

2)低效的手工并行机制:分支之间难共享、重复计算严重

早期模型并行常依赖手工设计的分治规则:每条路径按既定模式推理或生成。由于缺乏对共享步骤的有效复用,常常出现每个分支都重复计算公共前缀的情况,效率很难满足实时推理和大规模部署需求。

3)基础设施与算法对并行架构支持不足:分支 + 聚合「学不会」

现有推理引擎、强化学习算法对「分支 — 聚合」结构往往缺乏原生支持:推理引擎难以高效调度并行分支;常用 RL 技术可能会截断或削弱触发并行结构的特殊控制词元梯度,从而阻碍模型学习严格的并行控制逻辑。

NPR 的核心理念:把「并行性」升维成模型的原生能力

NPR 的关键词在「原生」二字:研究团队试图在零外部监督(不依赖强教师并行轨迹)的条件下,探索一条让模型自我进化出并行推理能力的路径。

整体思路是一个渐进式的三阶段训练范式,让模型从「会用并行格式写出来」,逐步过渡到「计算图层面真的并行执行」。

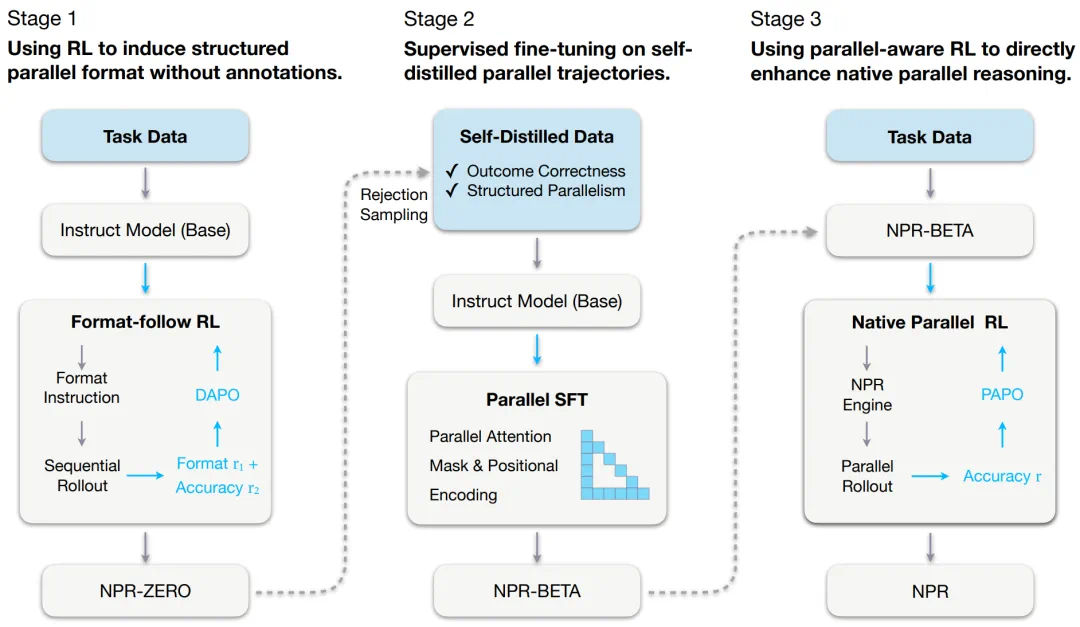

三阶段训练范式:从「并行外形」到「并行大脑」

阶段一:并行格式学习 —— 先学会「怎么写成并行」

第一步不追求一步到位「真的并行」,而是让模型先掌握并行推理的表达结构:如何标记分支、如何组织多条候选路径、如何定义聚合点。

阶段二:自蒸馏 —— 内化「并行思考逻辑」,摆脱外部老师

在具备并行表达能力后,NPR 用自蒸馏方式让模型用自己的生成结果反过来训练自己:通过筛选与沉淀,让模型逐步内化「多分支探索 — 相互印证 — 汇总收敛」 的推理规律,而不是照搬教师的串行偏好与局限。

阶段三:并行感知强化学习 —— 从「模仿并行」迈向「执行并行」

最后一步是关键跃迁:利用并行感知的强化学习,让模型学到什么时候该分叉、分叉多少、如何在聚合点进行比较与合并,使并行不再停留在文本表面,而是真正成为推理过程可执行的控制逻辑。

这一步把「并行性」从工程技巧,推进到模型的原生能力层面。

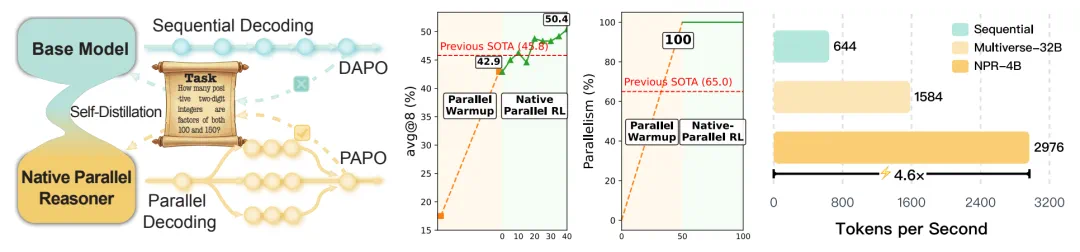

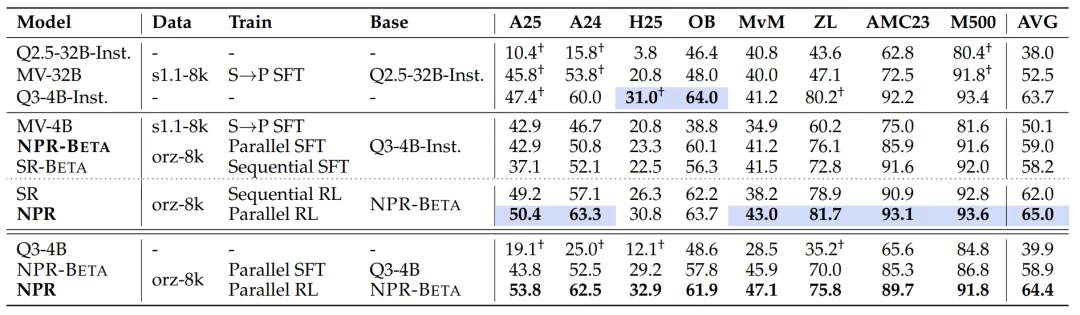

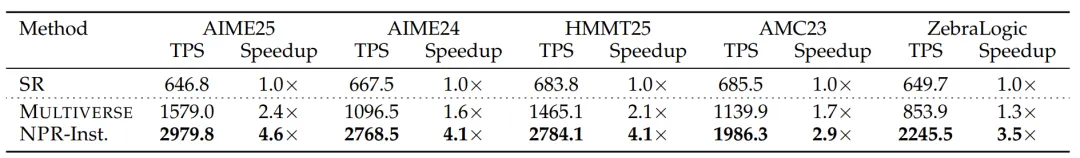

如下图所示,经过三个阶段的训练,NPR 准确率从约 17% 持续爬升,最终达到 50.4%(中间两条学习曲线分别对应第一阶段的格式学习与第三阶段的并行强化学习);与传统推理方式相比,NPR 实现了约 4.6 倍生成加速(右侧柱状图)。

NPR 具体实现细节

NPR 训练范式

Stage 1:Format-following Reinforcement Learning(NPR-ZERO)

目标:在无任何外部并行示例 / 教师情况下,让模型学会生成结构化的并行格式(如 <guideline>、<plan>、<step>、<takeaway> 等结构化标签),并尽量保证答案正确性。

方法:以格式合规与答案正确为奖励信号,对初始指令微调模型进行 DAPO 风格的强化学习,从而得到能产出并行格式轨迹的生成器(NPR-ZERO)。这一步为后续自蒸馏提供原始候选轨迹。

Stage 2:Rejection Sampling + Parallel Warmup(NPR-BETA)

目标:把 Stage 1 的 “格式化产物” 变为高质量的训练数据并让模型在并行语义上稳定。

方法:对 NPR-ZERO 进行拒绝采样并应用严格的筛选器(必须同时满足「格式合规」与「答案正确」),保留自蒸馏的并行推理轨迹,然后在此之上做冷启动的并行 SFT 预热微调,同时引入并行注意力掩码(Parallel Attention Mask)与并行位置编码(Parallel Positional Encoding),让模型内部能够支持并行分支的独立计算(并实现 KV Cache 重用以避免重复计算)。

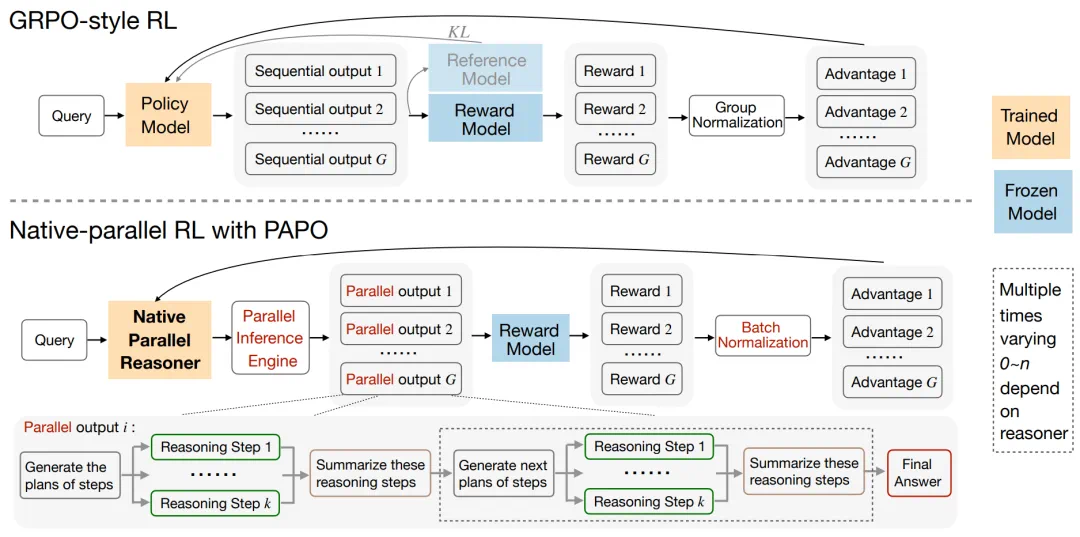

Stage 3:Native-Parallel RL(PAPO)

目标:在并行执行引擎上用强化学习直接优化并行分支策略,使其不仅会「写」并行格式,也会「算」并行结果。

方法:提出并实现 Parallel-Aware Policy Optimization (PAPO) —— 对并行语义做专门修改的策略优化方法:使用并行 Rollout 的 NPR-Engine 推理引擎以保证结构正确性、在批次层级进行优势归一化、保留特殊结构化 Token 的梯度并放弃重要性采样以维持稳定的 On-Policy 同策略梯度更新。PAPO 能直接在并行计算图内优化分支策略,从不断地试错中学会有效的问题拆解与合并策略。

关键技术细节

1. 自蒸馏与严格筛选(Rejection Sampling)

从 NPR-ZERO 生成大量并行格式的候选轨迹后,采用两条硬性筛选规则只保留高质量样本进入 D_accept:

Outcome Correctness:模型生成的候选轨迹的解析答案与 Ground Truth 一致。

Structured Parallelism:输出严格遵循并行格式的 Schema(标签、块边界等)。

当且仅当同时满足以上两条规则的采样轨迹被接受用于冷启动并行 SFT(NPR-BETA),此策略显著减少噪声并保证训练语料的并行性与可学习性。

2. 并行注意力掩码与并行位置编码

为在单次前向传递中同时存在多条 Reasoning Path,NPR 采用 Multiverse 风格的并行注意力掩码与专门设计的并行位置编码(对应论文给出的 Algorithm 2 伪代码),保证不同分支互相隔离但共享上下文 KV Cache,从而实现 KV Cache 重用并避免每条分支重复计算上下文代价。该编码亦允许通过标签 Token 标明分支 / 步骤 / 指南块,便于引擎解析。

3. Parallel-Aware Policy Optimization(PAPO)

并行语义下直接套用经典 PPO 或 DAPO 会遇到特殊 Token 被剪裁掉、重要性采样不稳定等问题。PAPO 的主要设计包括:

并行 Rollout:使用 NPR-Engine 产生严格遵守并行 Schema 的轨迹,保证样本合法。

结构化过滤:格式违规样本在进入优化前被剔除,奖励退化为纯准确性(+1 / −1)。

批次级优势归一化(Batch-level Normalization):由于格式违规样本被移除,组内方差塌缩,因此用更大范围(batch 内多组)统计标准差来稳定优势估计。

保留特殊 Token 的梯度 & 放弃重要性采样:为防止触发并行结构的特殊标签被裁剪掉,PAPO 在 Token 级别保留梯度流;同时放弃重要性采样,采用严格的 On-policy Objective,避免重采样比带来的不稳定。

4. AI Infra 工程化改进:NPR-Engine

实验证明:把并行语义放到生产环境的并行 RL,会暴露出大量的工程问题(KV Cache 重复释放导致的内存泄漏、并行 Token 计数导致的超长生成、非法并行 schema 导致的未定义状态等)。论文在引擎层面做了几项关键修复:

预算感知的 KV 回收:避免 Radix-Tree KV 路径的 Opportunistic Recycling 导致 Double-Free,引入预算感知的确定性回收机制与 Memory Flush 策略。

分支感知的 Token 累积策略:把全局 Token 预算从 “只看最长分支” 改为 “按活跃分支因子累计”,避免超出 max_new_tokens。

格式预检与轻量不变性:在分支展开前加一层格式合法性检查,快速拒绝潜在非法分支以保证 Determinism。

这些工程改进和实现是确保能稳定 Parallel RL 的训练,进而获得并行思考智能体的前提。

主要实验与结论

评测基准与度量

在 8 个推理型基准上评测:AIME24/25、HMMT25、OlympiadBench、Minerva-Math、ZebraLogic、AMC23、MATH500 等。对小规模竞赛类数据使用 avg@8(采样 8 条解答的平均正确率),对大规模或单答设置使用 avg@1。

训练数据优势:性能提升的关键在于用自行提炼的数据集(NPR-BETA 的 ORZ-8k)替换了 Multiverse 的训练语料库(MV-4B 的 s1.1-8k)。尽管两个流程在实现细节上略有不同,但都依赖于并行式的 SFT,因此比较结果具有意义。数据替换的影响清晰且一致:AIME24 的性能从 46.7 提升至 50.8(+4.1),ZebraLogic 从 60.2 提升至 76.1(+15.9),AMC23 从 75.0 提升至 85.9(+10.9),MATH500 从 81.6 提升至 91.6(+10.0)。总体而言,平均得分从 50.1 提升至 59.0(+8.9)。

并行 SFT 的优势:从顺序 SFT(例如 SR-BETA)切换到并行 SFT 方法(NPR-BETA)能够显著提升各种推理基准测试的性能。顺序 SFT 引入了较强的步骤依赖性先验,限制了任务分解的灵活性。相比之下,并行 SFT 在训练过程中使模型能够接触到结构上并行的轨迹,从而实现更独立的子问题探索。具体而言,AIME25 从 37.1 提升至 42.9 (+5.8),OlympiadBench 从 56.3 提升至 60.1 (+3.8),HMMT25 从 22.5 提升至 23.3 (+0.8),ZebraLogic 从 72.8 提升至 76.1 (+3.3)。整体性能从 58.2 提升至 59.0 (+0.8),仅在少数基准测试中出现轻微退步。

并行强化学习优势:基于 NPR-BETA,应用并行强化学习算法可获得进一步的性能提升,并始终优于顺序强化学习(NPR 与 SR 相比)。这些改进是广泛而系统的:AIME24 从 57.1 提升至 63.3(+6.2),HMMT25 从 26.3 提升至 30.8(+4.5),Minerva-Math 从 38.2 提升至 43.0(+4.8)。其他基准测试也显示出稳步提升,AIME25(+1.2)、OlympiadBench(+1.5)、ZebraLogic(+2.8)、AMC23(+2.2)和 MATH500(+0.8)。总体而言,平均得分从 62.0 提升至 65.0(+3.0)。

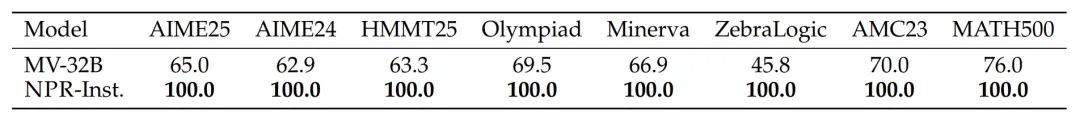

Multiverse-32B 在不同数据集上的并行率差异显著,表明其并行推理的采用高度依赖于数据集。尤其是在 ZebraLogic 等逻辑密集型任务上,其性能明显低于多个数学竞赛数据集,这表明从顺序行为逐步过渡到并行行为的 Multiverse 训练范式,导致并行策略的内化不一致,并且对领域特征非常敏感。相比之下,NPR 模型在所有八个数据集上均达到了 100.0% 的并行触发率。这种一致性意味着端到端的 NPR 训练流程能够更可靠地将并行推理作为模型的默认问题解决模式,而不受数据集领域或复杂性的影响。实际上,这意味着 NPR 不仅能更频繁地触发并行推理,而且能够在不同的评估数据集上稳健地实现这一点。

NPR 在所有五个基准测试中均取得了最佳效率,始终优于 Multiverse(1.3 倍至 2.4 倍)和自回归基线,这表明该方法具有稳健的泛化能力。重要的是,加速比随任务难度而增加:NPR 在较难的问题(AIME25:4.6 倍;HMMT25:4.1 倍)上观察到的加速比在较容易的问题(AMC23:2.9 倍)上更大,这表明当需要更深入地探索解路径时,NPR 优势日益凸显。证明了 NPR 既能提高准确率,而且在可以并行探索多种解策略时尤其有效。

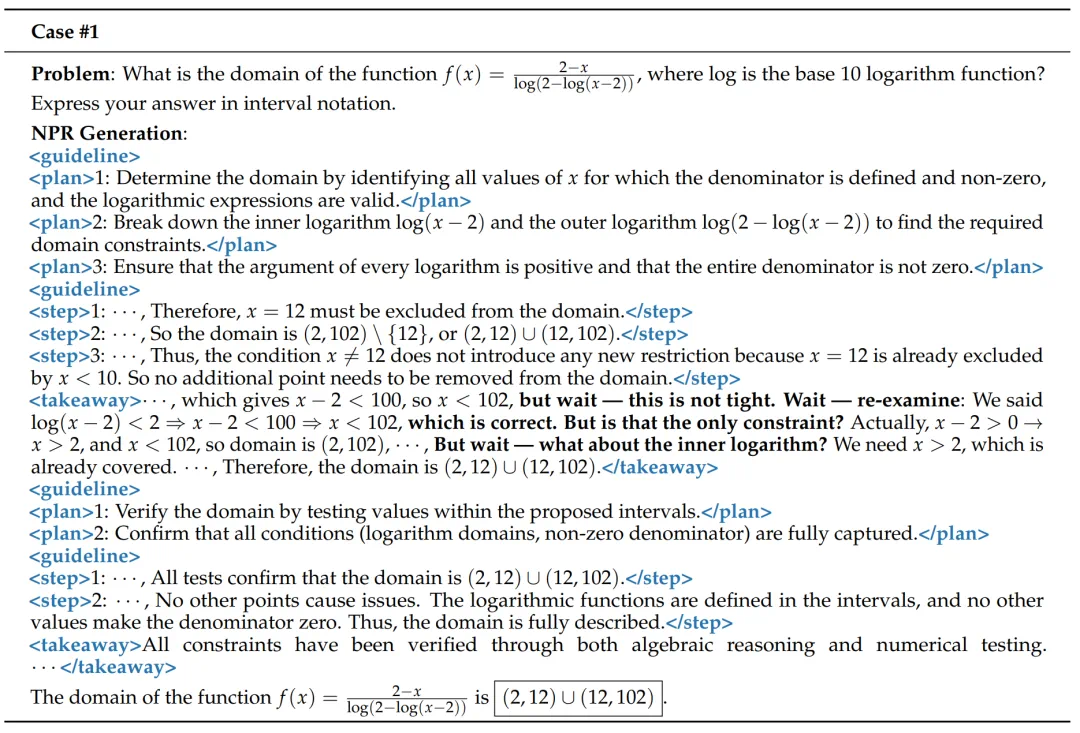

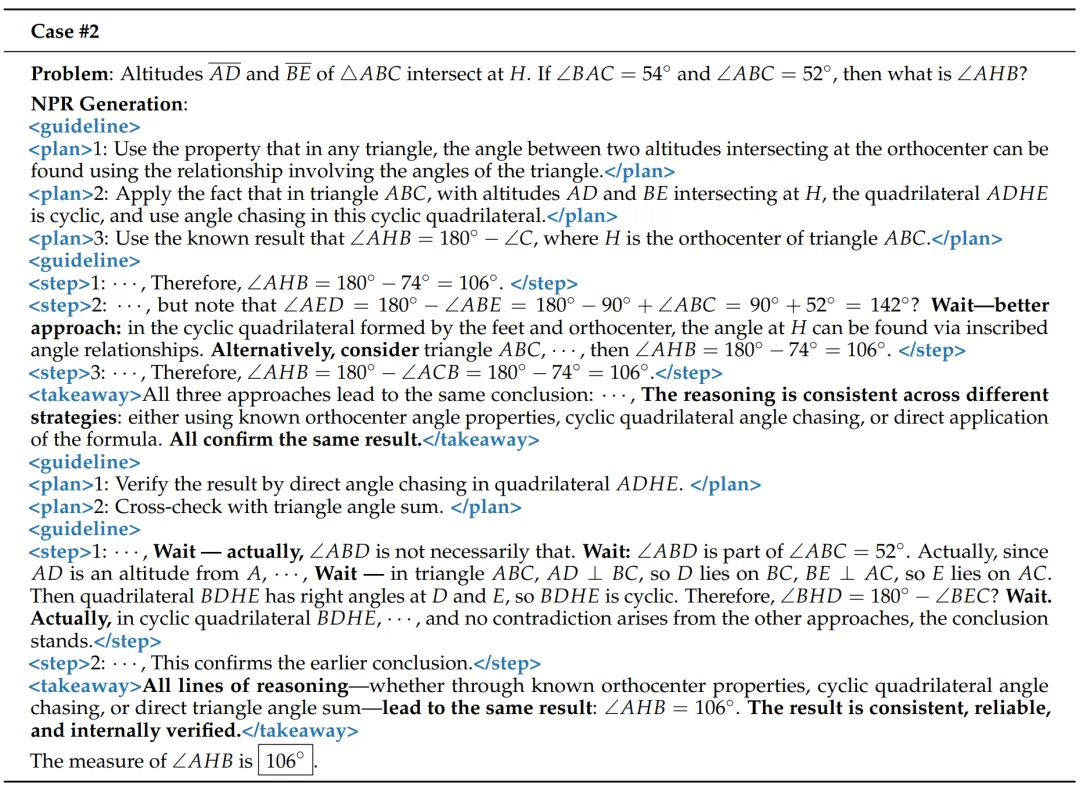

案例解析

论文给了若干具体题目的并行解法示例,典型模式为:

1. <guideline>:并行产生若干独立 plan(每个 plan 一句战术);

2. <step>:每个 plan 独立并行展开具体推理步骤;

3. <takeaway>:整合与交叉验证,得出最终结论并给出简短答案(boxed answer)。

举例:对于域函数或几何题,某些 plan 会分别做不同的分解(代数、数值检验、几何角度关系),最后 <takeaway> 将各分支结果比对、剔除不一致项并输出最终答案。这种「多角度并行 + 汇总」能显著减少因单一路径假设错导致的花费。

结语

本文提出了一种简单且可扩展的框架,用于构建原生并行推理器。该推理器无需依赖外部教师模型即可学习自适应分解、多样化的并行规划和可靠的聚合。通过将自提炼的并行 SFT 与智能体并行 RL 相结合,NPR 能够生成真正的并行推理策略,而非模拟或脚本化的策略。在八个推理基准测试上的实验表明,与 Multiverse 数据集、自回归训练和直接强化学习相比,该方法均有显著的改进。论文中的分析进一步证明了该方法能够显著加速推理、增强测试时的可扩展性,并且不存在伪并行行为。案例研究展示了该模型如何根据问题难度调整其并行性,从而实现结构化探索和稳健的验证。这些结果表明,原生并行推理是实现更通用、可扩展智能的一个有前景的方向。