英伟达最近真的痴迷上「小模型」了。

刚刚,英伟达发布了一个全新的混合架构语言模型系列,Jet-Nemotron。

论文地址:https://arxiv.org/pdf/2508.15884

项目地址:https://github.com/NVlabs/Jet-Nemotron

Jet-Nemotron系列有Jet-Nemotron-2B和Jet-Nemotron-4B大小。

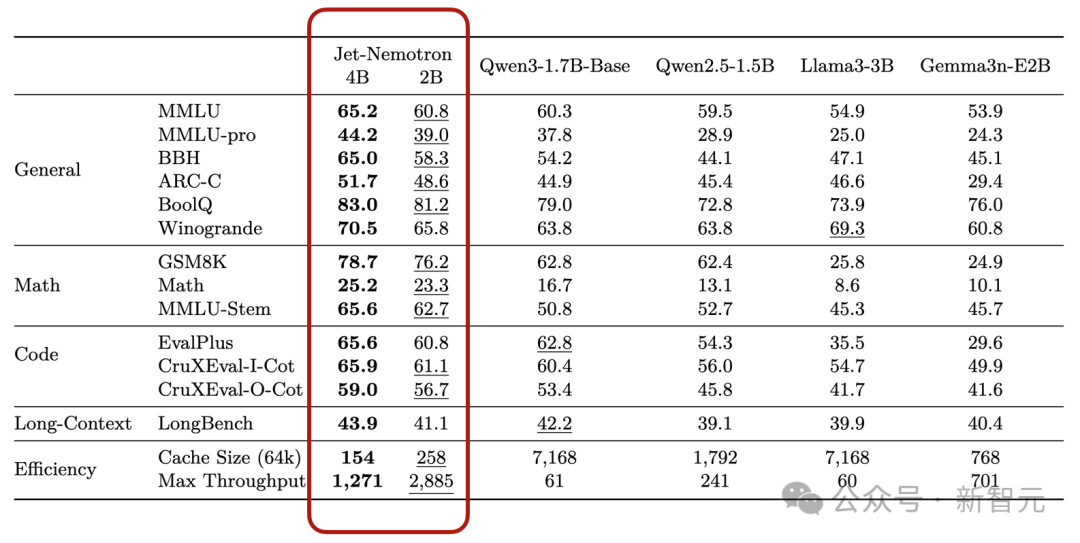

英伟达表示Jet-Nemotron系列「小模型」性能超越了Qwen3、Qwen2.5、Gemma3和 Llama3.2等当前最先进的开源全注意力语言模型。

同时实现了显著的效率提升,在H100 GPU上生成吞吐量最高可提升53.6倍。

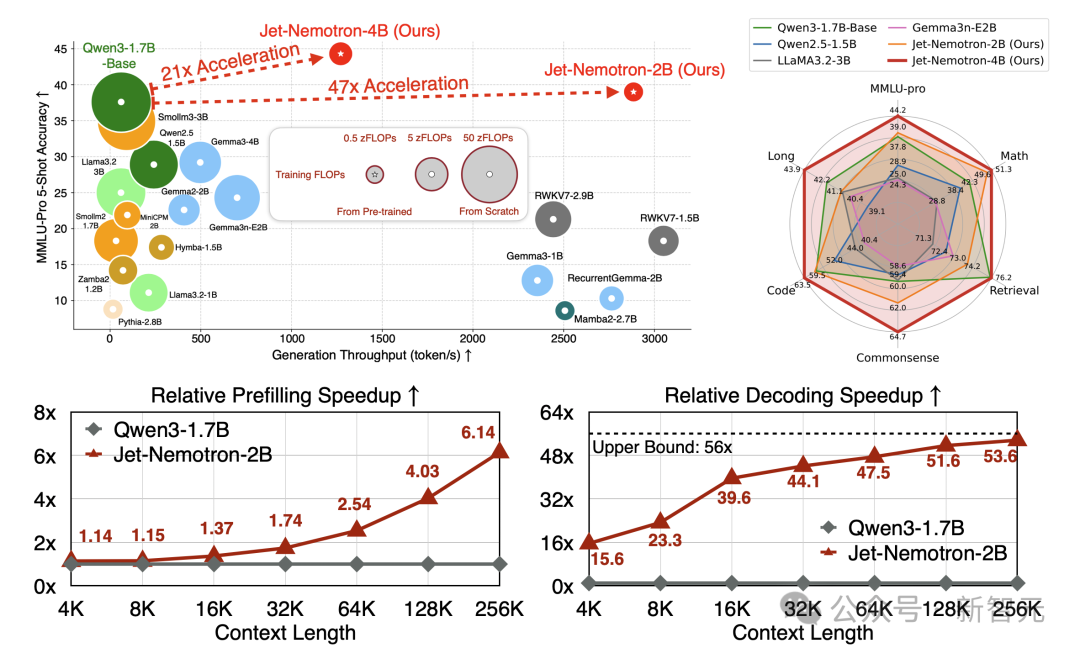

在右上角的雷达图中,可以看到Jet-Nemotron简直就是六边形战士。

Jet-Nemotron-4B模型在六个维度MMLU-pro、Math、Retrieval、Commonsense、Code、Long几乎都拉满。

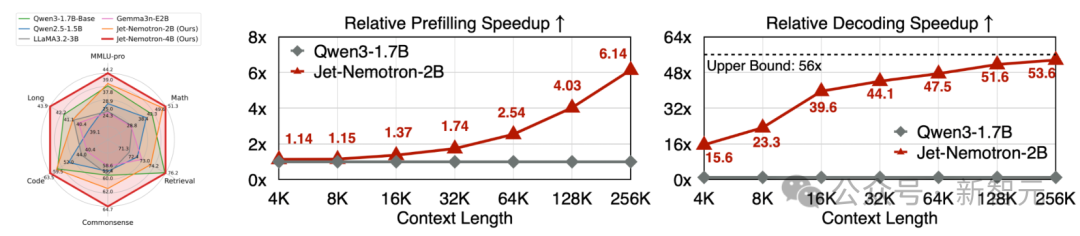

在预填充和解码阶段,Jet-Nemotron-2B在上下文越增加的情况下,相对Qwen 3-1.7B优势越夸张。

一句话总结就是同等硬件与评测设置下,Jet-Nemotron在长上下文的场景里,把吞吐做到了数量级提升(解码可达50倍提升)。

同时在常识/数学/代码/检索/长上下文等维度的准确率不降反升。

相较传统全注意力小模型又快又准。

看来,英伟达盯上了小模型Small Model这个领域。

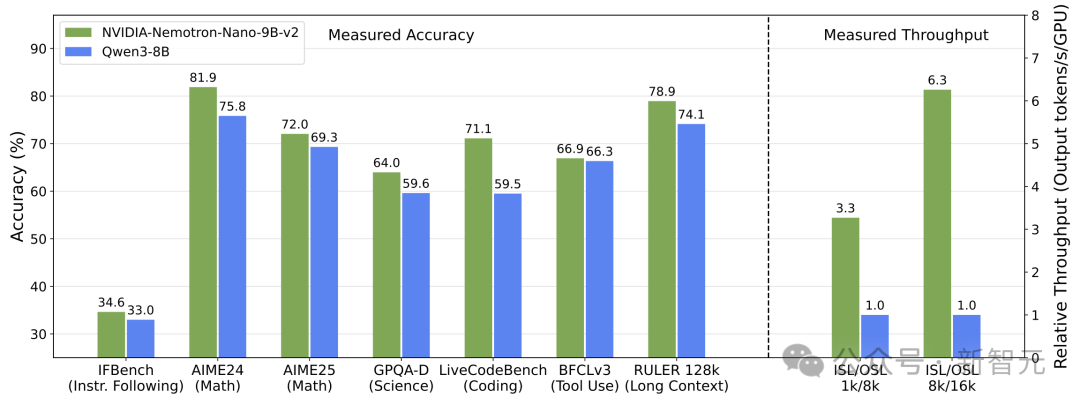

上一周,他们刚刚发布了只有9B大小的NVIDIA Nemotron Nano 2模型。

在复杂推理基准测试中实现了和Qwen3-8B相当或更优的准确率,并且吞吐量最高可达其6倍。

今天就推出了更小的Jet系列,体量降到了2B和4B模型。

核心创新

Jet-Nemotron有两项核心创新。

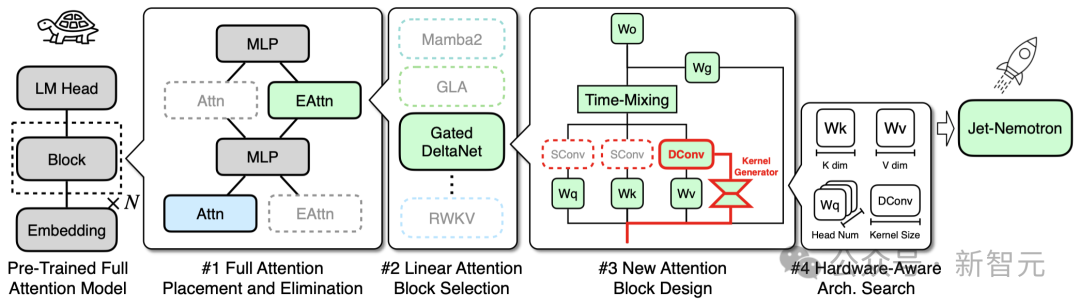

- 后神经网络架构搜索(Post Neural Architecture Search,PostNAS),这是一个高效的训练后架构探索与适应流程,适用于任意预训练的Transformer模型;

- JetBlock,一种新型线性注意力模块,其性能显著优于先前的设计,如Mamba2。

PostNAS:训练后架构探索与适配

与之前从头开始训练以探索新模型架构的方法不同,PostNAS在预训练的Transformer模型基础上进行构建。

同时支持对注意力块设计的灵活探索,从而大大降低了开发新语言模型架构的成本和风险。

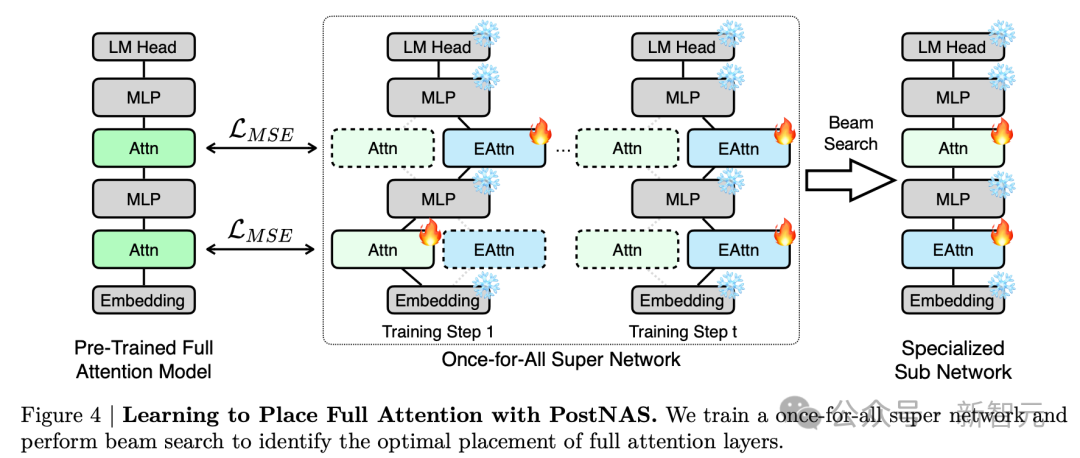

PostNAS首先确定全注意力层的最佳放置位置,然后再搜索改进的注意力块设计。

PostNAS从一个已预训练的全注意力模型出发,并将MLP冻结。

随后对高效注意力块的设计进行由粗到细的搜索:

先确定全注意力层的最优放置位置,再选择最合适的线性注意力块或采用新的线性注意力块,最后搜索最优的架构超参数。

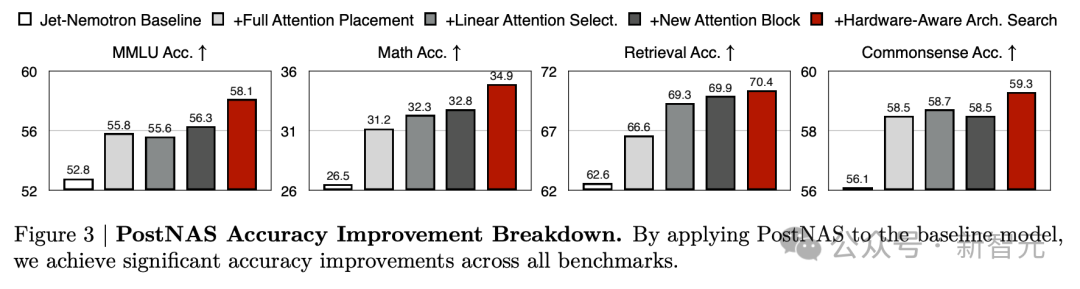

通过将PostNAS应用于基线模型后,在所有基准测试上都取得了显著的准确率提升。

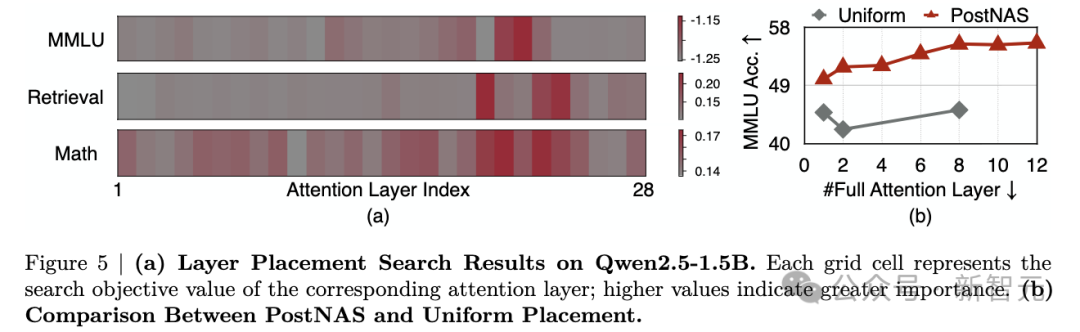

在预训练的Transformer模型中,并非所有注意力层的贡献都是相同的。

PostNAS揭示了预训练Transformer模型中重要的注意力层。

KV缓存大小是影响长上下文和长生成吞吐量的最关键因素。

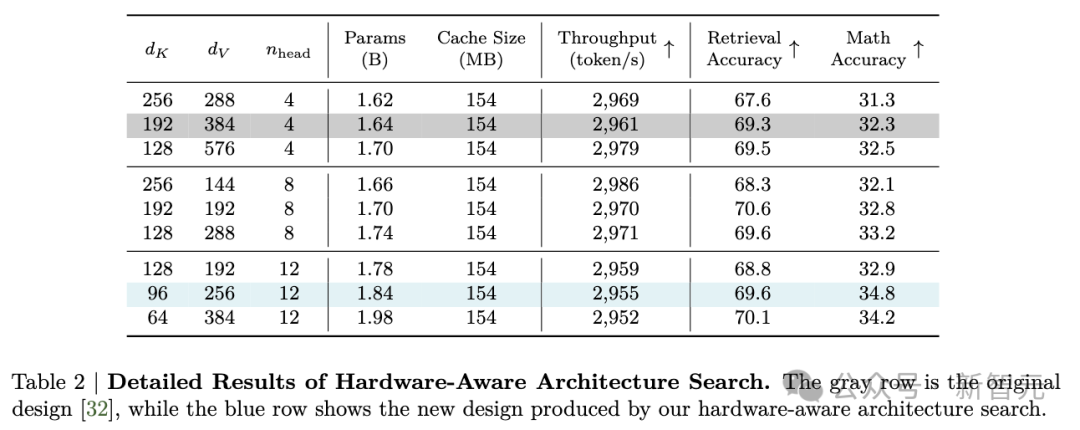

PostNAS硬件感知搜索能够发现一些架构,在保持相似生成吞吐量的同时,拥有更多参数并实现更高的准确性。

JetBlock: 一种具有SOTA准确率的新型线性注意力模块

通过PostNAS,引入了JetBlock:一种新颖的线性注意力模块,它将动态卷积与硬件感知架构搜索相结合,以增强线性注意力,在保持与先前设计相似的训练和推理吞吐量的同时,实现了显著的准确率提升。

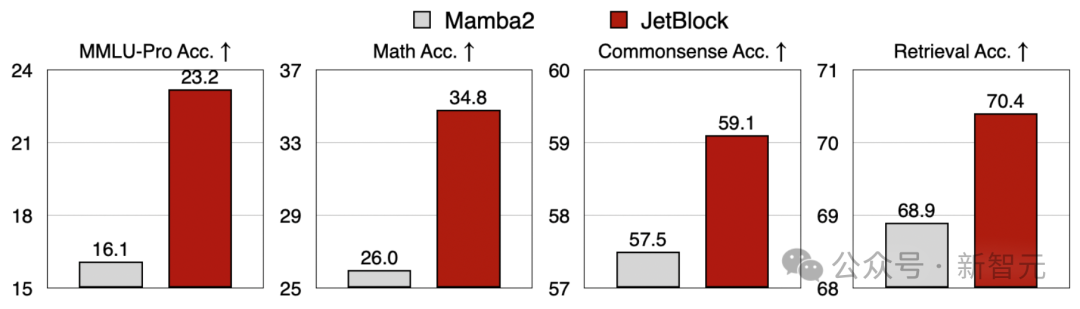

下方使用完全相同的训练数据和训练方案,对Mamba2 Block与JetBlock进行了公平的对比。

性能

Jet-Nemotron-2B和Jet-Nemotron-4B在全面的基准测试中达到或超过了主流高效语言模型(例如Qwen3)的准确率。

同时运行速度明显更快——分别比Qwen3-1.7B-Base快21倍和47倍。