AI的感知困境:一只眼睛的世界

我们习惯了AI能够处理文字、分析数据,但在处理复杂信息时,传统AI面临着三大感知困境:

文字与图像割裂

好比戴着眼罩工作的设计师,AI只能读懂文字,却看不懂图表中的趋势线、饼图中的占比关系。

OCR技术让AI能提取图像中的文字,却无法理解一张财务图表所传达的"销售额正在快速增长"这类视觉信息。

这就像让一个人只通过摸索来理解一幅画,注定失之偏颇。

碎片化思维

即使AI能获取大量信息,也难以形成连贯思路。

它就像一个可以背诵所有拼图碎片的人,却不知如何将它们拼成完整图案。

当你问"这份市场分析报告的主要结论是什么"时,AI可能只是简单重复报告中的句子,而非真正理解并整合图表与文本的核心观点。

经验短板

现有的视觉问答数据集大多针对单一图像,就像教孩子认识单个物体,却不教他理解复杂场景。

AI缺乏处理包含多页文档、多种图表、不同数据格式的真实复杂场景的经验,难以应对如"分析这份季度报告并指出其中的风险点"这类需要综合判断的任务。

这些问题制约着AI在商业分析、教育辅导、研究助手等高价值领域的应用。

人类要从单一感官的AI转向全面感知的AI,需要一场技术创新。

开启AI全模态感知与协作思考

ViDoRAG并非技术上的简单迭代,而是认知方式的根本变革。

这项阿里巴巴提出的技术正在重塑AI的感知与思考方式,如同人类从单一感官到多感官协作的进化飞跃。

全模态感知引擎:让AI"看懂"而非"看到"

传统AI只是被动地接收信息,而ViDoRAG的感知引擎让AI真正理解所见的内容。它包含两个关键创新:

动态感知智能网络

利用高斯混合模型(GMM)动态调节信息获取范围。

当你走进一个陌生的房间,你不会同等关注所有物品,而是自动筛选重要信息。这个网络模拟了人类的选择性注意力机制,通过相似度分布和期望最大化算法,智能地决定什么信息值得深入分析,什么信息可以忽略,避免被无关信息淹没。

多元信息融合系统

不再将文字、图表、结构割裂开来,而是保持它们的原始关联。

好比你看到一份报告,会自然地将正文描述与相应图表联系起来一样。

这个系统重建了不同模态信息间的逻辑连接,形成完整的知识图谱。当你问"公司第三季度业绩如何"时,AI能同时理解文字描述、财务图表和组织结构,给出全面分析。

协作智能决策系统:从单兵作战到团队协作

ViDoRAG突破了单一AI模型的局限,引入了三个专业智能体协作的决策系统:

探索智能体

类似于具有丰富经验的资深顾问,以宏观视角巡航信息海洋,发现潜在关联,把握整体方向。它不追求精确细节,而是凭借"直觉"找出关键线索和可能的突破点。

分析智能体

扮演专业分析师角色,对探索智能体发现的线索进行精细审查,验证初步假设。它审查的信息通常少于探索智能体,但分析更为深入,能够排除噪声干扰,提炼核心价值。

决策智能体

如同高管决策者,整合多方观点,验证逻辑一致性,形成最终判断。它不仅检验答案的准确性,还评估解决方案的完整性和一致性,确保最终输出既精确又全面。

这种分工协作模式,模拟了人类团队解决复杂问题的方式,实现了从信息收集、分析到最终决策的完整思维链路,大幅提升了处理复杂查询的能力。

结语

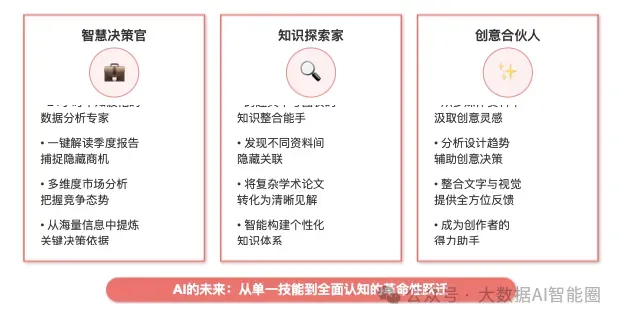

ViDoRAG代表了AI从单一技能向全面认知能力进化的重要一步。

未来,随着技术的进一步发展,我们可以期待:

1. 多模态认知将成为AI的标准配置,就像人类天生具备多感官一样。

2. 专业智能体协作将成为复杂问题解决的范式,模拟人类团队协作的方式。

3. AI将从被动的信息提供者转变为主动的思考伙伴,不仅告诉你"是什么",还能解释"为什么"和"怎么办"。

当AI能够像人类一样全面感知世界、协作思考问题时,它将真正成为我们认知能力的延伸,而不仅仅是信息处理的工具。

正如一位AI研究者所说:"让AI拥有全面感知和协作思考的能力,就像是让盲人重见光明,聋人重听声音。这不仅是技术上的突破,更是认知方式的革命。"