深度强化学习在机器人控制 、自动驾驶等复杂决策任务中取得了巨大成功([2])。

然而,传统强化学习算法训练出的策略网络往往对观测噪声和外部扰动十分敏感,导致输出的动作信号缺乏平滑性([3-5])。

现有的平滑方法大多从时域入手,例如设计与任务高度耦合的奖励函数、对网络施加复杂的正则化约束、或构建分层策略等。

这些方法虽然在特定任务上有效,但往往存在泛化性不强、限制网络表达能力或设计复杂等问题。

清华大学智能驾驶课题组(iDLab)另辟蹊径,在智能车辆领域顶级期刊IEEE Transactions on Intelligent Vehicles上发表的最新研究成果指出:控制策略的不平滑现象,本质上是输出序列中高频分量导致的。

图片

图片

论文链接:https://ieeexplore.ieee.org/document/10643291

这些高频分量主要由观测噪声引入,并在网络的正向传播中被放大。

因此,如果能设计一个神经网络,使其自身具备低通滤波能力,在滤除无用高频噪声的同时保留对控制有益的低频信号,即可有效提升策略的平滑性与鲁棒性。

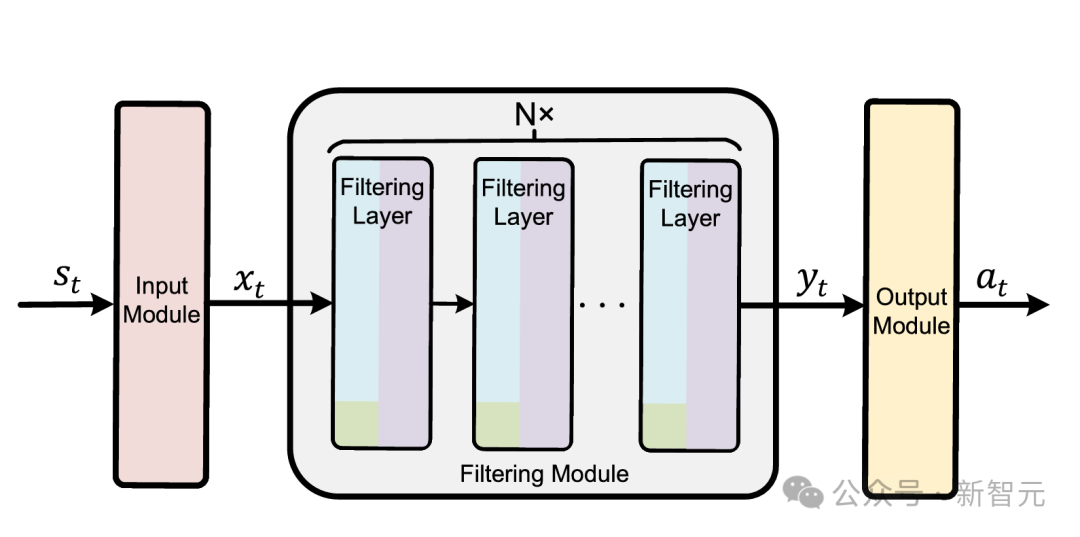

为实现上述目标,研究团队设计了名为Smonet的新型神经网络架构。

其核心是一个由多个串联滤波层组成的滤波模块,该网络包含三大关键组件:

图片

图片

图1 Smonet网络架构

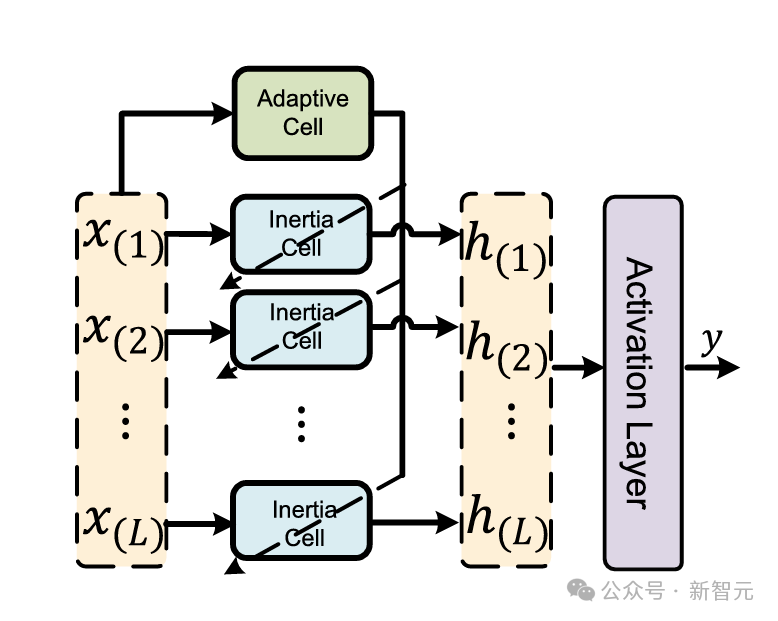

1. 惯性滤波单元 (Inertia Cell)

该单元是实现低通滤波的核心。它基于简单高效的一阶惯性滤波过程,通过对输入信号进行带有指数衰减权重的积分,有效滤除高频噪声成分,从而学习到一个平滑、低频的隐藏状态表征。

2. 自适应调节单元 (Adaptive Cell)

滤波不可避免地会引入延迟,过度平滑可能导致系统在需要快速响应时表现不佳。为解决这一矛盾,Smonet在每个滤波层中都设计了一个自适应单元。该单元能够根据当前输入信号的动态特性,自适应地调整惯性单元的滤波强度。这使得Smonet能够在系统状态平稳时提供强力平滑,在需要紧急规避或跟踪突变信号时又能实现快速响应,达到了平滑性与性能的有效平衡。

图片

图片

图2 Smonet滤波层

图3 Smonet滤波层内的核心单元

3. Smonet正则化训练方法

仅有网络结构还不够,为引导Smonet的滤波能力向「最优」的方向学习,研究团队进一步提出了一种配套的正则化训练方法。

该方法通过在标准强化学习策略损失函数中引入一个与滤波因子相关的正则项,鼓励网络在大部分状态下采用较小的滤波因子(即更强的平滑能力,同时允许策略的性能优化目标在必要时「推高」滤波因子以保证快速响应。

这种设计在优化过程中实现了控制性能和平滑性之间的动态权衡。

实验结果

研究团队在多个Mujoco仿真机器人控制任务和一个真实世界的移动机器人避障实验中,对Smonet的性能进行了全面验证。

仿真机器人控制

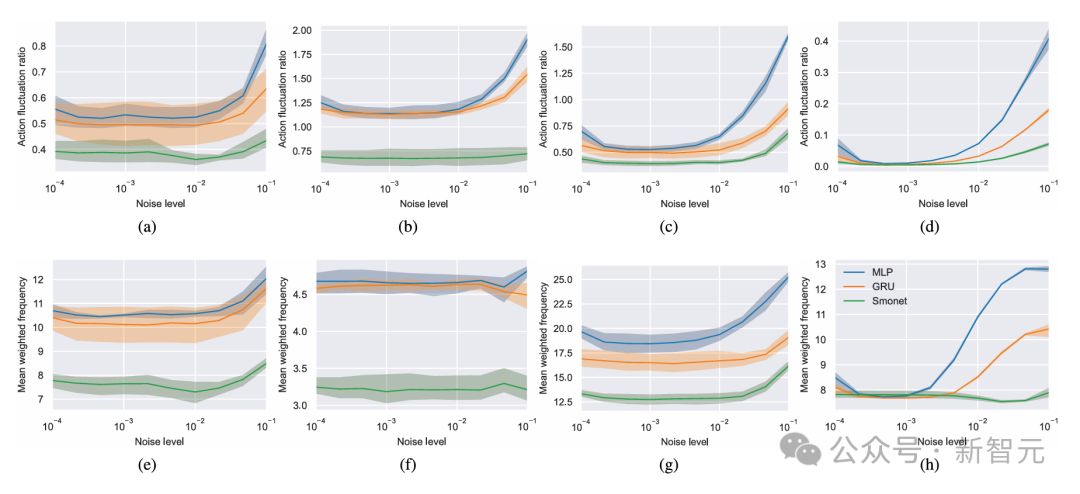

在Humanoid、Ant等多个标准测试环境中,Smonet与传统MLP、GRU网络进行了对比。

噪声鲁棒性:在无噪声环境下,Smonet的控制性能与其余网络结构相当。但在引入高斯噪声后,MLP和GRU的性能显著下降,而Smonet得益于其滤波能力,依然能保持高水平的控制性能。

动作平滑性:在所有噪声水平下,Smonet的动作波动率和平均加权频率均显著低于对比方法。与MLP相比,平均降幅分别达到48.2%和32.1%。

图4 不同噪声水平下的动作平滑性指标对比

图4 不同噪声水平下的动作平滑性指标对比

移动机器人避障

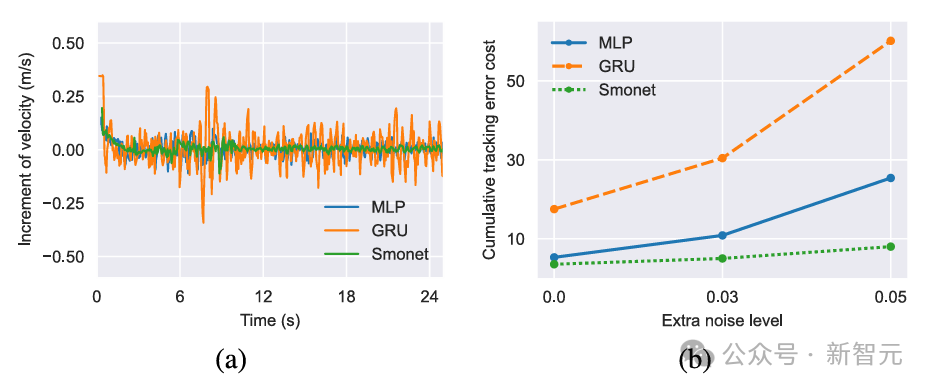

为了验证Smonet在真实世界中的效果,研究团队将训练好的策略部署到一台两轮移动机器人上,执行轨迹跟踪与动态避障任务 。

实验结果表明,Smonet生成的控制指令明显比MLP和GRU更平滑、抖动更小。

在引入额外的人工观测噪声后,Smonet不仅保持了最低的动作波动,还实现了最低的累积跟踪误差,展现出较好的鲁棒性。

在高噪声下,其动作波动率相比MLP和GRU分别降低了57.9%和70.4%。

图5 真实机器人实验中的控制动作(左)与累积跟踪误差(右)

图5 真实机器人实验中的控制动作(左)与累积跟踪误差(右)

总结

研究人员针对强化学习在真实世界应用中的动作震荡痛点,创新性地从频域视角出发,提出了具备低通滤波能力的神经网络Smonet。

通过内置的惯性滤波单元、自适应调节单元以及配套的正则化训练方法,Smonet在不牺牲控制性能的前提下,显著提升了策略的平滑性和噪声鲁棒性。

仿真与真实世界实验的成功验证,证明了该方法在迈向更安全、更稳定、更可靠的智能控制系统方面具有巨大潜力,为强化学习和具身智能技术在现实世界的落地应用铺平了道路。

参考资料:

[1] W. Wang, J. Duan, X. Song, et al. "Smooth Filtering Neural Network for Reinforcement Learning." IEEE Transactions on Intelligent Vehicles, vol. 10, no. 5. pp. 3103-3112, May 2025.

[2] S. E. Li. Reinforcement Learning for Sequential Decision and Optimal Control. Singapore: Springer Verlag, 2023.

[3] Y. Wang, W. Wang, X. Song, et al. "ODE-based Smoothing Neural Network for Reinforcement Learning Tasks." The Thirteenth International Conference on Learning Representations (ICLR), 2025.

[4] X. Song, L. Chen, T. Liu, et al. "LipsNet++: Unifying Filter and Controller into a Policy Network." International Conference on Machine Learning (ICML). PMLR, 2025.

[5] X. Song, J. Duan, W. Wang, et al. "LipsNet: A Smooth and Robust Neural Network with Adaptive Lipschitz Constant for High Accuracy Optimal Control." International Conference on Machine Learning (ICML). PMLR, 2023.