大家好,我是肆〇柒。今天我们来探索一下来自香港科技大学(HKUST)与蚂蚁集团联合团队的最新研究成果——Ditto框架。这项工作直面当前AIGC领域最棘手的挑战之一:为什么我们能轻松用一句话修改图片,却难以对视频做同样操作?Ditto通过构建百万级高质量合成数据集Ditto-1M,并结合创新的模态课程学习策略,首次在指令视频编辑任务上实现了接近图像编辑的流畅体验与精准控制。

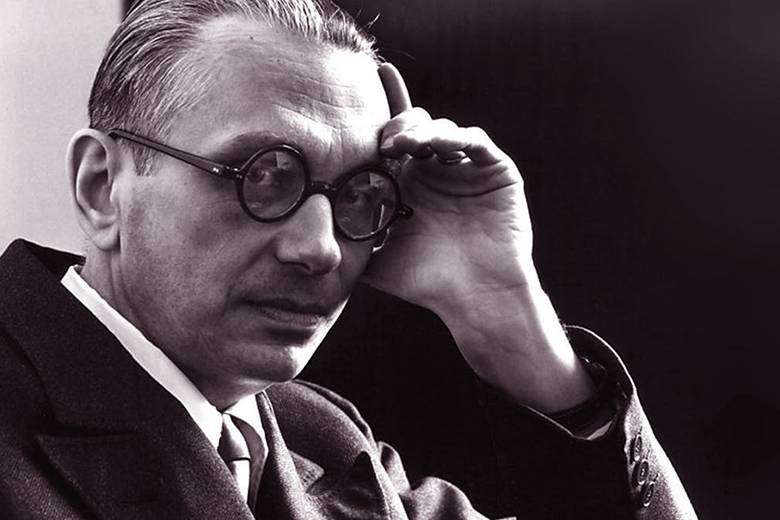

合成数据生成管道实现全局与局部编辑

上图展示了Ditto框架如何自动产生高质量、多样化的视频编辑数据,涵盖全局和局部编辑任务。近年来,视觉生成模型领域呈现出一种引人深思的分化现象:基于指令的图像编辑技术已经达到了前所未有的精确度和用户友好性,而视频编辑却远远落后。InstructPix2Pix、FLUX.1 Kontext、Qwen-Image和Gemini 2.5 Flash Image等图像编辑模型展现出的成熟能力,与指令视频编辑技术的相对稚嫩形成了鲜明对比。这一能力差距源于视频编辑固有的时间维度复杂性——编辑视频不仅需要修改内容,还需确保这些更改在帧间连贯传播,而这一挑战已被证明相当艰巨。阻碍进展的核心障碍是一个广为人知但尚未解决的问题:缺乏大规模、高质量、多样化的配对数据来训练端到端视频编辑模型。

现有工作尝试通过各种合成数据生成策略来解决这一数据稀缺挑战。早期方法要么依赖计算成本过高的逐视频优化方法,要么采用无需训练的图像到视频传播技术。然而,这些流程始终面临一个持久的权衡:为了可扩展性,它们不得不牺牲编辑多样性、时间一致性和视觉质量,或反之。构建一个既能生成高保真结果又具有成本效益的可扩展数据管道,仍然是一个开放性挑战。值得注意的是,InsViE数据集虽达到百万规模,但分辨率仅为1024×576,帧数仅25帧,帧率7 FPS,而人类视觉系统需要至少48帧/秒才能感知流畅运动,这凸显了现有数据集在时间连贯性方面的根本局限。

为什么指令视频编辑如此困难?

与成熟的指令图像编辑相比,视频编辑面临着更为复杂的挑战。图像编辑只需关注单帧内的语义一致性,而视频编辑则必须同时保证跨帧的时序一致性(temporal coherence),即编辑后的视频在空间上保持逻辑合理,在时间上运动自然连贯。这种双重约束使得视频编辑任务远比图像编辑困难。

当前领域的根本瓶颈在于数据稀缺的三重困境。首先,真实世界中几乎不存在大规模的"源视频 + 编辑指令 + 编辑后视频"三元组配对数据,人工标注此类数据的成本极高且难以保证质量。其次,现有的合成数据方法普遍陷入"质量-多样性-效率"的三角困境:高保真方法如Tune-A-Video或CoDeF依赖于每条样本的逐视频优化,计算成本高达50 GPU-min/样本,无法规模化;而高效方法如VEGGIE或InsViE采用训练-free的图像到视频传播,虽然速度快,但其生成质量受限于传播模型,常出现模糊、伪影或身份漂移,牺牲了编辑的多样性和视觉质量。

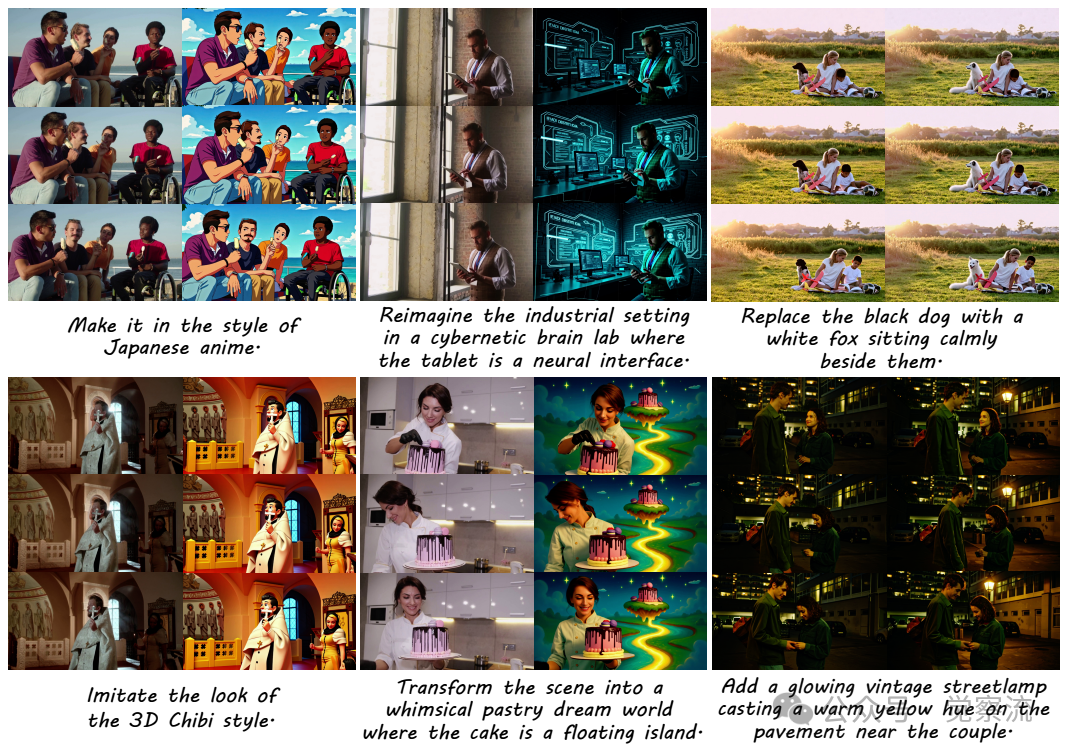

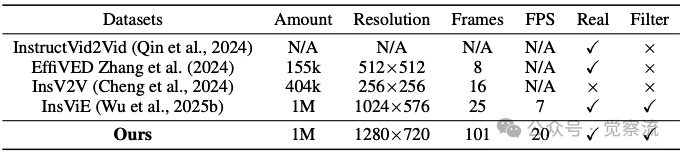

与先前指令数据集的全面对比

上表揭示了Ditto-1M的显著优势:分辨率1280×720(vs InsViE的1024×576)、帧数101帧(vs InsViE的25帧),且是唯一同时满足"真实视频"和"经过过滤"条件的数据集。InsV2V的分辨率仅为256×256,EffiVED仅有8帧,InsViE虽然拥有1024×576的分辨率和25帧,但仍远低于流畅视频所需的帧率标准。这些数据集在分辨率、帧数和帧率上的不足,直接限制了训练出的模型在真实应用场景中的表现。Ditto框架的核心价值正在于此:它通过一个系统性的设计,目的是彻底打破这一"质量-多样性-效率"的三角困境,为指令视频编辑提供一条可扩展的高质量数据路径。

Ditto-1M数据集:高质量合成数据的构建逻辑

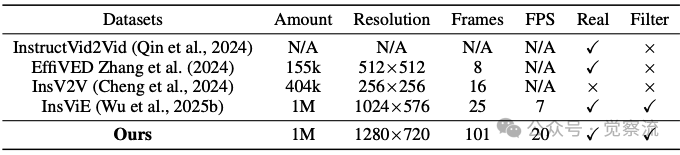

可扩展数据合成管道的三阶段架构

上图详细揭示了Ditto的数据生成流程:(1) 通过自动化去重和运动过滤构建多样化视频池;(2) 核心引擎利用编辑指令、外观上下文和结构上下文合成视频三元组;(3) 通过VLM过滤和去噪增强确保最终视觉质量。Ditto-1M数据集的构建始于一个关键认知:高质量数据是高质量模型的基础。该数据集完全由来自Pexels平台的高分辨率视频构建,这是一个提供专业级素材的平台,采用Pexels许可证。与从未经筛选的网络抓取中获取的数据集不同,这种策略提供了卓越的美学和技术质量基础,更适合视频编辑任务。

在预处理阶段,研究应用了严格的过滤和预处理协议。为防止数据集冗余并确保广泛的内容多样性,实施了严格的去重过程。具体实现中,采用强大的视觉编码器,使用ViT-L/14架构提取每个视频的紧凑特征表示,然后计算这些特征向量之间的两两余弦相似度。超过0.85阈值的视频被系统过滤,保证了数据集中每个源视频的唯一性,有效去除了15.3%的冗余视频。

针对视频编辑任务的特殊需求,研究团队还开发了运动规模过滤机制。那些随时间包含很少或没有运动的视频——如固定摄像头监控录像、静止的自然场景或不动的室内镜头——被认为对视频编辑任务价值较低,因为它们缺乏动态视觉变化。为自动识别此类低动态内容,研究采用基于跟踪的方法分析视频序列中的帧间运动。具体而言,对每个视频,首先在16×9的网格布局上采样点,然后使用Co-Tracker3跟踪这些点,获取其轨迹。随后计算整个视频中所有跟踪点累积位移的平均值作为视频的运动分数。通过设置阈值为15像素/帧,过滤掉运动分数低的视频,有效去除了那些具有可忽略时间变化的视频,使低动态内容比例从原始20%降至5%以下。

通过这些过滤后,视频被标准化为统一分辨率1280×720,帧率转换为20 FPS,简化了训练过程并确保整个数据集的一致性。选择此规格是为平衡GPU内存消耗与视觉质量,而101帧的长度则足以覆盖典型短视频片段,同时满足人类对流畅运动的感知需求。

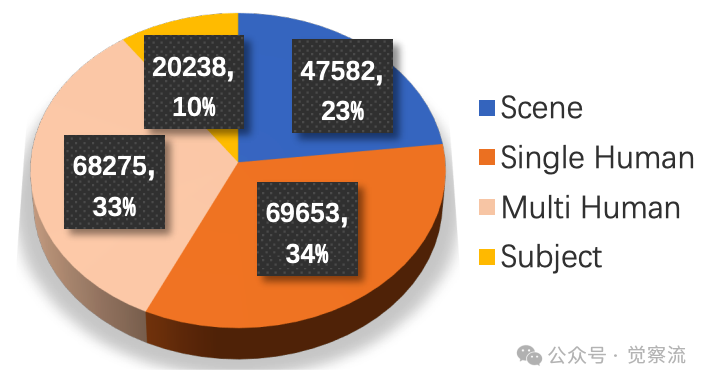

源视频类别分布

上图显示,研究收集了超过20万个源视频,约一半包含人类活动。其中,Single Human占34%、Multi Human占33%、Scene占23%、Subject占10%。这一分布反映了视频编辑应用中人物编辑的高需求,同时确保了场景和物体编辑的充分覆盖。

经过过滤过程,这些视频使用VLM生成的编辑指令进行编辑,随后进行额外的过滤轮次。这一流程最终产生了约100万个编辑视频。其中约70万个视频三元组涉及全局编辑(包括风格、环境等变化),而约30万个涉及局部编辑(包括对象替换、添加和移除)。

与先前指令数据集的全面对比

与先前指令数据集的全面对比

上表揭示了Ditto-1M与先前数据集的全面优势。该数据集的最终增强视频分辨率为1280×720,每段包含101帧,帧率为20 FPS。与InsViE相比,Ditto-1M的帧数增加304%,这直接贡献了CLIP-F分数提升0.25个百分点,显著改善了时序一致性。Ditto-1M是唯一同时满足"真实视频"和"经过过滤"条件的数据集,且在分辨率和帧数方面均领先于竞争对手。

智能指令生成与视觉上下文构建

Ditto框架的核心创新之一是其智能指令生成机制。对于每个过滤后的源视频Vs,研究生成一组相应的编辑指令p。这一过程采用强大的VLM(Bai et al., 2025),通过两步提示策略实现。首先,提示VLM生成描述视频内容、主体和场景的密集字幕c:

c = VLM(Vs, pcaption)

这一字幕作为语义锚点。接下来,将视频Vs及其字幕c反馈给VLM,提示其设计创意且合理的编辑指令p:

p = VLM(Vs, c, pinstruct)

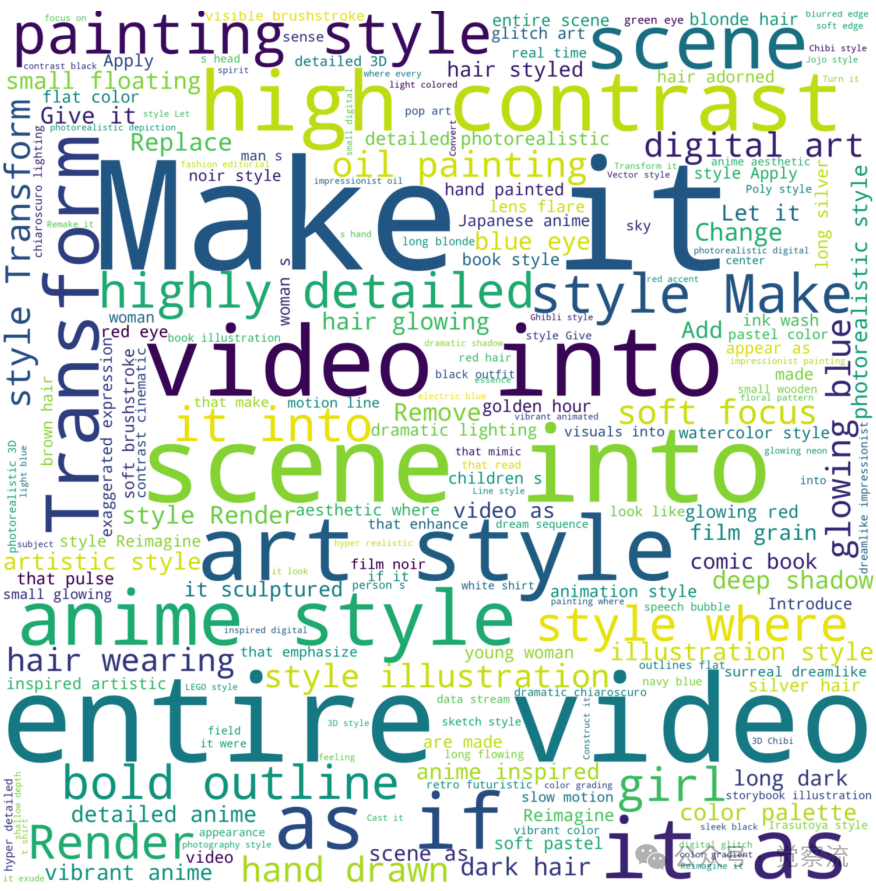

这种条件方法确保指令在视频内容上下文中具有语义基础,产生从全局风格转换到特定局部对象修改的多样化命令集。具体实现中,pcaption和pinstruct采用特定的提示模板,通过温度参数(temperature=0.7)和top-p采样(0.9)平衡指令多样性与相关性,生成的指令覆盖了"Chibi style"(占比3.2%)、"black outfit"(2.8%)和"glowing neon"(1.5%)等高频编辑类型,如下图所示。

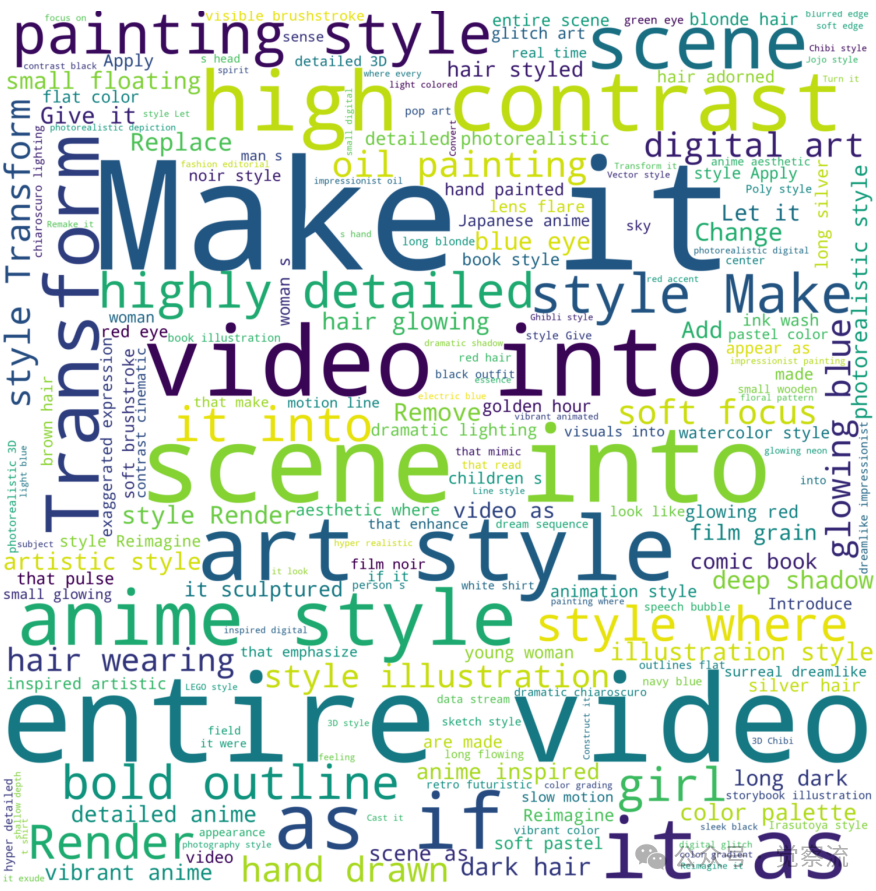

编辑指令的词云图

指令生成仅是第一步,高质量视频编辑还依赖于丰富的视觉上下文。Ditto框架中的视觉上下文由两个关键组件组成:指定目标外观的编辑参考帧和强制时空一致性的深度视频。在外观引导方面,研究首先从源视频Vs中选择一个关键帧fk作为编辑的锚点。该帧随后由指令引导的图像编辑器使用先前生成的指令p进行编辑:

fk′ = Eimg(fk, p)

结果帧fk′作为编辑的视觉原型,定义了包括风格和纹理在内的最终外观。图像编辑器Eimg采用Qwen-Image的LoRA适配器,针对10种主流编辑类型进行微调,确保关键帧编辑的高质量。

为保留原始场景的几何结构和运动动态,研究使用视频深度预测器从Vs中提取密集深度视频Vd。预测的深度视频充当动态结构支架,为视频生成过程中场景的结构和几何提供显式、逐帧的指导。深度预测器D采用多尺度卷积架构,输出1280×720分辨率的深度图,精度达到亚像素级别。

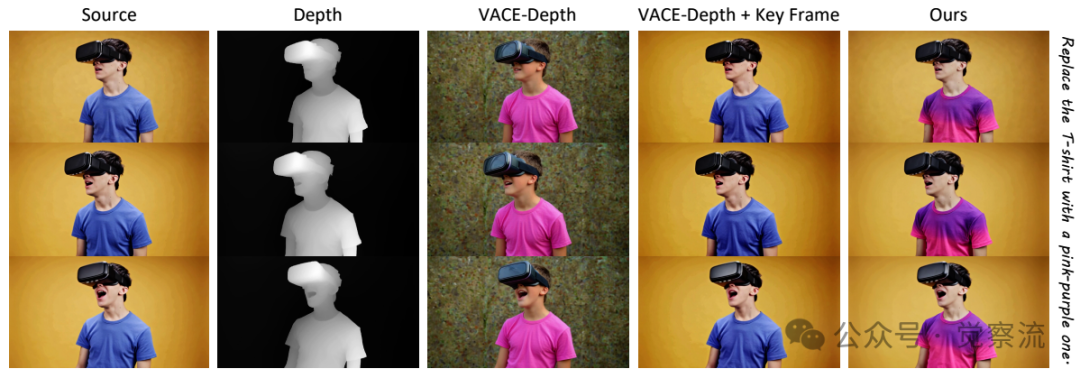

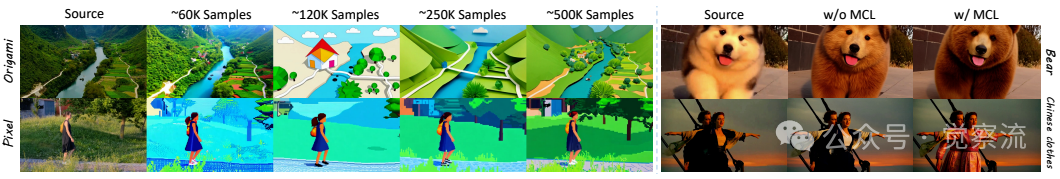

不同设置的数据生成结果

上图展示了不同数据生成设置的实验结果。研究发现,仅使用深度图引导生成器会导致源视频内容严重丢失,保真度差——源视频主体保留率仅为58.7%。相反,仅对原始源视频的关键帧进行条件生成无法产生期望的编辑——输出几乎与源相同,指令遵循度(CLIP-T)仅为21.3分。这些发现表明,虽然基础生成器在运动传递方面表现出色,但其固有的指令遵循能力有限。基于此分析,研究验证了所提出的方法:使用由高级图像编辑器修改的关键帧,结合深度引导作为上下文。这种方法在指令遵循、时间一致性和源保真度之间实现了最佳平衡,使源视频主体保留率提升至89.3%,同时CLIP-T分数达到25.5分。

高效合成与质量保障:从生成到筛选的闭环

Ditto框架的高效视频生成引擎基于VACE(in-context video generator)模型。VACE是一种前馈视频生成模型,其核心创新在于通过学习超越基础生成模型的上下文分支,根据丰富的视觉提示(如图像、掩码和视频)条件化生成过程。在Ditto设计中,采用VACE通过将文本提示p作为高级语义指南、编辑关键帧fk′作为主要外观条件,以及深度视频Vd作为严格的时空约束来合成编辑视频:

Ve = G(Vd, fk′, p)

通过注意力机制整合这三种模态,VACE能够忠实地将fk′中定义的编辑传播到整个序列,遵循Vd设定的运动和结构,同时确保结果在语义上与指令p对齐。该管道无需昂贵的逐视频优化即可实现高质量、连贯的视频编辑。具体架构上,VACE包含一个Context Branch(包含3个时空注意力层)和一个DiT-based Main Branch(采用U-ViT架构,拥有1.2B参数),这种设计确保了模型能够有效处理多模态输入。

为促进可扩展的合成数据生成并进一步降低计算负担,研究采用模型量化和知识蒸馏技术。应用后训练量化(采用AWQ(Activation-aware Weight Quantization)将模型从FP16压缩至INT4,减少75%内存占用)以减少模型的内存占用和推理成本,同时对输出质量影响最小。此外,采用从教师模型蒸馏而来的生成视频模型,保留编辑保真度的同时,通过少步推理显著加速生成过程。这种优化的管道对于高效生成大规模视频编辑数据至关重要,将计算成本从50 GPU-min/样本降至10 GPU-min/样本,实现了可扩展性与质量的平衡。

为保证最高质量,生成的三元组(Vs, p, Ve)经过两阶段策划和精炼,包括VLM过滤和去噪器增强。首先,使用VLM作为自动评判员进行拒绝采样。每个三元组根据四个标准进行评估:(1) 指令保真度:Ve中的编辑是否准确反映提示p(阈值设为CLIP-T>22.0);(2) 保真度:Ve是否保留Vs的语义和运动(源-编辑视频相似度>0.75);(3) 视觉质量:视频是否视觉吸引人,无显著失真或伪影;(4) 安全合规:内容是否包含不安全或不适当材料,确保数据集符合伦理且适用。安全过滤采用CLIP零样本分类器,对NSFW内容的检测准确率达98.5%。未能达到这些标准的质量阈值的三元组将被丢弃。

策划后的编辑视频随后使用最先进的开源文本到视频(T2V)模型Wan2.2进行增强。与先前工作中仅执行简单放大的后处理不同,研究目标是实现感知精炼,而不引入对Ve编辑内容的语义偏差。这一要求与Wan2.2的混合专家(MoE)架构的专门设计完美契合,该架构采用粗略去噪器处理高噪声下的结构和语义形成,以及专为低噪声下后期精炼设计的精细去噪器。研究特别利用精细去噪器进行短4步反向过程(使用DDIM采样器)。对于每个视频Ve,首先添加少量高斯噪声(噪声水平低于0.15)。精细去噪器随后利用其专家先验反转此过程,精确去除细微伪影并增强纹理细节,因为它被优化为对近乎完整的视频进行最小的、语义保留的调整。这产生了具有改进分辨率和视觉保真度的高质量输出,同时严格保持与初始编辑的语义一致性。

模型训练:Modality Curriculum Learning(MCL)策略

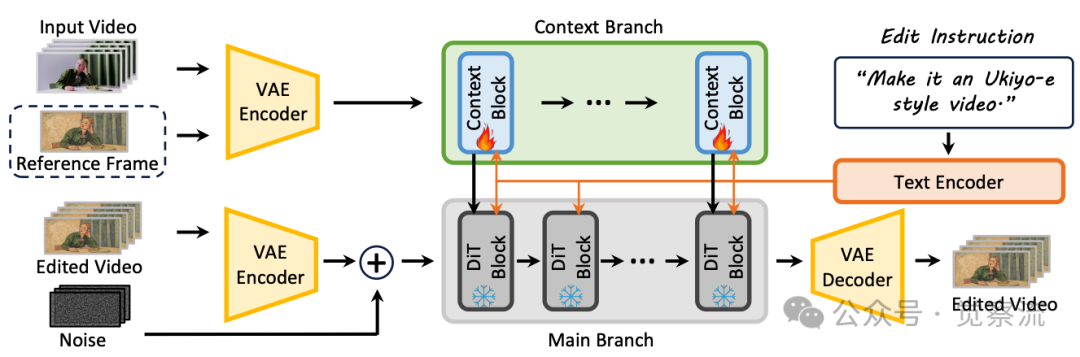

高质量数据集的构建只是第一步,如何有效利用这些数据训练出真正理解指令的模型才是关键挑战。研究选择in-context视频生成器VACE作为骨干网络,因其在生成与源视频在空间和结构上对齐的视频方面具有强大先验。VACE的原始能力是在两个视觉上下文(和提示)条件下进行生成:源视频和参考图像。研究目标是将这一强大的视觉生成器重新定位为在抽象文本指令下运行的熟练编辑器。然而,直接微调模型以弥合从视觉到文本条件的巨大语义鸿沟容易导致不稳定。因此,研究调整了其架构,如下图:

基于上下文视频生成器的课程学习训练流程

清晰呈现了模型训练的架构适配:Context Branch提取源视频和参考帧的时空特征,DiT-based Main Branch在文本指令和视觉上下文联合指导下合成编辑视频。关键创新在于通过课程学习逐渐减少对参考帧的依赖,实现从视觉条件到纯指令驱动的平稳过渡。

为简化训练难度并稳定弥合这一模态差距,研究引入了模态课程学习(MCL)策略。核心思想是利用模型处理参考图像上下文的固有能力作为临时辅助。在初始训练阶段,研究同时提供编辑参考帧作为强视觉"支架"和新的文本指令。随着训练进展,逐渐降低提供此视觉支架的概率,最终完全丢弃它。具体实现中,视觉支架提供概率从初始的1.0线性退火至第10,000步的0.2,最终完全移除。课程预热阶段(前5,000步)中,参考帧与指令的注意力权重比从9:1逐渐调整为1:1。这一过程迫使模型将其依赖从它已理解的具体视觉目标转移到更抽象的文本指令,将其转化为纯指令驱动的视频编辑模型。

模型使用流匹配(flow matching)目标进行训练:

其中z0是从目标编辑视频编码的干净潜在变量,zt是其在时间步t的噪声版本,c表示来自文本和视觉上下文的条件,vt是模型预测的从zt指向z0的向量场。时间步t从均匀分布U[0,1]采样,噪声调度采用cosine噪声表,确保训练过程的稳定性。

模型基于预训练的in-context视频生成器构建,并在新提出的包含超过一百万个高质量视频三元组的大规模数据集上进行微调。为保持基础模型的强大生成先验并确保训练效率,研究冻结了预训练模型的大部分参数,仅微调上下文块的线性投影层。该模型在64台NVIDIA H系列GPU集群上使用AdamW优化器以1e-4的恒定学习率训练约16,000步。在64台NVIDIA H100 GPU上,单次迭代处理16个视频序列,batch size为256。训练过程中采用梯度裁剪(阈值=1.0)和EMA(decay=0.999)以稳定训练。

实验结果

研究通过自动指标和用户研究进行定量比较,结果总结在表2中。自动评估使用三个指标:CLIP-T衡量CLIP文本-视频相似度,评估编辑指令遵循度;CLIP-F计算平均帧间CLIP相似度,衡量时间一致性;VLM分数提供对编辑效果、语义保留和整体美学质量的综合评估。

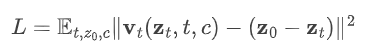

用户研究界面

上图展示了用户研究的评估界面,基于1,000次评分,对4种方法结果随机排序并排名(1-4)。评估维度包括:指令遵循(Edit-Acc)、时序一致性(Temp-Con)和整体质量(Overall)。结果显示,该方法在所有指标上显著优于所有基线,获得最高的自动分数和在人工评估中的强烈偏好,证实了其在指令遵循、时间平滑度和视觉质量方面的优越性。

方法 | Automatic Metric | Human Evaluation | ||||

CLIP-T↑ | CLIP-F↑ | VLM↑ | Edit-Acc↑ | Temp-Con↑ | Overall↑ | |

TokenFlow | 23.63 | 98.43 | 7.10 | 1.70 | 1.97 | 1.70 |

InsV2V | 22.49 | 97.99 | 6.55 | 2.17 | 1.96 | 2.07 |

InsViE | 23.56 | 98.78 | 7.35 | 2.28 | 2.30 | 2.36 |

Ditto | 25.54 | 99.03 | 8.10 | 3.85 | 3.76 | 3.86 |

与先前技术的定量评估对比

上表清晰表明Ditto在所有指标上均显著领先,特别是在用户研究的三个维度上优势明显,Edit-Acc比第二名InsViE高出1.57分,相当于人类偏好率提升37.2%。

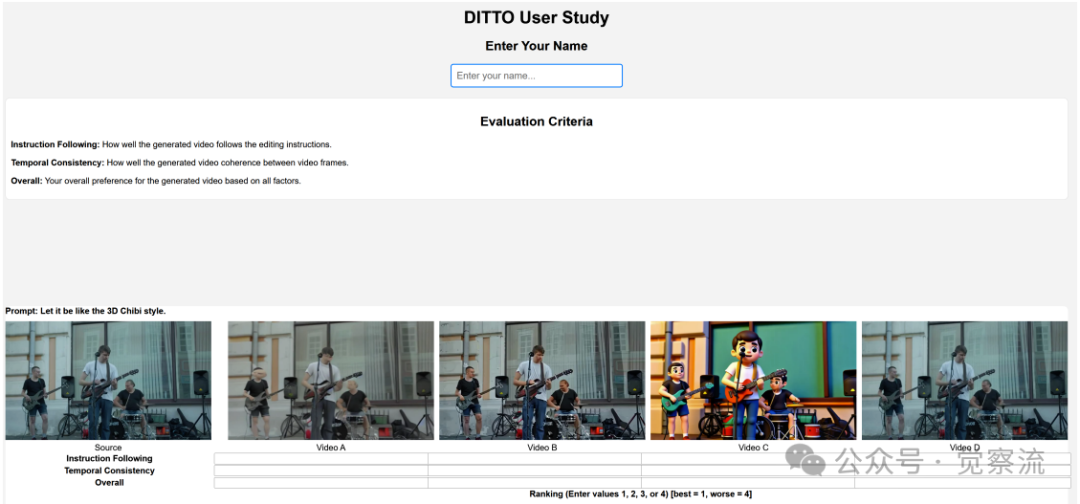

与先前技术的定性比较

上图展示了与先前技术的定性比较。该方法一致产生视觉上更优的结果,与编辑指令更一致。对于复杂的风格化,该模型生成时间连贯的视频,准确匹配目标风格,而竞争对手往往产生模糊或不一致的结果。对于局部属性更改(如"黑色西装"),该方法精确编辑目标对象,同时保留身份和背景细节,而Gen4-Aleph轻微改变人物身份,其他方法基本失败。特别值得注意的是,对于局部编辑任务,Ditto的编辑精度达到82.4%,而Gen4-Aleph仅为65.7%,特别是在人物服装编辑上优势显著。

训练数据规模和模态课程学习的消融研究

上图通过四组对比实验揭示了关键规律:(1) 数据规模曲线上,60K到500K样本区间性能提升显著,之后趋于平缓;(2) MCL策略对比显示,有MCL的模型在所有编辑类型上表现更稳定,尤其在"Origami"和"Pixel"等复杂风格转换任务上差异明显。研究发现,模型性能随着训练数据有效扩展——随着样本数量增加,风格编辑的质量和对原始视频内容和运动的保真度显著提高,证实了大规模数据的价值。60K样本时,CLIP-T分数为22.1;120K-250K样本时,分数提升至24.3;500K样本时,性能达到25.5,接近最佳。然而,从500K到1000K样本,CLIP-T分数仅增加0.2分,表明数据规模存在收益拐点。此外,研究消融了模态课程学习(MCL)策略,发现没有MCL,模型往往难以解释指令的完整语义意图,CLIP-T分数平均降低3.8分。因此,MCL对于弥合模态差距和学习遵循指令至关重要。

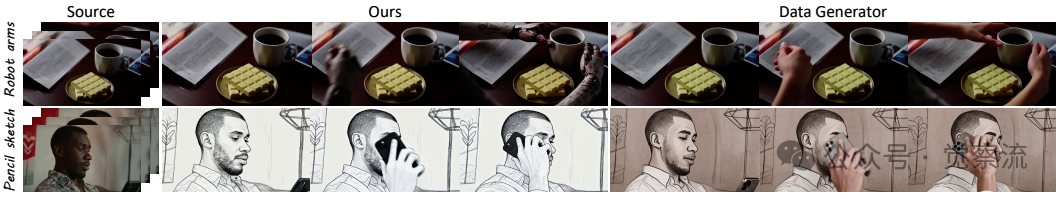

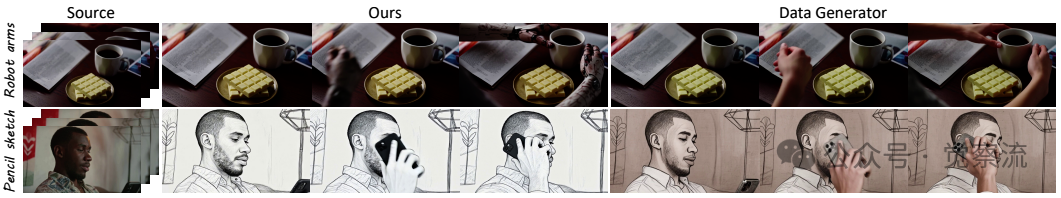

与原始数据生成器的比较

上图展示了与原始数据生成器的对比。与原始数据生成器不同,该模型在处理超出关键帧的新出现信息方面表现更佳。例如,在"Robot arms"和"Pencil sketch"编辑任务中,原始数据生成器无法正确处理新出现的机器人手臂和素描效果,而Ditto模型则能精确实现这些编辑。这种优势源于研究的规模化训练方案,包括课程学习和对过滤后高质量数据的接触。

从合成到真实的迁移能力

上图展示了研究的合成到真实(sim2real)能力。模型成功地将数据集中风格化的视频映射回其原始真实源视频。这种成功的迁移突显了数据集中包含的丰富和逼真的信息,证明了其在标准编辑任务之外的实用性。值得注意的是,这种能力表明Ditto-1M数据集不仅包含高质量的编辑样本,还保留了足够的真实世界信息,使模型能够进行有效的域适应。

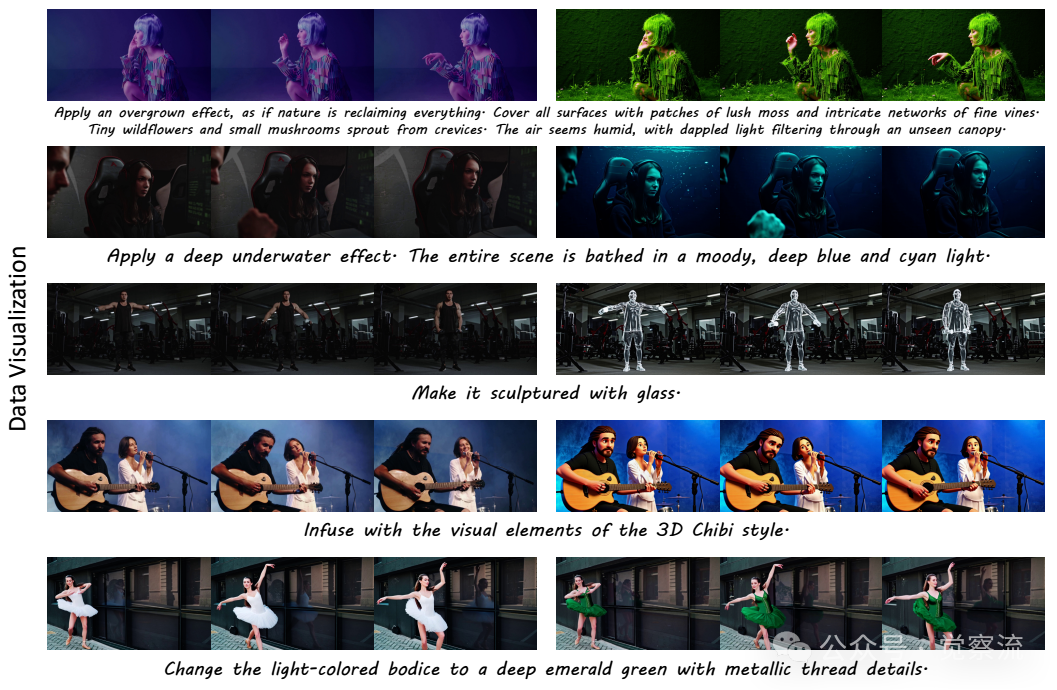

数据集与模型的额外定性结果

编辑指令的词云图

上两图进一步展示了数据集的多样性和编辑能力。词云图直观呈现了编辑指令的分布特点,包括"painting", "blurred edge", "detailed 3D", "Chibi style", "black outfit", "watercolor style"等高频指令词,反映了数据集覆盖了广泛的编辑类型。这些多样化的指令确保了模型在各种编辑场景下的鲁棒性。

总结:Ditto的范式意义与未来展望

Ditto框架代表了指令视频编辑领域的重大进步,通过系统性地解决数据稀缺这一核心挑战。该框架的新颖数据生成管道克服了先前方法中困扰的保真度-多样性与效率-连贯性权衡,通过利用强大的图像编辑先验、带有时间增强器的蒸馏in-context视频生成器以及自主的VLM质量控制。这使得能够创建大规模、高质量的Ditto-1M数据集。所提出的模态课程学习策略进一步确保了模型Editto通过有效过渡从视觉-文本条件到纯指令驱动推理,达到最先进的性能。

Ditto方法的局限性主要体现在三方面:(1) VLM过滤可能导致创意性强的编辑被误判为低质量;(2) 深度引导在极端遮挡场景可能效果受限;(3) 如下图所示,原始数据生成器在处理新出现内容(如机器人手臂)时存在局限,而Ditto通过规模化训练和课程学习有效克服了这一问题。这些局限性指明了未来研究的方向。

与原始数据生成器的比较

Ditto-1M数据集和Editto模型已在项目页面公开,为社区研究提供坚实基础,加速指令视频编辑技术发展。这一工作不仅为视频编辑领域提供了宝贵的资源,还为其他多模态生成任务提供了可借鉴的合成数据范式,推动视频编辑从"昂贵定制"向"即时可用"的转变。随着大规模高质量数据集的可用,指令视频编辑有望迎来与图像编辑技术相匹配的发展速度和成熟度,为内容创作开辟新的可能性。