导语:当AI开发进入“效率时代”,你还在重复造轮子吗?

在大模型落地的黄金时代,企业和开发者面临着“甜蜜的烦恼”:如何快速将LLM能力转化为可用的AI应用?从模型对接、工作流设计到RAG开发、Agent构建,每一步都可能陷入繁琐的技术细节。今天,我们发现了一个“一站式LLM应用开发平台”——Dify,它用开源+低代码的方式,让AI开发效率提升10倍以上。无论你是想搭建智能客服、知识问答系统,还是复杂的多模态AI助手,Dify都能帮你从“原型设计”直接跳到“生产部署”。这篇文章将带你深度拆解这个开发者圈最近热议的“神器”。

一、Dify核心能力解析:重新定义AI应用开发范式

1. 可视化工作流:像搭积木一样设计AI逻辑

传统AI开发需要写大量代码串联模型、工具和数据,而Dify的“画布工作流”让一切变得直观:

- 拖放式操作:通过可视化界面拖拽节点(如模型调用、工具集成、数据处理),轻松搭建复杂AI流程,支持实时调试和版本管理。

- 全功能集成:工作流中可无缝接入RAG管道、Agent工具、模型管理等模块,比如让用户输入先经过文档检索(RAG),再调用计算器工具(Agent),最后由LLM生成回答。

- 附演示视频:官方提供的optimized_workflow_intro.mp4展示了10分钟搭建智能客服的全过程,零基础开发者也能快速上手。

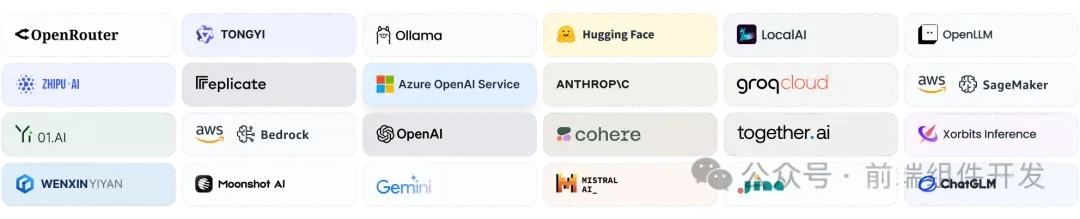

2. 模型生态“通吃”:告别模型兼容性噩梦

Dify支持数百种LLM模型,无论是OpenAI(GPT-4)、开源模型(Mistral、Llama 3),还是自托管解决方案,只需简单配置即可接入。更关键的是:

- 统一API接口:对OpenAI兼容模型提供无缝支持,切换模型无需修改代码,轻松实现“低成本模型优化”(比如从GPT-3.5切换到开源模型测试效果)。

- 推理提供商管理:支持AWS SageMaker、阿里云PAI等云端推理服务,以及本地部署的模型(如通过vLLM加速的Llama),灵活应对不同算力需求。

3. Prompt IDE:让提示工程成为“可视化游戏”

提示词设计是LLM应用的核心,但传统方式靠“手动试错”效率极低。Dify的Prompt IDE带来三大突破:

- 可视化编辑器:支持变量注入、条件分支(如根据用户问题复杂度切换提示策略),实时预览不同提示词的输出效果。

- 多模型对比:同时测试GPT-4和Llama 3在同一提示下的表现,用数据驱动提示优化。

- 功能扩展:一键添加文本转语音、格式校验等附加功能,快速构建多模态交互场景(如生成语音版客服回复)。

4. RAG开发“一键化”:从文档到智能的最短路径

处理企业自有数据是RAG落地的痛点,Dify提供全链路RAG工具链:

- 开箱即用的数据摄入:支持PDF、PPT、Markdown等20+格式,自动解析文档并构建向量库(集成FAISS、Milvus等主流向量数据库)。

- 智能检索优化:支持BM25、语义检索混合策略,自定义检索逻辑(如限定检索文档范围、设置相关性阈值),大幅提升答案准确率。

5. Agent开发“工具库自由”:50+内置工具秒级调用

Dify的Agent智能体支持基于函数调用(Function Call)或ReAct框架开发,更提供“工具超市”级体验:

- 预构建工具矩阵:包含谷歌搜索(实时信息获取)、DALL·E(图像生成)、WolframAlpha(数学计算)、Stable Diffusion(AI绘图)等50+常用工具,无需重复开发API对接。

- 自定义工具扩展:支持接入企业自有API(如内部数据库查询),打造行业专属Agent(如法律文书生成助手、金融数据分析师)。

6. LLMOps全链路观测:让AI应用“可监控、可迭代”

生产环境中,AI应用的稳定性和效果衰减是重大挑战。Dify的LLMOps模块提供:

- 日志监控:实时追踪模型调用耗时、错误率、用户对话历史,支持按维度(如用户ID、模型版本)筛选分析。

- 数据标注与迭代:基于生产数据标注“优质回答”,反向优化提示词和训练数据,形成“观测-优化-部署”闭环。

7. 后端即服务(BaaS):无缝嵌入业务系统

所有功能均可通过API调用,企业可将Dify作为核心AI引擎,轻松对接自有前端(APP/小程序)或业务系统(如OA、CRM)。例如:

- 电商平台用Dify的RAG能力构建“商品知识库客服”,通过API接收用户问题,返回定制化回答。

- 教育机构用Agent工具开发“作业答疑助手”,调用WolframAlpha解析数学题,通过API集成到学习平台。

二、不同场景下的“Dify打开方式”

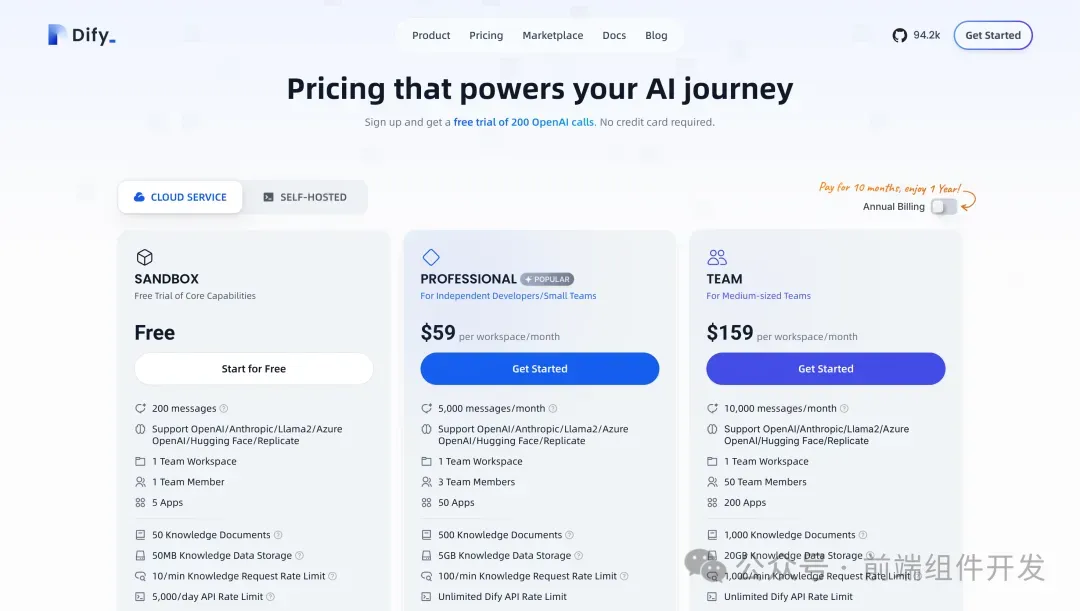

1. 个人开发者/初创团队:零成本快速验证想法

- Dify云服务:无需部署,注册即享200次免费GPT-4调用,30分钟内搭建第一个AI聊天机器人(如小红书文案生成器)。

- 社区版自托管:下载Docker镜像,4步完成本地部署(cd docker && cp .env.example .env && docker compose up -d),适合需要数据本地化的场景(如医疗、金融领域原型开发)。

2. 企业级用户:从规模化到私有化的全场景覆盖

- 企业版定制:支持单点登录(SSO)、权限管理、集群部署,满足合规要求(如数据加密、审计日志)。

- AWS/Azure一键部署:通过Marketplace快速上架到企业私有云,支持自定义域名、品牌LOGO,打造专属AI应用(如车企智能售后助手、银行智能客服)。

3. 技术极客:开源生态激发无限可能

Dify开源社区活跃,提供Helm Chart(K8s部署)、Terraform脚本(多云适配)、CDK模板(AWS深度集成),支持二次开发。例如:

- 开发者@LeoQuote贡献了K8s部署Helm Chart,让Dify在集群环境中稳定运行;

- 团队用Terraform实现“Dify+自建向量库”的自动化部署,大幅降低运维成本。

三、实战案例:3小时落地一个“企业知识问答系统”

假设某科技公司需要搭建内部文档问答机器人,步骤如下:

- 数据接入:上传500+PDF技术文档,Dify自动解析并生成向量索引(耗时30分钟);

- 工作流设计:画布中拖入“用户输入→RAG检索→LLM生成回答”节点,配置检索参数(如限定近1年文档);

- 工具增强:添加“关键词高亮”工具,让回答中的技术术语自动标注链接到内部Wiki;

- 部署上线:通过API对接企业微信,员工在对话框中输入问题,秒级获取文档相关答案。整个过程无需编写复杂代码,成本比传统方案降低70%。

四、如何开始使用Dify?超详细安装指南

1. 最低配置要求(适合本地开发):

- CPU:2核+

- 内存:4GB+

- 系统:Linux/macOS/Windows(推荐Docker环境)

2. 快速启动(5分钟搞定):

复制# 克隆仓库 git clone https://github.com/dify-ai/dify.git cd dify/docker # 复制配置文件 cp .env.example .env # 启动Docker容器 docker compose up -d # 浏览器访问初始化界面 http://localhost/install

3. 进阶部署:

- K8s环境:使用社区提供的Helm Chart或YAML文件,适合生产环境集群部署;

- 多云适配:通过Terraform/CDK一键部署到AWS、Azure、Google Cloud,支持VPC私有网络接入。

结语:当AI开发进入“平民化”时代

Dify的出现,标志着LLM应用开发从“技术壁垒”走向“效率革命”。无论是个人开发者的创意落地,还是企业级AI系统的规模化部署,它都提供了“开箱即用”的解决方案。更重要的是,开源生态让技术创新不再被大厂垄断——每个人都能成为AI应用的创造者。

现在就尝试Dify:

- 体验云服务:Dify Cloud官网(https://dify.ai/ 免费额度即开即用):

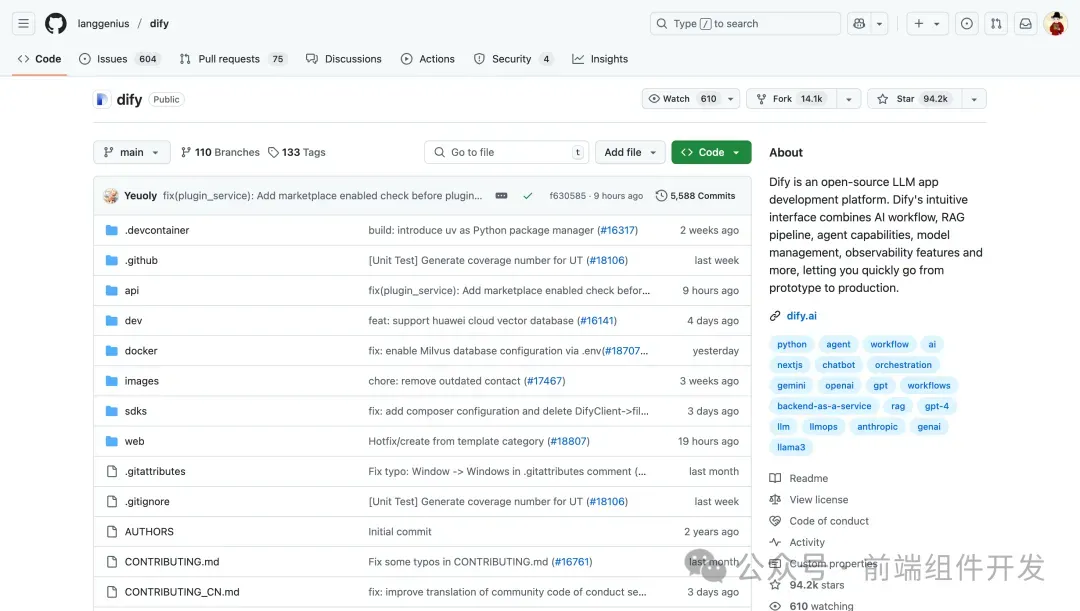

- 下载社区版:GitHub仓库(star数破万,开发者活跃)

- 企业合作:发送邮件至[email protected]获取定制方案

AI应用开发的“低门槛时代”已经到来,你准备好抓住下一个风口了吗?

项目地址:

复制https://github.com/langgenius/dify