由华中科技大学与小米汽车提出了业内首个无需 OCC 引导的多模态的图像 - 点云联合生成框架 Genesis。该算法只需基于场景描述和布局(包括车道线和 3D 框),就可以生成逼真的图像和点云视频。

论文题目:Genesis: Multimodal Driving Scene Generation with Spatio-Temporal and Cross-Modal Consistency

论文链接:https://arxiv.org/abs/2506.07497

Github 链接:xiaomi-research/genesis

Genesis 采用两阶段架构:第一阶段基于透视图投影的布局和场景描述等条件,利用基于 DiT 的扩散模型学习 3D 变分自编码器编码的环视图特征; 第二阶段将第一阶段多视角视频序列转到鸟瞰图的特征空间,并结合场景描述和布局等条件,学习 2D 自编码器编码的点云特征。

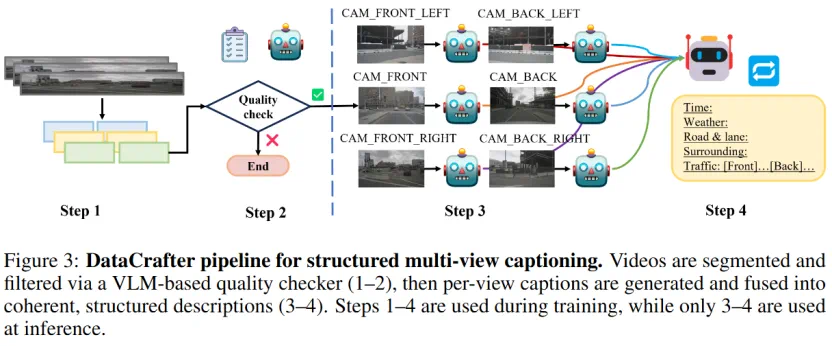

为了以结构化语义引导生成过程,本文引入了 DataCrafter (一个基于 VLM 的数据标注模块),可提供场景级与实例级的信息描述。在 nuScenes 基准数据集上的大量实验表明,Genesis 在视频与激光雷达指标上均达到了当前 SOTA 水平。

本文的主要贡献总结如下:

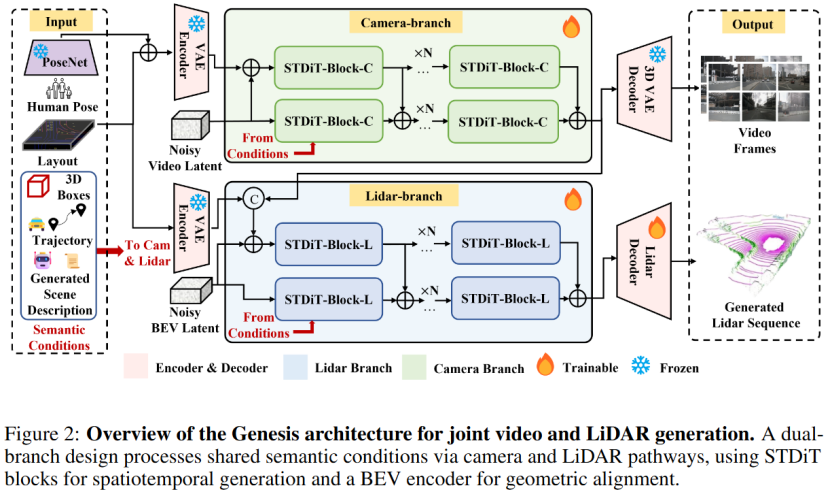

统一的多模态生成架构。Genesis 采用统一的 pipeline,视频和 LiDAR 分支都在共享相同的条件输入,包括场景描述和布局等,这确保了生成的多模态数据的一致性。为进一步保证点云和图像背景的信息一致性,我们将 RGB 透视图转到鸟瞰图视角下的特征下,并把该特征作为条件输入到基于点云扩散模型中,从而加强两种模态的一致性,该过程无需依赖 occupancy 或体素等中间体。

通过 DataCrafter 进行结构化语义信息提取。为了提高语义可控性,本文引入了 DataCrafter,这是一个基于视觉语言模型构建的 caption 数据处理模块。它提取多视图、场景级和实例级描述,这些描述融合到密集的语言引导式先验中。这些 caption 数据为视频和 LiDAR 生成器提供了详细的语义指导,从而产生不仅逼真而且可解释和可控的输出。

引言

在自动驾驶技术向高阶迈进的进程中,构建多样化、高拟真度的驾驶场景数据集,已成为不可或缺的关键环节。合成数据因为其可编辑,易泛化的特点得到了广泛的关注。现有研究虽在视频生成、LiDAR 序列合成领域取得显著进展,但如何实现视觉与几何模态间的深度协同与一致性表达,仍属亟待攻克的前沿课题。

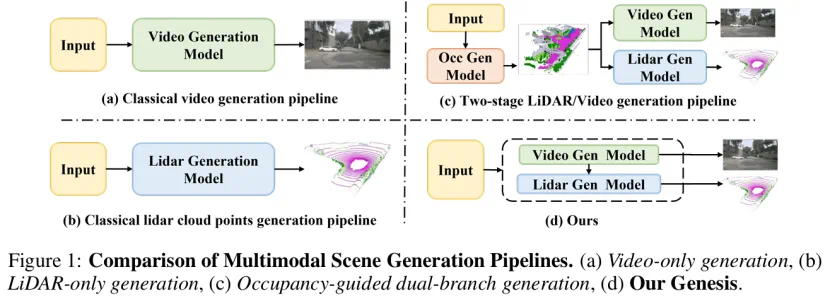

如图 1,当前主流的驾驶场景生成方案,多聚焦于 RGB 视频或 LiDAR 点云的单模态数据生成。这些方法虽极大推动了场景生成技术的发展,却未能充分挖掘多模态融合的协同优势。在处理 RGB 视频与其他传感器数据时,模态间的对齐精度不足,导致生成结果难以满足实际应用需求。许多方法采用基于 BEV 地图或 3D 框的 “布局 - 数据” 单步生成模式,这种依赖粗略空间先验的架构,在捕捉复杂交通动态与精细语义细节时存在天然缺陷。

尽管 UniScene 等研究尝试引入占用网格实现多模态生成,但实际自动驾驶场景中 OCC 标签的获取是非常昂贵的,这严重限制了生成模型在工业界的应用。另外,现有多模态生成方案多依赖粗略标签或通用标题模型提供语义标签,未能有效利用现代视觉语言模型(VLM)的细粒度语义解析能力。这种语义标签的缺失,直接影响生成场景的真实性、可控性,以及时空逻辑的连贯性。

具体工作

DataCrafter 模块

本文提出 DataCrafter, 一个专为多视角自动驾驶视频设计的 Caption 数据生成模块,旨在实现以下两项核心功能:

(1) 训练阶段数据筛选:借助预训练视觉语言模型的图像理解能力,对原始训练片段进行评估,仅筛选高质量片段用于训练。(2) 结构化语义提取:利用视觉语言模型对多视角视频片段提取细粒度语义信息,为多模态生成任务提供丰富的结构化语义条件。

具体流程如下:首先,将多视角输入视频 分割为片段

分割为片段 ,每个片段都由基于视觉语言模型的模块进行评分:

,每个片段都由基于视觉语言模型的模块进行评分:

其中 项表示由视觉语言模型得出的子分数,

项表示由视觉语言模型得出的子分数, 为固定权重。

为固定权重。

评分体系涵盖三类关键视觉属性:(1) 图像清晰度:如模糊、畸变、脏污等;(2) 结构合理性:如遮挡程度、结构混乱、场景完整性等;(3) 美学特性:如逆光、过暗过亮、曝光异常、色彩偏差等。

仅得分高于设定阈值的片段会被保留用于训练,并进一步进行语义标注。相较于现有方法仅使用单视角图像进行标注或将多视角图像拼接后统一标注的策略,前者容易造成信息缺失,后者则常出现语义冗余、视角冲突以及跨视角信息不一致等问题,本文为确保多视图间的一致性,多视角场景描述 经预训练 VLM 的语言编码器

经预训练 VLM 的语言编码器 和冗余消除函数

和冗余消除函数 处理,去除冗余并生成统一语义表示。最终,每个片段生成层次化场景描述。

处理,去除冗余并生成统一语义表示。最终,每个片段生成层次化场景描述。

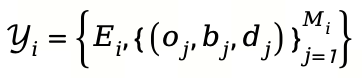

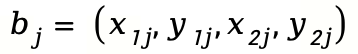

其中 编码全局场景语境 (如天气、道路类型、时间), 每个物体实例由类别

编码全局场景语境 (如天气、道路类型、时间), 每个物体实例由类别 、边界框

、边界框 和有根据的描述

和有根据的描述 构成。通过该模块的结构设计,模块能够生成具备跨视角一致性的语义表征,从而为视频与 LiDAR 模态的联合生成提供细粒度的语义引导。

构成。通过该模块的结构设计,模块能够生成具备跨视角一致性的语义表征,从而为视频与 LiDAR 模态的联合生成提供细粒度的语义引导。

视频生成模型

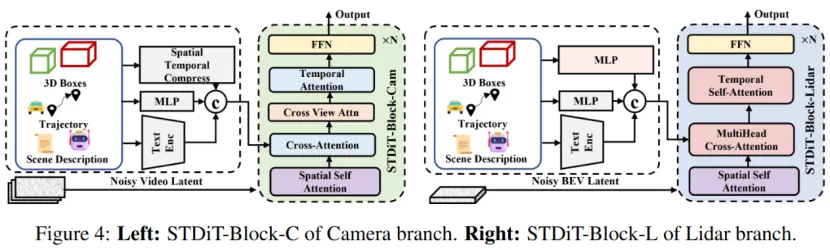

如图 2 中 camera_branch,Genesis 的视频生成模块以 DiT 为骨干,引入 3D-VAE 编码与结构化语义先验,构建出具备时空一致性的生成架构。Camera 分支将场景布局信息与语言描述通过注意力机制深度耦合,使生成的视频不仅具备视觉真实感,更能遵循语义逻辑。

我们发现,目前自动驾驶场景视频生成的疼点在于行人难以清晰地生成,为此,我们创新性地利用 YOLOv8x-Pose 检测行人姿态并投影到各视角,以此增强动态场景的语义表达。

具体实现上,我们首先构建包含车道段和 3D 边界框的结构化场景布局,将其投影到各视角 2D 图像平面形成语义控制图,再通过 Control-DiT 模块的交叉注意力机制在每个去噪时间步融入这些结构化先验,实现对生成过程的引导。

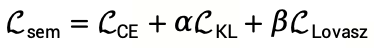

在隐空间编码方面,借助 3D VAE 将多帧 BEV 图压缩为隐空间表示,解码器从去噪词元中重建 BEV 语义。训练目标函数为:

通过交叉熵损失、KL 散度和 Lovasz 损失的联合优化,确保语义信息的准确捕捉。此外,通过 DataCrafter 模块生成的场景描述经 T5 编码器处理为文本嵌入 ,与 BEV 图编码后的特征

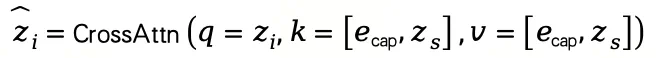

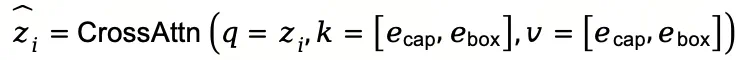

,与 BEV 图编码后的特征 共同作为条件输入 DiT 块,通过交叉注意力实现高阶语义对生成的调制:

共同作为条件输入 DiT 块,通过交叉注意力实现高阶语义对生成的调制:

最后,模块集成的语义对齐控制 Transformer 通过控制注意力将语义特征注入扩散块早期阶段,并结合空间自注意力、跨视角注意力和时间注意力机制,全面保障多视角视频生成的时空连贯性与语义保真度。

激光雷达生成模型

如图 2 中 lidar_branch,激光雷达生成模块致力于生成几何精确且时空连贯的点云序列,通过点云自动编码器与时空扩散模块的协同设计,结合跨模态语义条件实现多传感器数据的一致性生成。

如图 4,首先,点云自动编码器将稀疏点云体素化为 BEV 网格,利用 Swin Transformer 骨干网络压缩为隐空间特征,再通过 Swin 解码器与 NeRF 渲染模块重建点云,过程中采用空间跳跃算法减少空网格误差,并通过深度 L1 损失、占用损失和表面正则化损失优化训练,同时引入后处理过滤噪声点。

时空扩散模块以自动编码器的隐空间特征为基础,采用双 DiT 网络结合 ControlNet 架构,集成场景描述、道路图等语义条件,以及 3D 边界框几何条件;为保证跨模态一致,通过 LSS 算法将视频分支的 RGB 图像转为 BEV 特征,与道路图特征拼接后输入 ControlNet。扩散过程中,隐空间词元通过交叉注意力融合语义与几何嵌入,交叉注意力操作的公式为:

其中,嵌入值 和

和 分别来自道路草图和三维边界框。为确保时间一致性,STDiT-Block-L 采用了多头自注意操作。给定输入

分别来自道路草图和三维边界框。为确保时间一致性,STDiT-Block-L 采用了多头自注意操作。给定输入 ,标记更新为

,标记更新为 。

。

实验结果

视频生成结果

nuScenes数据集上的联合生成

私有数据集上的联合生成

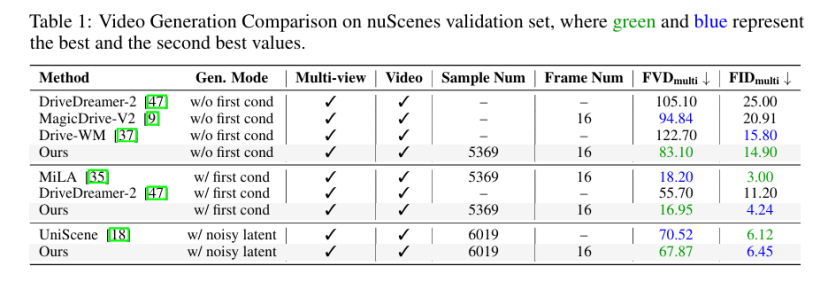

在无首帧条件设定下,本文的方法实现了 83.10 的多帧 FVD 和 14.90 的多帧 FID,优于 DriveDreamer-2 等先前的工作。在有首帧条件设定下,本文的方法进一步提升至 16.95 的 FVD 和 4.24 的 FID,与 MiLA 相比展现出具有竞争力的结果,同时保持了时间一致性和结构保真度。在有噪声隐空间设定下,在 6019 个样本上实现了 67.87 的 FVD 和 6.45 的 FID,超过了 UniScene 报告的先前最佳结果。

LiDAR 生成结果

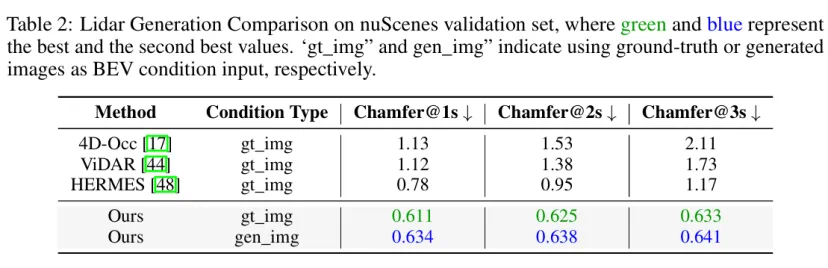

表 2 展现了先前最先进的方法与本文提出的 Genesis 框架在激光雷达序列生成性能方面的定量比较。评估标准遵循 HERMES 的设定进行,在水平面 [−51.2, 51.2] 米以及高度 [−3, 5] 米的空间范围内,使用 Chamfer distance 作为主要指标。在短期和长期预测方面,Genesis 始终优于现有方法。在预测时长为 1 秒时,它的 Chamfer distance 达到 0.611,比之前的最佳值(HERMES 的 0.78)高出 21%。在预测时长为 3 秒时,优势扩大到相对减少 45%(从 1.17 降至 0.633)。

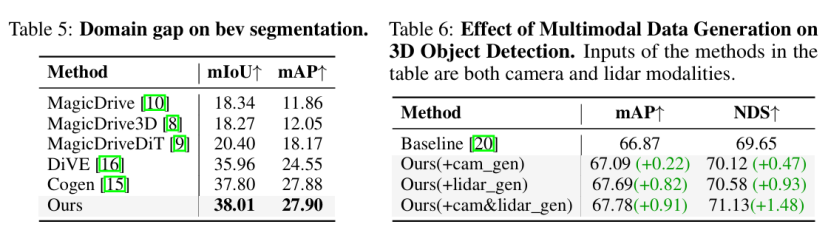

下游任务实验

本文的方法在多个下游感知任务上评估了生成数据的效用。如表 5 所示,本文的方法在 BEVFormer 3D 目标检测中取得了最佳的平均交并比(38.01)和平均精度均值(27.90)。如表 6 所示,本文评估了生成数据在 BEVFusion 3D 目标检测框架上的有效性。在所有设置中,本文的方法都取得了一致的改进,mAP 从 66.87 提高到 67.78,NDS 从 69.65 提高到 71.13。摄像头和激光雷达模态的联合生成实现了的最高增益(+0.91 mAP / +1.48 NDS),证明了多模态生成的互补优势。