多模态检索是信息理解与获取的关键技术,但其中的跨模态干扰问题一直是一大难题。

可行的解决办法是构建一种统一的多模态表示方式,为此,来自快手与东北大学的研究人员推出了多模态统一嵌入框架——UNITE。

UNITE的核心目标,就是构建一个能同时处理文本、图像、视频及其融合模态输入的统一嵌入器。

它从数据策划与训练机制两个关键视角出发,用对比学习的机制重新定义了统一多模态表示学习的范式。

在细粒度检索、指令检索等多个评测中,UNITE框架都斩获了最佳成绩。

模态感知对比学习,缓解跨模态干扰

在多模态检索任务中,不同模态(文本、图像、视频)天然存在分布差异。

如果在训练时将所有模态混合进行对比学习,会导致表示空间产生语义扭曲或干扰噪声,影响模型对各模态语义的准确建模。

为了解决这一挑战,UNITE团队提出了Modal-Aware Masked Contrastive Learning(MAMCL)这一对比学习机制,能显著缓解跨模态“相互干扰”。

在传统InfoNCE损失下,模型会尝试最大化正样本对之间的相似度,并最小化其与负样本之间的相似度:

但这种方式不能区分模态组合,例如,一个query的正样本为文本模态,但其负样本可能是图像、视频或者其他模态组合。这可能导致模型用图像来学文本相似度,产生模态冲突。

MAMCL的核心思想是模态掩码约束,也就是只在与当前query目标模态一致的负样本中进行对比,从而避免模态间的错误竞争。

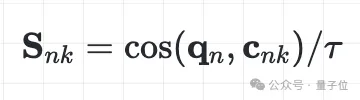

给定一个批次中个query,每个query()对应一个正样本和个负样本,构造相似度矩阵:

其中是第个候选样本,是温度系数。

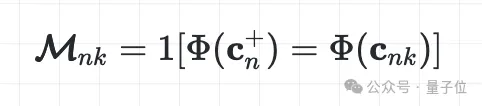

接下来引入模态掩码矩阵,用于标记候选样本与正样本模态是否一致:

其中表示提取候选样本的模态标签(例如 text, image, video, text+video)。

然后,构造模态感知掩码相似度矩阵:

这一步确保在计算损失时,仅考虑模态一致的样本。

最终,MAMCL损失定义为(p是当前query对应的正样本索引):

为了平衡泛化能力与判别能力,UNITE采用了“检索适应 + 指令微调”的两阶段训练方案:

- 检索适应阶段,使用text-text、text-image、text-video等多模态数据训练模型的基本检索能力,同时引入高粒度视频-文本数据,显著提升模型的细粒度区分能力;

- 指令微调阶段,基于MMEB、CoVR等复杂多模态指令任务训练,增强模型的指令遵循能力和扩展性。

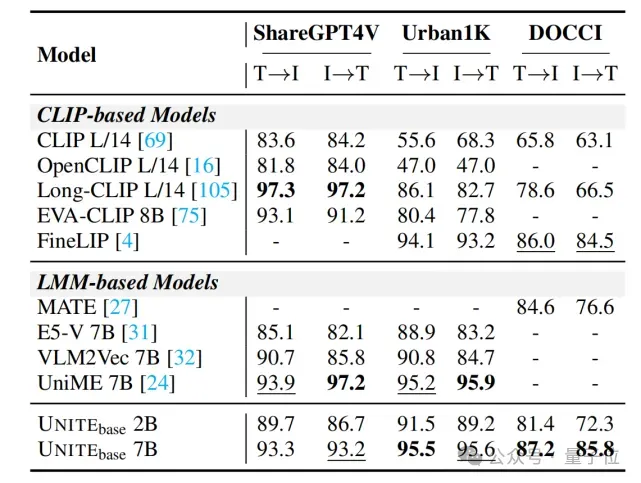

多个评测中斩获最佳成绩

在细粒度检索、指令检索等多个评测中,UNITE框架都斩获了最佳成绩。

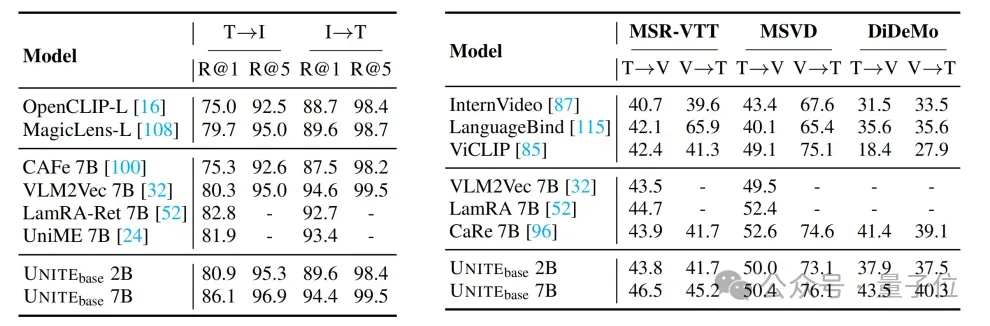

图像-文本检索任务中,在ShareGPT4V、Urban1K和DOCCI上,UNITE显著超越E5-V和VLM2Vec等模型;

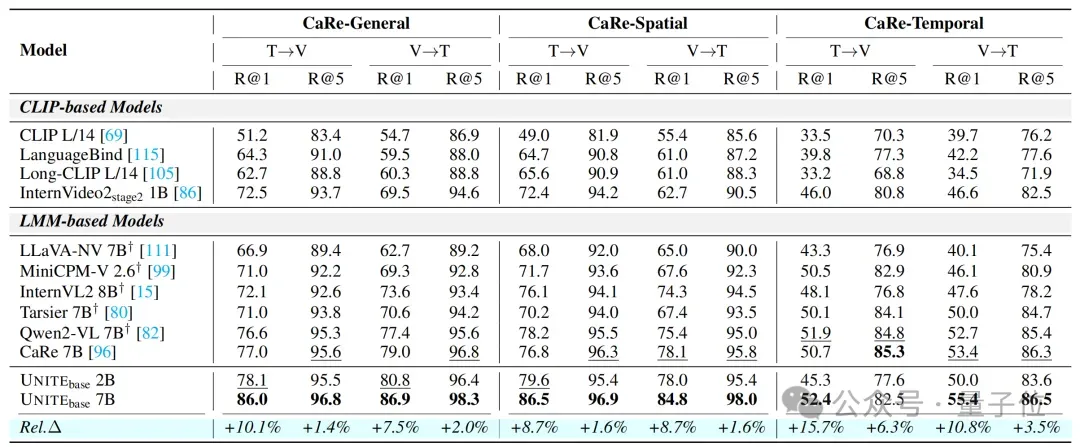

视频-文本检索方面,UNITE的2B模型在CaReBench三个子任务(General/Spatial/Temporal)中的General和Spatial里超越了前SOTA,7B模型以显著领先水平刷新当前最好表现。

UNITE 7B在CaReBench上分别达到86.0,86.9,86.5,84.8,52.4,55.4。

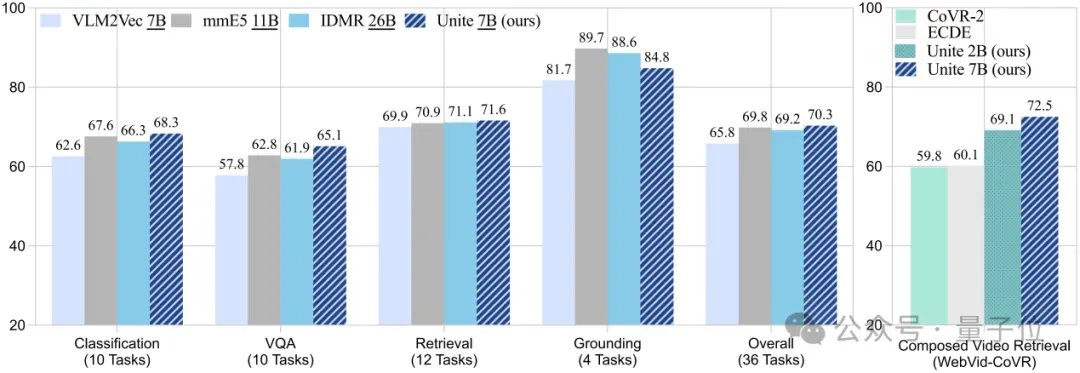

指令检索任务里,作者的UNITE系列模型也在多个数据集上表现出色。

具体来说,在涵盖分类、VQA、检索、定位四类任务共36个数据集的MMEB Benchmark中,UNITE 7B达到了最优性能70.3,超越了更大规模的模型mmE5 11B (69.8) 和IDMR 26B (69.2)。

在合成视频检索任务CoVR上,UNITE 2B和UNITE 7B达到了69.1和72.5,均明显领先于现有SOTA模型(60.1)。

为验证其通用性,团队还在多个标准跨模态检索任务上进行了评估。在Flickr30K、MSR-VTT、MSVD、DiDeMo任务上,展现了良好的通用表征能力。

综合来看,UNITE支持文本、图像、视频及融合模态内容,并展现了综合最优性能。

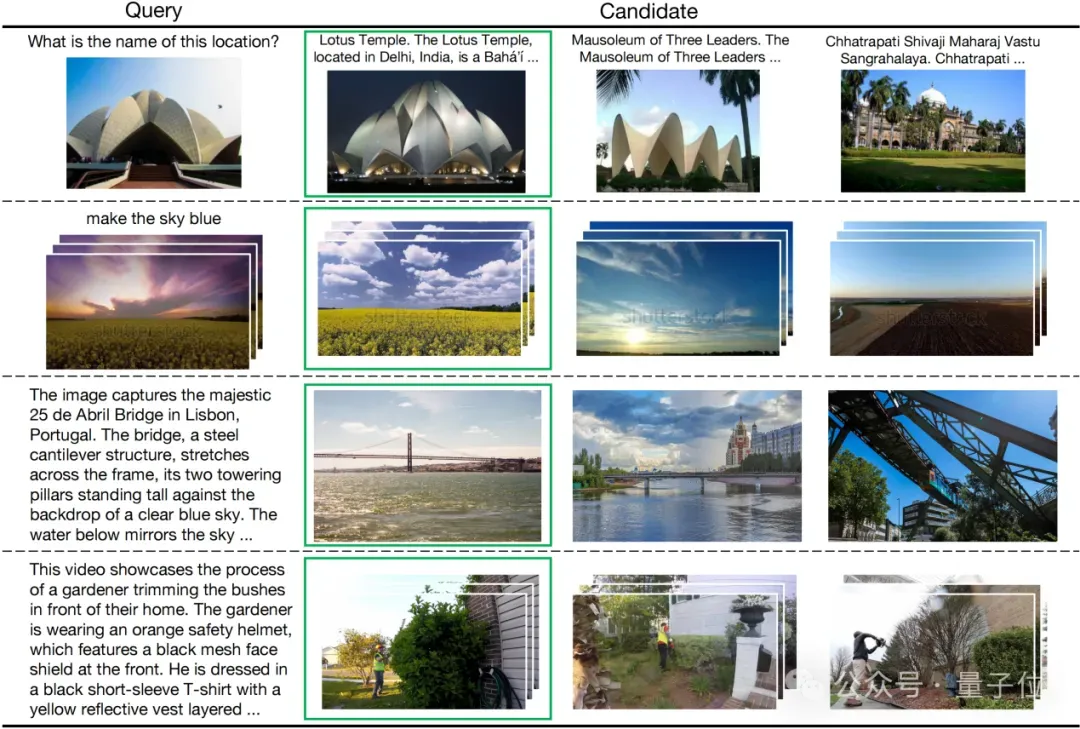

其可视化结果如下:

另外在实验过程当中,作者还有三个关键发现。

一是视频-文本数据具备“统一模态”的核心能力。

具体来说,视频-文本对数据在所有配置中表现最为突出,不仅在视频检索任务中遥遥领先(如MSR-VTT、MSVD),甚至在图文检索任务中也超越了基于图像-文本对训练的模型。

二是指令类任务更依赖文本主导的数据支撑——

尽管视频-文本对数据在一般检索任务中表现出色,但在复杂检索指令跟随类任务(如MMEB、CoVR)中,其优势反而不明显。

这类任务需要模型理解长文本、复杂逻辑或多阶段指令,研究认为,Text–Text数据提升了语言理解与逻辑构建能力,而Text–Image数据提供精准的视觉语义映射,利于模态对齐。

最后,细粒度Text-Video样本的添加策略影响巨大,直接在第一阶段“检索适应”中融合细粒度视频-文本样本,能带来整体性能最优解,相比传统“先对齐后微调”的做法更加有效且高效。

更多方法和实验细节,请参照论文。

论文链接:https://arxiv.org/pdf/2505.19650代码链接:https://github.com/friedrichor/UNITE项目链接:https://friedrichor.github.io/projects/UNITE模型/数据链接:https://huggingface.co/collections/friedrichor/unite-682da30c4540abccd3da3a6b