大家好,我是肆〇柒。今天要和大家分享的这项研究来自佐治亚理工学院(Georgia Institute of Technology)的工作,AutoBnB-RAG非常巧妙,为解决大型语言模型在网络安全决策中的“知识断片”问题,提供了一个既符合人类专家直觉又极具工程智慧的方案——让AI团队在“卡壳”时才去“查资料”。这个研究为我们在多智能体中应用 agentic RAG 带来一些启发。

想象一个安全事件,凌晨3点,你的SIEM系统突然报警,显示有异常数据外传。作为SOC负责人,你只有30分钟决定是否启动全面应急响应。你召集团队分析日志,但关键问题出现了:攻击手法前所未见,团队对这种新型威胁缺乏认知,而时间正在飞速流逝。在信息不完整的情况下,是继续观察还是立即行动?误判可能导致业务中断,而犹豫则可能让攻击者完成数据窃取。这不仅是想象中的场景,而是每天在安全运营中心(SOC)真实上演的决策困境。

在网络安全领域,时间就是生命线。当高级持续性威胁(APT)悄然渗透企业网络,安全团队必须在信息不完整的情况下快速决策、协同响应。大型语言模型(LLM)的出现为自动化安全响应带来了新希望,但这些模型在面对专业领域的"知识断片"时,往往陷入"幻觉"陷阱。AutoBnB-RAG的出现,为这一难题提供了创新解决方案——通过检索增强生成(Retrieval-Augmented Generation, RAG)技术,让LLM智能体在决策过程中能够"查阅资料",显著提升安全响应的准确性和可靠性。这项研究不仅验证了RAG在多智能体安全协作中的关键价值,更为构建可信赖的AI安全智能体系统指明了方向。

当LLM安全团队"知识断片"时,如何避免误判?

想象一个由LLM驱动的"虚拟SOC"(Security Operations Center)正在应对一次新型供应链攻击。尽管团队成员能流畅沟通、制定计划,却因缺乏对近期真实事件的认知,而将关键线索误判为常规扫描。这并非假设——LLM的"知识截止"与"幻觉"是其在高风险安全决策中落地的最大障碍。

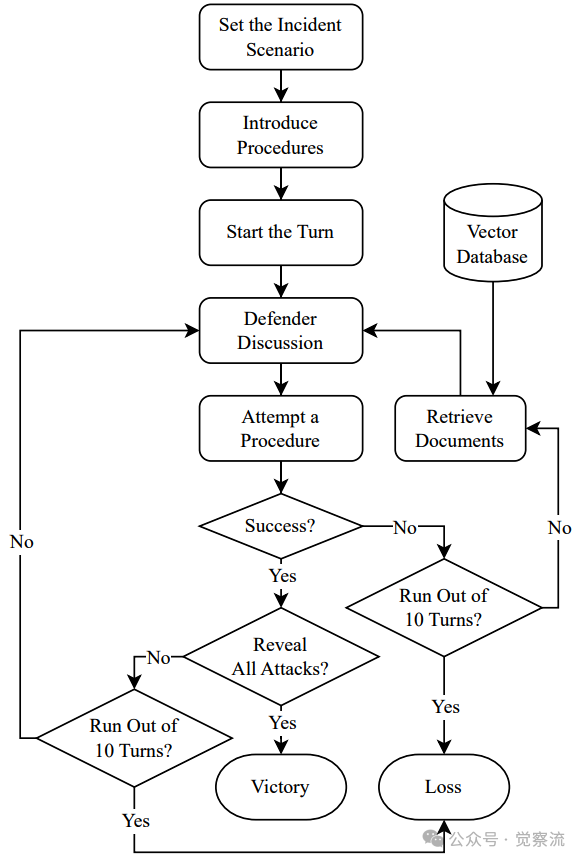

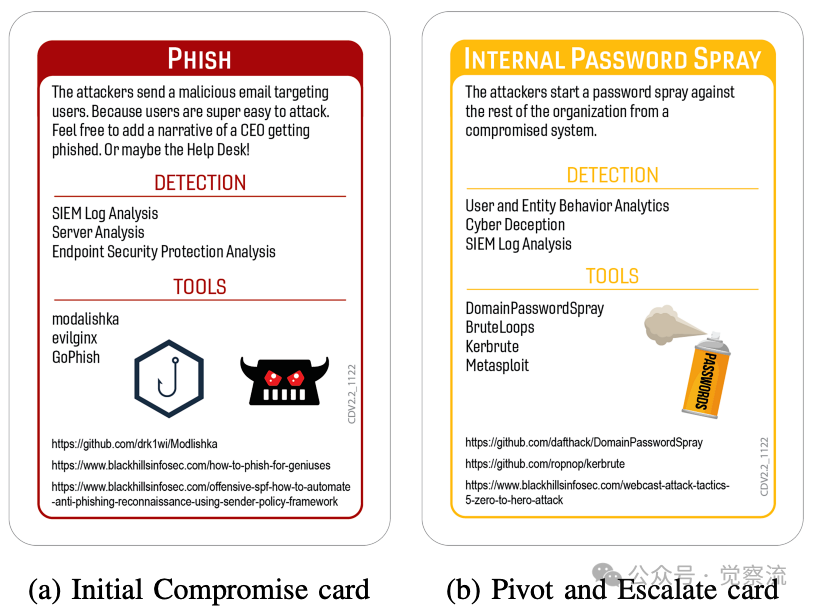

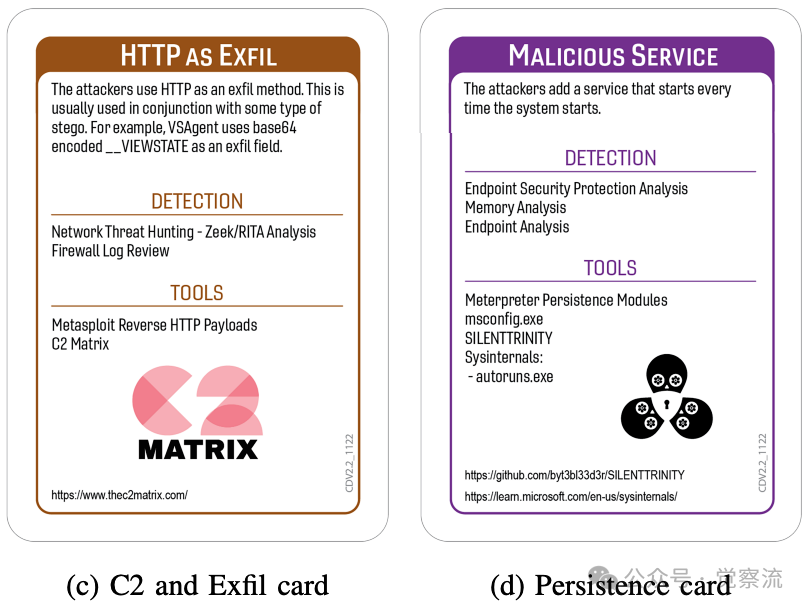

Backdoors & Breaches(B&B)是一款结构化网络安全桌面游戏,旨在模拟真实事件响应(Incident Response, IR)场景。这款游戏围绕一个结构化挑战展开:防御团队必须揭开四个隐藏的攻击阶段——初始入侵(Initial Compromise)、横向移动(Pivot and Escalate)、命令与控制(C2)与外传(C2 and Exfiltration),以及持久化(Persistence)。游戏包含超过50张独特卡牌,分为13张初始入侵卡、12张横向移动卡、7张C2与外传卡和14张持久化卡,以及12张代表常见检测或调查技术的程序卡(Procedure Cards)。每个回合,防御团队选择一个程序卡并投掷20面骰子决定是否成功(11+为成功),已建立程序(Established Procedures)可获得+3修饰符。团队需在10回合内揭示全部四个攻击阶段才能获胜。

AutoBnB框架首次实现了LLM多智能体在B&B环境中的结构化协作,使智能体能够通过结构化对话协作,模拟安全团队在各种组织结构下揭开攻击序列的过程。这一开创性工作展示了LLM在多智能体协作任务中的潜力,为研究网络安全决策提供了可控实验平台。

然而,研究者很快发现核心瓶颈:大语言模型可能存在“幻觉”现象,或在事实知识上出现缺口,尤其当面对特定领域或不断演变的威胁时。在无外部知识支持下,智能体可能基于过时或错误认知做出响应,导致漏检或误判。例如,当面对新兴的攻击技术时,LLM可能因训练数据截止而无法准确识别威胁模式,或在推理过程中产生"幻觉",编造不存在的检测方法。

这对你意味着什么? 作为安全分析师,你可能已经体验过类似困境:面对未知威胁时的"知识盲区"。当SolarWinds式供应链攻击首次出现时,许多团队因缺乏相关知识而误判,导致关键响应窗口期的丧失。AutoBnB-RAG正是针对这一痛点设计的——它不是简单地给LLM加个搜索引擎,而是将知识检索深度融入决策流程,就像给安全团队配备了"关键时刻的智囊团"。

AutoBnB-RAG被研究者提出,它通过集成检索增强生成(RAG),为LLM团队提供"实时知识接入"。这不仅是功能扩展,更是向"可信赖AI安全智能体"迈出的关键一步:让智能体在"思考"时,也能"查阅资料"。AutoBnB-RAG的核心价值在于,它将RAG机制深度嵌入多智能体协作框架,在保持自主决策能力的同时,显著提升决策的事实准确性与适应性。

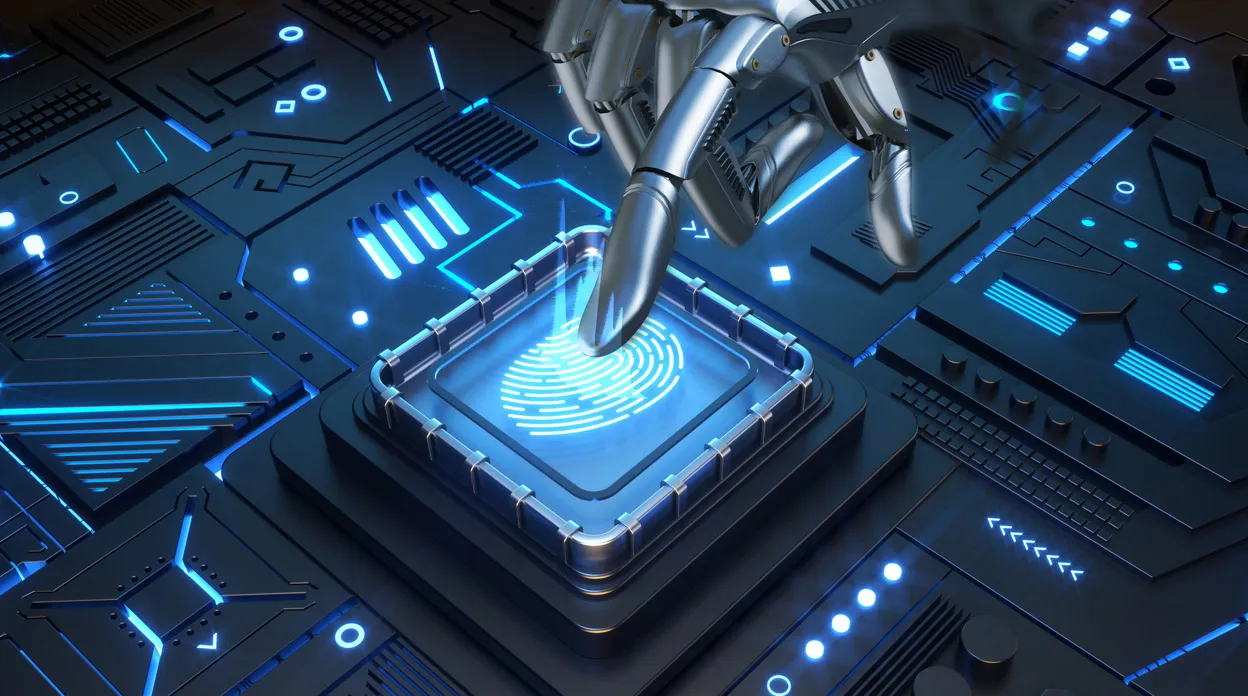

TeamStructures

上图,AutoBnB-RAG评估的八种团队结构,涵盖从集中式到辩论型的不同组织模型。关键看点:每种结构都模拟了真实SOC中的不同组织模式,为研究不同团队配置下的决策效果提供了实验基础。

方法论:RAG如何被"精准嵌入"多智能体工作流?

AutoBnB-RAG的精妙之处在于其对RAG机制的"精准嵌入"——不是简单地增加检索功能,而是将其设计为多智能体协作流程的有机组成部分,模拟真实安全团队的工作方式。这不仅仅是技术实现,更是对人类专家决策过程的深刻理解。

核心机制:后尝试检索(Post-Attempt Retrieval)——为什么"失败后才求助"更聪明?

想象你是一位经验丰富的安全分析师,面对一个复杂的入侵事件。你会在每一步都查阅文档吗?当然不会——那会大大降低调查效率。你只会在卡壳时才会寻求外部帮助。AutoBnB-RAG的"后尝试检索"机制正是模拟了这种专业行为模式。

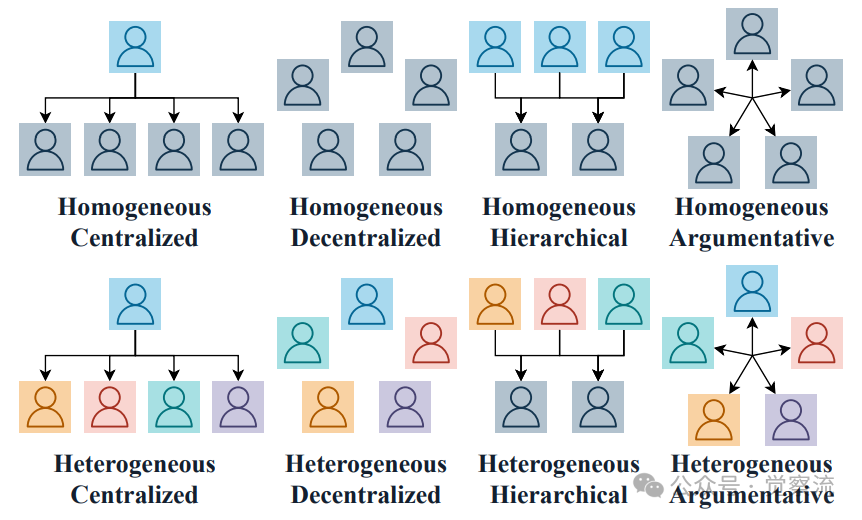

GameplayFlow

上图:AutoBnB-RAG的游戏流程,关键在于"失败 → 查询 → 获取 → 协商 → 再行动"的迭代循环。关键看点:检索仅在程序执行失败后触发,模拟了真实SOC中"调查陷入僵局时查阅文档"的专业行为。

整个流程形成"失败 → 查询 → 获取 → 协商 → 再行动"的迭代循环:

1. 防御智能体选择并执行一个检测程序(Procedure)

2. 系统通过20面骰子判定执行是否成功(11+为成功)

3. 仅当执行失败时,事件负责人(Incident Captain)触发检索查询

4. 检索结果返回并融入团队讨论

5. 团队基于新信息制定下一步行动

为什么这一设计如此精妙? 通过仅在程序执行失败后触发检索(而非随时可用),AutoBnB-RAG实现了三重平衡:

- 效率与准确性的平衡:避免了信息过载,确保检索只在关键时刻提供必要支持

- 自主性与知识性的平衡:保留了LLM的自主推理能力,同时在需要时提供"知识急救"

- 模拟真实性:完美复现了真实SOC中"调查受阻时才查阅资料"的专业行为

这种设计不是技术上的妥协,而是对人类专家决策过程的深刻理解——真正的专业能力不在于拥有所有知识,而在于知道何时以及如何获取所需知识。

支撑性架构设计

非参与式检索智能体(Non-Participatory Retrieval Agent):该设计是系统稳定性的关键。AutoBnB-RAG引入了一个专用检索智能体,它仅负责接收查询、返回结果,不参与任何讨论或决策。这一设计至关重要,确保了外部知识以"纯净信息"的形式注入,避免了检索结果本身成为新的"幻觉源"或引导偏见。检索智能体被纳入通信图,由群聊管理器确保适当的发言转换,实现了无缝集成。在技术实现上,该系统使用Chroma作为向量数据库后端,通过LangChain提供的递归字符分割策略将文档分割为5,000字符的重叠块,保留500字符的重叠部分。

关键价值:这一设计解决了RAG系统中的一个常见问题——检索结果的"二次幻觉"。当检索智能体参与讨论时,它可能会基于检索到的信息产生新的幻觉,而AutoBnB-RAG的非参与式设计确保了知识传递的纯净性,这对高风险安全决策至关重要。

双知识源:事实锚定 vs. 情境启发:AutoBnB-RAG定义了两种互补的检索设置,满足不同决策需求:

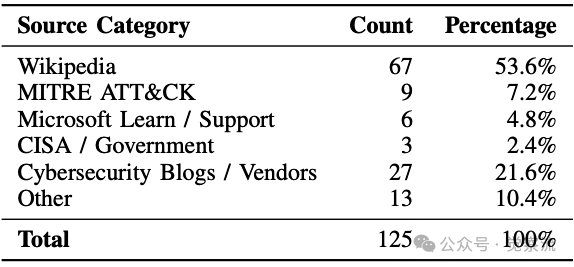

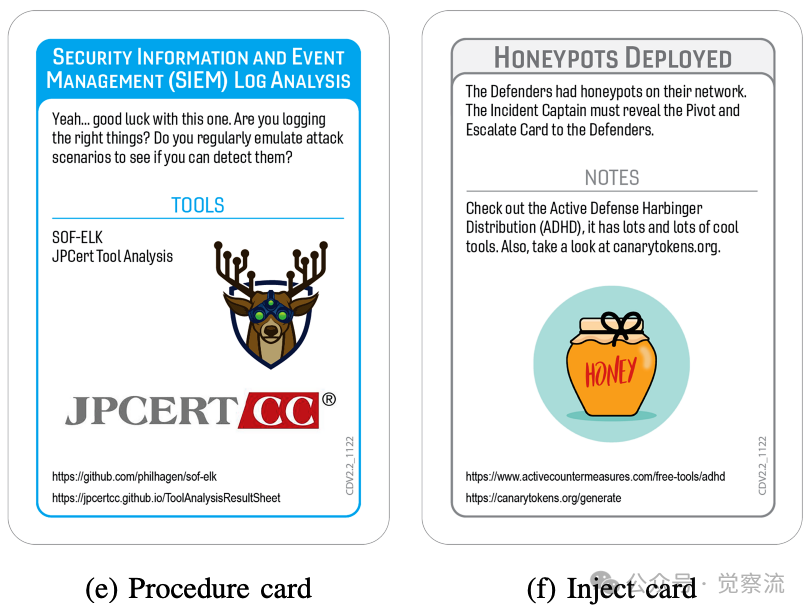

- RAG-Wiki:基于125篇技术文档(表I),涵盖Wikipedia(53.6%)、MITRE ATT&CK(7.2%)、Microsoft Learn(4.8%)等权威来源。这些文档覆盖了与B&B卡牌相关的技术解释、威胁模型和实用指南,提供事实性、定义性的知识支持,用于锚定技术概念与检测逻辑。文档收集过程特别关注与Backdoors & Breaches卡牌相关的技术主题,包括访问令牌操作、ARP欺骗、DLL注入、钓鱼、内部威胁、恶意软件注入等,以及SIEM分析、欺骗技术、端点检测等防御策略。

- RAG-News:基于100篇合成叙事报告,通过结构化提示模板生成(附录B),模拟真实事件报告。这些故事以虚构内部安全团队的视角,描述他们如何调查和应对多阶段攻击,包含成功与失败的调查过程,提供过程性、情境化的案例学习,帮助智能体理解"攻击如何被发现"的完整路径。每篇新闻故事都遵循严格的生成模板:以明确相关的标题开始,模拟真实新闻文章或事件报告,不包含具体日期或时间戳,团队最初不知道攻击卡牌,必须尝试不同程序,逐步揭示攻击路径,并包含成功与失败程序的示例。

WebpageDistribution

上表:RAG-Wiki设置中收集的网页分布。关键看点:Wikipedia占比53.6%,表明基础概念解释是技术文档的主要内容;而网络安全博客/供应商内容占21.6%,提供了实用指导和最新威胁情报。

为什么需要双知识源? 安全调查本质上是一个"既需要事实,又需要过程"的活动。RAG-Wiki提供技术准确性,而RAG-News提供调查思路——这就像安全分析师既需要参考NIST指南,又需要学习同行的调查案例。在实际工作中,这两种知识源的结合能产生最佳效果。

辩论型团队(Argumentative Teams):内置的"批判性思维"模块:AutoBnB-RAG新增两种团队结构(Homogeneous/Heterogeneous Argumentative),其角色定义明确要求成员"建设性反对"(constructive disagreement),主动挑战提议、提出替代方案。例如,"辩论型端点安全专家"的职责包括"对提议的行动提出建设性质疑,确保端点相关决策经过充分验证"。此设计旨在对抗群体思维,与外部RAG机制形成"内外双重视角",共同提升决策鲁棒性。在具体实现中,辩论型团队成员被明确指示"尊重地挑战同伴建议,引入替代想法以刺激批判性思维,避免群体思维",而不仅仅是提供专业意见。

BnBCards

上图:Backdoors & Breaches卡牌示例,展示初始入侵、横向移动、C2与外传、持久化等攻击阶段。关键看点:这些卡牌覆盖了从初始入侵到持久化的完整攻击链,模拟了真实APT攻击的多阶段特性。

实验结果:数据揭示RAG的普适性增益与关键设计原则

AutoBnB-RAG在八种不同团队结构上进行了系统评估,每种结构进行了30次独立模拟,结果清晰展示了RAG机制的显著价值。研究采用AutoGen系统,以GPT-4o作为基础模型,温度设置为0.7,确保实验条件的一致性。30次独立模拟的设计保证了结果的统计显著性,能够有效排除随机因素对实验结果的影响。

主实验:RAG显著提升所有团队的胜率

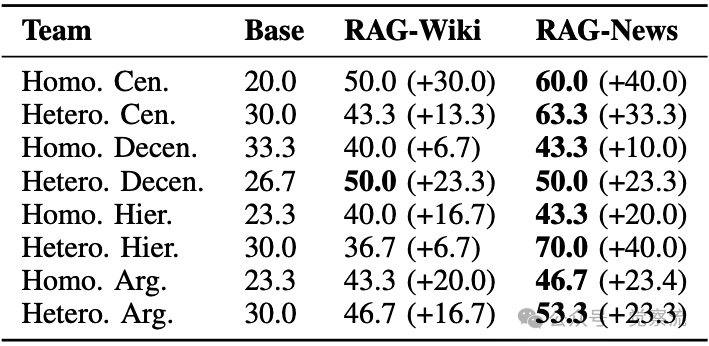

WinRates

上表:不同团队结构在模拟事件响应场景中的胜率,展示检索增强前后的性能提升。关键看点:请特别关注三组数据——(1)异构层级团队在RAG-News下70.0%的最高胜率,比基线提升40个百分点;(2)辩论型团队的显著提升,证明批判性思维的价值;(3)RAG-News在多数场景优于RAG-Wiki,揭示了情境化知识的重要性。

实验数据(上表)显示,RAG机制在所有八种团队结构中均带来显著胜率增长,证明其增益具有普适性:

- 全面性提升:在无检索的基线条件下,各团队胜率在20.0%-33.3%之间;引入RAG后,所有团队胜率均大幅提升,最高达到70.0%。这一提升幅度表明,外部知识的接入能够有效弥补LLM自身的知识缺陷。

- RAG-News为何更优?:在多数结构中,RAG-News胜率高于RAG-Wiki。分析表明,叙事性报告包含"成功与失败的调查过程",更贴近LLM的训练数据分布,更易激发其类比和情境联想能力,从而指导下一步行动。例如,同质集中式团队在RAG-News下胜率达60.0%,比RAG-Wiki高10个百分点。叙事性内容的连贯性和故事性使LLM能够更好地理解和应用其中的知识。

深入解读:为什么叙事性内容更有效?安全调查本质上是一个叙事过程——从线索到证据链的构建。LLM在处理叙事性内容时表现更好,这与它们的训练数据分布一致。RAG-News提供的不仅是事实,而是"如何应用这些事实"的完整思路,这正是安全分析师在面对未知威胁时最需要的。在实际SOC中,这类似于经验丰富的分析师分享他们的调查思路,而不仅仅是提供技术文档。

- 峰值性能:异构层级团队的"经验放大器"效应:Hetero. Hier.团队在RAG-News下达到70.0% 的最高胜率(基线仅30.0%)。该团队由3名领域专家和2名新手组成,RAG-News提供的"案例式指导"恰好弥补了新手经验不足,使专家能更高效地引导团队,形成协同增益。这一结果特别证明了RAG在混合经验水平团队中的价值。

实践启示:在实际SOC中,这对应着资深分析师指导初级分析师的模式。RAG-News就像为初级分析师提供了"虚拟导师",通过案例式学习弥补经验差距。对于安全团队管理者而言,这意味着投资于知识管理(特别是案例库建设)能显著提升团队整体能力。

消融研究:关键设计参数的实证验证

为理解AutoBnB-RAG的性能敏感性,研究者进行了消融实验,验证关键设计选择:

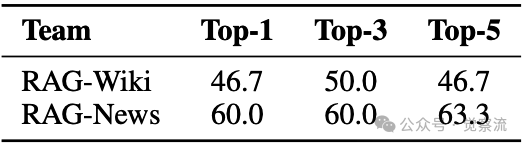

检索数量(Top-k):少而精为佳:在同质集中式团队中,比较了Top-1、Top-3、Top-5的检索效果(表IV)。结果显示性能相对稳定,Top-3已足够。过多检索结果可能引入噪声,"精准检索"比"海量检索"更重要。RAG-News在Top-5时甚至略有提升至63.3%,表明叙事性内容的冗余信息可能带来额外启发。这一发现对实际部署具有重要指导意义:在资源有限的情况下,优先确保检索质量而非数量。

RetrievalNumbers

上表:在同质集中式团队设置中,不同检索文档数量的胜率(%)。关键看点:Top-3已足够,过多检索可能引入噪声;RAG-News在Top-5时略有提升,表明叙事性内容的冗余信息可能带来额外启发。

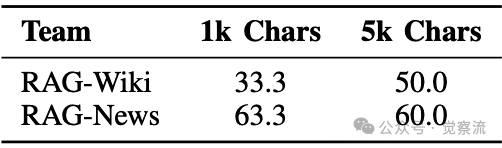

分块大小(Chunk Size):上下文连贯性至关重要:比较1,000字符与5,000字符的分块大小(表V),发现对技术文档(RAG-Wiki),更大的分块显著提升性能(50.0% vs. 33.3%),表明技术文档需要更完整的上下文以准确理解。而RAG-News对分块大小不敏感,因其叙事本身具有较强内聚性。这一差异揭示了不同类型知识源的处理需求:技术文档往往需要更完整的上下文来理解专业术语和概念关系,而叙事性内容则因其内在连贯性,对分块大小的敏感度较低。

ChunkSizes

上表:在同质集中式团队设置中,不同文档分块大小的胜率(%)。关键看点:技术文档需要更大分块(5,000字符)以保持上下文完整性,而叙事性内容对分块大小不敏感(1,000字符已足够)。

这些发现为实际部署提供了重要指导:对于技术性知识库,应保持较大分块以保留上下文;而对于叙事性内容,可采用较小分块提高检索效率。在实际安全运营系统中,可以根据知识源类型采用差异化的分块策略,以最大化RAG效果。

现实世界模拟:从游戏到真实威胁的"零样本攻击重构"

AutoBnB-RAG的价值不仅体现在模拟环境中,更在于其处理真实世界威胁的能力。研究者选取了2025年6月发生的三起真实安全事件,将它们映射到B&B卡牌体系,验证系统在非合成场景中的实用性。这些模拟使用GPT-4o模型,温度设置为0.7,检索配置为Top-3相关文档,文档分块为1,000字符窗口以保留上下文。

北面(North Face)撞库攻击案例

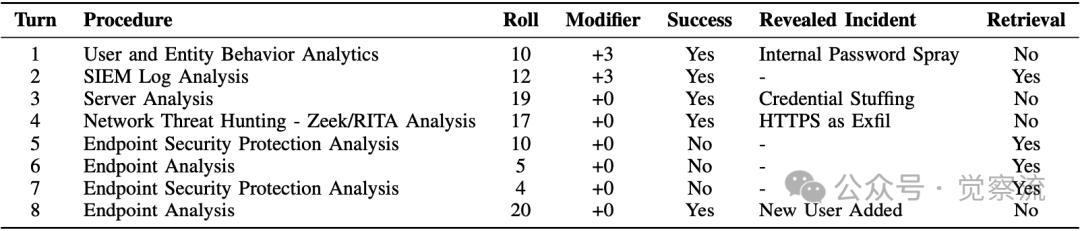

该案例模拟了北面网站客户账户遭撞库攻击的事件。攻击路径映射为:撞库(Credential Stuffing)→内部密码喷洒(Internal Password Spray)→HTTPS作为外传通道(HTTPS as Exfil)→添加新用户(New User Added)。

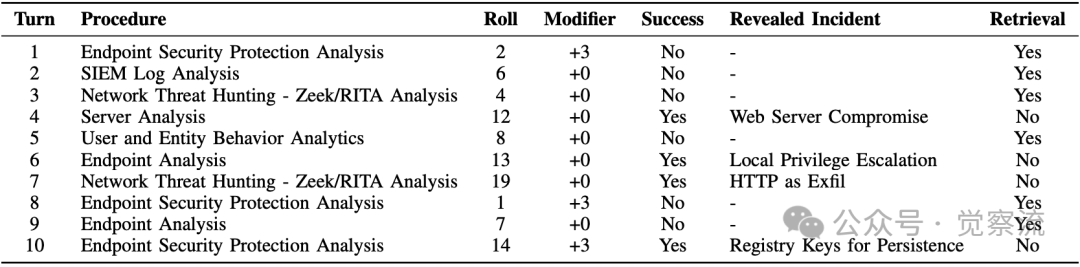

NorthFaceSimulation

上表:北面撞库事件模拟的回合轨迹,使用同质集中式团队结构。关键看点:第3回合SIEM日志分析失败后触发的检索,直接引导团队转向服务器分析,成功识别出初始撞库攻击。

关键转折点出现在第2回合:当"用户与实体行为分析"(UEBA)成功揭示内部密码喷洒后,第3回合的SIEM日志分析失败,触发了检索操作。检索返回的相关信息帮助团队聚焦于服务器分析,成功识别出初始撞库攻击。这一"失败-检索-成功"的模式,清晰展示了RAG在突破调查瓶颈中的关键作用。值得注意的是,UEBA程序作为已建立程序(+3修饰符)成功揭示了内部密码喷洒,而SIEM日志分析作为非已建立程序(+0修饰符)的失败触发了检索机制,体现了游戏机制与RAG集成的无缝衔接。

实战启示:在真实SOC中,当常规检测方法失败时,RAG机制就像一位经验丰富的同事,提醒你"试试这种方法"。这种"关键时刻的知识急救"正是安全团队最需要的。

Cock.li Roundcube漏洞案例

该案例模拟了攻击者利用Roundcube网络邮件界面漏洞窃取100万用户记录的事件。攻击路径映射为:Web服务器入侵(Web Server Compromise)→本地权限提升(Local Privilege Escalation)→HTTP作为外传通道(HTTP as Exfil)→注册表键持久化(Registry Keys for Persistence)。

CockliSimulation

上表:Cock.li Roundcube漏洞事件模拟的回合轨迹,使用同质集中式团队结构。关键看点:前3回合全部失败,团队陷入困境;第4回合服务器分析的成功是整个调查的转折点。

值得注意的是,前3回合全部失败,团队陷入困境。检索机制在此时发挥了关键作用,提供了外部情报支持,引导团队在第4回合通过服务器分析成功识别Web服务器入侵。这表明,RAG在早期调查受阻时的价值尤为突出,能够帮助团队快速调整方向。服务器分析程序作为已建立程序(+3修饰符)的成功,是整个调查的转折点,凸显了"已建立程序"在关键节点上的重要性。

深度分析:在真实事件中,当团队连续失败时,往往会产生"决策瘫痪"。RAG机制在此时提供的外部视角,就像为团队注入了一剂"认知重启剂",帮助他们跳出思维定式。这对于处理新型或复杂攻击至关重要。

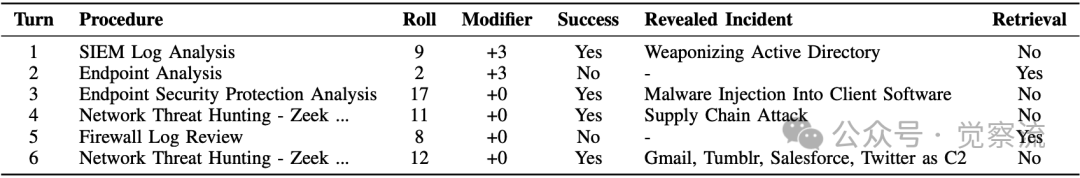

Gluestack供应链攻击案例

该案例模拟了Gluestack NPM包供应链攻击,攻击者将远程访问木马注入React Native库。攻击路径映射为:供应链攻击(Supply Chain Attack)→武器化Active Directory(Weaponizing Active Directory)→利用第三方服务作为C2(Gmail/Tumblr/Salesforce/Twitter as C2)→恶意软件注入客户端软件(Malware Injection Into Client Software)。

GluestackSimulation

上表:Gluestack NPM供应链攻击事件模拟的回合轨迹,使用同质集中式团队结构。关键看点:第2回合端点分析失败后触发的检索,为团队提供了关键指导,使其转向"端点安全保护分析",成功识别持久化阶段。

该案例仅用6回合就成功识别全部四个攻击阶段,展示了高效的调查过程。第2回合端点分析失败后触发的检索,为团队提供了关键指导,使其转向"端点安全保护分析",成功识别持久化阶段。随后的网络威胁狩猎又揭示了初始供应链攻击和C2通道。这一案例特别说明了RAG如何支持针对隐蔽、开发导向型威胁的灵活调查。值得注意的是,SIEM日志分析作为已建立程序(+3修饰符)在第1回合就成功揭示了武器化Active Directory阶段,为后续调查奠定了基础。

行业洞察:供应链攻击因其隐蔽性和复杂性,是当前安全领域的重大挑战。AutoBnB-RAG在这一案例中的成功,证明了RAG机制在处理新兴威胁方面的适应性。对于安全团队而言,这意味着即使面对前所未见的攻击手法,也能通过外部知识支持进行有效调查。

核心结论:零样本推理能力:这些真实事件未被包含在RAG-News的合成库中。系统通过检索到的相似情境案例,成功重构了完整的多阶段攻击路径。这证明AutoBnB-RAG具备基于外部知识进行零样本迁移和推理的能力,是其实际应用潜力的关键体现。在Gluestack案例中,尽管供应链攻击是相对较新的威胁类型,但通过检索到的相似情境,系统仍能有效识别攻击路径,展示了RAG机制在应对新兴威胁方面的适应性。

总结:迈向可信赖的AI安全协作

AutoBnB-RAG的研究成果清晰表明,将RAG机制深度集成到多智能体协作框架中,不仅能显著提升事件响应的成功率,更能增强决策的事实性、适应性与可解释性。实验数据证实,检索增强在所有测试的团队结构中均带来显著性能提升,最高胜率达到70.0%,比基线提高40个百分点。

研究揭示了几个关键点:

- 情境化知识优于纯技术文档:RAG-News在多数场景下表现优于RAG-Wiki,表明LLM更善于从叙事性、过程导向的案例中提取实用洞察。这与LLM的训练数据特性一致,因为大量训练数据包含叙事性内容。对安全团队的启示:投资于案例库建设比单纯收集技术文档更有价值。

- 团队结构影响RAG效果:层级化和集中式团队从RAG中获益最大,特别是结合专家与新手的异构层级团队,RAG-News将其胜率从30.0%提升至70.0%。这表明RAG机制能够有效弥补团队经验不足,放大专家价值。对安全团队的启示:在构建SOC时,应考虑经验混合的团队结构,以最大化RAG效果。

- 精准检索优于海量检索:Top-3检索已足够,过多结果可能引入噪声。这一发现对实际部署具有重要指导意义,特别是在计算资源有限的环境中。对安全团队的启示:质量优于数量,精心构建的知识库比海量数据更有价值。

- 上下文连贯性至关重要:技术文档需要更大分块以保持上下文完整性,而叙事性内容对分块大小不敏感,这为不同知识源的处理提供了差异化策略。对安全团队的启示:根据知识类型采用不同的管理策略,技术文档需要更完整的上下文,而案例分享可以更碎片化。

AutoBnB-RAG验证了"结构化多智能体协作"与"目标知识访问"的结合,是克服LLM固有缺陷、构建更具韧性与可靠性的AI驱动防御系统的可行路径。这一框架不仅适用于模拟环境,还能有效重构真实世界的安全事件,展示了从实验室到实际部署的潜力。

未来研究方向包括探索更多样化的知识源(如实时威胁情报馈送)、评估不同LLM基座模型的影响,以及模拟更复杂的团队动态。特别是,将RAG机制与实时威胁情报集成,可能进一步提升系统对新兴威胁的响应能力。AutoBnB-RAG不仅是一个模拟工具,更是探索"人机协同、AI赋能"未来安全运营模式的重要实验平台。随着网络安全威胁日益复杂多变,这种结合人类专业知识与AI规模化能力的混合响应模式,将成为构建弹性安全体系的关键支柱。

最后的思考:在AI安全智能体的发展道路上,AutoBnB-RAG证明了一个简单而深刻的真理:最聪明的团队,不仅是那些拥有最多知识的团队,更是那些知道何时以及如何获取所需知识的团队。在网络安全的动态对抗环境中,这种"知识获取能力"可能比"已有知识量"更为关键。AutoBnB-RAG的"按需检索"机制正是对这一原则的实践,它不仅增强了LLM智能体的决策能力,也为构建可信赖的AI安全系统提供了重要范式。

对于安全从业者而言,这一研究提醒我们:在AI时代,真正的专业能力不仅在于掌握多少知识,更在于如何高效地获取和应用知识。这或许是我们应对日益复杂网络安全挑战的最有力武器。