大家下午好,今天我将基于百度智能云在基础设施等方面的技术能力,以混合云的业务实践为案例,向大家描述我们在建设诸如 3.2 万卡全国产智算集群这样的超大规模集群时,都面临了哪些挑战,以及在此期间我们做了怎样的探索,去解决这些问题。

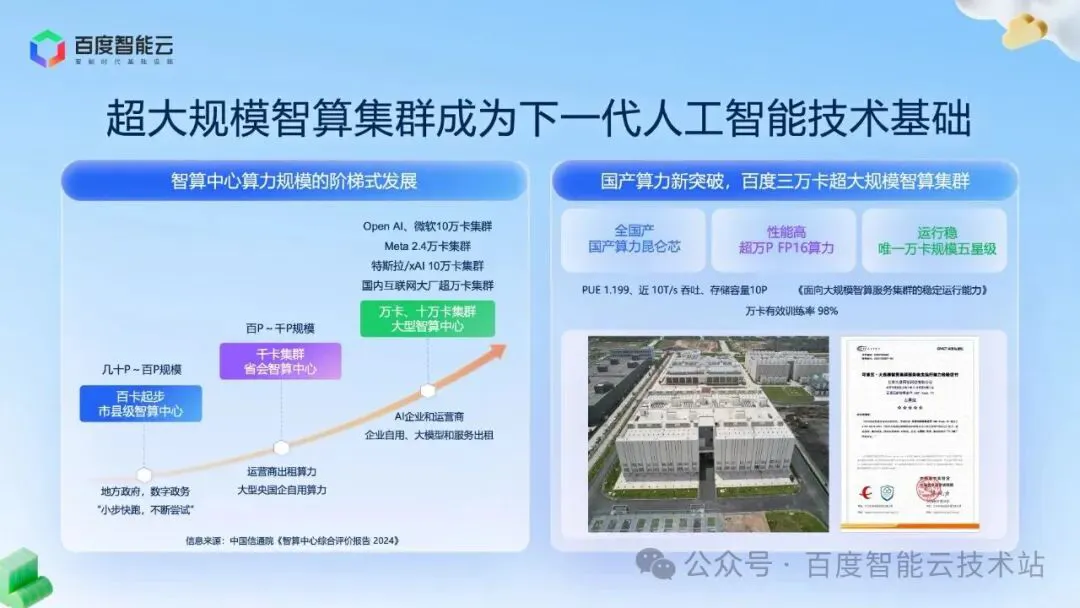

在过去几年,随着国家大力推进智算中心高质量发展,我国的智能算力实现跨越式增长,从百卡、千卡,向万卡、十万卡规模扩展。在这个进程中要具备两方面能力:

一方面如何把大规模算力建好,另一方面在建好的同时如何使这些算力得到有效使用、极致发挥。

百度智能云混合云深度参与了这个进程,也成功打造并且运营了多个大规模实践案例。刚才提到的 3.2 万卡超大规模智算集群正是综合应用了我们积累的各项技术能力,主要有以下特点:

- 首先是硬核底座,采用国产算力昆仑芯,实现核心技术的自主创新;

- 其次,整个集群提供了超万 P 算力,并实现了万卡有效训练率 98%;

- 在能效方面,整个集群的 PUE 做到了 1.199;

- 最后是建成后的运行情况,我们拿到了唯一的万卡规模智算集群服务稳定性的五星级认证。

图片

图片

接下来我将基于这个实际案例做一些具体的分享。

在去年,为了应对大规模智算集群建设的趋势,我们推出了「智算原生混合云」的产品方案,把智算的核心技术与混合云的弹性、安全与扩展能力进行了融合,通过软硬协同、一体化交付的方式构建智算基础设施。主要包含四层核心产品:

- 底层的高效智算中心 AIDC;

- 基于 AIDC 的高性能智算云底座 ABC Stack;

- 基于云底座之上的百度百舸 AI 计算平台;

- 以及多集群之间的算力运营平台 BHCMP。

基于整套方案,我们目前已成功落地多个超大规模集群。在这个过程中,由于算力规模攀升所带来的挑战主要在于两个方面:

其一,是算力规模本身带来的基础设施难题。特别是在电力和散热方面的瓶颈、网络互联和通信的效率,训推过程当中的并行计算以及使用性能。

其二是在集群建成之后,如何实现高质量使用同样关键,包括智能运维与安全保障、算力协同与高效运营。

首先,在 IDC 基础设施方面,相较于中小型的智算中心,超大规模集群在基础设施的部署与算能协同方面,面临更为严峻的挑战。具体包括几点:

- 电力保障:随着单芯片、单服务器的功耗飙升,算力规模提升,显存容量、通信带宽增长,模型训练以及模型集群化推理业务,相较于传统互联网业务而言,对整个集群的电力容量需求大幅提升;

- 散热压力:风冷散热能力接近极限,传统散热方式无法满足新一代芯片要求;

- 空间布局:GPU 并行计算带来的低延时数据传输要求,需要从配套电力到空间布局等全套的动态灵活调整机制来实现良好的配比。

针对以上挑战,在产品层面我们推出了更高算力密度和更高运行效率的昆仑芯超节点产品,并且基于昆仑芯超节点及传统 8 卡服务器的风冷、液冷形态,构建了大规模 AIDC 的技术方案。

- 供电体系上,我们引入「一体化 + 储能」架构,应用 750V 高压直流、源网荷储及绿电直供等技术,提升系统供电效率、可靠性与灵活性。

- 制冷系统上,采用「度冰川」+「度灵溪」的分布式架构,结合超节点 2.0 整机柜,实现冷源池化与风液兼容。在异构算力场景中,依托风液同源和复合式冷源架构,更有效地提供了散热能力支撑。

- 空间布局上,为进一步应对单栋建筑体量限制,我们推动更高功率密度与多建筑协同布局策略。在万卡甚至更大规模的场景中,必须将所有的算力节点到网络核心节点的通信延迟,控制在一个稳定的波动范围之内。对此,我们从传统并行布局改成以网络为核心的向心布局——从同一楼层的平面向心,到单栋建筑多层环境下的空间向心,以及跨楼宇的园区向心。

图片

图片

通过 AIDC 解决园区基础设施资源容量问题之后,算力集群对组网方案、路由策略以及网络的负载均衡也提出了极高的要求。

受电力与物理空间限制,超万卡的机柜一般需要多机房协同承载,为此我们推出了跨园区 RDMA 长传方案。这个方案包括硬件和软件两部分:

- 硬件层面,通过百度智能云自研的高性能大缓存交换机和优化的 RDMA 协议实现跨园区的高效互联互通,保障了长距离 RDMA 无损传输;

- 软件层面,通过百舸 5.0 高效调度算法,对模型并行策略进行优化。比如把对延时敏感度高,数据通信密度相对更高的专家并行、张量并行放在单一集群里面,而对延时敏感度相对较低,通信频率要求较低的数据并行,放在跨园区多集群之间进行通信。通信软件硬件配合方式,把长距离 RDMA 通信带来的性能影响降到最低。

同时在超大规模集群中,传统的组网方案面临路由爆炸、扩展性受限、可靠性差等问题。

我们通过路由聚合技术将大规模智算集群的 POD 内路由数量压缩到了 4000 多条,有效地缓解了交换机路由表项的压力。

同时我们将主机侧的 AR 自适应路由技术和端侧多平面组网架构进行了深度的结合:一方面通过端侧多平面组网提供更大的横向拓展能力,将二层组网规模从传统单 POD 8000 卡基础之上拓展到最大规模可达 13 万卡,且延时比三层组网更低。二是通过自适应路由实现了逐包哈希:对大象流产生的网络拥塞问题,我们会把流分拆成包,按单包分配到端侧不同网卡,再基于交换机协议在另一侧实现包重组,形成从包到流的重新汇聚,通过这种方式吞吐性能较传统的逐流哈希提升了20%;三是通过端侧多平面提供了更多的冗余链路,配合自适应路由技术,能够实现秒级的链路故障切换,从而极大提高网络可靠性。

整体上看,通过这些 HPN 关键技术,我们为大规模智算集群打造了一套高性能、高可靠、高扩展的组网架构。

说完组网,整个集群上线运营之后,我们将面临一个最核心的问题——建完之后如何把算力更有效地发挥出来?

在这个过程当中,我们从基础设施层、资源管理层、AI 任务层入手,解决整个资源利用率使用问题。

- 基础设施层中,在产品层面我们通过把原来在单机 8 卡内使用的 NVLink 传输能力进一步 Scale-up 到超节点内 32 卡乃至 64 卡(基于 XPU Link),去提升超节点内卡间通信效率。同时,利用高性能网络和存储,做机间网络扩展,使万卡网络带宽有效性大于 90%,单数据节点读吞吐大于 15 GiB/s;

- 资源管理层中,通过在控制面定向优化,我们可以支持单集群管理达到 12,500 节点的规模,并且实现了高并发场景下,查询变更等操作的响应时间在毫秒级;提交上百任务时,调度周期在分钟级。

最后是面向模型特点,尤其是最近火热的 MoE 架构,为整个训练推理过程带来了大量的 Alltoall 通信开销。针对这种场景,除了从网络拓扑层面减少 Alltoall 通信的交换机跳数,以及降低多对一通信的时延外,我们对 Alltoall 算子也进行了优化,相比开源方案,大幅提升 Prefill 和 Decode 的 Alltoall 通信性能。从效果上看,针对 batch size 级别的动态冗余专家编排,我们可以将专家均衡度优化至 1.08,确保集群中所有加速卡的通信时间大致相同。同时通过最大程度的计算和通信 overlap,整体吞吐提升 20% 以上。

我们具体看一下在训练、推理两个场景中算力效率的提升实践。

训练方面,得益于过往在 GPU 上对模型加速经验的大量积累,我们快速在国产芯上建立了全套优化体系,并面向 MoE 场景进行了新的优化,包括任务调度的易用性、并行策略、计算、显存、通信等不同维度的优化方向,贯穿产品、框架、编译器、算子、系统软件层面的整个 AI Infra 软件栈。具体手段上,我们在自动并行策略搜索、Alltoall 通信算子优化、计算通信 overlap 等基础上,还有算子融合、混合精度、显存 offload、通信压缩、优化 CPU 调用等细粒度的优化手段,从而能够在国产万卡集群 MFU 达到 50% 以上。

推理方面,我们将 PD 分离落地到国产芯生产环境中,通过采用推拉共存模式,可以同时兼顾小流量高性能、大流量高并发场景。我们还针对大模型注意力缓存机制的特点,实现了分布式 KV Cache 存储引擎(即 Attention Store)。该引擎可利用 SSD 和内存的超大容量,作为显存容量的补充,实现 KVCache 从显存到内存,再到 SSD 的多级缓存。在此之上,我们通过 PD 调度器实现了一种新的调度策略:通过对各层能力的缓存感知(即 Cache Aware),将 KV Cache 访问进行优化调度,提升推理性能。

通过这一系列的手段,最终可以提升整个 Prefix Cache 命中率,从原始状态提升 30%~50%。在万卡集群典型推理场景下,TTFT 可以降低 37%。

AI 基础设施进入运营状态后,就面临如何将算力稳定、高效、安全地转化为服务的挑战。这其中的关键在于,此时运维的核心从传统的「保障单节点和单模块稳定」转向「保障算力使用效率」,在实践当中,我们聚焦在算力与 AI 任务的协同上,围绕 AI 任务构建了全栈运维体系:

首先在基础设施上,我们在所有的设备部署前,会采用全面的软硬件质检与压力测试,提前排除隐患;在训推任务过程中,会采用百度自研硬件感知平台,从算力到网络及安全设备,进行全链路监控;运行后也会进行定期的软硬件巡检。基于基础设施全闭环的运维链条保障交付健康度 100% 以及系统运行的稳定性。目前,我们的硬件感知平台已经可以识别 280 多种 GPU 卡故障,并根据模式匹配到对应的故障类型,给出相对应的自动化容错方案。通过这种方式,基础故障召回率可以达到 98%。

第二在基础设施监控指标基础之上,我们提供了针对训练任务的全生命周期运维管理:通过在统一监控层实时采集日志、事件等相关信息,而后在训练保障层(如图所示绿色部分),对多维指标进行聚合分析,来判断当前任务执行的效率,这样可以预先识别集群中的潜在「软故障」,并提前进行相关的自动化容错处理,保障任务能够有效运行;最终通过全局可视化平台对底层基础指标以及任务粒度的运行状态进行全面且清晰的呈现。

最后在安全风险方面,通过加强基础设施、数据及模型的安全合规管理,保障敏感数据得到有效的管控;其次是搭建适应算力集群的安全运营体系,闭环安全风险事件。

除了面向单一集群建设和使用外,随着更多算力集群的上线使用,多集群之间的算力协同调度也成为一个核心问题,主要体现在三个方面:

- 第一,地域上,我们东西部算力资源不均衡,东部需求密集,而西部资源充裕;

- 第二,行业上,头部企业算力充裕而中小企业接入困难;

- 第三,场景上,高带宽、低延迟等多元需求难以被单一策略适配。

为此,我们构建了一套高效灵活的算力运营平台,能够对异构资源,异网资源、异地资源进行统一调度,推动算力资源向普惠方向发展。这套算力运营平台包括两个方面:

一是算力接入层,通过算力的一键接入机制,在 3 分钟内就可以完成一个新的智算池接入到算力体系中,大幅降低跨地域的资源整合门槛。同时针对异构资源,通过自研的资源标准化管理接口,屏蔽底层硬件、协议的差异,实现即插即用,打破资源孤岛。

二是算力感知和资源调度环节,我们通过实时采集集群负载、时延等核心指标,构建「全局算力资源画像」,实现从需求到策略、再到资源的精准绑定。

举个例子,当一个实时应答的推理任务,需要在峰值时段对外提供服务时,我们会按照低时延优先、低负载优先的策略命中最优资源池跑这个任务,并把结果反馈出去。

当前,我们已经建成了覆盖全国五大地域的算力网络,为全域用户提供高质量的算力服务,并将持续联手算力供应伙伴,借助算力运营平台进一步打造出覆盖面更广、资源供给更充足、可支撑更复杂任务的新型算力资源池。

我们常说技术赋能产品,产品成就方案,而方案的价值,最终必须交由实践检验。百度混合云具备从 AIDC 建设到底层芯片算力、平台软件,全栈的产品能力和技术。我们不但在实践中总结出了从建设、管理、使用到运维运营的全流程方案,也通过在厂内厂外多个项目中实践、迭代,已经形成了非常成熟的方案和建设体系。

我们的 3.2 万卡智算集群,是全国首个成功点亮的自研万 P 算力集群,这个集群汇集了我们所有的技术能力,也在建设和运行方面创下了多个纪录:90 天内完成动环施工,1 个月内完成万卡点亮,4 个月完成 3 万卡的投产运营,集群 MFU 超过 50%。

百度智能云混合云,愿意成为大家在国产化智算新基建路上的同行者,共同探索 AI 创新,共同为我国数字经济的发展,贡献力量。