2025年7月,Bilibili(B站)宣布其开源动漫视频生成模型AniSora迎来重大更新,正式发布AniSora V3。作为Index-AniSora项目的一部分,V3版本在原有基础上进一步优化了生成质量、动作流畅度和风格多样性,为动漫、漫画及VTuber内容创作者提供了更强大的工具。AIbase深入解读AniSora V3的技术突破、应用场景及行业影响。

技术升级:更高质量与精准控制

AniSora V3基于Bilibili此前开源的CogVideoX-5B和Wan2.1-14B模型,结合强化学习与人类反馈(RLHF)框架,显著提升了生成视频的视觉质量和动作一致性。其支持一键生成多种风格的动漫视频镜头,包括番剧片段、国创动画、漫画视频改编、VTuber内容)等

核心升级包括:

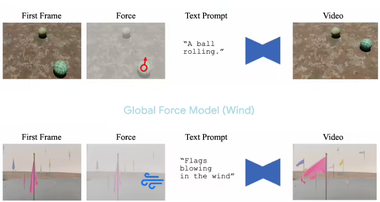

- 时空掩码模块(Spatiotemporal Mask Module)优化:V3版本增强了时空控制能力,支持更复杂的动画任务,如精细的角色表情控制、动态镜头移动和局部图像引导生成。例如,提示“五位女孩在镜头放大时起舞,左手上举至头顶再下放至膝盖”能生成流畅的舞蹈动画,镜头与角色动作同步自然。

- 数据集扩展:V3继续依托超过1000万高质量动漫视频片段(从100万原始视频中提取)进行训练,新增数据清洗流水线,确保生成内容的风格一致性和细节丰富度。

- 硬件优化:V3新增对华为Ascend910B NPU的原生支持,完全基于国产芯片训练,推理速度提升约20%,生成4秒高清视频仅需2-3分钟。

- 多任务学习:V3强化了多任务处理能力,支持从单帧图像生成视频、关键帧插值到唇部同步等功能,特别适合漫画改编和VTuber内容创作。

在最新基准测试中,AniSora V3在VBench和双盲主观测试中,角色一致性和动作流畅度均达到业界顶尖水平(SOTA),尤其在复杂动作(如违反物理规律的夸张动漫动作)上表现突出。

开源生态:社区驱动与透明发展

AniSora V3的完整训练和推理代码已于2025年7月2日在GitHub上更新,开发者可通过Hugging Face访问模型权重及948个动画视频的评估数据集。 Bilibili强调,AniSora是“对动漫世界的开源礼物”,鼓励社区协作优化模型。用户需填写申请表并发送至指定邮箱(如[email protected])以获取V2.0权重和完整数据集访问权限。

V3还引入了首个针对动漫视频生成的RLHF框架,通过AnimeReward和GAPO等工具对模型进行微调,确保输出更符合人类审美和动漫风格需求。社区开发者已开始基于V3开发定制化插件,例如增强特定动漫风格(如吉卜力风)的生成效果。

应用场景:从创意到商业

AniSora V3支持多种动漫风格,包括日本动漫、国产原创动画、漫画改编、VTuber内容及恶搞动画(鬼畜动画),覆盖90%的动漫视频应用场景。 具体应用包括:

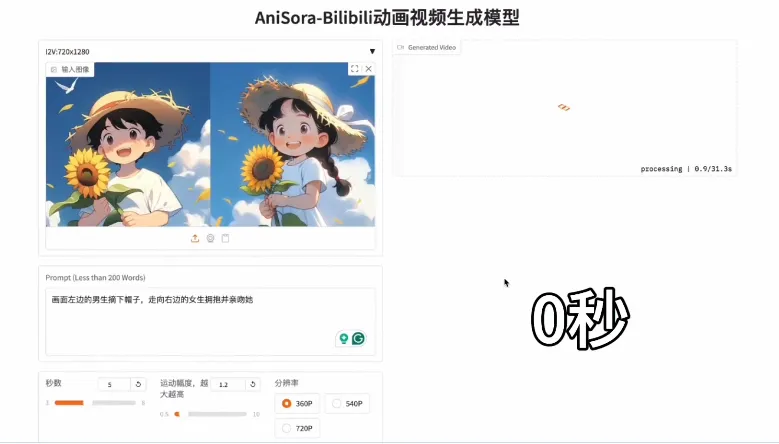

- 单图转视频:用户上传一张高质量动漫图像,配合文本提示(如“角色在向前行驶的车中挥手,头发随风摆动”),即可生成动态视频,保持角色细节和风格一致。

- 漫画改编:从漫画帧生成带唇部同步和动作的动画,适合快速制作预告片或短篇动画。

- VTuber与游戏:支持实时生成角色动画,助力独立创作者和游戏开发者快速测试角色动作。

- 高分辨率输出:生成视频支持高达1080p,确保在社交媒体、流媒体平台上的专业呈现。

AIbase测试显示,V3在生成复杂场景(如多角色交互、动态背景)时,相比V2减少了约15%的伪影问题,生成时间缩短至平均2.5分钟(4秒视频)。

AniSora V3的发布进一步降低了动漫创作门槛,使独立创作者和小型团队能以低成本实现高质量动画制作。相比OpenAI的Sora或Kling等通用视频生成模型,AniSora V3专注于动漫领域,填补了市场空白。 与字节跳动的EX-4D相比,AniSora V3更专注于2D/2.5D动漫风格,而非4D多视角生成,展现了不同的技术路线。

项目:https://t.co/I3HPKPvsBV