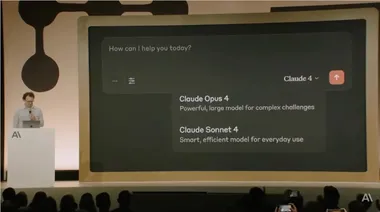

人工智能初创公司 Anthropic 今天宣布,他们备受欢迎的 Claude Sonnet4语言模型(LLM)现已支持高达100万个上下文词元。这一更新使 Anthropic 成为继 Google Gemini 之后,第二家能提供如此长上下文支持的主流模型供应商。

此前,Claude Sonnet4API 的上下文限制为20万个词元,而此次扩展将其提升至五倍,开发者们可以在单个请求中提交超过75,000行代码的整个代码库。这一改变将极大地方便开发者,尤其是在需要处理复杂任务或大规模数据时。

现在,Claude Sonnet4的长上下文支持已在 Anthropic 的 API 和 Amazon Bedrock 上进入公开测试阶段,Google Cloud Vertex AI 也即将推出类似功能。不过,目前的长上下文支持仅向 Tier4级别的开发者开放,并设定了自定义的速率限制。Anthropic 表示,未来几周内将逐步向更多开发者开放这一功能。

随着上下文窗口的扩大,必然伴随更高的计算需求。Anthropic 为此推出了新的定价策略:对于20万个词元以下的提示,Sonnet4的费用为每百万输入词元3美元,每百万输出词元15美元。而对于超过20万个词元的提示,费用则提升为每百万输入词元6美元,输出词元22.5美元。值得注意的是,开发者可以通过使用快速缓存和批处理来有效降低成本,批处理甚至可以为1M 上下文窗口的定价提供50% 的折扣。

最近,在 Reddit 的一场问答会议上,OpenAI 的领导层讨论了支持长上下文窗口的计划。OpenAI 的首席执行官 Sam Altman 表示,尽管尚未发现用户对长上下文的强烈需求,但若有足够的兴趣,他们会考虑支持这一功能。OpenAI 团队的 Michelle Pokrass 提到,他们原本计划在 GPT-5中提供长达100万个词元的上下文支持,特别是针对 API 的用例,但由于 GPU 需求量大,未能如愿。

随着 Anthropic 推出1M 上下文的支持,其在长上下文功能方面直接与 Google Gemini 竞争,这无疑给 OpenAI 带来了重新评估其产品路线图的压力。