大家好,我是肆〇柒。今天,我们来了解一项来自北京智源人工智能研究院(BAAI)的创新工作——InfoSeek。说不定你也想过,一个参数量仅为30亿(3B)的小模型,为何能在复杂研究任务上碾压320亿(32B)参数的大模型?答案不在于模型架构的玄学,而在于BAAI团队创新的“数据炼金术”。他们将海量网页转化为一种名为“层次化约束满足问题”(HCSP)的高纯度燃料,让小模型爆发出惊人的深度研究能力。接下来,让我们一起了解一下这个创新研究。

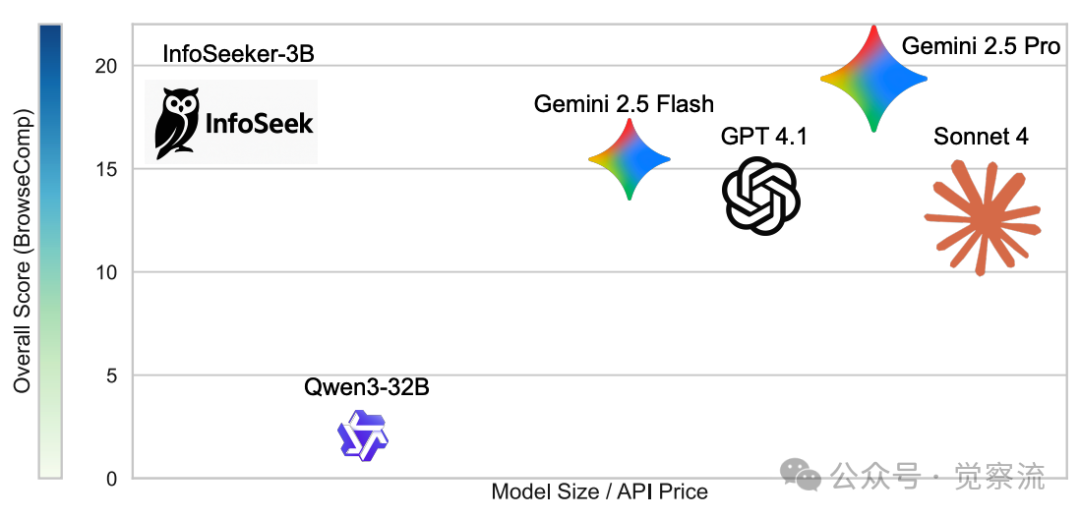

性能对比图

当看到这张性能对比图时,即使是经验丰富的AI研究者也会感到震惊:一个仅含30亿参数的InfoSeeker-3B模型,竟然在复杂任务上大幅超越了参数量高达320亿的Qwen3-32B模型,甚至与Gemini 2.5 Pro等商业大模型性能相当。这一结果彻底颠覆了"模型越大越好"的传统认知,引发了业界对深度研究能力本质的重新思考。

InfoSeeker-3B的性能提升并非偶然。正如技术报告所揭示的,其背后隐藏着一种全新的数据合成方法——InfoSeek,它通过精准捕捉深度研究任务的本质结构,为模型提供了高质量的训练信号。这一发现表明,在大型语言模型(LLM)的发展道路上,数据质量可能比模型规模更为关键。下面就一起瞅瞅这一"数据炼金术"的工作原理。

传统数据的根本性局限

当前主流的问答数据集,如Natural Questions(NQ)、HotpotQA和WebWalkerQA等,虽然在单跳和多跳问题上表现出色,却难以捕捉真实深度研究任务的复杂性。这些数据集的局限性主要体现在三个方面:

首先,它们的结构过于扁平。现有基准测试无法充分反映真实深度研究任务的层次化特性,正如技术报告所指出的,"existing benchmarks fail to capture this complexity"。单跳问题仅需满足并行约束,多跳问题则依赖线性推理链,但真实研究往往需要同时处理多层次、相互依赖的约束网络。

其次,这些数据集缺乏足够的深度。多跳问题通常只需要简单的线性推理,而深度研究则要求模型能够系统性地分解复杂问题,协调多步推理,并整合来自不同来源的证据。这种能力在传统数据集中难以得到充分训练。

更为严重的是,近期合成的数据集常常引入"捷径推理"和"知识泄露"问题。当模型发现可以通过参数化记忆而非真正推理来回答问题时,其深度研究能力的培养就会受到严重阻碍。技术报告中提到,当让Qwen2.5-32B模型直接回答InfoSeek问题时,它只能正确回答2%的问题,而传统数据集中的问题则容易得多。

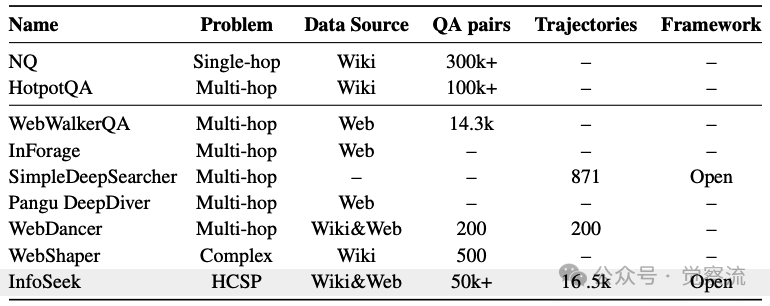

经典QA数据集与深度研究数据合成方法对比

通过上表的对比可以看出,InfoSeek在问题复杂度和开源状态上具有显著优势。它不仅是首个专注于深度研究场景的大规模数据集,还能够生成具有可控复杂度的层次化约束满足问题,并支持针对不同研究需求的便捷扩展。这一突破填补了高质量、结构化深度研究数据集的空白,为训练真正具备深度研究能力的模型提供了必要条件。

InfoSeek数据炼金术:从网页到HCSP的转化

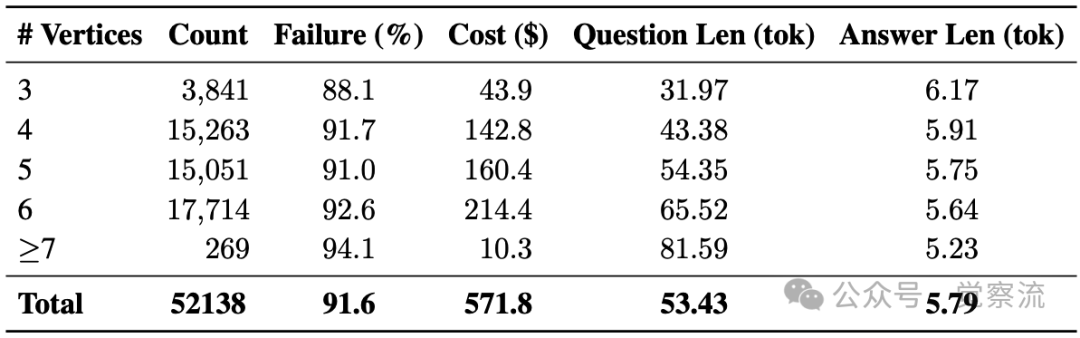

HCSP:深度研究问题的数学本质

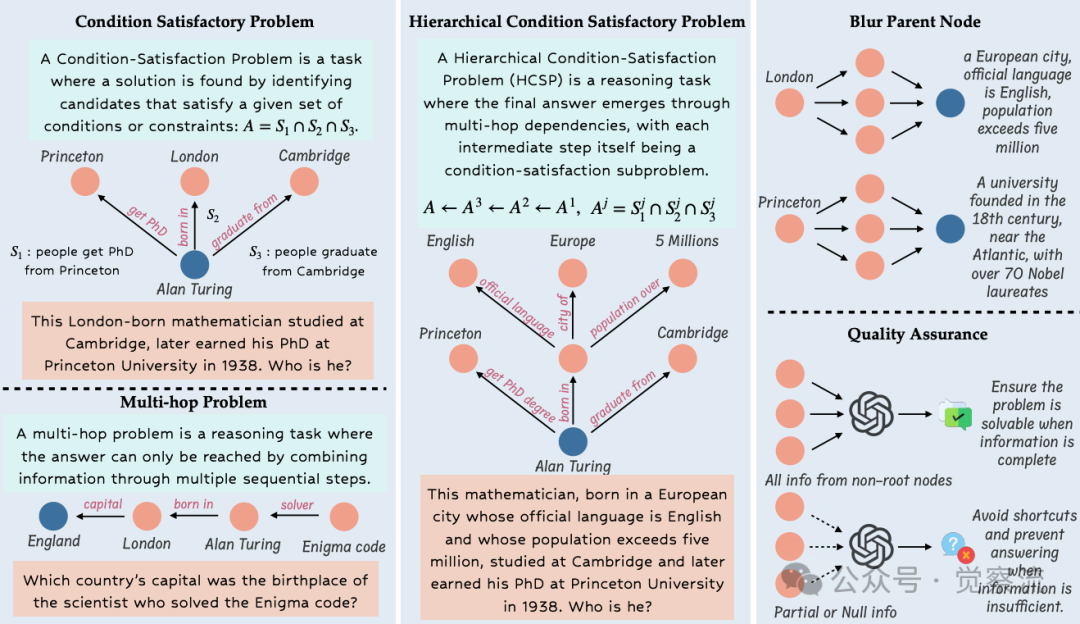

要理解InfoSeek的创新之处,必须先明确深度研究问题的数学本质。InfoSeek将具有可验证答案的深度研究问题形式化为层次化约束满足问题(Hierarchical Constraint Satisfaction Problem, HCSP),这一定义与传统的约束满足问题(CSP)和多跳问题(MHP)有着本质区别。

约束满足问题可以理解为多个独立条件的交集。例如,要找出"在1938年获得普林斯顿大学博士学位、出生于伦敦、毕业于剑桥大学的人",模型只需将三个条件的候选集取交集,即可得到"Alan Turing"这一答案。这类问题虽然需要整合多源信息,但所有约束都是并行且独立的。

多跳问题则要求模型按顺序执行多个推理步骤。例如,从"破解Enigma密码的科学家"出发,先找到"Alan Turing",再确定其出生地"London",最后得出国家"England"。这类问题需要线性推理链,但每一步的推理相对简单。

约束满足问题、多跳问题与层次化约束满足问题对比

上图清晰展示了三种问题类型的本质区别。层次化约束满足问题(HCSP)的创新在于,它构建了一个树状推理网络——每个中间节点本身就是一个约束满足问题,高层结论的有效性完全依赖于所有低层约束的满足。以图中Alan Turing案例为例,要确定"出生于一个人口超过500万、官方语言为英语的欧洲城市"这一模糊描述,不仅需要验证该城市的人口和语言特征,还需确认该城市与Alan Turing的其他关联(如毕业院校、博士学位等)。这种层次化结构更接近真实研究过程:科学家在探索未知时,往往需要同时处理多个相互依赖的子问题,而非简单地按顺序解决。

双智能体协同:Planner与Browser的精密配合

InfoSeek的数据合成过程采用双智能体协同工作的方式,从大规模网页数据中自动构建研究树,这一设计是其能够生成高质量HCSP的关键。两个智能体各司其职,形成了一种高效的分工协作机制。

Planner作为全局规划者,负责维护研究树的整体构建进度,根据全局复杂度目标选择目标节点和具体操作。它需要在顺序推理和并行推理之间取得平衡,确保研究树在深度和广度上均衡发展。Planner的决策直接影响问题的复杂度和结构,是控制合成数据质量的关键环节。

Browser则作为执行者,负责具体执行Planner选择的操作。它通过浏览选定节点的网页,提取候选超链接(增加深度)或原子声明(添加约束),并验证相关内容的相关性。Browser的工作确保了合成问题的证据链可靠且可验证,为后续训练提供了坚实基础。

这两个智能体的工作流程高度结构化:从Action 1开始初始化研究锚点,随后交替执行Action 2(模糊父节点)和Action 3(树结构扩展),最终以Action 4(问题生成与终止)结束。整个过程中,每一步扩展都记录明确的证据轨迹,确保问题的可验证性。这种双智能体架构不仅提高了数据合成的效率,还保证了生成问题的结构质量和复杂度控制。

四步炼金:从网页到HCSP的完整转化

InfoSeek的数据合成过程可概括为四个关键步骤,这些步骤共同构成了从原始网页到结构化HCSP的完整转化路径。

第一步是初始化研究锚点。InfoSeek使用维基百科和网页作为底层知识库,筛选有效实体作为研究树的根节点。具体而言,它从维基百科知识库中采样一个有效实体作为最终答案,并创建一个初始顶点r形成最基础的研究树。随后,Browser执行第一次扩展,选择一个相关实体创建子节点w及其连接边,为后续层次化推理奠定基础。

第二步是模糊父节点技术,这是InfoSeek的核心创新。Planner首先识别出当前约束不足以唯一确定的节点v,然后Browser从v的网页中选择k个声明,这些声明共同唯一确定v。关键设计在于确保候选集之间不存在包含关系,防止问题过早收敛。例如,将"Alan Turing"模糊为"出生于一个人口超过500万、官方语言为英语的欧洲城市",既保证了问题的挑战性,又确保了答案的唯一性。这一技术使得每个中间节点本身成为一个有效的约束满足问题,为层次化推理创造了必要条件。

第三步是树结构扩展,用于增加研究树的深度。Planner选择垂直扩展,从现有实体节点v提取超链接(如"v由w发现"),创建新的子节点w,从而延长逻辑依赖链。这种扩展增加了研究树的高度,提升了推理步骤的复杂度,使问题更接近真实研究场景。值得注意的是,每次扩展都基于实际网页内容,确保了问题的真实性和可验证性。

第四步是问题生成与终止,只有当研究树达到目标复杂度且所有节点有足够约束时才会触发。Planner基于完整的研究树构建最终问题,要求模型必须遍历整个层次结构才能得到答案。这一设计确保了每个合成问题都强制模型进行真正的层次化推理,避免了"捷径推理"的可能性。

双重验证确保数据价值

InfoSeek不仅关注数据规模,更重视数据质量,通过双重验证机制确保合成数据既"真难"又"真可解"。

难度验证环节让Qwen2.5-32B模型直接回答这些问题,结果表明模型仅能正确回答2%的问题。这一极低的准确率证实了数据集的高难度,也说明这些问题无法通过参数化记忆解决,必须进行真正的推理。InfoSeek移除了这些简单样本,确保数据集具有足够的挑战性。

可验证性验证则更为严格。InfoSeek将真实网页与干扰文档混合,让Gemini 2.5 Flash API基于这些材料推导答案。这一过程过滤掉答案错误、多解或无法解决的问题,有效防止了"答案不唯一"(underdetermined issue)和"过早收敛"(overdetermined issue)现象。只有那些在提供完整证据链时能得出唯一正确答案的问题才会被保留。

这种双重验证机制确保了InfoSeek数据集的质量:问题足够复杂,需要真正的层次化推理;同时又有明确的解决路径,确保模型能够通过正确推理得到答案。这种"高难度-高可解性"的平衡,正是训练高质量深度研究能力的关键。

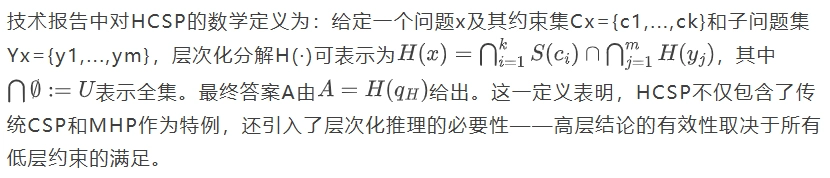

规模与成本:可扩展性的实证

InfoSeek不仅在质量上表现出色,在规模和成本方面也具有显著优势。根据下表的数据,InfoSeek包含52,138个样本,总数据整理成本仅为571.8美元,这一成本效益比在同类数据集中极为突出。

构建的研究树数据,按顶点数量分析其成本、失败率(Qwen2.5-72B,CoT)及 token 长度

数据分布显示,4-6个顶点的问题占比超过90% (15,263 + 15,051 + 17,714 = 47,928),这反映了深度研究问题的典型复杂度。更为重要的是,失败率与顶点数量呈现强正相关:3顶点问题的失败率为88.1%,而7+顶点问题的失败率高达94.1%。这一趋势证实了InfoSeek的合成过程"能有效控制推理复杂度",为不同难度级别的训练提供了精确的调控手段。

这种可扩展性不仅体现在数据规模上,还体现在方法论层面。InfoSeek提供了一套完整的开源框架,使研究者能够"便捷且可扩展地构建数据集"。通过调整研究树的复杂度参数,研究者可以针对特定需求生成不同难度级别的问题,为深度研究能力的系统性培养提供了灵活工具。

从数据到模型:InfoSeeker的训练秘籍

革命性工作流:小模型处理复杂任务的秘诀

InfoSeeker的工作流程设计是其能够以小博大的关键。与传统方法相比,这一工作流通过几个创新点解决了小模型处理复杂任务的核心挑战。

"思考先行"(Think Before Action)是整个工作流程的基石。每个推理回合开始时,模型首先在<think>和</think>标记之间进行结构化思考,这一设计强制模型反思已有信息并规划必要信息。这种结构化思考避免了盲目搜索的陷阱,引导模型生成更有针对性的查询,使推理过程更加稳健。实践证明,这一看似简单的流程设计,是小模型能够处理复杂深度研究任务的关键创新点之一。

并行多查询搜索是InfoSeeker的另一大亮点。与传统的顺序单查询策略不同,InfoSeeker在单步内生成多个多样化查询(标记为<search>和</search>),从多角度全面解决当前信息需求。这种并行化方法不仅扩大了信息覆盖范围,还加速了探索过程,有效避免了"上下文臃肿"问题。在多轮推理中,传统方法的上下文会迅速膨胀,导致模型失去焦点,而InfoSeeker通过并行多查询保持了上下文的紧凑性。

提炼智能体(Refiner Agent)进一步优化了信息处理效率。对于每个查询返回的top-k结果,Refiner Agent生成简洁摘要,提取关键证据并与查询意图对齐。InfoSeeker实践中采用Qwen2.5-7B-Inst作为基础模型,这一选择既保证了效率,又确保了摘要质量。通过提炼智能体,InfoSeeker能够"高效利用多查询搜索中的海量信息",同时保持工作上下文的紧凑和可操作性。

最终,当积累足够信息或达到最大搜索步骤时,模型输出最终答案(标记为<answer>和</answer>)。这一结构化输出确保了答案的可验证性,也为后续训练提供了清晰的监督信号。

这一工作流设计解决了传统方法中的核心瓶颈:随着搜索深度增加,上下文迅速膨胀导致模型失去焦点。InfoSeeker通过并行多查询与提炼智能体的组合,实现了高召回率与紧凑上下文的平衡,使3B参数的小模型也能处理复杂的深度研究任务。

两轮训练:渐进式能力提升

InfoSeeker采用"两轮训练"策略实现能力跃升,这是小模型突破性能瓶颈的关键。这一策略的核心思想是通过渐进式难度提升,让模型从基础能力逐步发展到高级推理。

第一轮训练使用24K高质量轨迹进行监督微调(SFT)和强化学习(RL)。这些轨迹通过拒绝采样获得,仅保留成功完成任务且答案正确的推理路径。训练在单个8×H100节点上仅需2小时,即可获得InfoSeeker-3B-SFT-Round1。这一阶段主要培养模型的基础推理和搜索能力,使其掌握"思考先行"、"并行多查询"等核心工作流程。

第二轮训练则聚焦于能力深化。从55K源样本中精选17K更难样本(保留模型失败的14K样本),通过拒绝采样生成3,450高质量轨迹。这些轨迹具有"多轮搜索、更精细的任务分解和更准确的逐步推理"的特点,针对性强化模型的深度研究能力。特别值得注意的是,第二轮训练专门针对模型在第一轮中表现薄弱的领域,实现能力的精准提升。

这种渐进式训练策略解决了小模型训练中的一个核心挑战:复杂多步推理任务的探索空间巨大,直接强化学习在稀疏奖励和组合行动空间下往往不稳定且效率低下。通过先建立基础能力,再逐步增加难度,InfoSeeker避免了"一步到位"训练导致的优化困难,使小模型能够稳步提升其深度研究能力。

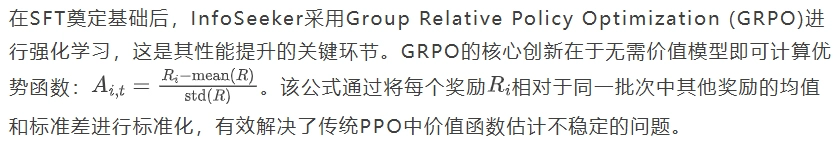

GRPO算法:精准强化的核心

算法设计上,GRPO采用PPO的裁剪代理目标,同时结合KL散度惩罚,既保留了PPO的优点,又避免了价值模型的复杂性和不稳定性。这种设计特别适合大规模训练,使InfoSeeker能够在有限计算资源下实现高效的强化学习。

奖励设计简洁而有效:仅当格式和提取答案都正确时给予奖励。这种二元奖励设计提供了清晰的优化信号,避免了过度复杂化奖励函数可能导致的优化方向模糊问题。技术报告强调,这种"相对直接的奖励"足以引导模型优化,因为模型在SFT阶段已具备基本能力,RL阶段主要聚焦于强化推理和精确查询能力。

训练策略上,InfoSeeker从SFT检查点开始RL训练,专注于强化模型的推理和精确查询能力。特别地,在第二轮训练中,系统从原始55K数据池中选择17K更难样本,进一步提升模型能力。这种针对性强化使InfoSeeker-3B能够在复杂任务上实现性能飞跃,甚至超越参数量大10倍的模型。

元信息:通往更高级优化的桥梁

InfoSeek的一个战略优势是其保留了中间步骤和检索标签等元信息。这些元信息不仅是训练数据,更是通往更高级优化的桥梁,为未来研究提供了丰富可能性。

支持复合奖励设计是元信息的首要价值。传统强化学习通常只关注最终答案的正确性,而忽略了中间步骤的质量。通过利用InfoSeek保留的中间步骤信息,研究者可以设计更精细的奖励函数,例如基于证据质量、推理步骤合理性的奖励,从而更全面地优化模型能力。

实现轨迹级探索是元信息的另一重要应用。传统方法通常优化单步决策,而忽略了整个推理路径的质量。元信息使研究者能够评估和优化完整的推理轨迹,确保模型不仅在最终答案上表现良好,还在整个推理过程中保持逻辑一致性和证据可靠性。

更为深远的是,这些元信息为未来高级优化策略提供了基础。例如,可以基于证据质量动态调整权重,或在训练中引入对抗性验证来检测推理漏洞。技术报告指出,InfoSeek不仅是一个静态数据集,而是一个"可进化的研究平台"。随着研究深入,这些元信息将释放更大价值,推动深度研究能力的持续提升。

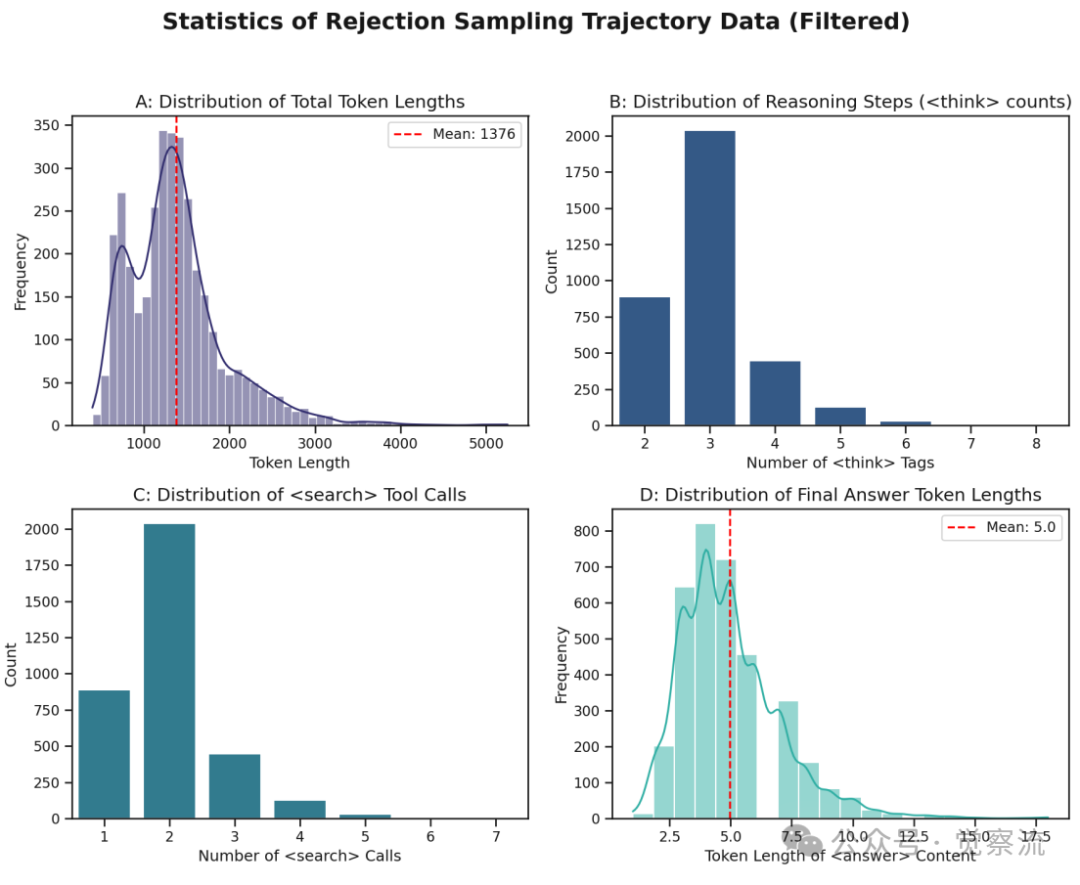

SFT轨迹数据统计

上图展示了SFT轨迹数据的统计特征,揭示了高质量轨迹的关键属性:成功轨迹通常具有更长的搜索步骤、更精细的任务分解和更准确的逐步推理。这一发现不仅验证了InfoSeek数据质量的有效性,还为未来优化提供了明确方向——强化这些关键特征将有助于进一步提升模型性能。

实验验证:数据质量决定模型上限

核心证据:数据集对比实验

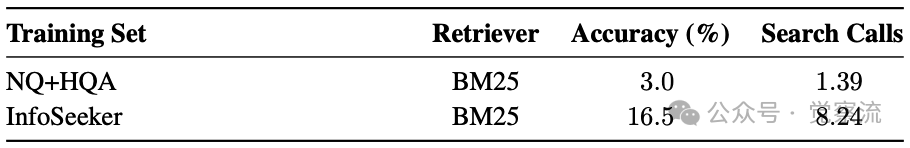

不同训练数据集性能对比

上表的实验结果提供了最直接的证据:使用InfoSeek训练的模型在BrowseComp-Plus基准上达到16.5%的准确率,而使用NQ+HQA训练的模型仅有3.0%。这一5.5倍的性能差距,直接证明了InfoSeek数据质量的决定性作用。

深入分析表明,NQ+HQA数据缺乏层次化结构,无法培养真正的深度研究能力。这些数据集中的问题大多可以通过简单的线性推理或并行约束解决,而无需真正的层次化推理。相比之下,InfoSeek数据强制模型遍历完整层次,培养系统化分解问题和整合多源证据的能力。

这一结果验证了一个核心论点:数据质量决定模型上限。即使使用相同的模型架构和训练方法,高质量数据也能带来质的飞跃。InfoSeeker-3B的成功表明,通过精心设计的数据合成方法,我们可以系统性地培养模型的深度研究能力,而不仅仅是依靠模型规模的扩大。

全面领先:传统基准的泛化能力

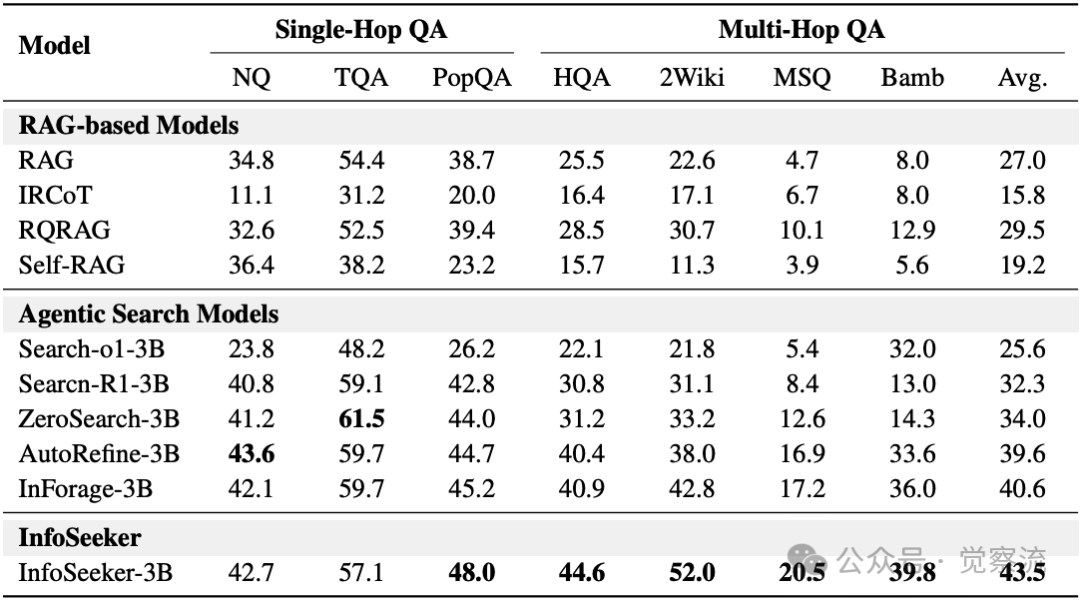

单跳与多跳QA基准性能比较

上表展示了InfoSeeker-3B在多个基准上的全面优势。在单跳和多跳QA基准上,InfoSeeker-3B均在所有基线模型中表现最佳,包括基于检索增强生成(RAG)的方法和近期的智能体搜索方法。

在单跳任务上,InfoSeeker-3B在Natural Questions(NQ)、TriviaQA(TQA)和PopQA基准上达到或接近最佳结果,证明了其基础事实检索能力的强大。在多跳任务上,它在HotpotQA(HQA)、2Wiki、Musique(MSQ)和Bamboogle等复杂基准上显著领先,尤其在Bamboogle上达到39.8%的准确率,远超其他3B级模型。

这一全面领先表明,深度研究能力训练不仅提升复杂任务表现,还增强了基础推理能力。高质量结构化数据的泛化效应远超预期,使模型在各类任务上都表现出色。这种能力迁移现象说明,深度研究训练培养的是更通用的推理能力,而非仅限于特定任务的技巧。

成本效益:小模型的崛起

InfoSeeker-3B最令人瞩目的是其成本效益:仅3B参数的模型,通过InfoSeek数据集训练后,性能超越参数量10倍的Qwen3-32B,甚至与Gemini 2.5 Pro等商业大模型性能相当。

这一发现具有深远的行业影响。首先,它证明了"模型小型化"路径的可行性,为资源受限场景提供了高性能解决方案。在边缘计算、移动设备等资源有限的环境中,小型高效模型具有明显优势。其次,它挑战了"更大即更好"的传统认知,将研发重点从单纯扩大模型规模转向优化数据质量和训练方法。最后,它为开源社区提供了与商业模型竞争的可能路径,降低了AI研发的门槛。

技术报告中的数据表明,InfoSeeker-3B在BrowseComp-Plus基准上达到16.5%的准确率,大幅超越Qwen3-32B的3.5%和SearchR1-32B的3.9%。这一结果不仅证明了数据质量的重要性,还展示了小模型通过高质量训练实现性能飞跃的可能性。

数据,新时代的"石油"

InfoSeek的突破性研究成果揭示了一个核心认知:在大型语言模型时代,高质量、结构化的数据比单纯的模型规模更为重要。正如技术报告所言,InfoSeek不仅是一个数据集,更是"实现高质量数据集构建的方法论,具有对结构复杂性的明确控制和原则性可扩展性"。

其开源价值尤为突出:InfoSeek完全开源(代码、数据、框架),为社区提供了"挖掘数据金矿的工具",实现了"便捷且可扩展的数据集构建"。这种开放性将加速深度研究能力的普及,推动整个领域向前发展。通过InfoSeek,研究者可以系统性地生成具有可控复杂度的深度研究问题,为模型训练提供高质量信号。

层次化约束满足问题(HCSP)框架有望引领深度研究任务的新标准,数据合成技术将成为AI研究的核心竞争力。谁能够更好地设计和合成数据,谁就能在AI竞赛中占据先机。InfoSeek标志着AI研究正从"模型驱动"向"数据驱动"的范式转变,而这一转变才刚刚开始。

在这个数据为王的时代,InfoSeek告诉我们:真正的炼金术不在于点石成金,而在于从海量信息中提炼出结构化知识,让小模型也能释放大智慧。深度研究能力将成为下一代AI系统的核心特征,而InfoSeek所开创的数据合成方法,将成为这一变革的关键推动力。

数据,正成为新时代的"石油"。而InfoSeek,则为我们提供了开采这一宝贵资源的先进工具。需要更进一步了解这个研究和项目的同学,可以移步到下放的参考资料中,有论文、有开源仓库、还有 infoseek 的开源数据集。