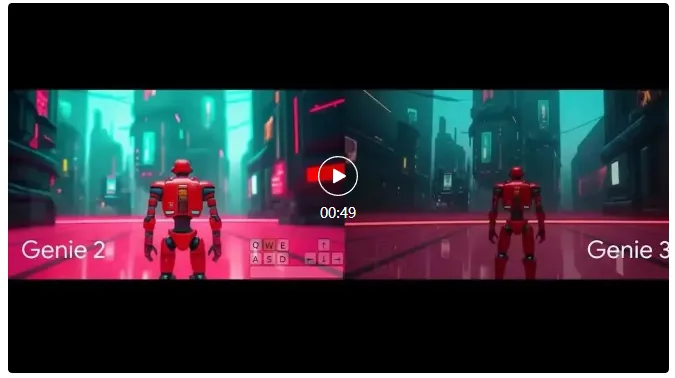

昨天,Google Deepmind推出新一代AI系统Genie 3,能够根据简单文本生成实时互动的3D虚拟世界。这一模型不仅能构建世界,还能让用户以每秒24帧、720p分辨率的画质在其中自由探索。

与传统视频生成不同,Genie 3采用自回归方式逐帧生成画面,每一帧都会参考多达一分钟内的环境细节。

这种方法显著提升了视觉连续性,生成的世界在交互过程中能够在数分钟内保持物理和视觉一致性。

Deepmind表示,这是首个同时实现实时交互与物理连续性的AI世界模型,为发展通用人工智能(AGI)打下了基础。

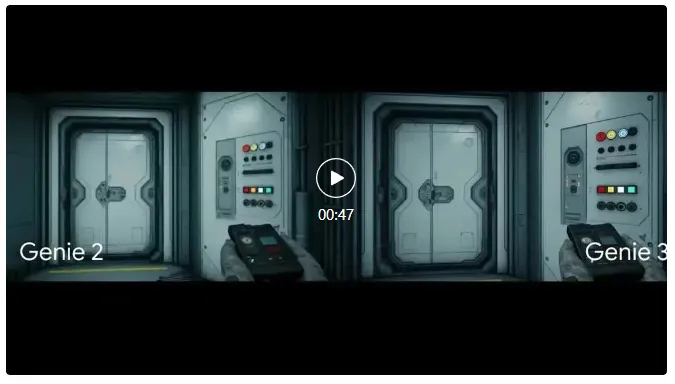

Genie 3是继Genie 1、Genie 2,以及视频生成器Veo系列之后的又一重要进展。

Deepmind希望将其发展为“基础世界模型”(Foundation World Model),为更高级的智能体系统提供训练平台。

1.AI世界的可塑性与开放性

用户仅需输入文字提示,就能在Genie 3中生成如“火山喷发”“飞行岛屿”或“史前遗迹”等复杂场景。

这些提示不仅能改变场景天气、召唤新物体,还能制造各种“反事实情境”,测试AI智能体在突发情况下的反应。

在一个演示中,镜头从多个角度移动,画面左侧的树木在0:00、0:20和0:40秒的时间节点始终如一,清晰展现出环境的稳定性。

Genie 3的独特之处在于,它无需任何预设3D模型或数据,只需文字描述即可构建出稳定世界。

这与NeRF或Gaussian Splatting等依赖已有数据的技术不同,意味着它可以构建更开放、动态的训练环境。

Deepmind的SIM智能体(SIMA)已经在这些虚拟世界中进行测试,系统对智能体的目标一无所知,仅对其动作做出反应。

这种设置让研究人员能够更真实地模拟AI执行复杂任务的过程,并探索其潜在弱点。

2.从AI研究到游戏引擎的未来

Deepmind称Genie 3目前处于有限研究预览阶段,仅向部分研究人员和创作者开放。

这一做法旨在提前识别风险,为后续发展提供参考。

尽管Genie 3还有一些技术限制,例如交互时长有限、多智能体互动尚不成熟、现实地理位置无法定位等,但它已展示出巨大的潜力。

未来,这一模型可用于教育、模拟训练、专家决策支持等领域,尤其适合复杂情境下的预演和演练。

Deepmind CEO Demis Hassabis曾表示,世界模型是实现AGI的关键,因为它们能让AI在无限多样的模拟环境中自主学习。

这一理念也得到AI研究者Richard Sutton和David Silver的支持,他们认为AI的未来应从静态数据转向基于自身经验的学习过程。

而Genie 3,正是这一理念的具象体现。

NVIDIA AI总监Jim Fan认为,Genie 3代表着“游戏引擎2.0”的雏形。

他预测,未来的游戏开发将不再依赖复杂的3D素材与场景图,而由数据驱动的AI模型直接生成可交互空间。

开发者只需通过提示语进行操作,无需理解图形学、着色器或场景管理等技术细节。

“这将是游戏开发的终局(The End Game),”Jim Fan写道,“全部由提示工程驱动,一切由数据决定,复杂性交由AI处理。”

正如语言模型改变了写作方式,Genie 3有望改变游戏的开发方式,乃至整个虚拟世界的创造范式。

Genie 3不仅是一个AI模型,它是Deepmind对未来世界的实验室。

通过它,我们看见了一种可能:人类以语言建造世界,AI在世界中学习行为。