强化学习

从探索到验证:Parallel-R1 如何塑造大模型的"思考"哲学

大家好,我是肆〇柒。 今天看看由腾讯AI Lab Seattle联合马里兰大学、北卡罗来纳大学、香港城市大学和圣路易斯华盛顿大学共同研究的工作——Parallel-R1,它首次通过强化学习让大语言模型真正掌握了"并行思考"这一人类高级认知能力,而非仅依赖推理时策略的临时拼凑。 这项研究不仅刷新了AIME25数学竞赛基准测试的准确率记录,更揭示了机器"思考"方式的演化规律。

9/28/2025 9:00:00 AM

肆零柒

AI正在偷走白领工作!OpenAI狂砸10亿教AI上班,你的完美继任者即将上岗

AI正在接管白领工作吗? 今年5月,Anthropic CEO Dario Amodei曾表示:AI有可能在未来1—5年内消灭一半的入门级白领职位,并使美国失业率上涨到10—20%。 这场史无前例的岗位大替代,引发了普遍担忧。

9/25/2025 3:23:44 PM

加速近5倍!北大与字节团队提出BranchGRPO,用「树形分叉 + 剪枝」重塑扩散模型对齐

快分叉与稳收敛在扩散 / 流匹配模型的人类偏好对齐中,实现高效采样与稳定优化的统一,一直是一个重大挑战。 近期,北京大学与字节团队提出了名为 BranchGRPO 的新型树形强化学习方法。 不同于顺序展开的 DanceGRPO,BranchGRPO 通过在扩散反演过程中引入分叉(branching)与剪枝(pruning),让多个轨迹共享前缀、在中间步骤分裂,并通过逐层奖励融合实现稠密反馈。

9/22/2025 3:45:00 PM

机器之心

统一视角下的HPT:动态融合SFT与RL,释放LLM后训练新潜能

大家好,我是肆〇柒。 今天探索一篇来自清华大学、上海AI实验室与微信AI团队的前沿研究。 这篇论文提出了一种名为HPT的创新算法,它像一位“智能教练”,能根据模型的实时表现,动态决定是该用监督学习“补基础”,还是用强化学习“练推理”,从而解决后训练中SFT与RL难以调和的矛盾,让模型性能实现质的飞跃。

9/16/2025 10:09:00 AM

肆零柒

清华、上海AI Lab等顶级团队发布推理模型RL超全综述,探索通往超级智能之路

超高规格团队,重新审视RL推理领域发展策略。 在人工智能的发展中,强化学习 (RL) 一直是一种非常重要的方法。 自 1998 年 Sutton 提出强化学习概念以来,就明确了只要给出明确的奖励信号,智能体就能学会在复杂环境中超越人类。

9/13/2025 6:20:00 PM

机器之心

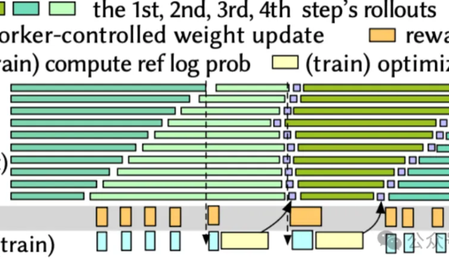

攻克强化学习「最慢一环」!交大字节联手,RL训练速度飙升2.6倍

强化学习的训练效率,实在是太低了! 随着DeepSeek、GPT-4o、Gemini等模型的激烈角逐,大模型“深度思考”能力的背后,强化学习(RL)无疑是那把最关键的密钥。 然而,这场竞赛的背后,一个巨大的瓶颈正悄然限制着所有玩家的速度——相较于预训练和推理,RL训练更像一个效率低下的“手工作坊”,投入巨大但产出缓慢。

9/13/2025 4:45:23 PM

鹭羽

从"调用工具"到"思考策略":Chain-of-Agents实现智能体技术的临界点突破

大家好,我是肆零柒。 今天,我们一起来了解一篇由OPPO AI Agent Team研究的论文。 这项工作名为Chain-of-Agents(CoA),它不只是一个新的AI框架,更是一次对"智能体"本质的深刻探索。

9/5/2025 9:00:43 AM

肆零柒

Prime Intellect 推出开放平台“环境中心”,对抗AI强化学习领域的封闭趋势

位于旧金山的人工智能初创公司 Prime Intellect 正式发布“环境中心”(Environments Hub),这是一个用于构建和共享强化学习(RL)环境的开放平台,旨在对抗当前由大型人工智能实验室主导的封闭生态。 Prime Intellect 指出,交互式训练环境已成为下一阶段 AI 发展的关键瓶颈。 在强化学习中,AI 代理通过与规则驱动的环境互动来学习,仅在面对动态变化时才能实现真正的智能。

9/2/2025 10:37:12 AM

AI在线

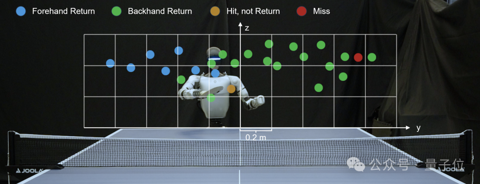

首个为具身智能而生的大规模强化学习框架RLinf!清华、北京中关村学院、无问芯穹等重磅开源

清华大学、北京中关村学院、无问芯穹联合北大、伯克利等机构重磅开源RLinf:首个面向具身智能的“渲训推一体化”大规模强化学习框架。 人工智能正在经历从 “感知” 到 “行动” 的跨越式发展,融合大模型的具身智能被认为是人工智能的下一发展阶段,成为学术界与工业界共同关注的话题。 在大模型领域,随着 o1/R1 系列推理模型的发布,模型训练的重心逐渐从数据驱动的预训练 / 后训练转向奖励驱动的强化学习(Reinforcement Learning, RL)。

9/1/2025 11:41:00 AM

机器之心

Meta万引强化学习大佬跑路!用小扎原话作为离别寄语,扎心了

小扎在这头疯狂挖人,结果家里的老员工纷纷跑路了? ? 最新消息,Meta万引强化学习大佬Rishabh Agarwal即将离职,还留下了一篇让人浮想联翩的小作文:这是我在Meta的最后一周。

8/27/2025 9:05:00 AM

突破Agent长程推理效率瓶颈!MIT&NUS联合推出强化学习新训练方法

AI Agent正在被要求处理越来越多复杂的任务。 但当它要不停地查资料、跳页面、筛选信息时,显存狂飙、算力吃紧的问题就来了。 针对这一难题,MIT和新加坡国立大学联合提出了MEM1框架。

8/22/2025 4:35:00 PM

时令

微软Agent Lightning:零代码接入RL,“解耦”任何AI Agent学会“在实践中学习”

大家好,我是肆〇柒。 我从工程落地角度出发,看到一篇很有意思的研究想要分享出来。 这是一项来自微软研究团队的研究工作——Agent Lightning。

8/22/2025 9:56:18 AM

肆零柒

突破Agent长程推理效率瓶颈!MIT&新加坡国立联合推出强化学习新训练方法

AI Agent正在被要求处理越来越多复杂的任务。 但当它要不停地查资料、跳页面、筛选信息时,显存狂飙、算力吃紧的问题就来了。 针对这一难题,MIT和新加坡国立大学联合提出了MEM1框架。

8/21/2025 9:10:00 AM

如何训练你的大型语言模型

打造一个听起来很智能的大型语言模型 (LLM) 助手,就像在反复塑造泥塑一样。 你从一块泥土开始,把它挤压成一个可行的结构,然后开始精雕细琢,直到最终成品。 越接近最终成品,那些精妙的点缀就越重要,正是这些点缀决定了最终成品是杰作还是恐怖谷效应。

8/19/2025 10:10:46 AM

晓晓

混合数学编程逻辑数据,一次性提升AI多领域强化学习能力 | 上海AI Lab

近年来,AI大模型在数学计算、逻辑推理和代码生成领域的推理能力取得了显著突破。 特别是DeepSeek-R1等先进模型的出现,可验证强化学习(RLVR)技术展现出强大的性能提升潜力。 然而,现有关于强化学习和模型的研究多聚焦于单一领域优化,缺乏对跨领域知识迁移和协同推理能力的系统性探索,让模型能够在多领域协同工作,发挥更好的推理能力。

8/15/2025 9:00:00 AM

冗长响应缩减80%,DeepSeek GRPO获得颠覆性改进,微软GFPO问世

用过 DeepSeek-R1 等推理模型的人,大概都遇到过这种情况:一个稍微棘手的问题,模型像陷入沉思一样长篇大论地推下去,耗时耗算力,结果却未必靠谱。 现在,我们或许有了解决方案。 这两天,微软研究员 Dimitris Papailiopoulos 在 𝕏 上曝出一个新成果:Group Filtered Policy Optimization(GFPO)—— 一种颠覆性的强化学习算法。

8/14/2025 1:18:00 PM

机器之心

研究者警告:强化学习暗藏「策略悬崖」危机,AI对齐的根本性挑战浮现

本文作者为徐兴成博士,任上海人工智能实验室青年研究员,北京大学与英国牛津大学联合培养数学博士,上海市启明星项目(扬帆专项)获得者。 研究方向:大模型后训练、强化学习与基础理论研究。 强化学习(RL)是锻造当今顶尖大模型(如 OpenAI o 系列、DeepSeek-R1、Gemini 2.5、Grok 4、GPT-5)推理能力与对齐的核心 “武器”,但它也像一把双刃剑,常常导致模型行为脆弱、风格突变,甚至出现 “欺骗性对齐”、“失控” 等危险倾向。

8/13/2025 1:01:00 PM

机器之心

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

马斯克

英伟达

Anthropic

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

Sora

研究

百度

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

AI模型

特斯拉

场景

深度学习

亚马逊

架构

Transformer

MCP

Copilot

编程

视觉