模型压缩

模型压缩技术揭秘:量化、剪枝、蒸馏三大法宝

核心内容1. 模型量化的原理与方法:降低参数精度,减少存储与计算成本2. 模型剪枝的技术分类:结构化与非结构化剪枝的优缺点对比3.

10/15/2025 1:15:00 AM

大西瓜

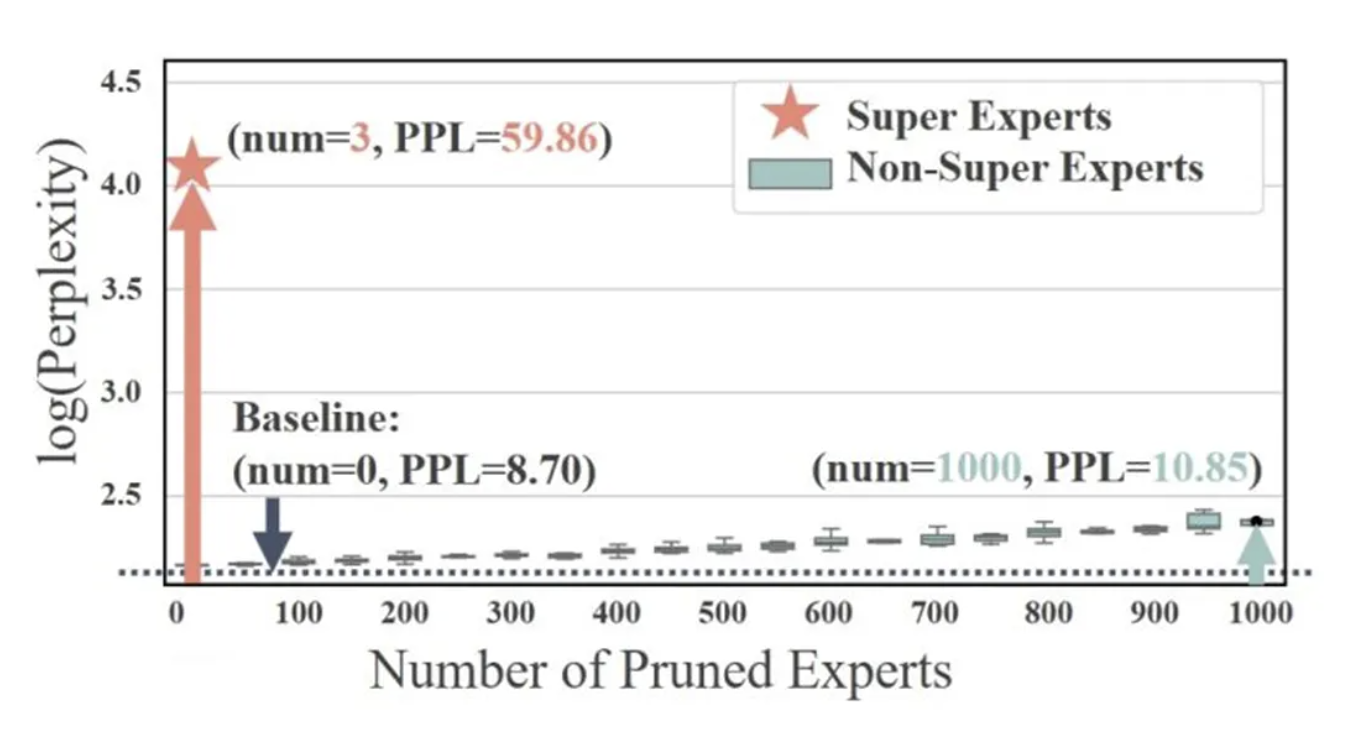

Attention Sink产生的起点?清华&美团首次揭秘MoE LLM中的超级专家机制

稀疏激活的混合专家模型(MoE)通过动态路由和稀疏激活机制,极大提升了大语言模型(LLM)的学习能力,展现出显著的潜力。 基于这一架构,涌现出了如 DeepSeek、Qwen 等先进的 MoE LLM。 然而,随着模型参数的迅速膨胀,如何高效部署和推理成了新的挑战。

8/11/2025 2:46:00 PM

机器之心

终于把深度学习中的模型压缩搞懂了!

今天给大家分享几种常见的模型压缩技术。 在深度学习中,模型压缩是减少模型大小、降低计算复杂度,同时尽可能保持模型性能的一类技术。 它在移动端、嵌入式设备和边缘计算等资源受限的环境中尤其重要。

2/17/2025 1:09:59 PM

程序员小寒

提升人工智能性能的三种关键的LLM压缩策略

译者 | 布加迪审校 | 重楼在当今快节奏的数字环境中,依赖人工智能的企业面临着新的挑战:运行人工智能模型的延迟、内存使用和计算能力成本。 随着人工智能快速发展,幕后推动这些创新的模型变得越来越复杂、资源密集。 虽然这些大模型在处理各种任务中取得了出色的性能,但它们通常伴随着很高的计算和内存需求。

11/19/2024 8:08:16 AM

布加迪

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

大模型

机器人

数据

Midjourney

AI新词

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

马斯克

Gemini

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

AI for Science

Agent

苹果

Claude

芯片

腾讯

Stable Diffusion

蛋白质

开发者

xAI

具身智能

生成式

神经网络

机器学习

3D

RAG

AI视频

人形机器人

研究

大语言模型

百度

生成

Sora

GPU

工具

华为

计算

字节跳动

AI设计

AGI

大型语言模型

搜索

视频生成

生成式AI

场景

DeepMind

深度学习

AI模型

特斯拉

架构

MCP

亚马逊

Transformer

编程

视觉

预测