DeepEP

DeepSeek公开致谢腾讯技术团队 助力DeepSeek通信框架提速100%

DeepSeek近日发文公开致谢腾讯技术团队,称其对DeepSeek开源通信框架DeepEP的优化是一项“huge speedup”级别的代码贡献。 此次优化聚焦于在多种网络环境下提升通信性能。 经测试,优化后的DeepEP在RoCE网络环境下性能提升高达100%,在IB(InfiniBand)网络环境下提升约30%,显著增强了通信效率,为AI大模型训练提供了更稳定、高效的底层支撑。

5/8/2025 10:00:55 AM

AI在线

DeepSeek 致谢腾讯技术团队,DeepEP 开源通信框架性能显著提升

经测试,优化后的通信框架性能在 RoCE 网络环境提升 100%,IB 网络环境提升 30%,为企业开展 AI 大模型训练提供更高效的解决方案。

5/7/2025 7:55:10 PM

汪淼

分析一下EP并行和DeepSeek开源的DeepEP代码

被好几个团队的人追着要渣B来分析一下DeepEP的工作, 公司内外的团队都有...简单的一句话说, 非常棒的工作,很多细节都值得学习. 但是还有一些硬件上的缺陷, 在DeepSeek-V3的论文中提出的建议要结合在一起看就会更清楚了. 我们还是由浅入深来谈谈EP并行, 并进一步分析一下这份出色的工作.

2/27/2025 9:06:34 AM

渣B

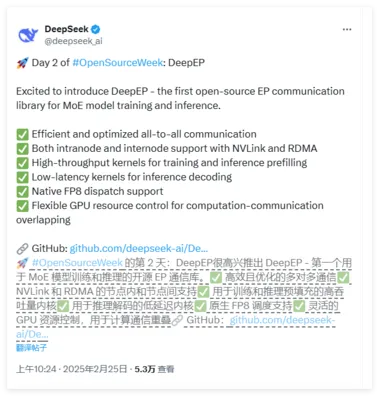

刚刚,DeepSeek开源MoE训练、推理EP通信库DeepEP,真太Open了!

上周五,DeepSeek 发推说本周将是开源周(OpenSourceWeek),并将连续开源五个软件库。 昨天,他们开源了第一个代码库 ——FlashMLA。 这是一款用于 Hopper GPU 的高效型 MLA 解码核,仅用了 24 小时就达到了接近 8k 的 star 量(详情请参见《刚刚,DeepSeek 开源 FlashMLA,推理加速核心技术,Star 量飞涨中》)。

2/25/2025 11:39:00 AM

机器之心

DeepSeek开源周第二日:首个面向MoE模型的开源EP通信库

Deepseek 公布了开源周第二天的产品,首个面向MoE模型的开源EP通信库,支持实现了混合专家模型训练推理的全栈优化。 DeepEP 是一个专为混合专家(MoE)和专家并行(EP)设计的高效通信库。 它致力于提供高吞吐量和低延迟的多对多 GPU 内核,通常被称为 MoE 调度和组合。

2/25/2025 11:02:00 AM

AI在线

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

视觉

Copilot