CoPE

解决Transformer根本缺陷,CoPE论文爆火:所有大模型都能获得巨大改进

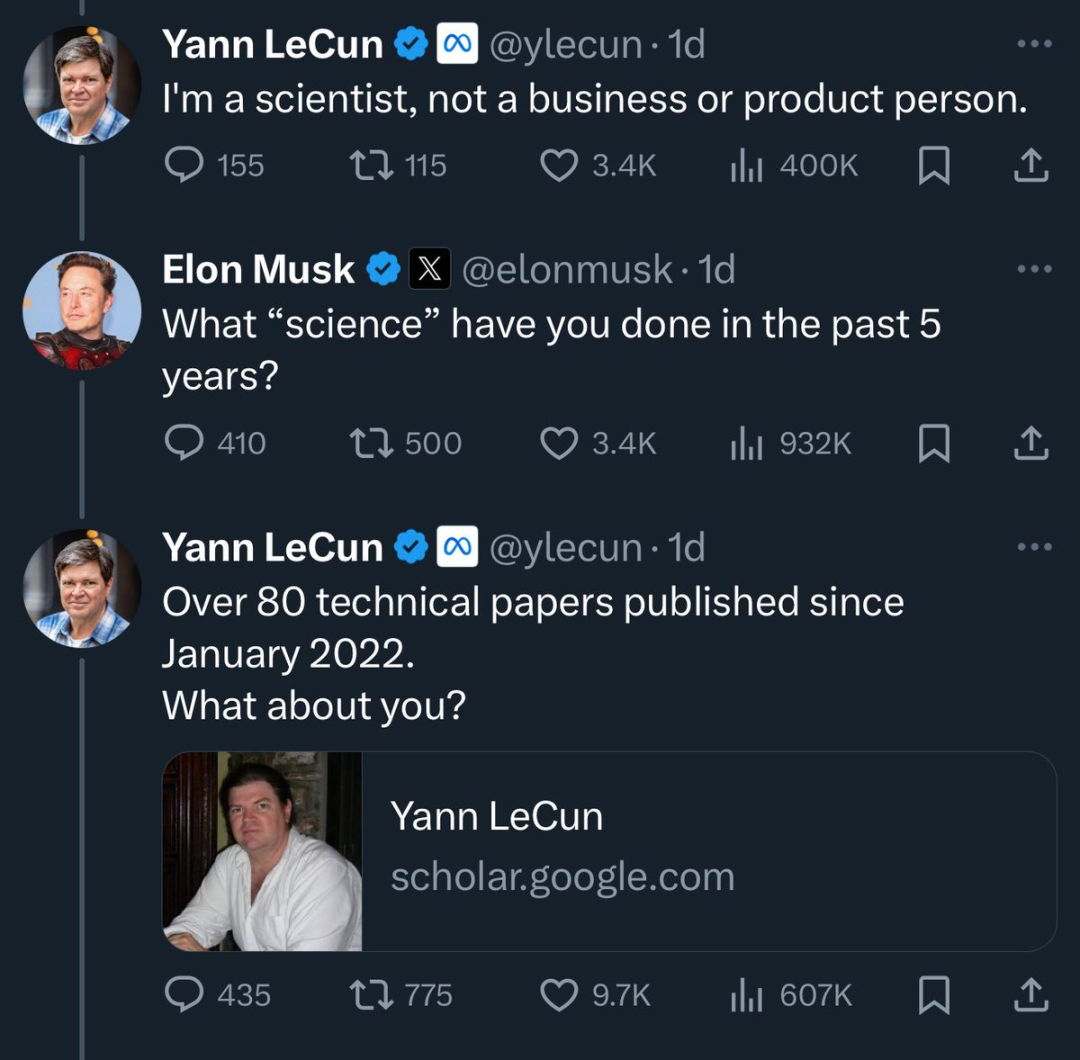

即使最强大的 LLM 也难以通过 token 索引来关注句子等概念,现在有办法了。最近两天,马斯克和 LeCun 的口水战妥妥成为大家的看点。这两位 AI 圈的名人你来我往,在推特(现为 X)上相互拆对方台。LeCun 在宣传自家最新论文时,也不忘手动 @ 一把马斯克,并意味深长地嘱咐道:「马斯克,我们这项研究用来改善你家的 Grok 也没问题。」LeCun 宣传的这篇论文题目为《 Contextual Position Encoding: Learning to Count What’s Important 》,

5/31/2024 3:28:00 PM

机器之心

- 1

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

DeepSeek

谷歌

AI绘画

数据

机器人

大模型

Midjourney

开源

Meta

智能

用户

微软

GPT

学习

AI新词

技术

智能体

马斯克

Gemini

图像

AI创作

英伟达

Anthropic

训练

论文

代码

LLM

算法

Stable Diffusion

芯片

腾讯

苹果

AI for Science

Claude

蛋白质

Agent

开发者

生成式

神经网络

xAI

机器学习

3D

研究

人形机器人

生成

AI视频

百度

工具

计算

RAG

大语言模型

GPU

华为

Sora

具身智能

AI设计

字节跳动

搜索

大型语言模型

AGI

场景

深度学习

视频生成

预测

视觉

架构

伟达

Transformer

DeepMind

编程

神器推荐

AI模型

亚马逊

特斯拉