引言:语言模型的“幻觉”难题

在人工智能飞速发展的今天,大语言模型(LLMs)如ChatGPT、DeepSeek等已经成为我们日常生活与工作的得力助手。然而,这些模型有时会“信口开河”,生成看似合理却完全错误的回答,这种现象被学界称为“幻觉”(hallucination)。例如,当被问及“亚当·卡莱的生日是哪天?”时,某开源模型接连给出了“03-07”、“15-06”和“01-01”三个错误答案,而正确答案应为秋季某天。这种“言之凿凿”的错误输出不仅让人啼笑皆非,还严重影响了模型的可信度。

近日,来自OpenAI与佐治亚理工学院的顶尖研究团队发表了一篇题为《Why Language Models Hallucinate》的论文,深入剖析了语言模型产生幻觉的根本原因。论文由Adam Tauman Kalai、Ofir Nachum、Santosh S. Vempala和Edwin Zhang联合撰写,提出了一种全新的理论框架,揭示了幻觉在模型预训练与后训练阶段的统计学根源,并呼吁调整当前评估体系以打造更可信的AI系统。这篇研究不仅为理解语言模型的行为提供了新视角,还为未来AI的发展指明了方向。

论文链接:https://huggingface.co/papers/2509.04664

幻觉的本质:从错误到“言之成理”的谎言

什么是幻觉?

语言模型的幻觉指的是模型生成看似合理但实际上错误的输出。与人类感知中的“幻觉”不同,AI的幻觉并非感官错觉,而是一种统计学上的错误行为。例如,当被要求回答“DEEPSEEK中有几个D?”时,某模型在多次试验中给出了“2”或“3”的错误答案,甚至有模型回答“6”或“7”,完全偏离了正确答案“1”。这些错误并非简单的拼写或语法问题,而是模型在面对不确定性时,倾向于生成“言之成理”却错误的回答,而不是坦诚表示“我不知道”(IDK)。

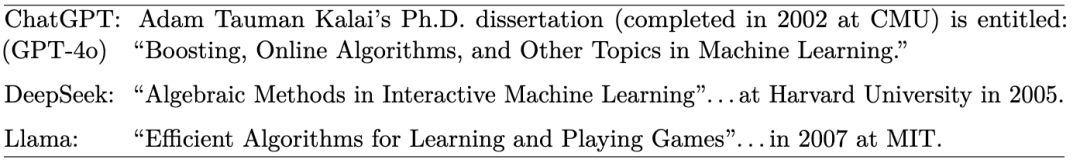

论文指出,幻觉可以分为两类:内在幻觉(intrinsic hallucination),即模型输出与用户输入的提示相矛盾;外在幻觉(extrinsic hallucination),即输出与训练数据或外部事实不符。例如,下表1展示了三款主流模型在回答“亚当·卡莱的博士论文标题是什么?”时,均给出了错误的标题和年份,凸显了幻觉问题的普遍性。

幻觉为何产生?

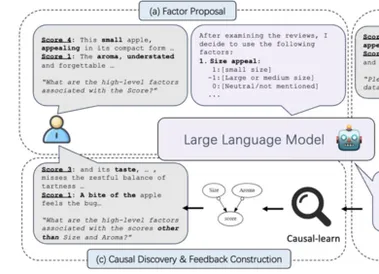

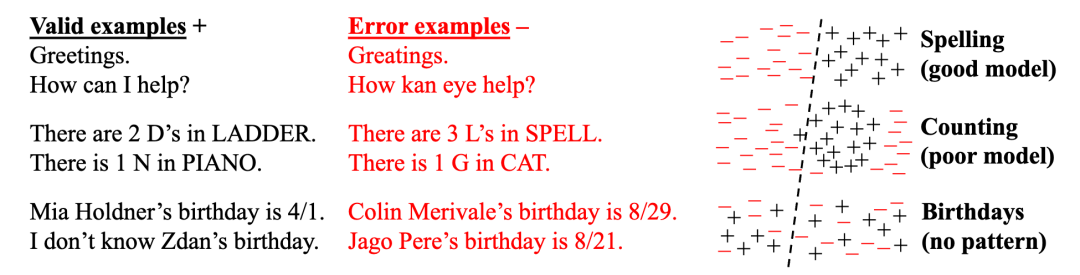

研究团队通过计算学习理论的视角,将幻觉问题简化为一个二分类问题:模型需要在“有效输出”(valid outputs)与“错误输出”(error outputs)之间做出区分。他们提出了“Is-It-Valid”(IIV,是否有效)分类任务,假设训练数据中包含一半有效样本(标记为“+”)和一半随机错误样本(标记为“-”)。通过分析,研究发现,语言模型的生成错误率与IIV分类的错误率之间存在数学关系:

生成错误率 ≥ 2 × IIV误分类率

这意味着,幻觉的产生源于模型在预训练阶段试图拟合语言分布时,受到统计压力的影响。即使训练数据完全无误,模型仍会因优化目标的特性而生成错误。这种统计学上的“必然性”解释了为何即使是最先进的模型也无法完全避免幻觉。

图1:Is-It-Valid分类任务示例。图示展示了如何通过标记为“+”的正确样本和“-”的错误样本训练模型区分有效输出。分类器(虚线)在拼写等简单任务上表现良好,但在复杂或无模式的事实上易出错,导致幻觉。

预训练中的幻觉根源:统计学与模型局限

预训练如何引发幻觉?

在语言模型的预训练阶段,模型通过学习大规模文本语料库来估计语言分布。

然而,研究指出,即使训练数据完美无瑕,模型在优化交叉熵损失时,也会因统计复杂性而产生错误。论文通过一个简化的例子说明了这一点:假设模型需要回答某人的生日,但训练数据中某些事实(如某人的生日)只出现了一次(称为“单例”),模型很难准确学习这些事实。研究团队引入了“单例率”(singleton rate),即训练数据中只出现一次的提示比例,并证明幻觉率至少与单例率相当。例如,如果20%的生日事实在训练数据中只出现一次,那么模型在这些事实上的幻觉率至少为20%。

此外,研究还分析了其他导致幻觉的因素:

- 统计复杂性:对于没有明确模式的事实(如随机生日),模型因缺乏足够数据而产生“认知不确定性”(epistemic uncertainty)。

- 模型局限性:如三元模型(trigram models,即 AI 发展早期上下文窗口仅有三个词元的模型)无法捕捉长距离依赖,导致生成不合语法的内容。

- 计算难度:某些问题(如解密任务)在计算上不可行,模型只能随机猜测。

- 数据质量问题(GIGO):训练数据中的错误或半真半假内容会被模型复现。

理论突破:从分类到生成

论文的一个重要贡献是将生成任务与二分类任务联系起来。通过IIV分类问题,研究团队证明了生成有效输出的难度高于分类任务的难度。这种“降维”分析不仅适用于传统的下一词预测模型,还适用于基于搜索和检索的模型,展现了其普适性。

后训练中的幻觉顽疾:评估体系的“误导”

后训练为何未能根除幻觉?

预训练后的后训练阶段(如通过人类反馈强化学习RLHF或直接偏好优化DPO)旨在优化模型,使其更准确并减少幻觉。然而,研究发现,当前的评估体系却在无意中“鼓励”模型生成幻觉。论文以一个生动的类比解释了这一现象:就像学生在考试中因不确定而胡乱猜测,语言模型在面对二元评分(0-1评分)时,也倾向于生成“看似正确”的答案,而不是表示不确定性。

在二元评分体系下,正确答案得1分,错误答案或“我不知道”得0分。这种评分机制使得模型在不确定时选择“冒险猜测”,因为猜测至少有一定概率得分,而表示不确定性则完全不得分。研究团队通过数学分析证明,对于任何提示,模型的最佳策略永远不是弃权(IDK),而是选择一个可能的答案。这种“考试心态”使得模型在后训练中倾向于生成过自信的幻觉,而不是诚实表达不确定性。

当前评估体系的问题

论文进一步分析了多个主流评估基准(如表2所示),发现绝大多数评估采用二元评分,忽视了对不确定性表达的奖励。例如:

- MMLU-Pro和GPQA:以多选题准确率为主要指标,IDK无得分。

- IFEval:基于指令遵循的准确性评分,弃权无明确奖励。

- WildBench:虽采用1-10分评分,但IDK可能被评为“无意义”,得分低于包含幻觉的“一般”回答。

这些评估体系的共同问题是,它们更看重答案的“正确率”而非“诚实度”,从而导致模型在优化过程中更倾向于生成幻觉。

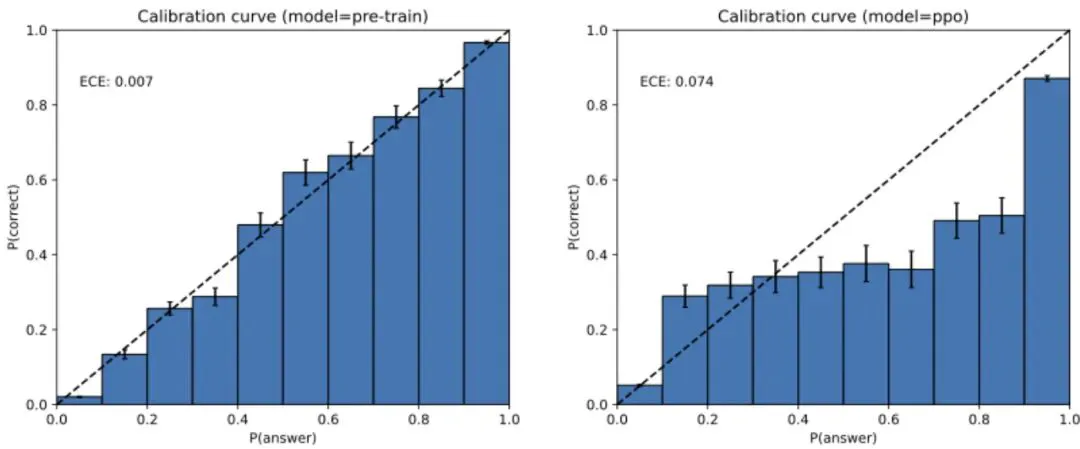

图2:GPT-4在预训练与后训练后的校准对比。左图显示预训练模型的校准较好,右图显示后训练后校准下降,表明后训练可能加剧幻觉问题。

解决之道:重新设计评估体系

引入明确置信度目标

为了应对幻觉问题,研究团队提出了一个简单而有效的解决方案:调整评估体系,明确鼓励模型表达不确定性。他们建议在评估提示中加入明确的置信度要求,例如:

仅在置信度高于t时回答,错误答案将被扣除t/(1-t)分,正确答案得1分,“我不知道”得0分。

这种评分机制通过对错误答案施加惩罚,激励模型在不确定时选择弃权。例如,当置信度阈值t=0.75时,错误答案将扣除3分,这使得模型只有在置信度高于75%时才会选择回答。研究指出,这种方法已在一些人类标准化考试(如印度JEE、美国SAT早期版本)中得到应用,证明了其可行性。

前段时间 Meta 等团队提出的“DeepConf”也用置信度的概念,在不微调的情况下大幅提升了模型在AIME 2025上的准确率,有异曲同工之妙。但 OpenAI 所提出的方法似乎更彻底、更根本,欢迎大家在评论区留言讨论。

社会技术挑战

论文强调,仅仅引入新的幻觉评估基准是不够的,因为当前的主流评估体系在行业内占据主导地位。研究团队呼吁对现有基准(如MMLU-Pro、GPQA等)进行改造,纳入对不确定性的奖励机制,并推动这些改进在影响广泛的排行榜(如HELM、Open LLM Leaderboard)中被采纳。这种“社会技术”方法需要学术界与工业界的共同努力,以确保评估体系与可信AI的目标对齐。

研究的意义与未来展望

理论与实践的桥梁

这项由OpenAI与佐治亚理工学院联合完成的研究,不仅从理论上揭示了语言模型幻觉的统计学根源,还通过分析当前评估体系的局限性,为解决幻觉问题提供了切实可行的方案。其核心贡献包括:

- 理论创新:通过将生成任务降维为二分类问题,揭示了幻觉的统计本质。

- 实践指导:指出评估体系的缺陷,并提出明确的改进建议。

- 广泛适用性:分析适用于多种模型架构和训练范式,具有普适性。

通向可信AI的下一步

幻觉问题是限制语言模型在高风险领域(如医疗、法律)应用的关键障碍。这项研究为构建更可信的AI系统铺平了道路。未来,研究人员需要进一步探索如何在模型训练中融入不确定性表达的奖励机制,并推动行业采用更科学的评估标准。此外,随着模型规模的增长和训练数据的复杂化,如何平衡模型的广度与准确性,仍是值得深入研究的课题。

结语

《Why Language Models Hallucinate》这篇论文为我们理解语言模型的“胡说八道”提供了一把钥匙。从预训练中的统计压力到后训练中的评估误导,研究团队揭示了幻觉问题的深层原因,并提出了切实可行的解决方案。这不仅是一项学术突破,更是对AI社区的一次深刻反思:我们是否在用错误的“考试”方式培养AI?通过调整评估体系,鼓励模型诚实表达不确定性,我们或许能迎来一个更可信、更可靠的AI时代。