资讯列表

刚刚,马斯克开源Grok 2.5:中国公司才是xAI最大对手

就在刚刚,马斯克一手开源动作,引发了大伙儿的高度关注——xAI现在正式开源Grok 2.5,Grok 3将在半年后开源。 其实早在本月初的时候,马斯克就公开表示过:是时候开源Grok了,将会在下周。 虽然开源的时间已经超过了他说的节点,但也正如网友所说:迟到总比没有的好。

8/25/2025 8:54:00 AM

比GPT-5还准?AIME25飙到99.9%刷屏,开源模型首次!

如何让模型在思考时更聪明、更高效,还能对答案有把握? 最近,Meta AI与加州大学圣地亚哥分校的研究团队给出了一个令人振奋的答案——Deep Think with Confidence(DeepConf),让模型自信的深度思考。 论文地址::「置信度筛选」,不仅让模型在国际顶尖数学竞赛AIME 2025上拿下了高达99.9%的正确率。

8/25/2025 8:53:00 AM

诺贝尔物理学成果48年后终获数学证明!中科大少年班尹骏又出现了

诺奖得主都没找到的证明方法,现在被两位华人学者突破了。 凝聚态物理奠基人菲利普·安德森(Philip Warren Anderson)提出的Anderson模型,因解释了半导体材料中电子为何突然不再流动而闻名。 这一成果也助力他获得诺奖。

8/25/2025 8:51:00 AM

运用轻量化大语言模型:实现事件响应加速与幻觉抑制双重突破

墨尔本大学和伦敦帝国理工学院的研究人员开发了一种利用大语言模型(LLM)改进事件响应规划的方法,重点在于降低产生幻觉的风险,该方法采用经过微调的小型大语言模型,并结合检索增强生成技术和决策理论规划。 他们所针对的问题十分常见:目前事件响应在很大程度上仍依赖人工操作,速度缓慢,且依赖专家配置的应急预案。 许多企业需要数周甚至数月才能从事件中完全恢复。

8/25/2025 7:00:00 AM

Mirko Zorz

AI投资终于有回报了!这些大公司用数据证明:AI不是烧钱黑洞

有朋友问我,最近企业界有什么大新闻。 我想了想,可能是一批知名企业终于拿出了硬数据,证明AI投资不仅不是烧钱黑洞,还能带来实实在在的回报。 说实话,过去两年我听了太多"AI投资看不到回报"的抱怨。

8/25/2025 2:00:00 AM

阿丸笔记

零基础也能学!最适合设计师的Flux基础工作流教程讲解(上)

大家好,我是三石。 最近发现大家对 Flux 模型及其 ComfyUI 工作流不太清楚,不知道跟 SDXL、SD1.5 的区别是什么,也不太清楚工作流的基础搭建和 SDXL 这类的工作流的区别,包括后面的 ControlNet 的搭建,感觉晕晕的。 现在我将通过上下两篇文章帮助大家更好地理解 Flux 模型和工作流的搭建,并共安排 8 个典型的工作流搭建方法(上下两篇),如文生图、图生图、放大、遮罩重绘、物品替换、风格迁移等。

8/25/2025 1:42:39 AM

体验设计

记忆增强型Transformer:从神经科学原理到技术解决方案的三维解析

大家好,我是肆〇柒。 当下,Transformer架构已成为自然语言处理、计算机视觉和多模态学习的基石。 然而,随着应用场景的复杂化,标准Transformer暴露出三大关键局限:固定上下文窗口限制了长距离依赖建模静态知识表示阻碍了持续学习能力计算效率远低于生物神经系统这些限制催生了记忆增强型Transformer的研究热潮,而由新加坡国立大学等机构联合发表的系统性综述《Memory-Augmented Transformers: A Systematic Review from Neuroscience Principles to Technical Solutions》为我们提供了一个全面理解这一领域的三维分类框架。

8/25/2025 12:10:00 AM

肆零柒

趋势抢先知!8条值得关注的最新设计资讯

上个月的重大资讯,看这篇就够了! 往期干货:1. 随着iOS26发布,部分设计软件陆续在增加玻璃材质能力.

8/25/2025 12:02:34 AM

ISUX 团队

牛津大学警告:越“温暖”的 AI,越爱胡说八道,温柔体贴=更高错误率

牛津大学的一支研究团队发现,越是表现出温暖和同理心的语言模型,越容易出错,甚至更频繁地重复虚假信息和阴谋论。 这次,研究团队测试了五个不同架构和规模的模型,包括Llama-8B、Mistral-Small、Qwen-32B、Llama-70B和GPT-4o。 研究发现,温暖的模型在推广阴谋论、提供不正确的医疗建议和事实信息方面,表现出更高的错误率。

8/25/2025 12:02:00 AM

用同一组提示词,横向测评30+热门AI绘画平台(上)

前言. 常见的 AI 生图模型大概有以下这些:黑森林的 flux kontext、flux krea、flux dev、flux pro、flux krea、flux1.1,谷歌的 imagen-4、nano-banana,OpenAI 的 Gpt-4o,以及国内的 Dreamina3.1、Qwen3、Wan2.2、星流,还有就是老牌的 Midjourney、Ideogram、即梦、豆包、可灵、海螺等其他平台。 当有设计需求,无论是要出主图还是找创意灵感时,我习惯根据具体使用场景,把提示词放到对应的平台上尝试。

8/25/2025 12:01:35 AM

AI设计师Lena

连烤面包机都能跑的“大模型”!DeepMind 推出超轻量 Gemma 3 270M(≈0.27B)

谷歌 DeepMind 发布了全新的 Gemma 3 270M。 它只有 2.7 亿参数,比七百亿参数级别的大模型轻了约 250 倍,却依旧保持强悍。 DeepMind 并不想拿它硬刚 GPT-4o 或 Gemini Ultra,它生来就为极致高效、本地部署而生。

8/25/2025 12:00:01 AM

马斯克xAI开源Grok 2.5:Grok 3将于半年后开源

近日,埃隆·马斯克在社交平台X上宣布,其人工智能公司xAI已正式开源Grok2.5模型,向公众开放了该模型的源代码。 这一举措是马斯克推动技术开放理念的又一具体实践,也为人工智能领域的发展开辟了新的路径。 马斯克进一步透露,更先进的Grok3模型预计将在未来六个月内同样以开源形式发布。

8/24/2025 11:11:44 PM

AI在线

三十载热爱同行, vivo Vision发布会暨影像盛典盛大举办

8月21日,vivo Vision发布会暨影像盛典于广东东莞隆重举行。 值企业三十周年之际,vivo重磅发布vivo Vision混合现实头显探索版,借助vivo蓝科技整体技术创新能力及在影像、传感器、显示等多方面硬件技术积累,系统性解决MR设备在感知、交互、算力等维度的工程化难题,成为第一家真正以硬件厂商底层能力,构建一整套混合现实体验的中国科技公司,也是国内首家同时布局手机与MR的科技企业,实现内容创作与体验的“生态闭环”。 现场vivo也宣布了影像技术战略及影像文化生态的全新布局,并揭晓了2025 vivo影像加手机摄影大赛最终获奖结果。

8/24/2025 9:26:00 PM

新闻助手

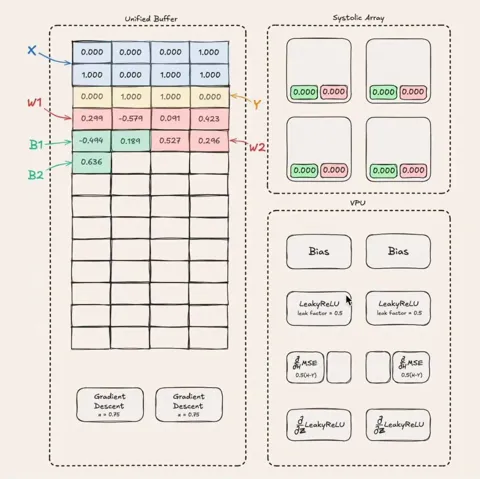

三个月、零基础手搓一块TPU,能推理能训练,还是开源的

最近,大模型技术的发展,让人们再次重视起 AI 专用芯片。 对于计算任务负载来说,越是专用,效率就越高,谷歌的 TPU 就是其中的一个典型例子。 它自 2015 年开始在谷歌数据中心部署后,已经发展到了第 7 代。

8/24/2025 8:21:00 PM

机器之心

超越宇宙极限:第六位海狸数再次突破,无法用常规数学符号表达

当数字逃离人类的想象力:BB (6) 的故事。 现在给你一串数字,你能猜到一下个是多少吗:1、6、21、107,47176870……如果你没头绪,不必气馁。 因为这些数字并不是随意凑出来的,它们就是所谓的 「忙碌海狸数」的前五项。

8/24/2025 8:05:00 PM

机器之心

仅靠5000+样本,全新强化学习范式让30B轻松击败671B的DeepSeek V3

传统强化学习(RL)在有标准答案的指令遵循任务(如数学、代码)上已趋成熟,但在开放式的创意写作领域却因缺乏客观对错而举步维艰。 如何让 RL 突破「可验证奖励」的边界? 蚂蚁技术研究院联合浙江大学开源全新强化学习范式 Rubicon,通过构建业界最大规模的 10,000 条「评分标尺」,成功将强化学习的应用范围拓展至更广阔的主观任务领域。

8/24/2025 7:59:00 PM

机器之心

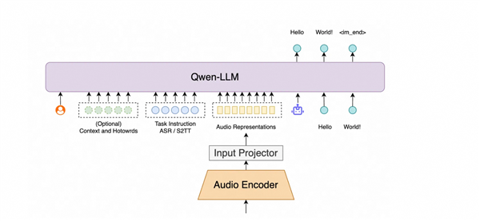

阿里通义Fun-ASR语音模型升级 垂直领域识别率跃升超15%

阿里通义正式推出新一代端到端语音识别大模型Fun-ASR,该模型通过强化上下文感知与高精度转写能力,在家装、保险等垂直行业场景中实现语音识别准确率超15%的突破性提升。 实测数据显示,保险行业准确率较前代提升18%,家装、畜牧等领域增幅达15%-20%。 作为大语言模型驱动的语音识别算法,Fun-ASR采用自研语音算法与Qwen3监督微调技术,结合前沿模型架构与文本模态对齐技术,在保持语言处理优势的同时,集成RAG检索增强方案,支持超1000个自定义热词导入。

8/24/2025 4:02:03 PM

AI在线

老黄刚投了无人配送,复旦校友创办的

老黄出手,为L4独角兽续命。 复旦校友创办的,美国无人配送创业一哥Nuro,刚刚完成了最新一轮融资,筹资2.03亿美元(约合人民币14.6亿元)。 这一轮投资者,既有老股东,也有新资本加入,英伟达赫然在列。

8/24/2025 3:08:44 PM

杰西卡