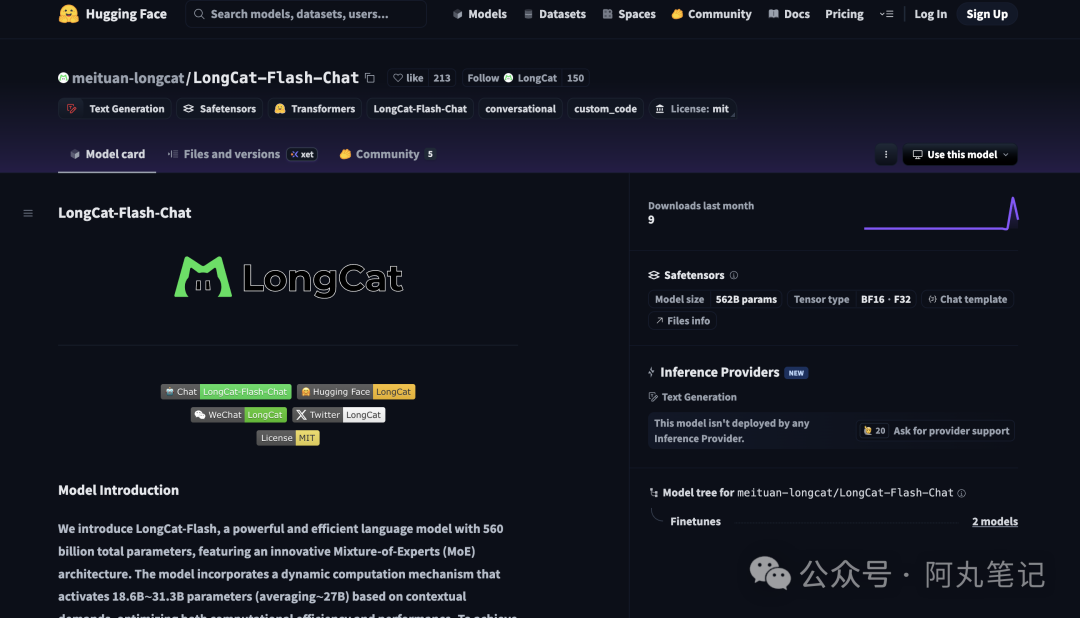

美团正式发布并开源了自己的首个大语言模型——LongCat-Flash-Chat。

说实话,这个消息让我挺意外的。美团,这个我们天天用来点外卖、叫车的平台,突然宣布要在AI大模型领域正面挑战OpenAI、Anthropic这些巨头。更让人意外的是,他们不仅发布了,还直接开源了。

9月1日,美团技术团队正式发布并开源了LongCat-Flash-Chat模型,这标志着美团从AI应用场景的使用者,正式转身成为AI基础技术的贡献者。

图片

图片

技术亮点

LongCat-Flash-Chat最大的技术亮点在于在架构层面引入 “零计算专家(Zero-Computation Experts)” 机制,总参数量 560 B,每个 token 依据上下文需求仅激活 18.6B~31.3 B 参数,实现算力按需分配和高效利用。

为控制总算力消耗,训练过程采用 PID 控制器实时微调专家偏置,将单 token 平均激活量稳定在约 27 B。

此外,LongCat-Flash 在层间铺设跨层通道,使 MoE 的通信和计算能很大程度上并行,极大提高了训练和推理效率。

配合定制化的底层优化,LongCat-Flash 在 30 天内完成高效训练,并在 H800 上实现单用户 100+ tokens/s 的推理速度。LongCat-Flash 还对常用大模型组件和训练方式进行了改进,使用了超参迁移和模型层叠加的方式进行训练,并结合了多项策略保证训练稳定性,使得训练全程高效且顺利。

美团的AI野心:从外卖到通用智能

其实,美团涉足AI大模型并不突然。早在几年前,美团就在内部大量应用AI技术来优化配送路径、提升搜索推荐效果、智能客服等业务场景。

我翻了翻美团技术团队的历年论文,发现他们在机器学习、深度学习领域已经积累了不少技术成果。从搜索推荐算法到配送系统的运筹优化,从计算机视觉到自然语言处理,美团技术团队的研究覆盖面相当广泛。

特别值得注意的是,美团在2022年就开始探索粗排优化的深度学习方法,通过知识蒸馏和对比学习来联动精排与粗排,这些技术积累为今天的大模型研发打下了坚实基础。

不过,从垂直领域的AI应用跨越到通用大语言模型,这中间的技术鸿沟还是很大的。美团选择在这个时点发力,我觉得有几个原因:

• 业务需求驱动 - 美团需要更智能的对话系统来处理复杂的用户咨询

• 技术积累到位 - 多年的AI应用经验让团队具备了做大模型的能力

• 开源生态布局 - 通过开源获得更大的技术影响力和开发者社区

开源策略的深层考量

美团选择开源这个模型,我觉得背后的考量挺有意思的。

首先,开源能够快速建立技术影响力。在AI大模型这个赛道,技术实力的展示比什么宣传都有效。通过开源,美团能够让更多开发者接触和使用他们的技术,形成技术品牌效应。

其次,开源有助于技术迭代。大模型的训练和优化需要海量的反馈数据,开源社区能够提供这样的数据来源。这对美团来说,是一个低成本获得大规模测试的好方法。

最后,也是最现实的一点,美团可能认为在大模型的商业化路径上,API服务比模型本身更有价值。开源模型能够吸引更多开发者,进而为美团的AI基础设施服务导流。

总的来说,美团这次发布LongCat-Flash-Chat,展现了一种务实的技术路线。他们没有盲目追求参数规模或者性能跑分,而是专注于解决实际应用中的效率问题。这种思路在当前的AI发展阶段,可能比追求极致性能更有实用价值。

至于这个模型能否在激烈的竞争中站稳脚跟,我觉得关键还是看后续的迭代速度和生态建设。毕竟在AI这个赛道,技术领先只是第一步,能不能形成可持续的竞争优势,还需要更多时间来验证。