Kimi K2称霸全球开源模型的秘籍公开了!

没错,就是整整32页的Kimi K2官方技术报告。业内人士第一波repo已火速出炉:

这篇论文中有很多令人印象深刻的内容。

nice!它分享了很多关于Kimi(以及中国实验室)对这些模型的看法(他们关注/优化的内容)。

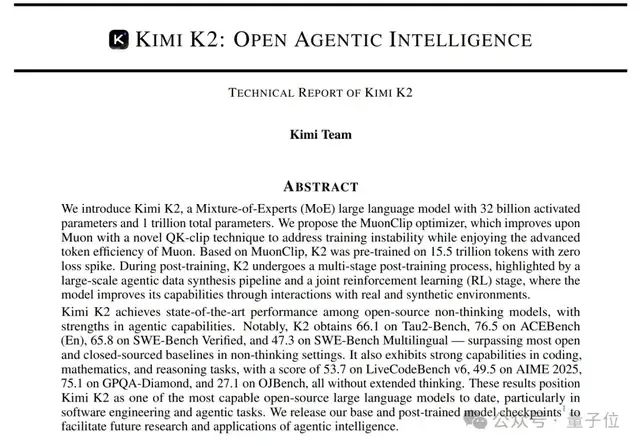

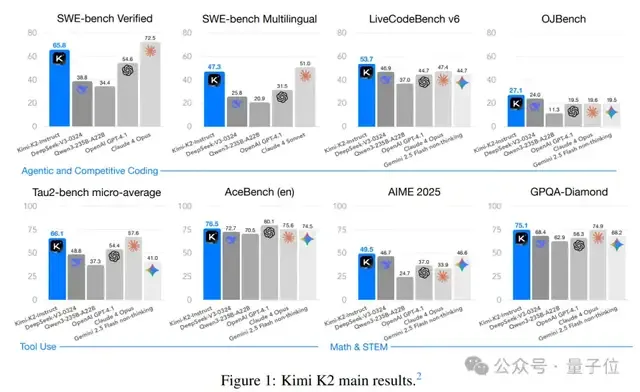

Kimi K2,作为Kimi最新MoE基础模型,总参数1T,激活参数32B,能力领先性尤其展现在代码、Agent、数学推理任务上。

上线仅一周,它就在竞技场千人盲评中击败DeepSeek,登顶全球最强开源模型,而且能媲美Grok 4、GPT 4.5等顶尖闭源模型。

那它是咋做到的呢?

别急,这篇最新论文来给答案了——一次性大公开Kimi K2的训练过程及“秘密配方”。

包括但不限于大家已经热议的:MuonClip优化器、大规模Agentic Tool Use数据合成、通用强化学习等等。

下面详细来看。

首先,Kimi团队认为,现如今大语言模型正从静态模仿学习向Agentic Intelligence转型。

这意味着,模型需要具备在复杂动态环境中自主感知、规划、推理和行动的能力。

要实现这一点,当面人们面临两大挑战:

- 预训练需在高质量数据有限的约束下,通过提升每token效率构建通用先验(universal prior)。

- 后训练需将先验转化为可行动行为,但Agentic能力在自然数据中稀缺且难以规模化。

对此,团队在Kimi K2中采用了三大核心创新技术:

1、MuonClip优化器:抛弃传统的Adam优化器,创新性地使用了Muon优化器。结合Muon的token效率与QK-Clip的稳定性,支持15.5万亿token无损失spike预训练。

2、大规模Agentic Tool Use数据合成:构建可大规模生成多轮工具使用场景的合成pipeline,覆盖数百领域、数千工具。

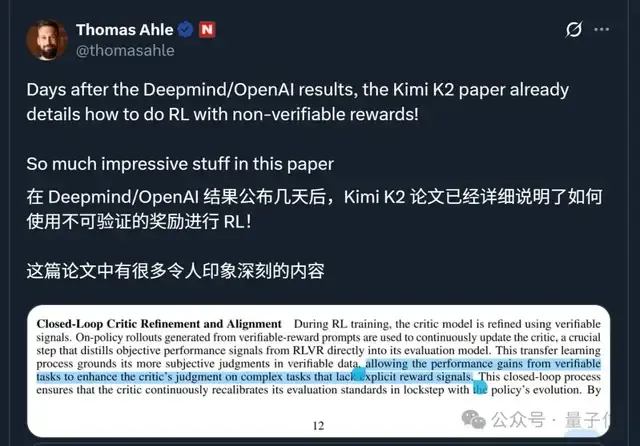

3、通用强化学习框架:结合可验证奖励(RLVR)和自我批判评估奖励,将对齐从静态扩展到开放域。

得益于以上技术,Kimi K2在SWE Bench Verified、Tau2、AceBench等基准性能测试中,均取得开源模型中的SOTA成绩。

以下为技术细节部分:

在Kimi K2预训练阶段,团队主要对优化器和数据进行了优化。

整体而言,其预训练采用了MoE架构+稳定优化器+高效token利用这一全新组合拳,以此构建通用语言和推理能力。

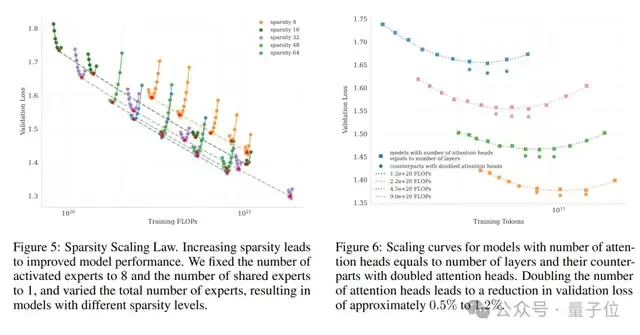

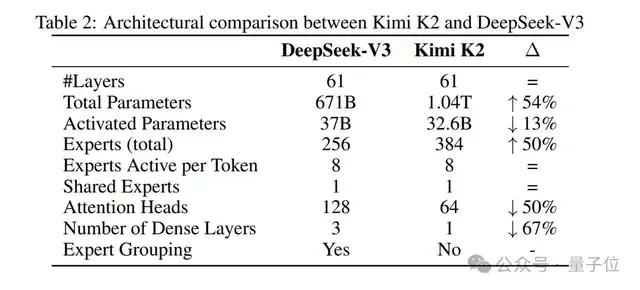

模型架构上,一共包含384个专家,每层激活其中8个,通过这种高度稀疏的设计在保证性能的同时优化计算效率。

在注意力机制上,K2使用MLA(Multi-head Latent Attention)结构代替传统的密集注意力(dense attention),有效减少了计算量和带宽压力。

而且将每层的注意力头数量降至64个,与同类模型相比进一步降低了推理过程中的资源消耗,使模型能更好地处理长上下文。

优化器选择上,K2采用了MuonClip优化器,其核心是在Muon优化器基础上融合了QK-Clip机制。

这一机制会定期检查模型注意力的关键参数(query和key),如果它们的值太大,就自动“收紧”,防止计算过程出现异常,从而显著提升了训练稳定性。

团队最终也发现,借助MuonClip可让K2在15.5万亿token的预训练过程中实现零损失spike,确保了大规模训练的连续性和有效性。

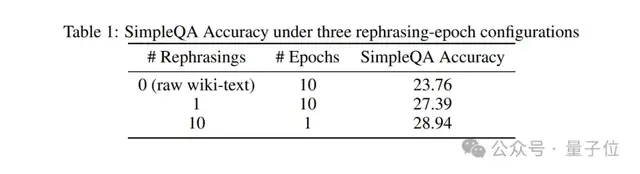

数据方面,其核心目标为,在高质量数据有限时,通过提升每token的有效学习信号(token效用)来增强训练效率,避免重复训练导致的过拟合。

而为了让模型“吃透”有限的优质训练数据,K2团队采取了一种所谓的“重述法”。

- 对知识类文本:不是简单重复读,而是换着说法再讲一遍。

- 对数学类文本:把枯燥的教材式内容改写成更易理解的“学习笔记”风格,还加入了多语言版本的翻译文本,让模型见多识广。

一言以蔽之,K2的训练数据覆盖网页、代码、数学、知识四大板块,所有数据都经过严格的质量筛选,确保模型学到的都是有用的信息。

而且它不是靠“多刷题”训练出来的,而是靠“换种说法讲一遍”让模型真正理解知识。

用重写 10 次的数据训练 1 轮(28.94%),其准确率超过了用原始数据训练 10 轮(23.76%)的结果 。

概括而言,K2采用了与DeepSeek-V3相似的多头潜在注意力(MLA),具体对比如下:

K2后训练阶段主要涉及监督微调和强化学习。

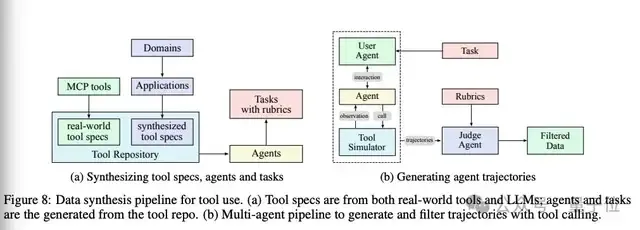

值得一提的就是大规模Agentic Tool Use数据合成,主要流程如下:

- 工具生成:3000多真实MCP工具+20000多合成工具,覆盖金融、机器人控制等领域;

- Agentic与任务生成:为工具集生成多样化Agentic(系统提示+工具组合)和带评估标准的任务;

- 轨迹生成:模拟用户交互、工具执行环境(含状态更新和随机结果),生成多轮工具使用轨迹;

- 结合真实执行沙箱(如编码任务),确保数据真实性。

最终,Judge Agent会依据任务rubrics对轨迹质量进行判断,只保留高质量样本用于训练。

这一过程本质上是一种大规模拒绝采样(rejection sampling)机制,结合模拟规模与真实反馈,实现了大范围、高保真的训练数据构建。

而在强化学习阶段,K2主要经历了三大步骤:

第一,构建可验证的奖励环境(Verifiable Rewards Gym)。

简单说,团队为不同任务设计了“可打分”的训练场景,让模型的表现可以被客观评估。

比如对于编码场景,团队利用真实世界的数据(如程序竞赛题目、GitHub的PR和issue)构建任务,并通过自动化测试来验证模型的代码是否正确运行。

第二,除了外部评判,还训练模型自己评估自己,即引入自我评估奖励机制(Self-Critique Rubric Reward)。

具体而言,模型会将自己的多个输出结果进行两两比较,并根据一套明确的标准(如语言清晰度、对话是否连贯、是否啰嗦或拍马屁)给出奖励分,同时还引入一些规则约束(如“不要无脑称赞用户”)来避免生成套路化或迎合性回答。

这个机制不仅增强了模型的自我反馈能力,也能将客观任务中的评估信号迁移到主观对话场景(如回答开放性问题等人类主观评判场景),形成闭环优化。

第三,为了更高效、稳定地进行强化学习训练,K2还对算法进行了多项改进。

包括但不限于下面这些:

- 预算控制机制:限制每个样本的最大token数,避免生成啰嗦、重复或无意义的长文本。

- 引入PTX辅助损失:使用高质量预训练样本时再加一个损失项,以防模型在RL阶段“遗忘”已有知识。

- 温度衰减策略:训练初期用高温度鼓励模型大胆尝试、广泛探索,后期逐步降低温度,让模型输出更稳定、更收敛。

最后据论文介绍,K2的训练依托于由NVIDIA H800构成的大规模高带宽GPU集群,通过混合并行策略,既保证了训练效率,又能在不同规模资源下灵活适配。

每个节点配备2TB内存,并通过NVLink和NVSwitch将8块GPU在节点内部高速互联。不同节点之间则使用8×400 Gbps的RoCE网络互联,以实现节点间的高效通信。

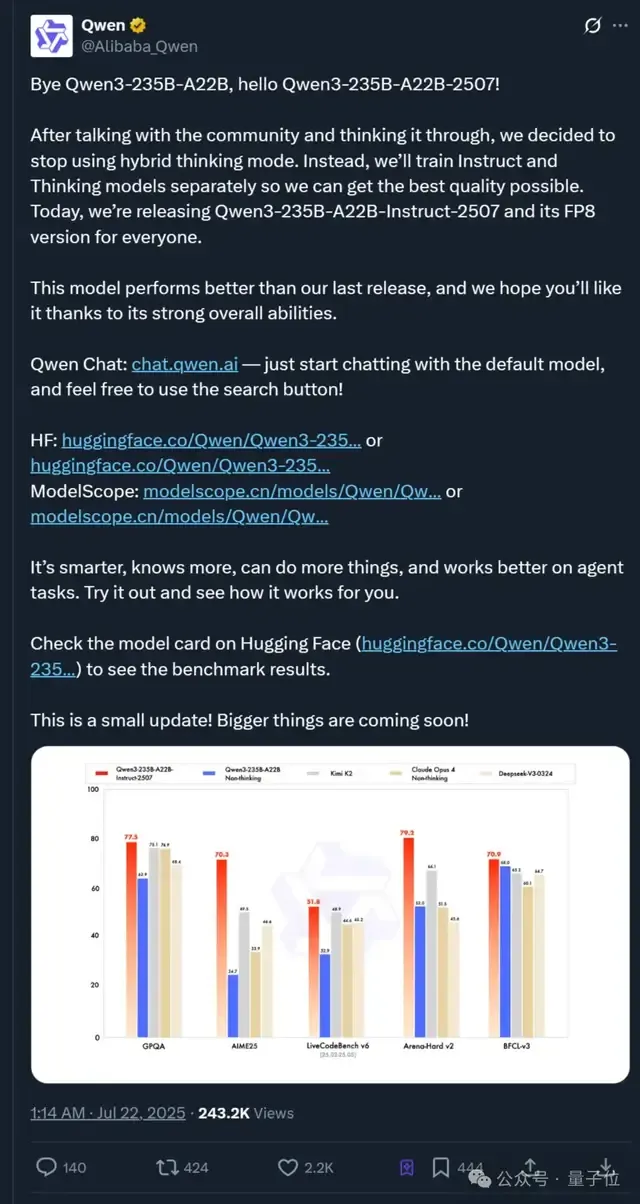

就在刚刚,阿里通义Qwen3模型也更新了——

正式由Qwen3-235B-A22B更新至Qwen3-235B-A22B-2507。

官方表示,他们停用了混合思维模式,改为分别训练Instruct和Thinking模型以提升质量,并正式发布性能更强的 Qwen3-235B-A22B-Instruct-2507及其FP8版本。

而且官方测评显示,最新版Qwen3又击败了Kimi K2模型,开源新王或将再次易主。