大家好,我是肆〇柒。最近,来自香港中文大学和新加坡管理大学的研究团队在一项关于自主智能体的实证研究中发现:当前主流智能体系统的任务完成率竟然只有约50%。他们不仅构建了一个包含34个可编程任务的基准测试,还对104次失败案例进行了系统性归因,首次提出了“三层失败分类法”。下面,我们一起看看智能体为何频频“卡壳”,以及我们该如何突破瓶颈。

现在,我们一起想象这样一个场景,深夜11点,某位开发者正盯着屏幕,看着自己精心搭建的自主智能体系统又一次在简单的Web爬虫任务上卡壳。明明宣传中LLM(大型语言模型)智能体能"自动化复杂任务",可现实却是连基础的HTML元素提取都屡屡失败。这种理论与实践的巨大落差,让无数开发者陷入困惑:为什么这些看似强大的自主智能体系统,实际任务完成率竟只有约50%?

当前行业对自主智能体的评估存在明显盲区——过度关注"成功率"这一单一指标,却忽视了对失败原因的系统性剖析。当一个智能体任务失败时,我们往往不清楚问题究竟出在任务规划、代码执行还是结果呈现的哪个环节。这种"黑箱式"评估无法为系统优化提供明确方向。

最新研究通过构建包含34个代表性可编程任务的基准测试,对三个主流开源智能体框架进行了204次实验评估,首次系统性地揭示了自主智能体失败的内在逻辑。研究不仅证实了当前智能体系统的任务完成率确实徘徊在50%左右,更提出了一个三层失败分类法,将104个失败案例精准归类。这些发现为开发者提供了可操作的改进路径,而非泛泛而谈的理论。

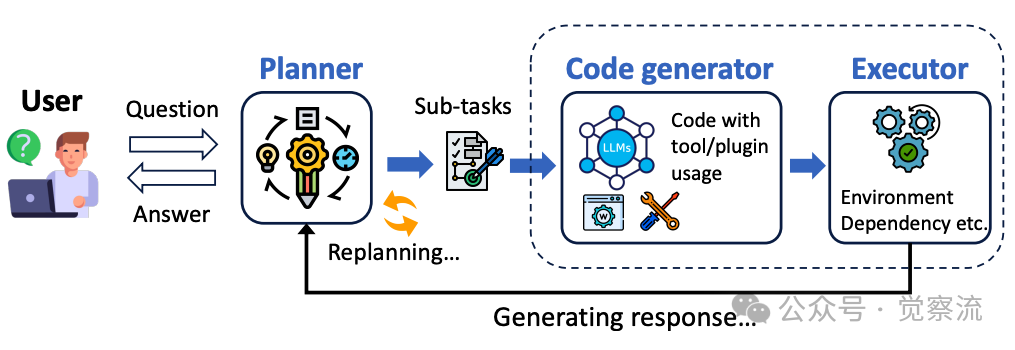

自主智能体系统基本框架

如上图所示,当前主流自主智能体系统由三大核心组件构成:负责任务分解的Planner(规划者)、负责代码生成的Code generator(代码生成器),以及负责执行与环境交互的Executor(执行器)。这三者形成闭环反馈机制,共同完成用户指令。理解这一架构是分析智能体失败原因的基础。

研究团队精心构建的基准测试包含三类日常常见的编程任务:

- Web爬虫:从GitHub和Stack Overflow中搜索"Web Crawling"关键词,构建任务

- 数据分析:采用DABench数据集中的端到端数据分析任务

- 文件操作:基于Stack Overflow中关于Python和Bash基本文件操作的帖子

任务选择遵循严格标准:必须可执行(基于代码运行结果而非代码本身评估)、适合自动化评估、且至少部分可被智能体解决。这种严谨的基准测试设计确保了评估结果的可靠性和实用性。

真相:自主智能体失败的三大"死亡陷阱"

1. 规划陷阱:聪明的开始是成功的一半,但智能体总在第一步就栽跟头

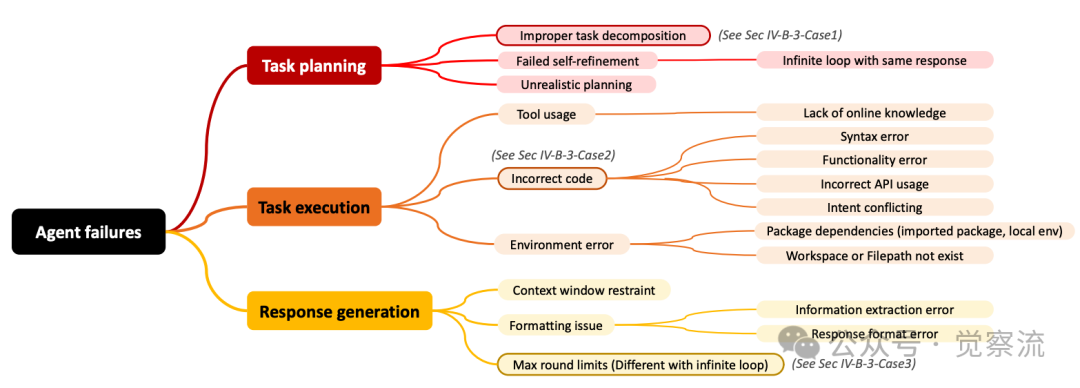

自主智能体失败的三层分类法

研究团队构建的三层失败分类法(上图)系统性地将104个失败案例归类为任务规划、任务执行和响应生成三大类,共19种具体失败原因。其中,任务规划阶段的失败尤为突出,因为Planner的输出直接指导后续智能体工作,很大程度上决定了整个框架的成功与否。

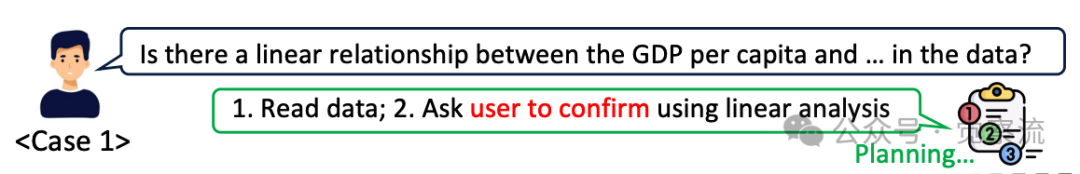

冗余确认:用户不需要的"贴心"当用户询问"是否存在GDP人均值与...数据的线性关系"时,理想的智能体应直接生成分析代码。但实际中,规划者常添加"请确认使用线性分析"的冗余步骤,虽然任务描述已明确要求线性分析。这种过度"人性化"的行为源于LLM内置安全约束与任务需求的冲突,导致看似合理的规划反而成为流程瓶颈。

Case1

上图展示了这一典型场景,智能体在数据分析任务中无谓地等待用户确认,完全违背了自动化初衷。

无限循环:学不会从错误中爬起来更令人沮丧的是,当智能体首次执行失败后,往往无法从错误反馈中学习调整。研究数据显示,许多失败案例中,智能体重复尝试相同错误方法,陷入"失败-重试-再失败"的死循环。这种"失败自我修正"能力的缺失,暴露了当前智能体系统缺乏有效的错误学习机制。规划者无法理解执行环境的反馈,导致无法动态调整计划。

不切实际的规划:纸上谈兵的"完美"计划有些规划看似逻辑严密、步骤清晰,却超出了下游智能体的实际执行能力。例如,规划者可能要求"从动态渲染的JavaScript页面提取数据",但实际代码生成器仅具备处理静态HTML的能力。这种理想化假设导致计划与执行脱节,是结构化任务中的常见陷阱。

规划阶段的其他关键失败原因:

- 任务分解不当:生成逻辑错误或不适合任务的步骤

- 缺乏环境感知:忽视实际运行环境的限制条件

- 上下文理解偏差:错误解读用户意图和任务需求

2. 执行陷阱:代码世界里的"盲人摸象"

任务执行阶段涉及代码生成器(Code generator)和执行器(Executor)的协作,是技术实现的核心环节,也是错误高发区。

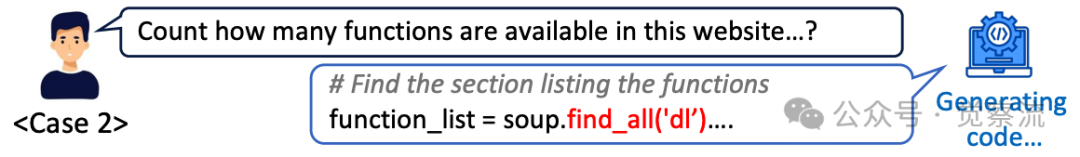

Case2

上图展示了典型的工具误用问题:当被要求"统计网站上的函数数量"时,智能体生成了soup.find_all('dl')的代码,错误假设所有<dl> HTML标签都用于列出函数。然而在技术文档等复杂网页中,这些标签常用于导航、定义等其他目的,导致计数严重失准。研究发现,工具使用问题在执行失败中占比较高,是执行阶段的主要痛点。

工具使用问题的四大表现:

- 缺乏在线知识:不了解特定工具的使用方法

- 错误假设:对工具功能有不准确的理解

- API误用:参数错误或调用方式不当

- 功能冲突:生成的代码与原始目标相矛盾

代码缺陷则表现为三种典型形式:

- 语法错误:代码无法执行,相对容易检测和修复

- 功能错误:代码可执行但结果偏离预期,如错误处理数据列名(KeyError)或返回空DataFrame

- API误用:参数错误或调用方式不当,常因对工具理解不深导致

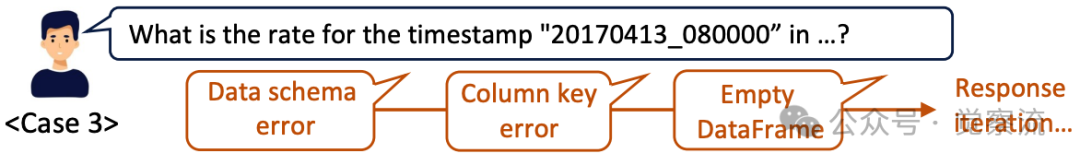

Case3

上图生动展示了功能错误问题:智能体在尝试获取特定时间戳数据时,先是因列名包含额外空格而报KeyError,随后切换策略检索整行数据又遭遇Empty DataFrame错误,最终陷入无法自拔的失败循环。这种错误表明智能体面临"基于先前检查输出进行自我修正"的挑战。

环境配置问题不容忽视:

- 包依赖缺失:未正确导入所需库或本地环境配置问题

- 文件路径错误:访问不存在的工作区或文件路径

- 资源限制:超出系统资源限制,如内存不足

研究数据表明,执行阶段的失败占总失败案例的43.2%,是三大阶段中占比最高的,凸显了这一环节的重要性。

3. 响应陷阱:功亏一篑的最后一步

即使代码执行成功,智能体在最终响应生成阶段仍可能功亏一篑。

上下文丢失:记忆太短的"金鱼脑"LLM的上下文窗口限制导致处理大HTML文件等复杂任务时,智能体可能丢失关键对话历史,使响应与上下文脱节。这种"上下文窗口约束"问题在Web爬虫任务中尤为突出,智能体可能忘记之前已尝试过的方法,重复相同的错误。

格式错乱:答非所问的"沟通障碍"格式问题在响应阶段失败中占比较高,主要表现为:

- 信息提取错误:无法从执行结果中提取关键信息

- 响应格式错误:返回结果包含无关信息或不符合要求格式

- 数据类型不匹配:返回字符串而非数值等

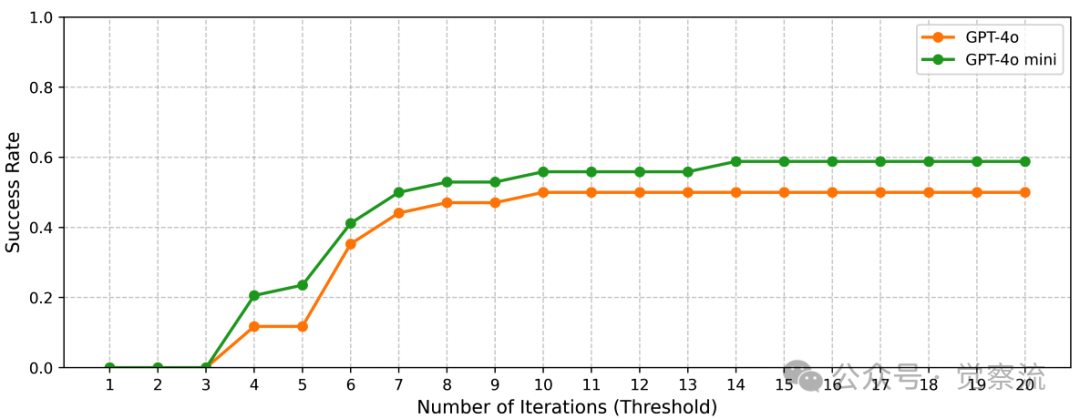

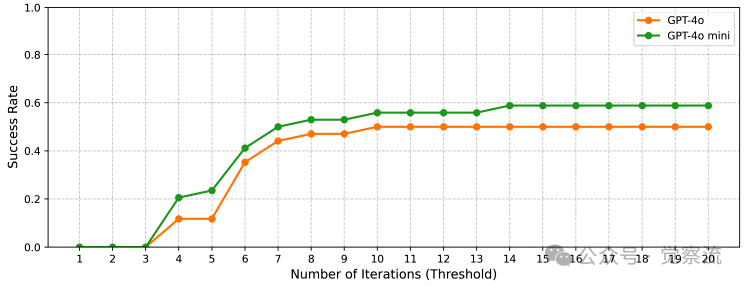

轮次耗尽:永远差"最后一次尝试"的遗

迭代次数与成功率关系

上图揭示了一个关键发现:前2次迭代成功率几乎为零,3-10次迭代是成功率快速提升的关键窗口期,而超过10次迭代后,提升效果显著放缓。这意味着智能体常在接近成功时因达到最大迭代次数而失败,造成"差一步成功"的遗憾。

研究数据显示,约18.3%的失败案例属于"最大轮次限制"问题,即智能体在达到预设交互轮次上限时仍未成功完成任务。这表明当前系统缺乏有效的迭代终止策略,既可能导致过早放弃可成功任务,也可能造成资源浪费。

破局之道:从失败中提炼的两大实战策略

策略一:构建"学习-反馈"闭环——让智能体真正学会思考

当前智能体系统最大的痛点在于规划与执行脱节,无法从错误反馈中有效学习。研究发现,规划阶段的自我修正失败是最大瓶颈,而解决这一问题的关键在于建立"学习-反馈"机制。

该机制的核心是让规划者能够理解执行环境的反馈,并据此动态调整计划。具体实施可包括:

错误模式识别与映射:

- 为关键错误类型建立映射规则,如检测到KeyError时自动检查列名格式

- 构建错误代码-解决方案的映射表,如"KeyError→检查列名空格"

- 开发错误相似度计算模型,识别重复错误模式

动态规划调整:

- 设计"计划健康度"指标,当错误模式重复出现时触发重规划

- 实现基于历史数据的预测机制,避免重复探索已知无效路径

- 引入多计划备选机制,当主计划失败时快速切换到备选方案

成功路径记忆库:

- 记录成功解决类似问题的路径

- 建立任务类型-解决方案的关联索引

- 实现跨任务知识迁移,将解决A任务的经验应用于B任务

这种反馈感知机制已在程序修复和代码生成领域显示出潜力。研究表明智能体可以动态调整计划基于工具反馈,决定是精炼还是重启预定义计划,避免僵化和不合逻辑的步骤。通过让智能体从每次失败中学习,可显著减少无效迭代,提高任务完成效率。

策略二:开发"早期停止与导航"机制——不做无用功

针对智能体常陷入无限循环或接近成功却因轮次耗尽而失败的问题,研究建议开发一个"元控制器",负责根因分析和问题导航。

该机制包含三个关键组件:

错误诊断引擎:

- 实时分析错误日志,识别根本原因

- 区分规划错误、执行错误和响应错误

- 评估错误可修复性,决定是继续尝试还是终止

智能导航系统:

- 错误-解决方案映射表:针对常见错误类型预设解决方案

- 代理角色切换机制:根据错误类型导航到最合适的代理

- 路径优化算法:跳过已知无效路径,直接尝试验证有效的解决方案

动态迭代管理:

- 基于任务进展动态调整最大尝试次数

- 设定错误重复阈值,触发"早期停止"

- 实现渐进式尝试策略,逐步扩大搜索空间

研究表明,部分失败案例中,智能体在最后1-2步就已接近成功。通过早期停止机制,可在确认无法突破时及时终止,减少资源浪费。同时,元控制器能引导系统跳过无效路径,直接尝试已验证有效的解决方案,提升任务成功率。

实战指南:根据任务类型选择最佳实践

1. 框架选择:没有"全能选手",只有"最佳匹配"

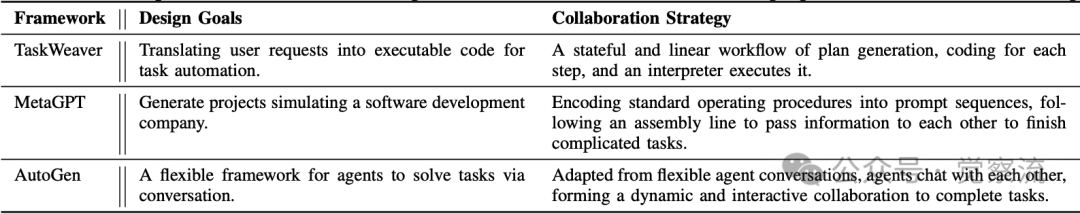

研究评估了三个主流开源智能体框架在不同任务类型上的表现,发现它们的工作机制存在本质差异:

智能体框架设计目标与协作策略比较

上表详细展示了三个框架的设计差异:

- TaskWeaver:采用有状态的线性工作流,依次完成计划生成、步骤编码和解释器执行。其线性工作流特别适合步骤明确、逻辑清晰的任务。使用GPT-4o时在数据任务上达66.67%成功率,在文件操作上达75.00%。

- MetaGPT:模拟软件开发公司,将标准操作流程编码为提示序列,通过流水线方式传递信息完成复杂任务。在Web爬虫等推理密集型任务上表现较好,GPT-4o下达33.33%成功率。

- AutoGen:提供基于对话的灵活框架,智能体通过聊天形成动态交互协作。适合需要多智能体协作的场景,但需加强响应格式控制,避免沟通混乱。

任务-框架匹配指南:

- Web爬虫任务:优先选择MetaGPT,因其标准操作流程更适合处理需要推理的非结构化数据

- 数据分析任务:TaskWeaver表现最佳,特别是GPT-4o版本达到66.67%成功率

- 文件操作任务:TaskWeaver和AutoGen均表现优异,GPT-4o下均达75%以上成功率

2. 模型选择:不是越强大越好

研究揭示了一个反直觉现象:在某些任务中,较小的模型(如GPT-4o mini)可能表现优于更强大的模型(如GPT-4o)。原因在于"过度思考"问题——GPT-4o在Web爬虫任务中常因安全约束与规划需求的冲突而失败:它能生成有效计划,但随后因内置安全机制拒绝执行爬虫操作。

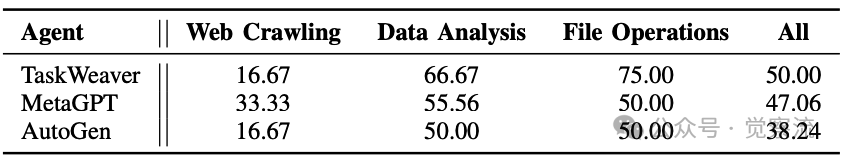

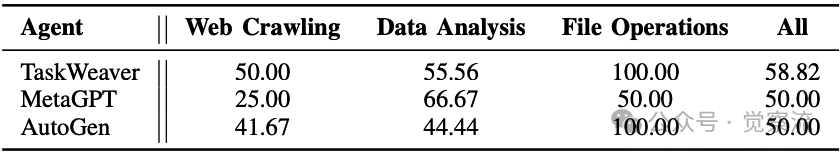

以上两表-不同模型下的基准成功率

以上两表提供了详细数据:

- Web爬虫任务:GPT-4o mini在TaskWeaver上达50.00%,而GPT-4o仅16.67%

- 数据分析任务:GPT-4o mini在MetaGPT上达66.67%,略高于GPT-4o的55.56%

- 文件操作任务:GPT-4o mini在TaskWeaver和AutoGen上达100.00%,显著优于GPT-4o

具体而言,GPT-4o会产生有效的计划但随后停止执行",这种"过度思考"导致任务失败。而GPT-4o mini由于安全约束较弱,反而能顺利完成这些任务。这一发现挑战了"更大模型总是更好"的直觉,表明模型选择应与任务特性匹配:对于涉及敏感操作的任务,有时较小模型更为合适。

任务-模型匹配原则应为:

- 结构化任务:使用GPT-4o(更强的推理能力)

- 敏感操作任务:考虑GPT-4o mini(避免过度思考)

- 资源受限场景:根据具体任务类型做针对性选择

3. 迭代策略:把握关键窗口期

迭代次数与成功率关系

上图清晰展示了迭代次数与成功率的关系:

- 最低尝试次数:至少3次,前2次迭代成功率几乎为零

- 最佳上限:8-10次,超过此值后成功率提升显著放缓

- 智能终止:当检测到重复错误模式时提前终止

这一发现表明,自主智能体系统需要"热身期"。前2次迭代成功率几乎为零,这是因为智能体需要时间理解任务并调整策略;3-10次迭代是成功率快速提升的关键窗口期;超过10次后,提升效果显著放缓。

优化迭代策略的具体建议:

- 设置动态上限:初始设置为10次,但根据任务类型和早期表现动态调整

- 错误模式监控:实现错误相似度检测,当重复错误超过阈值时提前终止

- 阶段式尝试:前3次尝试基础方案,4-7次尝试变体方案,8-10次尝试创新方案

- 资源配额管理:为不同类型错误分配不同资源配额,避免在不可修复错误上过度消耗资源

研究数据表明,将最大迭代次数从5提高到10可将成功率提升约20%,但进一步提高到15仅提升约5%,说明存在明显的边际效益递减。

总结:从50%到更高——务实的可靠性提升路径

研究证实,自主智能体系统的50%任务完成率背后有着系统性原因,可归结为三大类19个具体问题。这些失败不是随机的,而是有迹可循的,为系统优化提供了明确方向。

关键发现表明,没有"银弹"解决方案:框架选择需匹配任务类型,模型选择需避免"过度思考"陷阱,迭代策略需把握关键窗口期。而两大核心改进策略——"学习-反馈"闭环和"早期停止与导航"机制——则为提升智能体可靠性提供了实操路径。

一些实用建议:

- 诊断先行:从小任务开始,应用三层失败分类法诊断智能体系统

- 优先解决规划问题:70%以上的失败可追溯至规划阶段,优先实现学习-反馈机制

- 设置智能迭代上限:采用8-10次的动态上限,配合错误模式检测实现早期停止

- 任务导向选择框架:Web爬虫任务选MetaGPT,结构化任务用TaskWeaver

- 模型选择避免"越大越好"误区:敏感操作任务考虑GPT-4o mini

一点收获,自主智能体技术的真正价值不在于偶尔的成功,而在于系统性地分析失败、持续改进的能力。只有这样,自主智能体才能从"偶尔可用"走向"可靠实用"的新阶段,真正释放LLM驱动自动化任务的潜力。

最重要的是,开发者需要放下"完美智能体"的幻想,拥抱"可诊断、可修复"的务实理念。通过理解失败模式并针对性改进,我们有望将自主智能体成功率进一步提升。