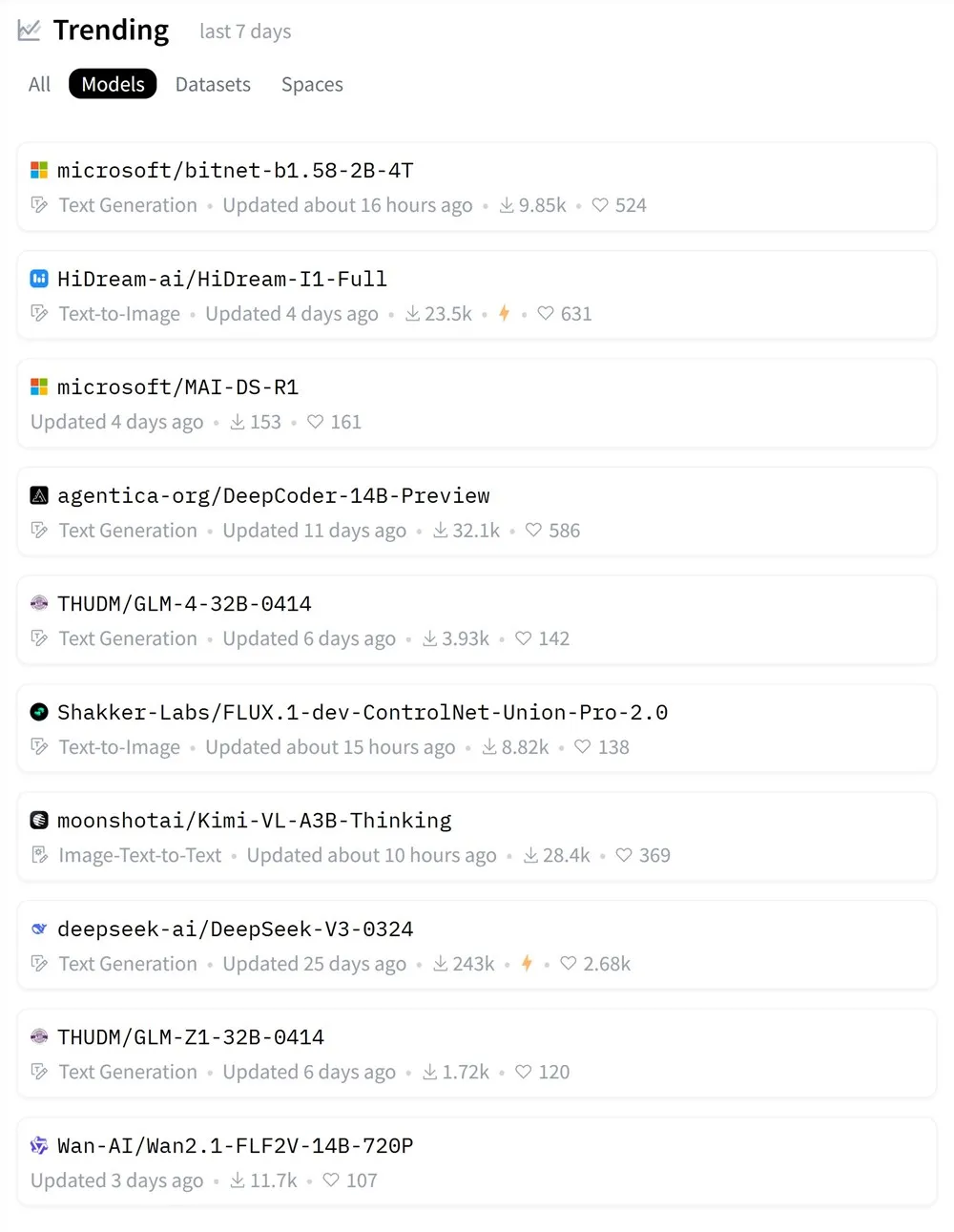

Hugging Face近日公布了2025年4月第二周最受欢迎模型榜单,涵盖文本生成、图像生成到视频生成等多模态领域,凸显了AI技术的快速迭代与多元化应用。据AIbase了解,本次榜单中的模型不仅展示了开源社区的创新活力,还反映了从低精度训练到多模态生成的技术趋势。以下为榜单亮点解析,AIbase编辑团队为您带来专业解读。

文本生成模型:高效与专业化并重

microsoft/bitnet-b1.58-2B-4T:作为首款采用1-bit精度训练的文本生成模型,BitNet以极低的计算成本实现高效推理,适合边缘设备部署。其创新的量化技术在保持性能的同时大幅降低能耗,受到社区广泛关注。

agentica-org/DeepCoder-14B-Preview:专为代码生成优化的文本生成模型,特别在前端开发任务中表现出色。其微调设计提升了代码逻辑的准确性,为开发者提供了强大工具。

THUDM/GLM-4-32B-0414& GLM-Z1-32B-0414:智谱AI的GLM系列再度上榜,GLM-4-32B以15T高质量数据预训练,支持对话、代码生成与指令跟随;GLM-Z1-32B则强化推理能力,性能媲美GPT-4o与DeepSeek-V3。AIbase期待本周社区发布的测试结果进一步验证其潜力。

deepseek-ai/DeepSeek-V3-0324:DeepSeek-V3的“小更新”版本,以671B参数规模继续领跑文本生成领域。其在复杂推理与多语言任务中的卓越表现,已成为开源社区的标杆模型。

microsoft/MAI-DS-R1:微软基于DeepSeek的后训练模型,优化了特定任务的指令跟随能力,尽管社区对其性能褒贬不一,仍因高效微调受到关注。

图像与多模态模型:视觉生成迈向新高度

HiDream-ai/HiDream-I1-Full:这一文本到图像模型以高生成质量脱颖而出,细节表现与风格多样性令人印象深刻。AIbase认为,其在艺术创作与商业设计中的应用潜力巨大。

Shakker-Labs/FLUX.1-dev-ControlNet-Union-Pro-2.0:基于FLUX.1-dev的改进版本,专注于人物生成,结合ControlNet技术提升了图像一致性与控制精度,适合高精度视觉任务。

moonshotai/Kimi-VL-A3B-Thinking:Kimi的多模态模型,支持图像-文本到文本生成,凭借强大的视觉理解与推理能力,适用于复杂问答与内容分析场景。AIbase此前已报道其在多模态领域的创新突破。

视频生成模型:动态内容创作提速

Wan-AI/Wan2.1-FLF2V-14B-720P:阿里巴巴开源的首尾帧视频生成模型,支持5秒720p高清视频生成。通过CLIP语义特征与DiT架构,该模型在画面稳定性与过渡流畅性上表现优异,广泛应用于短视频创作与影视后期。

AIbase分析,Hugging Face榜单反映了AI发展的两大趋势:一是多模态模型的崛起,如Kimi-VL与Wan2.1-FLF2V展示了从图像到视频的生成能力;二是高效推理的突破,如BitNet的1-bit训练为低资源环境开辟了新可能。未来,随着模型规模扩大与计算优化,AI将在教育、医疗与创意产业中发挥更大作用。AIbase将持续跟踪榜单动态,为读者带来最新技术洞察。