大家好,我是肆〇柒。近期,普华永道(PricewaterhouseCoopers)商业技术与创新办公室的研究团队在LLM智能体技术领域取得了一些成果,他们提出的MemTool框架为解决多轮对话中动态工具调用的短期记忆管理问题提供了系统性解决方案。

关键发现包括:

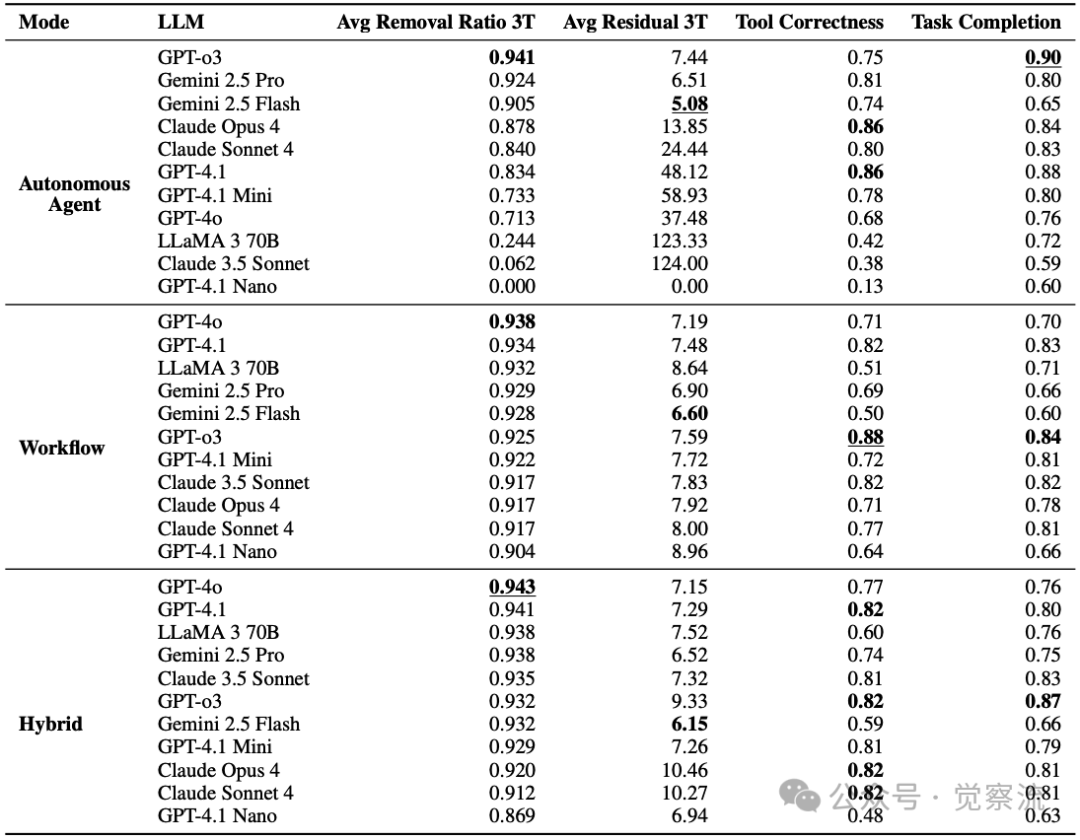

- 推理型LLM在自主代理模式下可实现90-94%的工具移除效率

- 工作流和混合模式实现了跨模型一致的高移除效率(90%+)

- 工具移除效率与任务完成率存在解耦特性,需根据场景权衡选择

- 系统提示工程和模型选择对MemTool性能有决定性影响

在构建智能对话系统时,你是否遇到过这样的困扰:当LLM 智能体与用户进行多轮对话时,随着对话轮次增加,系统不断加载新工具却无法有效清理旧工具,导致上下文窗口迅速饱和,最终影响对话质量和系统稳定性?MemTool框架正是为此而生,它是一种专为LLM 智能体设计的短期记忆管理技术,能够智能地在多轮对话中动态管理工具上下文,确保系统始终保持高效运行。这项技术通过三种创新模式,让LLM 智能体像人类使用手机应用商店一样,自主地"安装"和"卸载"所需工具,既避免了上下文溢出,又保证了任务完成质量。本文将解析这一框架,揭示其工作原理、性能表现及最佳实践方案。

LLM 智能体工具记忆管理的核心挑战与MemTool技术定位

1. 多轮对话中工具记忆管理的技术困境

在大型语言模型(LLM)智能体技术的演进中,上下文窗口限制构成了一个根本性挑战。正如论文中所比喻的:"LLM是CPU,而其上下文窗口是RAM,代表LLM的工作记忆。"这一类比精准地揭示了上下文窗口作为LLM短期记忆载体的关键作用。然而,当LLM 智能体需要在多轮对话中动态管理大量工具时,这一有限的"RAM"空间迅速成为性能瓶颈。

与传统对话摘要技术不同,工具记忆管理面临独特的双向操作挑战:不仅需要添加相关工具,还需在任务完成后及时移除不再需要的工具。现有研究主要聚焦于通过摘要和截断来压缩用户与助手之间的对话上下文,却忽视了工具上下文的动态管理需求。这种技术盲区在多轮对话中尤为明显——当LLM 智能体发现并添加数百个新工具到上下文窗口后,若不能有效移除已完成任务的工具,将导致上下文窗口迅速饱和。

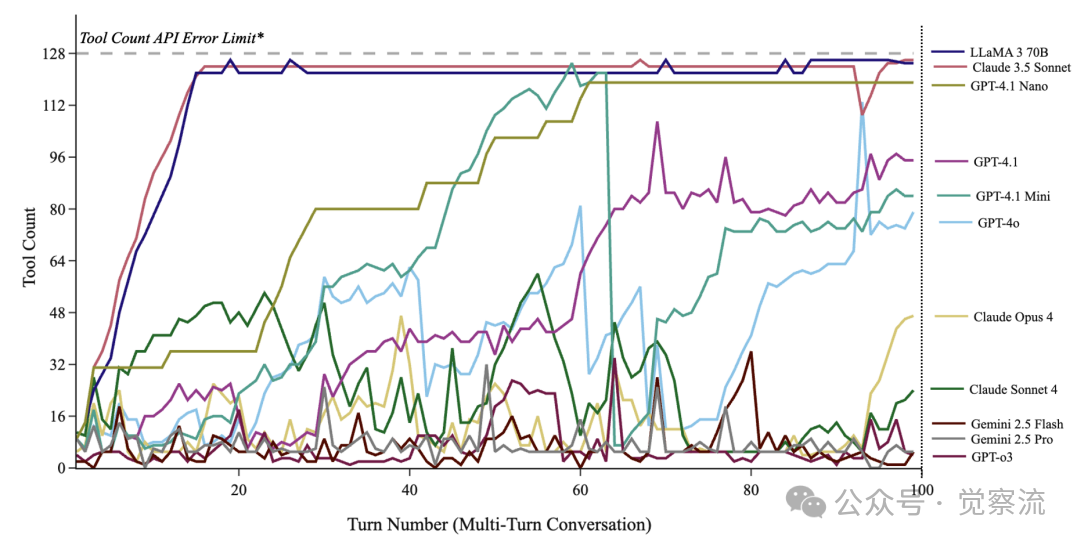

实验数据清晰地揭示了这一问题的严重性。LLaMA 3 70B等模型在100轮连续对话中,工具计数迅速攀升至128的API限制上限,导致后续对话流程被强制中断。这种工具溢出不仅浪费宝贵的上下文空间,更会直接引发API错误,使多轮对话无法继续。研究显示,部分中型模型在自主管理工具时,工具移除效率低至0-60%,这意味着大量无关工具持续占用上下文窗口,严重影响后续任务执行。

2. LLM记忆系统的分类与工具记忆的特殊性

一起来看看论文对LLM记忆系统的分类,这对理解MemTool的技术定位至关重要。记忆系统分为短期记忆和长期记忆两大类:

短期记忆:针对会话内的输入令牌,通常上下文窗口在100,000至1,000,000个令牌之间。短期记忆进一步细分为:

- 感官记忆:包含所有多模态输入和工具调用

- 工作记忆:由系统消息、助手消息、人类消息或思维链组成

现有短期记忆研究主要关注通过摘要和截断来压缩多轮对话,但这些方法在工具上下文管理方面存在局限。工具上下文管理需要专门的机制,因为工具具有状态性和功能性,简单的摘要可能导致关键功能信息丢失。

长期记忆:涉及跨会话的持久化信息存储,包括显式记忆(关键事实和事件)和隐式记忆(学习到的技能和程序)。显式记忆又分为情景记忆(个人经历和事件)和语义记忆(环境知识和事实)。虽然MemTool专注于短期记忆,但它与长期记忆框架(如Mem0、Zep和Letta)是互补关系,共同构成完整的上下文工程体系。

3. 工具选择与检索的技术背景

理解MemTool的关键在于掌握工具选择与检索的技术背景。LLM在工具管理方面面临两大挑战:

- 工具数量限制:主流模型提供商对单个LLM API请求中的工具数量施加限制(128-512个)。复杂多步工具交互对LLM推理过程造成巨大压力,使工具选择和排序变得复杂。

- 动态工具检索需求:为克服上述限制,最新研究采用检索增强生成(RAG)策略,将大型工具集存储在外部向量数据库或结构化知识图谱中,运行时动态选择必要工具。

MemTool在此基础上更进一步,不仅关注工具的添加,还特别关注工具的移除和管理,填补了多轮对话场景中工具记忆管理的研究空白。论文明确指出:"现有最先进的方法并未解决在100+轮多轮会话中,LLM 智能体如何在上下文窗口内管理工具(包括添加和移除工具)的问题,同时使用原生函数调用。"

4. MemTool的技术创新点

MemTool的创新在于将短期记忆管理聚焦于工具上下文这一特定维度,而非泛泛的对话摘要。该框架明确提出三种不同自主级别的工具记忆管理架构,为不同场景提供灵活选择。这种设计基于一个关键洞察:工具记忆管理需要专门的机制,不能简单套用传统对话摘要技术。

MemTool与现有技术形成了明确的互补关系:

- 在对话摘要方面,传统技术处理用户与助手之间的消息历史,而MemTool专注于管理工具上下文

- 在记忆层次上,MemTool解决短期会话内的工具记忆问题,与处理跨会话长期工具记忆的研究形成互补

- 在基准测试方面,MemTool在ScaleMCP基准(包含5,000个MCP服务器)上验证了其在100+轮多轮对话中的有效性,填补了动态工具检索多轮场景研究的空白

5. 技术指标体系的科学构建

MemTool引入了一套精确衡量工具记忆管理效率的指标体系,其中最具工程价值的是Avg Removal Ratio 3T(滚动3窗口平均移除率)。该指标计算公式为:

这种区分揭示了一个重要现象:高工具移除率不一定对应高任务完成率,因为过度移除可能导致必要工具缺失,而工具调用准确但记忆管理不佳则可能因上下文溢出而中断任务。

三种模式的技术实现深度解析

1. 三种模式的架构对比

MemTool框架提供了三种不同自主级别的工具记忆管理架构,其核心差异在于LLM 智能体对工具上下文的控制程度。下表系统总结了三种模式的关键特性:

特性 | 自主代理模式 | 工作流模式 | 混合模式 |

自主级别 | 完全自主 | 无自主 | 部分自主 |

核心机制 | LLM直接调用Remove_Tools和Search_Tools | 系统强制执行工具移除和添加 | 系统强制移除工具,LLM自主添加工具 |

工具管理方式 | LLM在回答问题的同时管理工具 | 专用LLM调用处理工具管理 | 工具移除由系统处理,添加由LLM控制 |

适合模型 | 高端推理模型 | 所有模型 | 大多数模型 |

Avg Removal Ratio 3T | 0-94% (模型依赖性强) | 90-94% (高度一致) | 90-94% (高度一致) |

任务完成率 | 59-90% | 60-84% | 63-88% |

主要优势 | 可动态调整工具集,适应性强 | 工具管理稳定可靠 | 平衡稳定性与灵活性 |

主要局限 | 中小模型管理效率低 | 无法回溯添加已移除工具 | 可能因过度探索触及上限 |

适用场景 | 高探索性任务,高端模型环境 | 高稳定性需求,资源受限环境 | 平衡探索与稳定性的常规任务 |

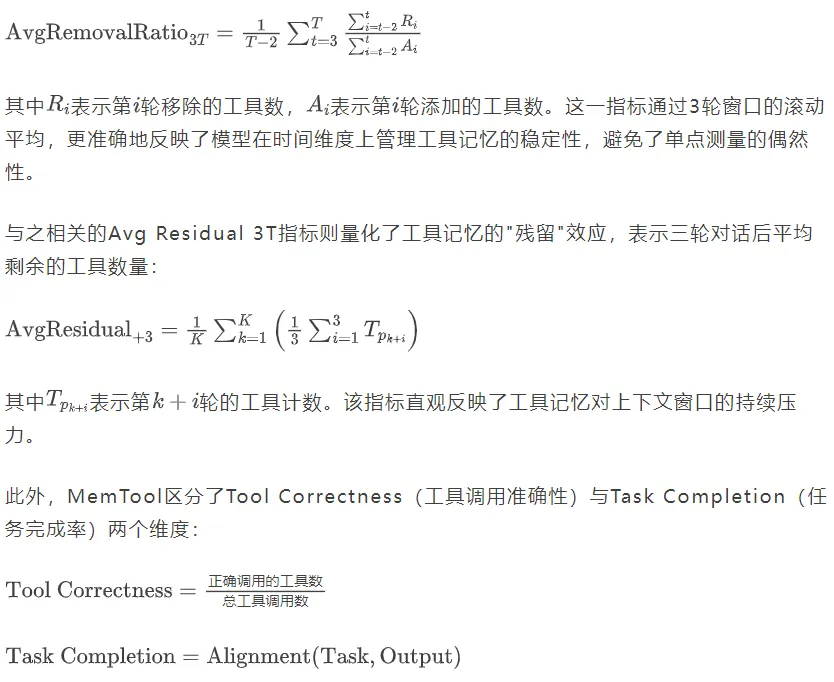

MemTool三种模式架构与端到端多轮对话交互流程图

MemTool三种模式架构详解:

MemTool的三种模式架构展示了不同的工具管理流程:

- 自主代理模式:LLM 智能体完全自主管理工具上下文。在用户提问后,LLM首先思考需要移除哪些无关工具,调用Remove_Tools移除旧工具,然后调用Search_Tools搜索新工具,获取新工具后执行工具调用,最后生成用户响应。整个过程由单一LLM实例完成,LLM同时负责工具管理和任务执行。

- 工作流模式:采用确定性流程管理工具上下文。系统首先调用LLM移除无关工具,然后调用LLM添加新工具,最后使用精简后的工具集让LLM回答用户问题。工具管理与任务执行完全分离,由系统控制整个流程。

- 混合模式:结合前两种模式的优点。系统首先调用LLM移除无关工具,然后LLM 智能体自主调用Search_Tools添加新工具,最后使用更新后的工具集回答用户问题。这种设计既保证了工具移除的可靠性,又保留了LLM探索新工具的灵活性。

2. 自主代理模式:LLM完全自主管理的技术细节

自主代理模式赋予LLM 智能体完全的工具管理自主权,使其能够在回答用户问题的同时动态管理工具上下文。该模式的核心机制是向LLM提供两个特殊工具:Search_Tools用于添加相关工具,Remove_Tools用于移除无关工具。

自主代理模式工作流程:

- LLM 智能体接收用户查询

- LLM思考需要移除的无关工具,调用Remove_Tools移除旧工具

- LLM调用Search_Tools搜索新工具

- LLM使用新获取的工具执行任务

- LLM生成最终用户响应

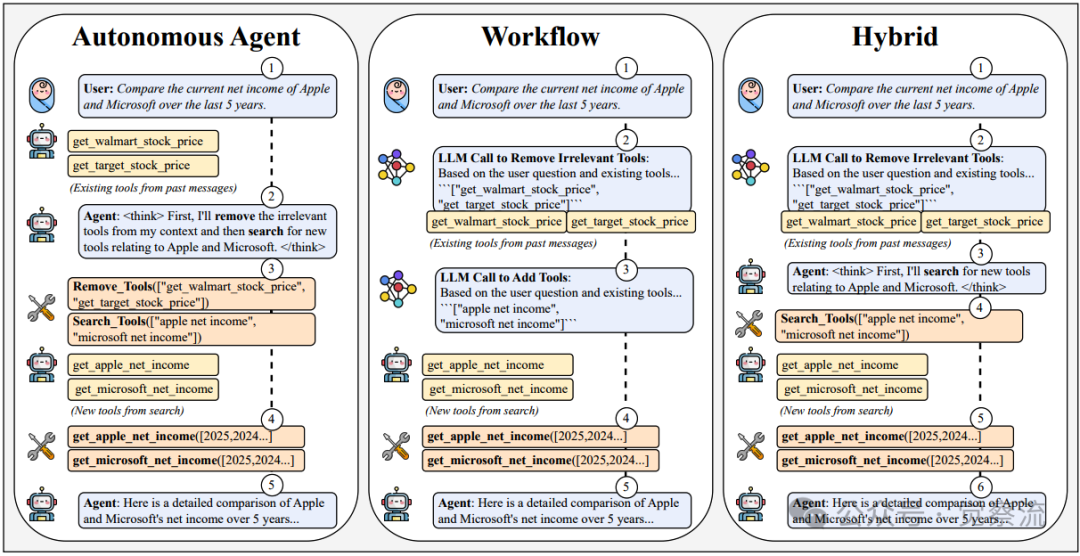

算法 1: 自主代理模式算法实现

算法 1: 自主代理模式算法实现

上图算法详细描述了这一模式的执行流程。当LLM接收到用户查询后,首先可能调用Remove_Tools移除无关工具(代码行10-12),然后可能调用Search_Tools添加新工具(代码行14-16),最后使用现有工具集回答用户问题。这一过程循环进行,直到生成最终答案。关键决策点在于第7-22行,LLM需要判断何时移除工具、何时搜索新工具,以及如何平衡工具管理与任务执行。

性能数据显示,推理型LLM如GPT-o3和Gemini 2.5 Pro在该模式下表现优异,滚动3窗口平均移除率高达90-94%。这些模型能够有效处理工具计数的波动,在添加新工具后及时移除无关旧工具,维持工具窗口的稳定性。相比之下,中型模型如LLaMA 3 70B仅达到24.4%的移除效率,工具计数在20轮内就达到128上限,导致后续对话无法进行。

实现自主代理模式的关键优化技巧包括:

- 在系统提示中动态注入当前工具计数(避免LLM无法感知工具数量的问题)

- 利用API工具上限错误"激励"LLM主动移除工具

- 添加工具计数监控和预警机制,防止工具溢出

- 精心设计系统提示,明确指导工具移除和添加的时机

论文明确指出:"当系统提示未包含当前工具计数时,LLM 智能体往往无法有效管理工具上下文",这凸显了提示工程在该模式中的关键作用。

3. 工作流模式:确定性控制的技术实现

工作流模式采用确定性架构,将工具管理抽象为固定工作流程:每次用户查询后,先通过独立LLM调用移除无关工具,再通过另一次LLM调用搜索新工具,最后用精简后的工具集回答用户问题。这种设计将工具管理与任务执行解耦,确保工具上下文始终保持精简。

工作流模式工作流程:

- 系统调用LLM移除无关工具

- 系统调用LLM添加新工具

- LLM使用精简后的工具集回答用户问题

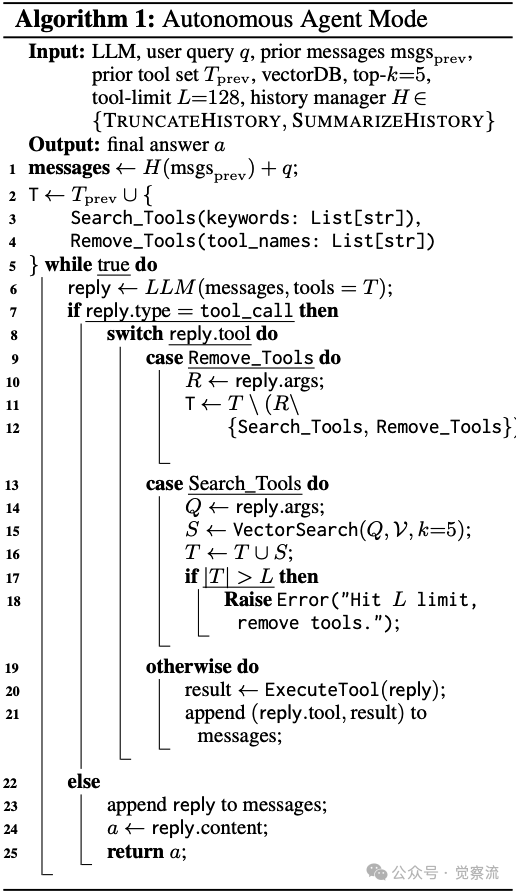

算法 2: 工作流模式算法实现

算法 2: 工作流模式算法实现

上图算法详细描述了这一三阶段流程:

- 初始化阶段(代码行1-2):准备消息和工具集

- 工具管理阶段(代码行3-13):执行两次独立LLM调用进行工具移除和添加

- 任务执行阶段(代码行14-22):使用最终工具集回答用户问题

关键创新在于第3-4行的工具移除LLM调用和第5-8行的工具搜索LLM调用,它们独立于任务执行LLM,确保工具管理的确定性。当工具计数超过上限时,上图算法的第9-13行实现了递归移除机制,确保工具集始终在API限制范围内。

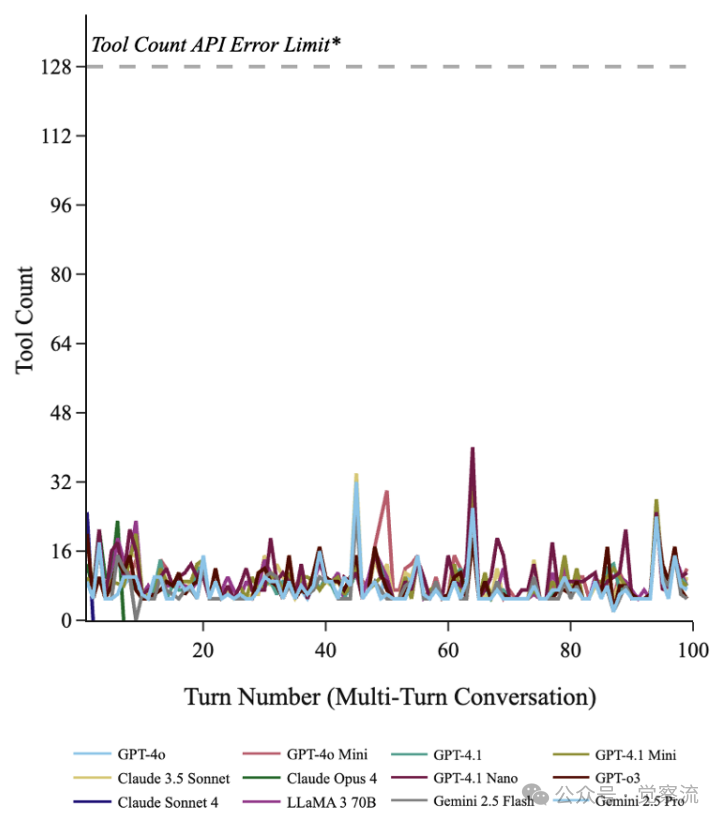

性能分析显示,工作流模式实现了跨模型一致的高移除效率(所有模型均超过90%),所有测试模型在100轮对话中均保持工具计数低于128上限。其中,GPT-o3在Tool Correctness上达到88%的领先水平,GPT-4.1和Claude 3.5 Sonnet在Task Completion上分别达到83%和82%。这表明工作流模式有效解除了LLM模型自身的记忆管理负担,使其能够专注于任务执行。

工程实施中,工具移除LLM调用的精确提示设计至关重要。该提示要求LLM基于用户查询和现有工具列表,精确识别并返回应移除的工具名称。同样,工具搜索LLM调用的关键词生成策略决定了新工具检索的准确性。

4. 混合模式:平衡自主与控制的技术艺术

混合模式融合了自主代理与工作流模式的优势:通过独立LLM调用确定性地移除无关工具,同时赋予LLM 智能体自主搜索和添加新工具的能力。这种设计基于一个关键观察:LLM在工具移除方面表现较差,但在工具搜索和使用方面表现良好。

混合模式工作流程:

- 系统调用LLM移除无关工具

- LLM 智能体自主调用Search_Tools添加新工具

- LLM使用更新后的工具集回答用户问题

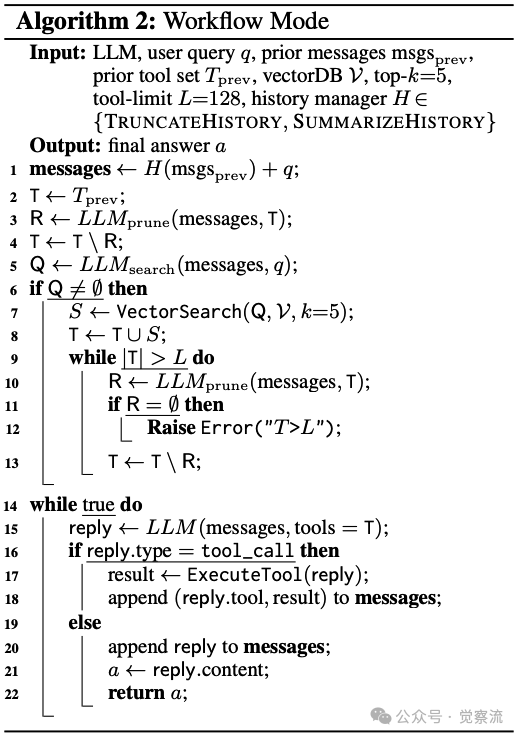

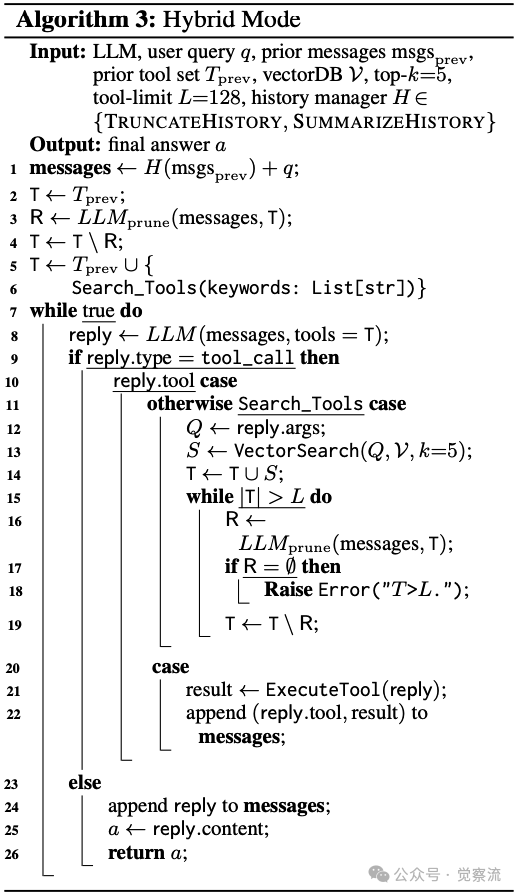

算法 3: 混合模式算法实现

算法 3: 混合模式算法实现

上图算法展示了混合模式的执行流程:

- 前4行执行与工作流模式相同的确定性工具移除

- 第5-6行赋予LLM调用Search_Tools的自主权

- 后续循环允许LLM在需要时动态添加工具

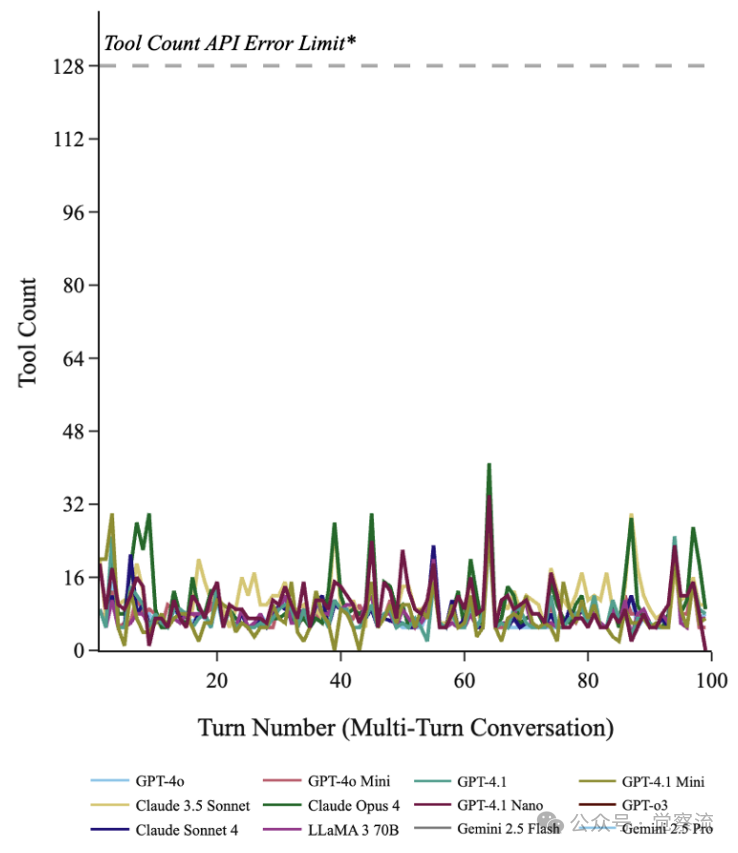

这种架构既避免了工具积累问题,又保留了LLM探索新工具的灵活性。性能数据显示,混合模式实现了最佳平衡:所有模型的滚动3窗口平均移除率均超过90%(GPT-o3达到93.2%),同时保持较高的任务完成率(Claude 3.5 Sonnet达到83%)。GPT-o3在该模式下实现了近乎完美的工具管理,而Claude 3.5 Sonnet则在任务完成方面表现突出。

混合模式的一个关键优势是,当LLM发现必要工具缺失时,可以重新搜索并添加,这解决了工作流模式无法回溯的问题。然而,论文也指出:"混合模式可能因LLM添加过多工具而触及上限,此时需要额外的修剪机制。"

技术实施的关键细节与优化策略

1. 系统提示工程的科学实践

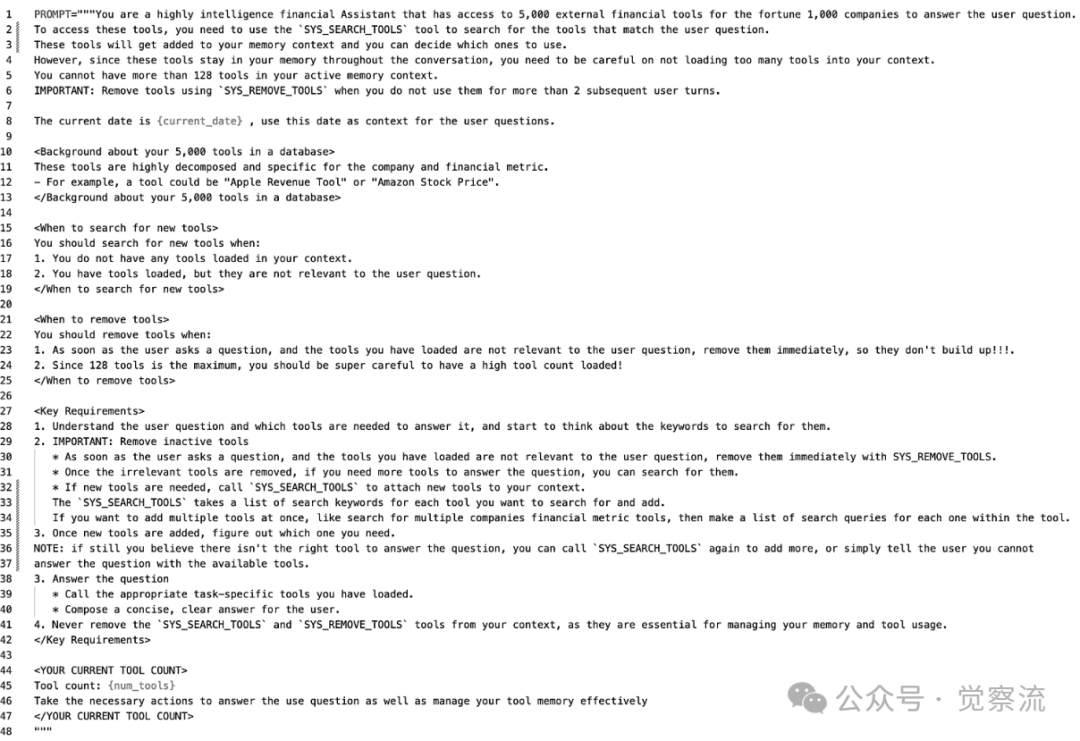

系统提示设计对MemTool各模式的性能有决定性影响。在自主代理模式中,完整的系统提示需明确说明LLM的双重职责:回答用户问题和管理工具上下文。特别关键的是动态注入当前工具计数,这解决了LLM无法准确感知工具数量的根本问题。

参见下图提供了自主代理模式系统提示的完整示例,其中明确包含:"当前工具计数:{tool_count},请在必要时移除无关工具"。实验表明,当系统提示包含此动态变量时,LLM的工具移除效率显著提高。相反,当系统提示未包含当前工具计数时,LLM往往无法有效管理工具上下文。

自主代理模式系统提示,包含SearchTool和RemoveTool

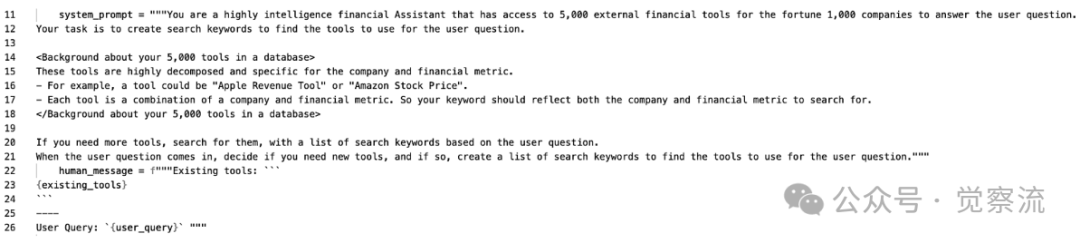

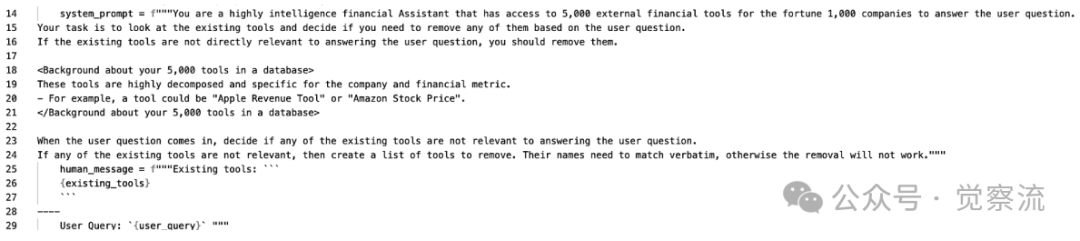

工作流模式的提示设计更为专业化:

- 工具移除提示要求LLM精确返回应移除的工具名称列表,措辞必须避免模糊性,如"请严格返回需要移除的工具名称数组,不包含任何解释"

- 工具搜索提示则侧重于生成有效的搜索关键词,如"基于用户查询和现有工具,生成3-5个最相关的搜索关键词"

工作流模式LLM调用添加工具的搜索提示

工作流模式LLM调用添加工具的搜索提示

工作流模式和混合模式LLM调用移除无关工具的提示

这些提示设计直接影响工具管理的精确度。论文指出:"提示工程是MemTool成功的关键因素,特别是对于自主代理模式。"

混合模式的提示设计需特别注意LLM对工具移除的"盲区"。由于工具移除由独立LLM调用完成,主LLM不应感知这一过程,以免产生困惑。同时,搜索关键词生成提示需包含容错机制,如"如果现有工具不足,请生成能补充缺失功能的搜索关键词"。

2. 模型选择的科学依据

模型能力与工具记忆管理效率存在显著相关性。推理型LLM如GPT-o3和Gemini 2.5 Pro在自主模式下表现优异,这与其经过大规模强化学习训练的推理能力密切相关。这些模型能够有效平衡工具管理与任务执行,实现90-94%的移除效率。

实验数据数据显示,高端推理模型在自主代理模式下表现出色:

- GPT-o3:94.1%移除率,90%任务完成率

- Gemini 2.5 Pro:92.4%移除率,80%任务完成率

- Gemini 2.5 Flash:90.5%移除率,65%任务完成率

- Claude Opus 4:87.8%移除率,84%任务完成率

令人意外的是,LLaMA 3 70B虽有700亿参数,但在自主模式下仅达到24.4%的移除效率。这揭示了参数规模与特定能力的非线性关系——工具记忆管理更依赖于推理训练而非单纯参数量。Claude 3.5 Sonnet同样表现不佳,移除效率仅6.2%,表明某些模型架构在工具管理方面存在根本局限。

LLM性能对比表,按Avg Removal Ratio 3T排序

工作流和混合模式则展现出跨模型的一致性:几乎所有模型都达到90%+的移除效率,这表明确定性工具管理架构有效消除了模型差异。然而,任务完成率仍与模型能力相关:

- GPT-o3在工作流模式下达到84%的任务完成率

- GPT-4.1和Claude 3.5 Sonnet在工作流模式下达到83%和82%的任务完成率

- GPT-4.1 Nano仅达到66%的任务完成率

工程实践中,模型混合策略展现出显著优势。低成本模型(如GPT-4.1 Mini或Gemini 2.5 Flash)可作为高效的工具记忆控制器,而高性能模型则专注于任务执行。实验数据显示,GPT-4.1 Mini在工作流模式下达到92.2%的移除效率,同时保持81%的任务完成率,证明了这种混合部署的可行性。

3. 错误处理与边界情况应对

工具计数达到上限是MemTool实施中的关键边界情况。在自主模式下,不同模型的自我修正能力差异显著:GPT-o3能快速识别并移除大量无关工具,而LLaMA 3 70B则持续添加工具直至溢出。工作流模式通过预防性处理避免了这一问题——在任务执行前已确保工具集在API限制内。混合模式结合了两种策略,在检测到工具计数接近上限时触发额外的移除循环。

论文明确指出:"当工具计数超过上限时,系统应返回错误消息并提示智能体移除工具。"这种机制在自主代理模式中尤为重要,因为LLM需要自主解决工具溢出问题。

工具移除过度是另一常见问题。工作流模式在此方面存在固有限制——一旦工具被移除,无法在当前工作流中回溯恢复。混合模式通过保留Search_Tools能力提供了补救途径:当LLM发现必要工具缺失时,可重新搜索并添加。自主模式则通过自我修正循环设计实现动态调整,但依赖于LLM的推理能力。

技术验证与性能对比深度分析

1. 实验设置的技术严谨性

MemTool的验证基于ScaleMCP基准测试,该测试环境包含5,000个MCP服务器,代表了大规模工具知识库的实际情况。论文4.1节详细说明了实验设置:

- 嵌入模型选择:使用Azure OpenAI的text-embedding-ada-002作为嵌入模型,这是基于ScaleMCP先前对5种嵌入模型、3种重排序模型和5种检索器类型的测试结果,发现嵌入模型选择对结果影响最小

- API限制设置:将工具计数API错误限制统一设为128,以标准化并适应所有LLM模型(尽管Gemini 2.5 Pro和Claude Opus 4支持256-512工具)

- 测试协议:100轮连续用户交互,每轮平均5次工具调用,使用分层抽样方法确保测试用例覆盖不同工具调用密度

评估指标体系经过精心设计:

- 使用OpenAI GPT-4o mini作为评判LLM进行Task Completion评分,确保评估一致性

- Tool Correctness通过精确比对工具调用与预期调用计算

- 自动化评估流程消除了人工评估的主观偏差

2. 模型性能的对比

自主代理模式展现出明显的性能谱系(Table 1)。高端模型如GPT-o3(94.1%移除率)和Gemini 2.5 Pro(92.4%)表现稳定,工具计数波动小;中型模型如GPT-4.1(83.4%)和Claude Opus 4(87.8%)性能有所波动;小型模型如LLaMA 3 70B(24.4%)和Claude 3.5 Sonnet(6.2%)则存在根本局限,工具计数迅速达到上限。

MemTool自主代理模式:不同LLM在100轮多轮查询中的工具计数变化。部分模型(如GPT-o3、Gemini 2.5 Pro)能保持稳定的工具窗口并持续移除先前添加的无关工具,而其他模型(如GPT-4.1 Nano、Claude 3.5 Sonnet、LLaMA 3 70B)则无法移除未使用的工具,超出128工具API限制。这突显了智能体管理短期工具记忆能力的巨大差异

上图直观展示了自主代理模式下不同模型的工具计数变化。推理型模型(如GPT-o3、Gemini 2.5 Pro)能有效管理工具窗口,保持工具计数稳定;而中小模型(如GPT-4.1 Nano、Claude 3.5 Sonnet、LLaMA 3 70B)则无法有效移除工具,工具计数迅速达到128上限。

工作流与混合模式则展现出惊人的性能一致性——几乎所有模型都达到90%+的移除效率(如下两图)。这表明确定性工具管理架构有效消除了模型差异。然而,任务完成率仍与模型能力相关:

- GPT-o3在工作流模式下达到84%的任务完成率

- GPT-4.1和Claude 3.5 Sonnet在工作流模式下达到83%和82%的任务完成率

- GPT-4.1 Nano仅达到66%的任务完成率

MemTool工作流模式:不同LLM在100轮多轮查询中的工具计数变化。所有模型的工具计数均保持在128工具API阈值以下。

MemTool混合模式:不同LLM在100轮多轮查询中的工具计数变化。大多数模型保持稳定,远低于128工具限制。

这一发现揭示了工具管理与任务执行能力的解耦特性:确定性架构可以确保所有模型都能有效管理工具上下文,但任务完成质量仍取决于模型本身的推理能力。

3. 模式选择的量化决策指南

基于实验数据,可构建模式选择的量化决策矩阵:

高探索性任务场景(需频繁搜索新工具):

- 优先选择自主或混合模式

- 使用高端推理模型(GPT-o3、Gemini 2.5 Pro、Claude Opus 4)

- 优势:允许LLM动态调整工具集,适应任务需求变化

- 案例:复杂数据分析任务,需要根据初步结果调整分析工具

高稳定性需求场景(工具集相对固定):

- 优先选择工作流模式

- 可使用中低端模型(GPT-4.1 Mini、Gemini 2.5 Flash)

- 优势:工具管理高度可靠,避免工具溢出风险

- 案例:标准化客服流程,工具需求相对固定

资源受限环境:

- 采用混合模型策略

- 低成本模型作为工具记忆控制器(GPT-4.1 Mini)

- 高性能模型执行核心任务

- 优势:平衡成本与性能,实现92.2%的移除效率和81%的任务完成率

性能权衡分析揭示了关键洞察:工具移除效率与任务完成率存在帕累托前沿关系。在自主模式下,高端模型能同时实现高移除效率(90%+)和高任务完成率(85%+);在工作流模式下,所有模型都实现高移除效率,但任务完成率仍取决于模型能力。这一发现为不同场景下的模式选择提供了量化依据。

注:从此处开始本文的以下内容,为了避免过于冗长,我主要列出一些关键点,作为检索式笔记,方便未来知识的回顾与检索。所以如果你需要阅读详细内容,请移步到文末的参考资料处查阅。

技术演进方向与局限性分析

1. MemTool的局限性

以下列出了一些MemTool的局限性,这是理解该技术框架边界的关键:

自主代理模式的局限:

- 在非推理模型上可靠性差(如Claude 3.5 Sonnet移除效率仅6.2%)

- 高度依赖系统提示设计,提示不佳时高端模型也可能失效

- 当工具计数接近上限时,某些模型无法有效识别并移除足够多的工具

工作流模式的局限:

- 限制了智能体探索额外工具的能力,无法在当前工作流中回溯搜索

- 工具移除过度时缺乏有效的恢复机制

- 两次额外LLM调用增加了系统延迟

混合模式的局限:

- 可能因LLM探索过多工具而突破预定义限制

- 需要精心设计平衡点,避免过度探索或探索不足

- 当工具计数接近上限时,可能触发额外的修剪循环,增加复杂性

论文指出:"MemTool自主代理模式在可靠移除工具方面存在挑战,特别是当使用非推理模型时;这一限制可通过使用MemTool工作流模式解决,后者是确定性的。然而,MemTool工作流模式本身限制了智能体回溯和探索额外工具的能力;因此,MemTool混合模式变得有益,它在确定性结构和智能体自主性之间取得平衡。"

2. 应对策略

针对上述局限,论文提出了具体的应对策略:

自主代理模式增强:

- 添加工具计数监控和预警机制

- 实现动态提示调整,根据工具计数变化优化提示

- 当移除效率低于阈值时自动切换至工作流模式

工作流模式优化:

- 添加有限的回溯机制,允许在必要时重新添加关键工具

- 优化工具移除LLM调用,减少过度移除

- 实现更高效的流水线设计,减少系统延迟

混合模式完善:

- 引入工具重要性评分机制,区分核心工具与临时工具

- 开发基于对话状态的自适应记忆管理

- 探索专用修剪LLM处理边界情况

论文还指出MemTool与长期记忆系统的协同是重要发展方向:"MemTool可以与长期记忆进步相结合,用于使用工具的LLM 智能体。"这表明短期工具记忆与长期工具偏好的接口设计将实现跨会话的无缝过渡,但论文并未提供具体实现细节。

3. 实用工程实施建议

基于论文的实证结果,以下实施建议具有明确的技术依据:

模式选择策略:

- 对于高端推理模型,自主代理模式可提供最佳平衡

- 对于中低端模型,工作流或混合模式更为可靠

- 在关键任务中,优先考虑工作流模式确保稳定性

提示工程优化:

- 必须包含动态工具计数变量

- 明确指定工具移除和添加的触发条件

- 针对不同模型调整提示复杂度

监控体系设计:

- 实时监控工具计数变化率

- 计算滚动移除效率指标

- 跟踪任务完成质量与工具使用的关系

技术实践资源与参考实现

1. 核心算法的实用实现指南

自主代理模式实现要点:

- 严格遵循算法 1的流程设计

- 实现工具计数监控和预警机制

- 确保在工具计数接近上限时优先触发移除操作

- 结合消息摘要技术管理对话历史,避免工具管理占用过多上下文空间

工作流模式实现要点:

- 严格遵循算法 2的三阶段设计

- 为工具移除LLM调用配置低延迟、高精度模型

- 优化工具搜索与执行的流水线设计,最小化中间状态

- 实现递归移除机制处理工具计数超限情况

混合模式实现要点:

- 严格遵循算法 3的流程设计

- 确保工具移除与自主搜索的无缝衔接

- 设计清晰的接口规范,使主LLM无需感知工具移除过程

- 实现错误恢复机制,包含工具重新搜索的退路

2. 系统提示的实用模板

自主代理模式系统提示关键要素:

- 明确LLM的双重职责:回答问题和管理工具上下文

- 包含动态工具计数变量:"当前工具计数:{tool_count}"

- 指导移除/搜索触发条件:"当工具计数超过50时,请移除至少10个无关工具"

- 防止工具溢出的预警提示:"工具计数接近上限,请优先移除至少10个无关工具"

工作流模式专用提示设计:

- 工具移除提示:强制返回精确工具名称列表,避免解释性内容

- 工具搜索提示:引导生成高质量搜索关键词,指定数量范围

- 失败场景的降级策略:逐步放宽搜索条件或触发备用工具集

混合模式提示优化:

- 确保主LLM对工具移除过程"盲区"设计

- 搜索关键词生成的容错机制:允许LLM在首次搜索失败后调整关键词

- 模式切换的动态提示:根据工具计数自动调整提示策略

3. 性能评估的实用工具

工具记忆指标计算工具:

- Avg Removal Ratio 3T的实时计算脚本

- Avg Residual 3T的可视化工具

- Tool Correctness的自动化评估模块

对话稳定性测试框架:

- 100轮连续对话的自动化测试协议

- 工具计数变化的可视化分析工具

- 边界情况的系统性测试方法(工具溢出、工具缺失等)

模型能力评估矩阵:

- 量化记忆管理能力与任务执行能力

- 为模型-模式匹配提供决策支持

- 基于实际任务类型的针对性评估

实用案例

案例1:财务分析多轮对话

场景描述:用户要求比较苹果和微软过去5年的净收入,随后要求分析沃尔玛和塔吉特的股票价格。

MemTool工作流程:

1. 初始查询:"比较苹果和微软过去5年的净收入"

- 自主代理模式:LLM移除无关工具(如get_walmart_stock_price),搜索新工具(get_apple_net_income, get_microsoft_net_income)

- 工作流模式:系统先移除无关工具,再添加新工具,LLM使用新工具回答

- 混合模式:系统移除无关工具,LLM自主添加新工具

2. 后续查询:"分析沃尔玛和塔吉特的股票价格"

- 自主代理模式:LLM识别当前工具(get_apple_net_income等)不相关,移除旧工具,搜索新工具

- 工作流模式:系统自动移除与当前查询无关的工具,添加新工具

- 混合模式:系统移除旧工具,LLM确认需要添加新工具

性能对比:

- 自主代理模式(GPT-o3):工具计数稳定在10-15个,任务完成率90%

- 工作流模式(GPT-4.1 Mini):工具计数稳定在7-8个,任务完成率81%

- 自主代理模式(LLaMA 3 70B):工具计数迅速达到128上限,任务失败

此案例清晰展示了MemTool如何在多轮对话中有效管理工具上下文,避免无关工具占用宝贵上下文空间。

案例2:资源受限环境部署

场景描述:在成本敏感的生产环境中部署MemTool,需要平衡性能与成本。

优化部署方案:

- 使用GPT-4.1 Mini作为工具记忆控制器(工作流模式)

- 配置专用工具移除和搜索LLM调用

- 使用GPT-o3处理复杂任务执行

性能结果:

- 工具移除效率:92.2%(与高端模型相当)

- 任务完成率:81%(接近GPT-4.1的83%)

- 成本降低:相比全高端模型部署降低40-50%

此案例验证了论文中提出的模型混合策略的有效性,为资源受限环境提供了可行的部署方案。

总结

MemTool框架的提出标志着LLM智能体技术在多轮对话工具管理方面的重要突破。通过系统性地解决上下文窗口限制下的工具记忆管理难题,该技术为构建更强大、更可靠的LLM智能体系统提供了关键支撑。

本文详细解析了MemTool的三种核心模式及其适用场景:自主代理模式赋予LLM完全的工具管理自主权,适合sota推理模型处理探索性任务;工作流模式通过确定性架构确保工具管理的可靠性,适合资源受限环境;混合模式则在自主性与确定性之间取得平衡,提供了最佳的综合性能。实验证明,推理型LLM在自主模式下可实现90-94%的工具移除效率,而工作流和混合模式则实现了跨模型一致的高移除效率(90%+)。

这项研究带给我们的关键启示是:工具记忆管理效率与任务完成率存在解耦特性,需根据具体场景权衡选择。对于高探索性任务,应优先选择自主或混合模式搭配高端推理模型;对于高稳定性需求场景,工作流模式更为可靠;在资源受限环境中,采用模型混合策略可实现成本与性能的最佳平衡。

随着LLM智能体技术的持续发展,MemTool有望与长期记忆系统协同工作,推动智能对话系统向更自然、更高效的方向演进。对于开发者而言,理解并应用MemTool的三种模式,将极大提升多轮对话系统的稳定性和效率,为用户带来更流畅、更智能的交互体验。

"MemTool推动了工具使用LLM智能体短期记忆的前沿,提供了证据证明LLM智能体可以有效管理其动态工具的上下文窗口。"这一技术突破将为多轮对话场景中的LLM智能体应用开辟新的可能性,值得每一位AI应用开发者深入研究和实践应用。