今天,豆包大模型团队正式发布文生图技术报告,首次公开 Seedream 2.0 图像生成模型技术细节,覆盖数据构建、预训练框架、 后训练 RLHF 全流程。

该报告针对 Seedream 2.0 原生中英双语理解、文字渲染、高美感、分辨率与画幅变换等特性的实现,进行了具体介绍。

本文将呈现其中精华内容,报告完整版可通过下方链接获取:

技术展示页:https://team.doubao.com/tech/seedream技术报告:https://arxiv.org/pdf/2503.07703

豆包大模型团队文生图模型 Seedream 2.0 于 2024 年 12 月初在豆包 APP 和即梦上线,已服务上亿 C 端用户,并成为国内许多专业设计师辅助创作的首选模型。

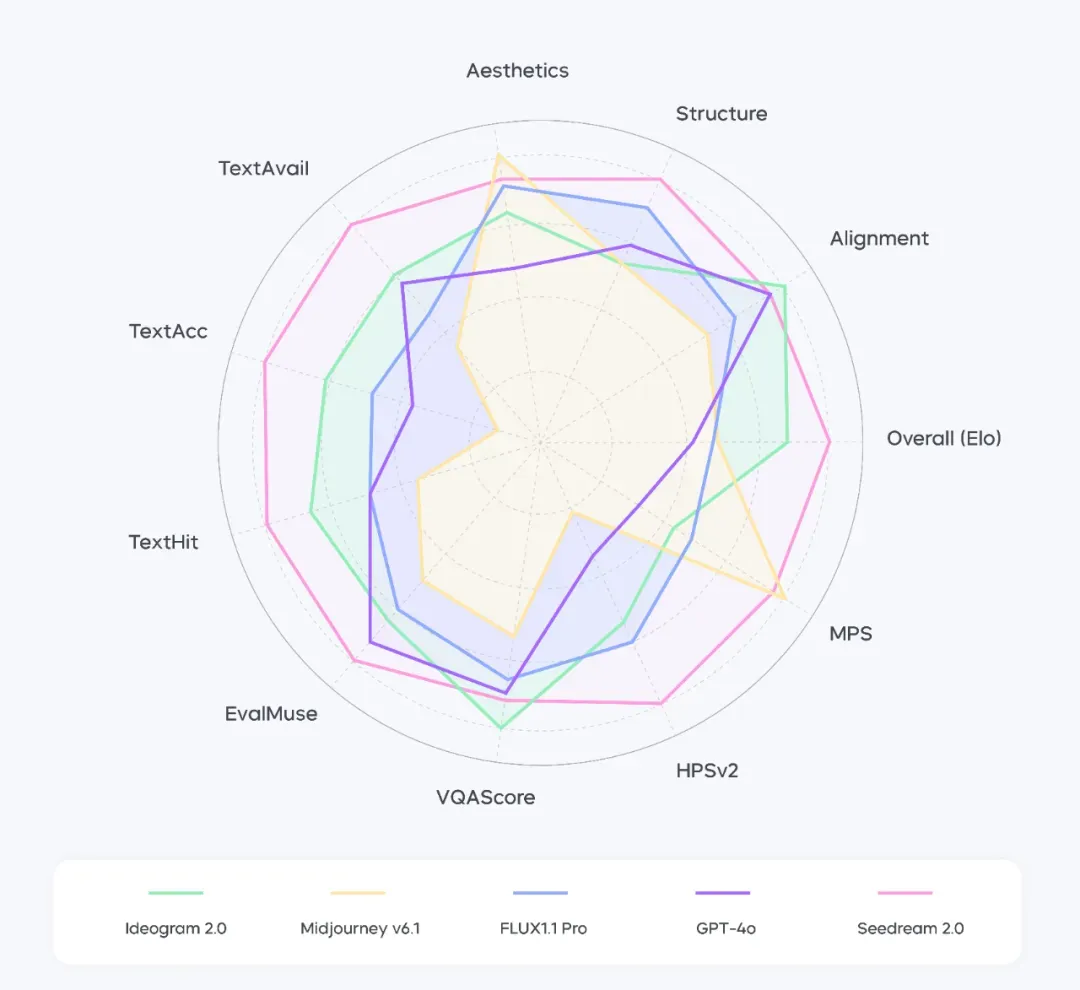

相比 Ideogram 2.0、Midjourney V6.1、Flux 1.1 Pro 等主流模型,该模型更好解决了文本渲染能力欠佳、对中国文化理解不足等诸多实际问题,支持原生中英双语,美感、指令遵循等能力有整体提升。

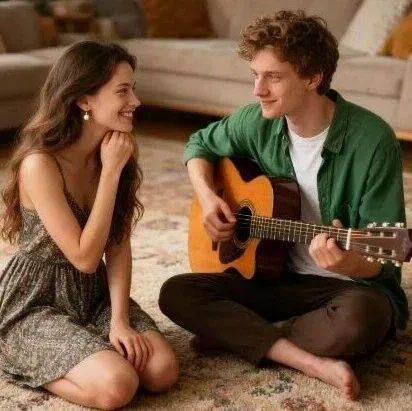

具体来看,模型支持中英文指令的高精度理解与遵循,能生成高美感度的图像作品。

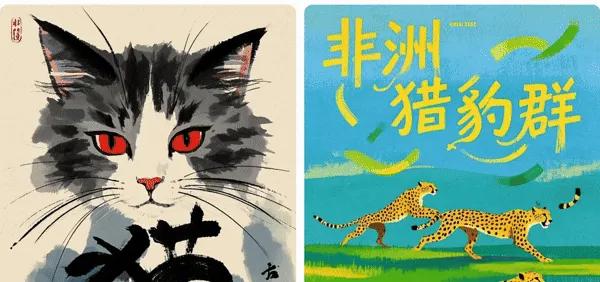

针对字体渲染和海报设计等实际场景,生成文字崩坏率大幅降低,且字体变化呈现更自然、更具美感。

对于国风图案与元素,比如国画、泥塑、文玩、旗袍、书法等,Seedream 2.0 也可输出高品质的呈现结果。

团队为了较全面客观地评估模型,围绕图文匹配度、结构准确率、美感等基础维度,严格构建了 Bench-240 评测基准。

通过测试,团队发现 Seedream 2.0 面向英文提示词,其生成内容的结构合理性、文本理解准确性高于主流模型。

注:面向英文提示词,Seedream 2.0 在不同维度上的表现。本图各维度数据以最佳指标为参照系,已进行归一化调整。

注:面向英文提示词,Seedream 2.0 在不同维度上的表现。本图各维度数据以最佳指标为参照系,已进行归一化调整。

中文综合能力同样突出,其生成与渲染文字可用率达 78%,完美响应率为 63%,高于业界目前其他模型。

注:面向中文提示词,Seedream 2.0 在不同维度上的表现。本图各维度数据以最佳指标为参照系,已进行归一化调整。

注:面向中文提示词,Seedream 2.0 在不同维度上的表现。本图各维度数据以最佳指标为参照系,已进行归一化调整。

以下将从数据预处理、预训练、后训练维度介绍模型技术细节。

1. 深度融合知识的数据预处理框架

生成式 AI 技术,正从规模至上的 “暴力美学” ,向满足特定要求的 “精准智能” 转变,与之同步,数据预处理也演变为复杂的系统工程。

面对百亿量级的中英多模态数据,Seedream 2.0 团队构建了以 “知识融合” 为核心的预处理框架,从以下三个方面实现技术突破。

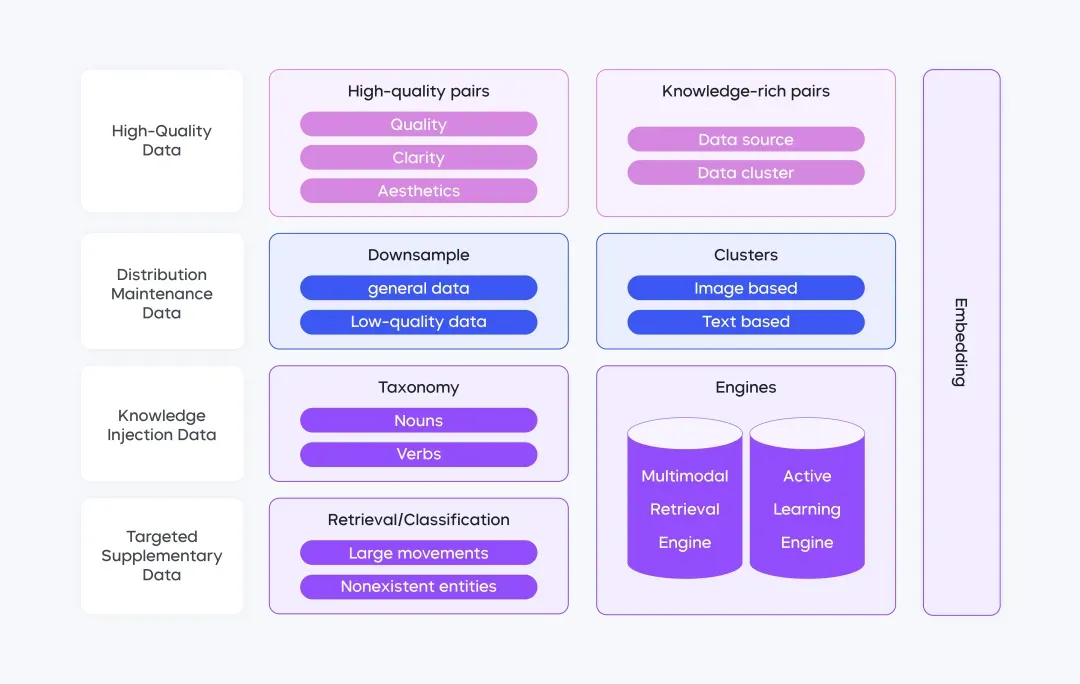

- 四维数据架构,实现质量与知识的动态平衡

传统图像生成模型训练数据筛选常面临 “质量-规模” 的两难抉择,数据量级是模型能力的基础,但大规模数据构建,往往伴随质量下滑,进而影响模型表现。

为此,团队创新设计了四维拓扑网络,突破单一模态限制。该架构包含四个数据层:

1)优质数据层:精选高分辨率、知识密度强的数据(如科学图解、艺术创作),奠定质量基础;

2)分布维持层:采用双层级降采样策略,从数据源维度对头部平台等比降维,从语义维度通过 10 万级细粒度聚类维持多样性;

3)知识注入层:构建 3 万+ 名词和 2000+ 动词分类体系,结合百亿级跨模态检索,为数据注入文化特征;

4)定向增强层:建立 “缺陷发现-数据补充-效果验证” 闭环,优化动作序列、反现实生成等场景。

这一架构有效平衡了数据质量与知识多样性,为模型训练提供坚实的数据支撑。

- 智能标注引擎:三级认知进化

传统标注的 Caption 系统受单模态理解局限,对图像内容描述不够全面精准。团队在其基础上,实现了智能标注引擎的三级认知进化,提升模型理解、识别能力。

首先,构建分层描述体系,通过短、长和特殊场景 Caption 结合,实现多维度、多层级精准图片描述,既能捕捉图像核心内容,又能提供丰富细节与艺术解释。

其次,建立文化专有名词映射库,实现跨语言对齐,将中英文生成质量差异压缩至 2% 以内,提升模型在多语言环境下表现。

最后,引入动态质检机制,利用 LLM 进行预筛选,通过 Badcase 驱动 prompt 模板迭代,优化描述质量,确保数据质量与可靠性。

- 工程化重构:百亿数据的流水线并行处理

工程化方面,传统 ETL 流程存在算力错配与迭代迟滞痛点。

这不仅导致非核心任务占用大量高算力资源,挤占核心任务资源,也造成数据处理流程难以适应业务与数据变化,限制整体效能。

团队从两方面重构工程系统。

一方面通过异构调度,将水印检测等非核心任务迁移至低算力集群,释放高算力资源用于关键任务。另一方面,采用 “分片-校验-装载” 三级流水线并行处理方法,打包速度提升 8 倍。

这些改进大幅提高数据处理效率与质量,为大规模数据管理利用奠定基础。

2. 预训练聚焦双语理解与文字渲染

在预训练阶段,团队基于大量用户调研与技术预判认为,多语言语义理解、双语文字渲染和多分辨率场景适配等模块的突破,对于图像生成技术发展极为关键,可大幅提升模型适用性与用户体验,满足不同语言文化背景的用户需求,并拓展应用场景。

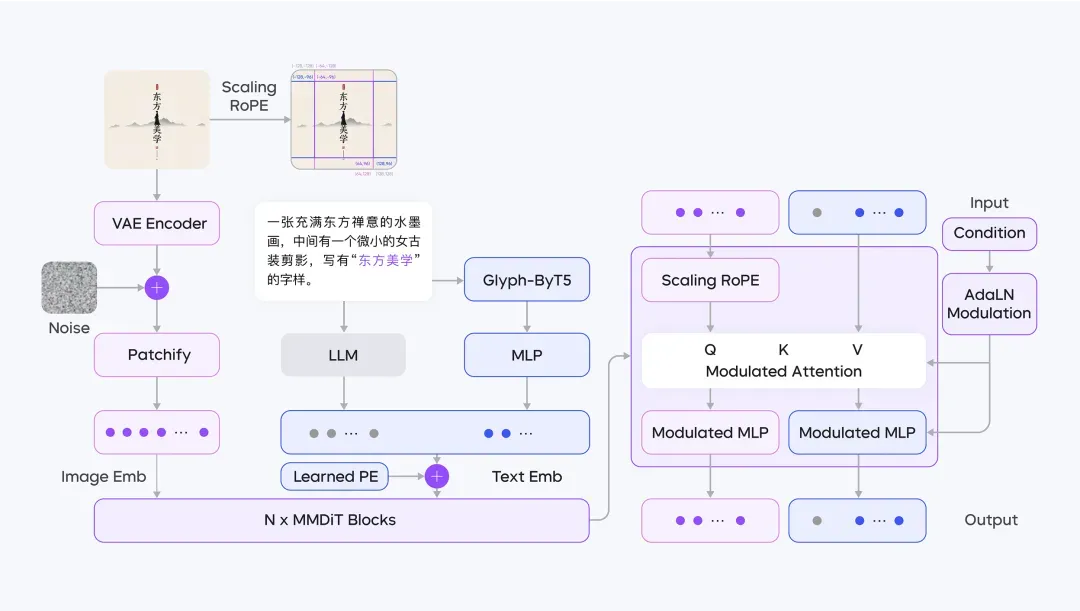

因此,Seedream 2.0 采用了全新的预训练架构设计,其整体框图如下。

具体来看,Seedream 2.0 从三个方面实现了关键技术升级。

- 原生双语对齐方案,打破语言视觉次元壁

面向双语文生图场景,传统的 CLIP/T5 编码器对中文语义和文化细节的捕捉能力有限,大语言模型虽具备多语言理解能力,但文本嵌入与图像特征的空间分布差异却导致扩散模型训练难以收敛。

为此,团队提出基于 LLM 的双语对齐方案。通过大规模文本-图像对数据,微调 Decoder-Only 架构的 LLM,使文本 Embedding 与视觉特征形成空间映射对齐。

同时,针对中文书法、方言俚语、专业术语等场景构建专用数据集,加强模型对文化符号的深度理解与感知。

这种“预训练对齐 + 领域增强”的双轨策略,使模型能够直接从大量中英文数据中习得“地道”的本土知识,进而,准确生成具有文化细微差别的中文或英文美学表达图像,打破不同语言与视觉的次元壁。

- 让模型既看懂文本,又关注字体字形

在过去,图像生成模型的文本渲染常面临两难困境:依赖 ByT5 等字形模型易导致长文本布局混乱,而引入 OCR 图像特征又需额外布局规划模块。

为此,团队构建了双模态编码融合系统—— LLM 负责解析“文本要表达什么”,ByT5 专注刻画“文字应该长什么样”。

具体来说,通过 MLP 投影层,将 ByT5 的字形特征对齐到 LLM 语义空间,二者拼接后输入扩散模型。

此种方法下,字体、颜色、大小、位置等渲染属性不再依赖预设模板,而是通过 LLM 直接描述文本特征,进行端到端训练。

如此一来,模型既能从训练数据中学习文本渲染特征,也可以基于编码后的渲染特征,高效学习渲染文本的字形特征。

- 三重升级 DiT 架构,让图像生成缩放自如

多分辨率生成是图像生成场景的常用需求,团队在 SD3 的 MMDiT 架构基础上,进行了两重升级:

其一,在训练稳定性方面。团队引入 QK-Norm 抑制注意力矩阵的数值波动,结合全分片数据并行策略(FSDP),使模型训练收敛速度提升 300%。

其二,团队设计了 Scaling ROPE 技术方案。传统二维旋转位置编码(RoPE)在分辨率变化时,可能会导致位置标识错位。Seedream 2.0 通过动态缩放因子调整编码,使图像中心区域在不同宽高比下,保持空间一致性。这使得模型在推理过程中,能够生成从未训练过的图像尺寸和各种分辨率。

3. 后训练 RLHF 突破能力瓶颈

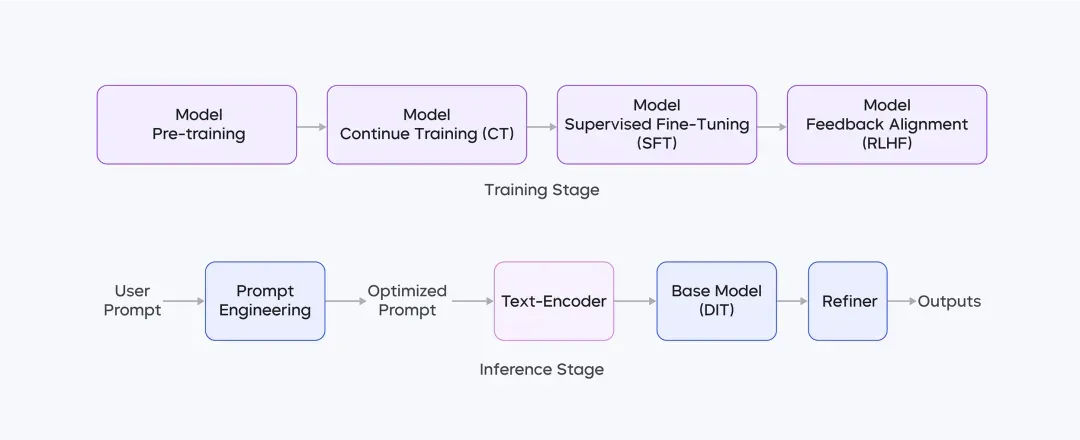

Seedream 2.0 的后训练过程包含四个阶段:

其中,CT 和 SFT 增强模型美学吸引力;人类反馈对齐(RLHF)利用自研奖励模型与反馈算法,提升模型整体性能;Prompt Engineering 借助微调大语言模型优化美学与多样性表现;超分模型提高图像分辨率并修复细微结构错误。

其中最值得一提的是,团队开发了基于人类反馈对齐的(RLHF)优化系统,提升了 Seedream 2.0 整体性能。

其核心工作包含以下三个方面:

- 多维度偏好数据体系,提升模型偏好上限

团队收集并整理了一个多功能的 Prompt 集合,专门用于奖励模型(RM)训练和反馈学习阶段,并通过构建跨版本和跨模型标注管道,增强了 RM 的领域适应性,并扩展了模型偏好的上限。

在标注阶段,团队构建了多维融合注释。这一做法成功扩展了单一奖励模型的多维度偏好表征边界,促进模型在多个维度上实现帕累托最优。

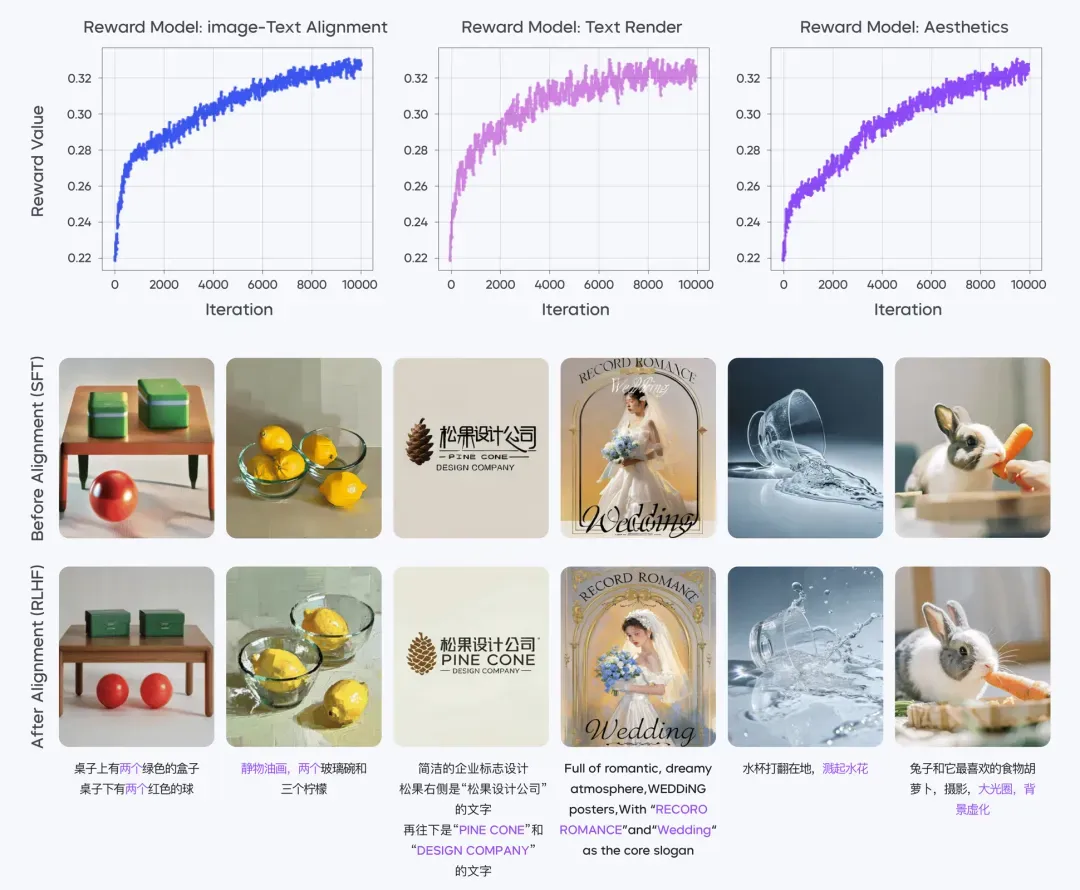

- 三个不同奖励模型,给予专项提升

Seedream 2.0 直接利用 CLIP 嵌入空间距离,作为基础奖励值。这省去了回归头等冗余参数结构以及不稳定训练情况。

同时,团队精心制作并训练了三个不同的奖励模型:图像文本对齐 RM、美学 RM 和文本渲染 RM。

其中,文本渲染 RM 引入了触发式激活机制,在检测到“文本生成”类标签时,模型将强化字符细节优化能力,提升汉字生成准确率。

- 反复学习,驱动模型进化

团队通过直接最大化多个 RM 的奖励,以改进扩散模型。通过调整学习率、选择合适的去噪时间步长和实施权重指数滑动平均,实现了稳定的反馈学习训练。

在反馈学习阶段,团队同时微调 DiT 和文本编码器。此种联合训练显著增强了模型在图像文本对齐和美学改进方面的能力。

经过 RLHF 阶段对扩散模型和奖励模型的多轮迭代,团队进一步提高了模型性能。

奖励曲线显示,在整个对齐过程中,不同奖励模型的表现分数值都呈现稳定且一致的上升趋势。

4. 写在最后

此次技术报告的发布,旨在推动图像生成技术进一步发展,加强业内交流。

展望未来,团队将持续探索更高效地 Scaling 模型参数及数据的创新技术,进一步提升模型的性能边界。

伴随 2025 年强化学习浪潮兴起,团队将持续探索基于强化学习的优化机制,包括如何更好地设计奖励模型及数据构建方案。

后续,豆包大模型团队也将持续分享技术经验,共同推动行业发展。