大家好,我是肆〇柒。今天来看看来自浙江大学与阿里巴巴集团联合研究团队的最新工作——《Scaling Generalist Data-Analytic Agents》。这项研究不仅提出了名为 DATAMIND 的高质量数据合成与智能体训练框架,更训练出了在多项基准上超越 GPT-5 的开源数据分析智能体 DATAMIND-14B,为构建专业领域 Agentic AI 提供了一套可复现、可扩展的方法论。

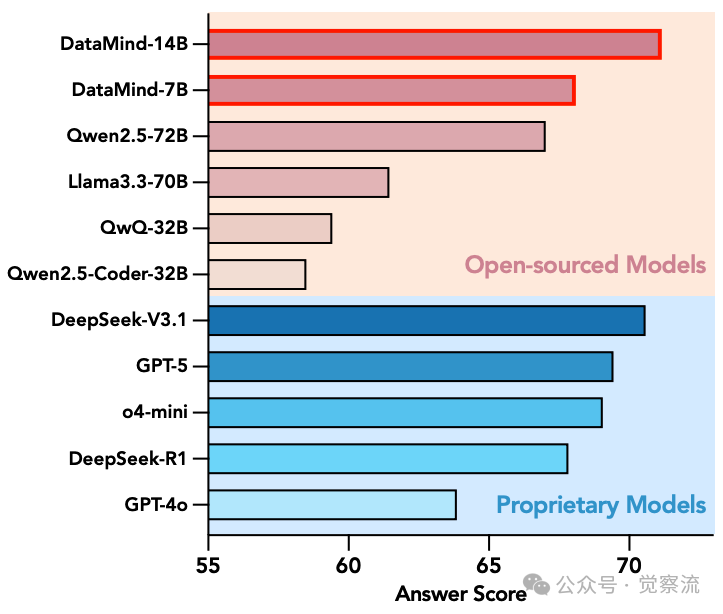

随着AI进入"下半场",面向日益复杂和特定领域场景的LLM智能体(LLM Agentic)基准测试正迅速涌现。在这一趋势中,自动化数据分析作为科学发现的关键支柱,对实现"创新AI"愿景至关重要,展现出提升研究效率和加速科学发现的潜力。然而当前的数据分析智能体过度依赖专有模型的提示工程或多智能体架构,而开源模型在处理多样格式、大规模数据文件和真实世界分析所需的长视野多步推理方面仍面临严峻挑战。DATAMIND的出现不仅带来了一个高性能模型(DATAMIND-14B以71.16%的平均得分超越GPT-5),更提供了一套可扩展的数据合成和智能体训练配方,为构建专业领域智能体提供了系统化指导。

专业智能体构建的三大核心挑战与对应解决方案

专业领域智能体的构建面临着一系列固有挑战,这些挑战在数据分析场景中尤为突出。以下将挑战与DATAMIND的解决方案一一对应分析。

挑战一:数据资源不足与DATAMIND的应对

训练专业智能体需要大规模、高质量的任务集合及其对应的解决方案轨迹,但公开可用的数据分析基准测试通常仅提供有限的评估测试集,缺乏逐步轨迹注释,使得无法从现成资源中组装有效的训练语料库。真实世界的数据分析任务要求处理多样格式(CSV、Excel、SQLite等)、大规模数据(>1,000行)以及多步骤推理,这使得数据合成既必要又困难。

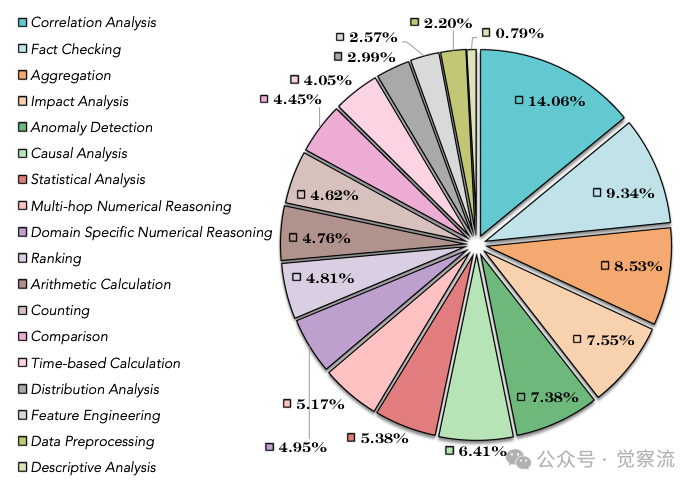

18个细粒度数据分析任务类别分布

如上图研究团队设计的18个细粒度数据分析任务类别呈现明显的长尾分布特性,相关性分析(Correlation Analysis)占比最高(14.06%),事实核查(Fact Checking)占9.34%,而描述性分析(Descriptive Analysis)仅占0.79%。这种不均衡分布反映了真实数据分析场景的特性——用户更关注发现数据间的关系而非简单描述,为合成查询提供了真实分布依据。

为应对这一挑战,DATAMIND从互联网和开源社区收集了3,400个.csv和560个.xlsx文件,并过滤掉无法加载、过小(<20行)或过大(>1,000行)的文件,以及包含异常数据类型的文件。对于数据库文件,研究团队从BIRD和OmniSQL中获取了1,954个.sqlite文件,构建了涵盖多种格式的多样化数据源。通过细粒度任务分类和递归易到难任务组合机制,系统性地生成多样化查询,有效解决了数据资源不足的问题。

案例展示:薪资差异分析

让我们通过一个具体案例来理解DATAMIND的工作流程。想象你是一名人力资源分析师,需要回答:"2020年亚裔男性和黑人男性的年薪中位数差异是多少?"(What is the difference between the median annual salaries of Asian Men and Black Men in the year 2020?)。这个问题属于"相关性分析"类别(第一张图中占比最高的类别)。

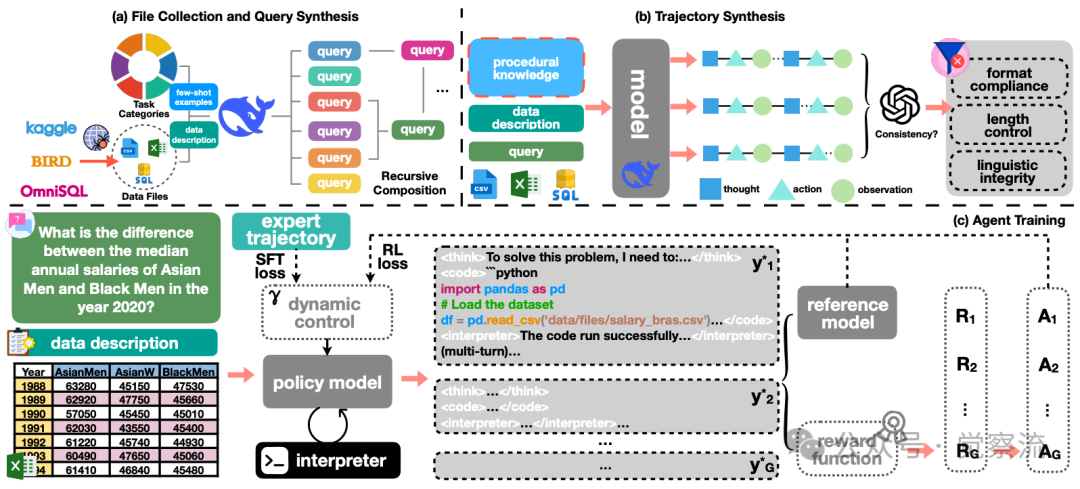

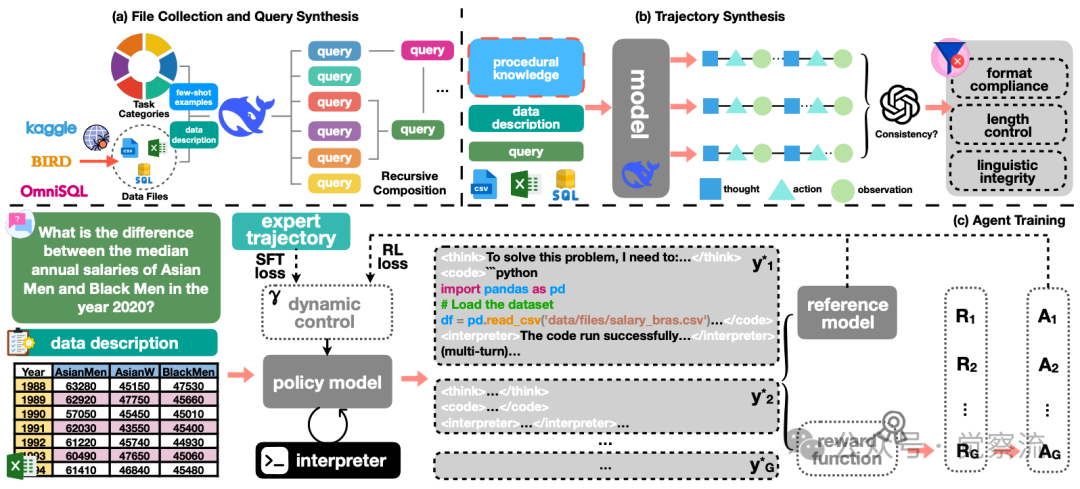

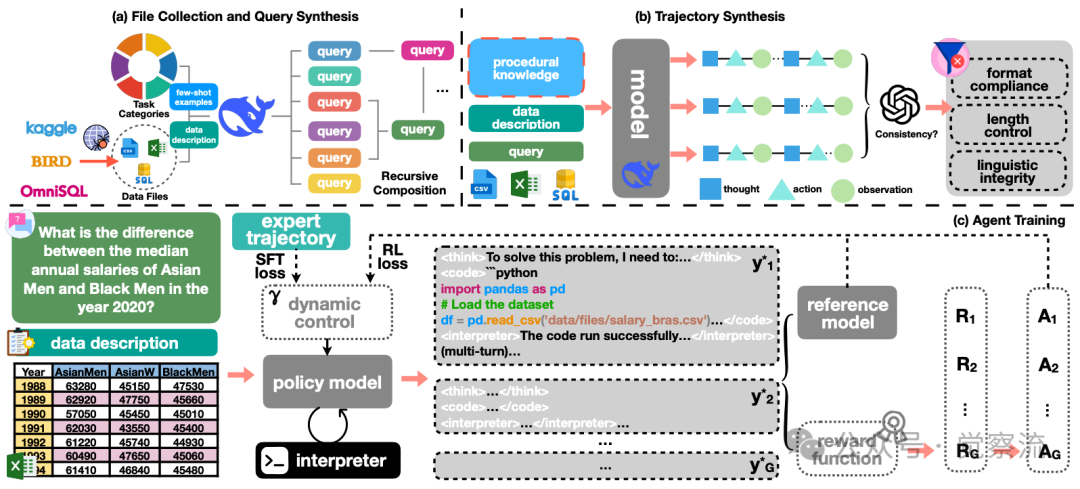

DATAMIND全流程架构

上图清晰展示了DATAMIND如何处理这个具体任务:

1. 数据输入:DATAMIND接收包含历年薪资数据的CSV文件(如上图所示,包含Year, AsianMen, AsianW, BlackMen等列)

2. 任务分类:系统识别这是"相关性分析"任务,并应用相应的高阶工作流

3. 多轮推理:首先加载数据并检查结构,然后筛选2020年数据,计算中位数差异

4. 结果输出:最终返回类似<answer>The difference is $12,345.</answer>的精确答案

通过这个具体案例,我们可以看到DATAMIND如何将复杂的多步骤推理过程自动化,而无需用户编写任何代码。在实际应用中,用户只需提出自然语言问题,DATAMIND就能自动完成从数据加载、预处理到最终结果生成的全过程。

挑战二:训练策略不当与DATAMIND的应对

长视野智能体训练的稳定性问题不容忽视。当前的智能体训练策略通常遵循SFT-then-RL范式,但在新场景中,如何稳定长视野智能体训练以及如何在SFT和RL之间分配训练步骤以实现最佳性能仍不明确。在多步骤推理过程中,模型可能因外部反馈和多轮次复合错误而经历分布漂移,极易导致轨迹崩溃,从而使强化学习训练不稳定。

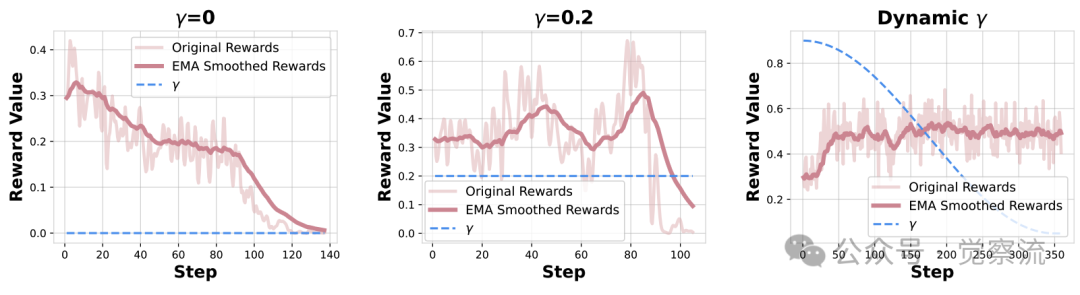

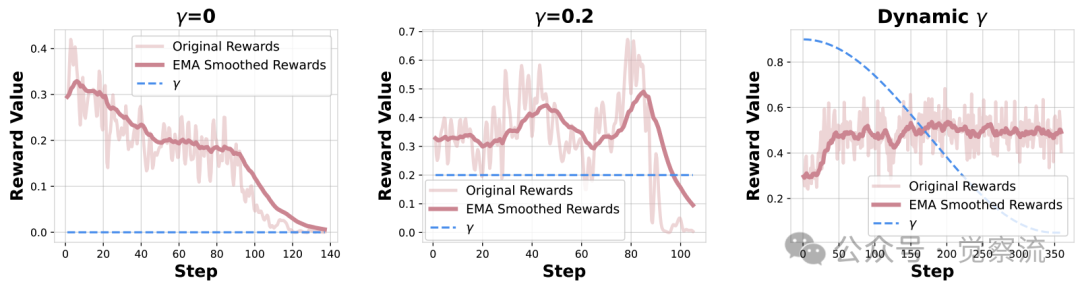

SFT损失对RL训练的影响

实验数据显示,当不施加SFT损失(γ=0)时,答案奖励几乎单调下降;当γ提高到0.2时,答案奖励虽有初始上升但随后崩溃;而采用动态γ策略(从0.9退火至0.05)则能实现稳定训练。这表明SFT损失既是RL训练的有效稳定器,也可能成为不稳定训练的罪魁祸首。

SFT与RL的动态平衡:可以将SFT(监督微调)比作"老师手把手教学",而RL(强化学习)则像"让学生独立解决问题"。DATAMIND的创新在于动态调整这两种教学方式的比例——开始时老师指导较多(γ=0.9),随着学生能力提升,逐渐放手让学生自主探索(γ降至0.05)。正如论文中所述:"训练过程 resembles raising a child。在童年早期,持续的父母指导(高γ)对防止孩子误入歧途至关重要。随着孩子成长,过度监督会抑制孩子自我探索的内在动力。"

DATAMIND通过动态调整SFT和RL损失的权重来解决这一问题。研究团队将γ参数从峰值0.9通过余弦衰减调度到谷值0.05,使模型首先从SFT损失中获取稳定监督,随后逐渐减少SFT权重以鼓励探索。同时,实施Void Turns过滤机制,将无法产生有效代码片段或答案的智能体循环定义为"无效轮次",并直接屏蔽这些轨迹对损失的贡献,有效防止了轨迹崩溃。此外,采用DAPO(Decoupled Clip and Dynamic Sampling Policy Optimization)算法,通过每令牌重要性采样比率和优势函数平衡探索与利用,确保训练过程的稳定性。

挑战三:代码执行环境不稳定与DATAMIND的应对

基于代码的多轮交互环境稳定性是第三大挑战。数据文件和代码解释器涉及复杂的内存管理,而并行智能体rollout和有限内存资源下的多轮代码生成将进一步加剧这一问题。

DATAMIND全流程架构

上图清晰展示了DATAMIND如何解决这一挑战。研究团队实施了三大关键创新:

DATAMIND解决环境稳定性的三大创新:

1. 异步交互:将模型生成和代码执行解耦,避免同时发生文件I/O和代码执行高峰

- 效果:解耦GPU和CPU内存需求峰值,防止系统崩溃

2. 块式代码维护:仅保留文本代码块而非全局变量池

对比:传统笔记本系统维护全局变量池(内存密集型),而DATAMIND在运行时动态连接代码片段

- 优势:实现相同的全局执行效果而无需额外内存开销

3. 安全控制:为每个轨迹设置隔离环境

具体措施:严格限制CPU时间和峰值内存,过滤不安全函数调用

额外功能:自动包安装机制,动态检查并安装缺失的Python包

这些措施共同构建了一个高效稳定的多轮代码执行框架,为长视野推理提供了坚实基础。

DATAMIND的方法框架

DATAMIND采用系统化方法应对上述挑战,其核心在于数据合成、训练策略和环境构建三个维度的创新设计。

DATAMIND全流程架构

上图清晰展示了这一框架的四个关键组件:细粒度任务分类与递归任务组合、知识增强轨迹采样与过滤、动态调整的训练目标以及内存高效的多轮代码执行框架。

数据合成:质量优先的轨迹构建

DATAMIND的数据合成流程始于多样化数据文件的收集,随后通过细粒度任务分类和递归组合机制生成高质量查询。研究团队为每个任务类别精心设计了46个示例查询作为少样本演示,确保生成的查询既多样又符合任务特性。通过递归易到难任务组合机制,将简单任务链接为多跳分析挑战,通过迭代25次逐步提高难度。

知识增强的轨迹采样流程包括:为每个问题类别手动设计高阶工作流k,编码过程性知识并引导模型在轨迹合成过程中的行为;采样N=3次独立轨迹;使用基于GPT-4o-mini的judge模型验证最终答案是否与推理理由一致;仅保留收敛到相同答案的轨迹。对于不一致的轨迹,将judge模型的思维链反馈给智能体进行反思修正,这一救援循环不仅挽救了额外可用数据,还能丰富思维模式的多样性。

研究团队实施了三层规则过滤:格式合规性(确保符合ReAct格式)、长度控制(最终答案<1,024 tokens)和语言完整性(消除乱码文本或混合自然语言),最终保留11,707条高质量轨迹,命名为DATAMIND-12K。值得注意的是,尽管DATAMIND-12K仅含12K轨迹,而TableLLM和Table-R1分别使用20K和2.5M的训练数据,但DATAMIND系列模型在多个基准测试上仍取得最佳表现。从Table 1可见,DATAMIND-14B在DABench上达到80.29%(pass@1),大幅领先Table-R1-14B的45.33%;在TableBench上达到70.95%,优于Table-R1-14B的50.38%。这一结果有力证明了"高质量轨迹比大量低质量轨迹更重要"的论点。

训练策略:动态平衡的SFT-RL范式

DATAMIND在训练策略上突破了传统SFT-then-RL范式,采用动态平衡SFT和RL损失的方法。研究团队将γ参数从峰值0.9通过余弦衰减调度到谷值0.05,使模型首先从SFT损失中获取稳定监督,随后逐渐减少SFT权重以鼓励探索。

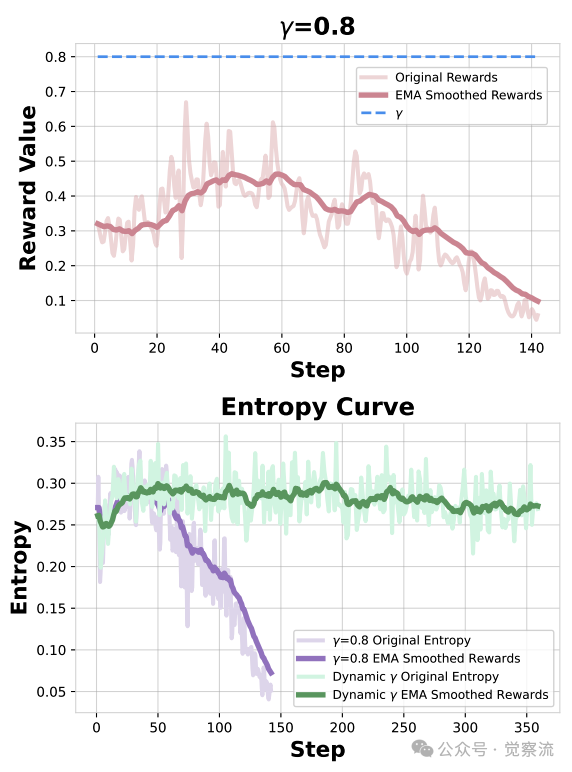

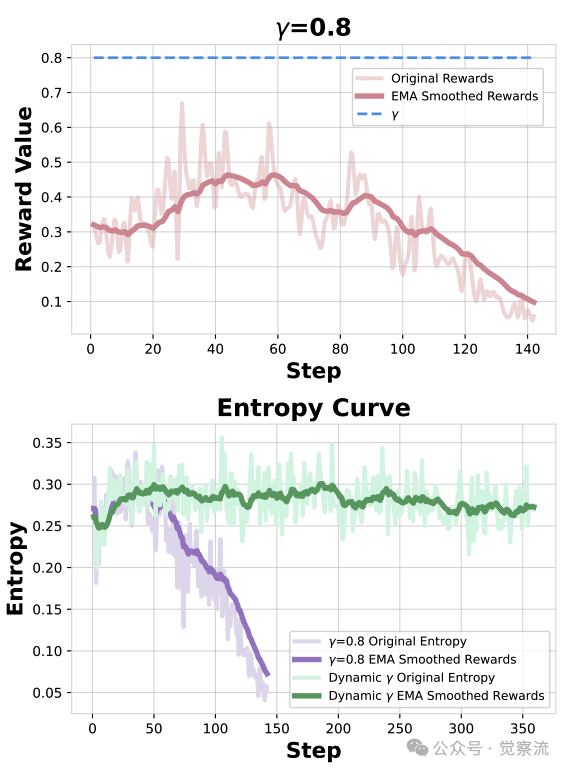

不同γ设置下的答案奖励与熵动态

上图揭示了SFT损失的双重角色:当γ固定在高位(0.8)时,答案奖励先短暂上升,随后逐渐下降,同时策略熵急剧降低,表明模型陷入刚性思维模式;而动态γ策略能保持策略熵在较高水平,确保模型持续探索能力。研究团队将训练过程比喻为"培养孩子":在早期需要大量指导(γ=0.9),随着模型成熟,逐渐放手(γ=0.05),让模型通过环境反馈发现自身真正能力。

DAPO算法的应用进一步优化了训练过程,其中clip参数εlow和εhigh分别设置为0.2和0.28,以平衡探索与利用。奖励设计包含格式奖励rformat、答案奖励ranswer和长度奖励rlength三部分,其中长度奖励定义为:当答案长度l ≤ lmin时为1;当lmin < l ≤ lmax时线性衰减至0.5;当l > lmax时固定为0.5。研究团队设置lmin和lmax分别为256和1024,以防止模型通过幻觉过多令牌来"破解"答案奖励。此外,使用EMA平滑奖励值以避免训练过程中的剧烈波动,确保训练稳定性。

环境构建:内存高效的多轮执行框架

DATAMIND的环境构建针对数据分析场景的特殊需求进行了多项创新,已在"挑战三"部分详细说明,此处不再赘述。关键点在于:异步交互、块式代码维护和安全控制三大创新共同构建了一个稳定、高效的多轮代码执行框架,为长视野推理提供了坚实基础。

从DATAMIND学到的三大核心经验

DATAMIND的实验分析揭示了专业智能体训练中的三大关键经验,这些发现对构建其他领域智能体具有重要参考价值。

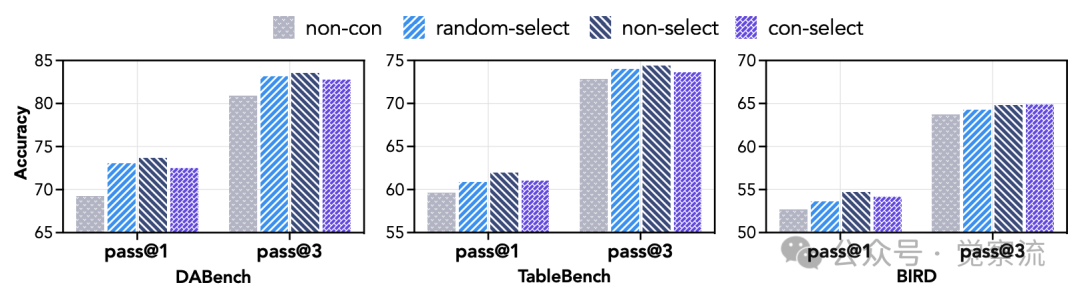

经验一:自一致性过滤比最佳轨迹选择更重要

自一致性过滤与最佳轨迹选择分析

在7B模型的SFT阶段分析表明,移除自一致性过滤(non-con)导致DABench的pass@1从61.92%降至61.03%,降幅相对较小但显著。值得注意的是,当最终答案一致时,随机选择轨迹的pass@3得分与最佳选择(con-select)相当甚至更高。

更关键的是,包含所有收敛到一致答案的轨迹(不进行选择)能获得最大的性能提升。这一模式在所有数据集上都成立,表明轨迹中嵌入的推理模式和问题解决策略的多样性对模型推理能力的提升更为有益。这与Guha等人研究发现一致,尽管我们不能完全排除引入的更大训练量的贡献。这一经验表明,在数据合成过程中,确保答案一致性比选择"最佳"轨迹更重要,而保留多样化的解决路径则能进一步提升模型能力。

经验二:SFT损失的双重角色与动态平衡

SFT损失既是RL训练的有效稳定器,也可能成为不稳定训练的罪魁祸首。

SFT损失对RL训练的影响

上图显示,当不施加SFT损失(γ=0)时,答案奖励几乎单调下降,主要由于7B模型有限的多步推理能力难以生成高质量轨迹组,以及数据结构和代码语言的异质性导致轨迹分布高度不平衡。

提高γ到0.2能在一定程度上缓解问题,答案奖励虽有初始上升但仍会崩溃。而采用动态γ策略,模型首先享受强SFT损失的稳定监督,随后逐渐减少SFT系数以鼓励探索,实现了整个训练过程的稳定。

不同γ设置下的答案奖励与熵动态

上图进一步揭示了固定高γ值会导致策略熵崩溃,使模型陷入专家轨迹中的刚性思维模式,而动态γ策略能保持策略熵在较高水平。研究团队将训练过程比喻为"培养孩子":在早期需要大量指导(γ=0.9),随着模型成熟,逐渐放手(γ=0.05),让模型通过环境反馈发现自身真正能力。这一经验强调了在训练过程中动态调整SFT和RL权重的重要性,避免过早陷入局部最优或过晚失去方向。

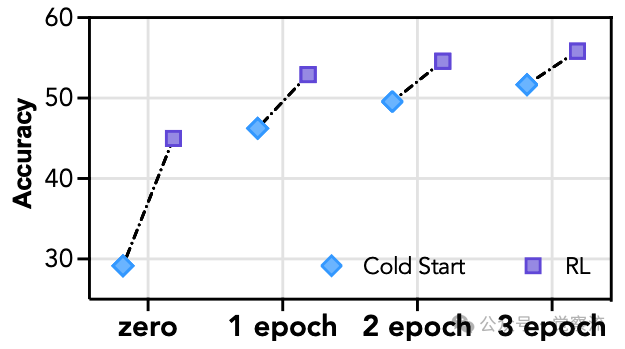

经验三:RL缩小差距但无法逆转顺序

冷启动与RL的性能差距

实验数据显示,随着冷启动训练周期增加,RL带来的边际收益递减。重要的是,尽管RL缩小了性能差距,但post-RL性能仍与基础模型能力正相关。这证实了大部分知识是在监督微调阶段习得的,而强化学习主要起到激发潜在能力的作用,而非强行突破模型固有的能力边界的观点。

研究团队指出:"强化学习可以缩小不同基础模型之间的性能差距,但很难逆转其优劣顺序" 特别值得注意的是,当冷启动足够强时,RL带来的改进空间将大幅缩小,这引发了一个关键问题:是否存在一个性能饱和点,使得RL不再有效?如果存在,是什么根本机制(如策略空间饱和、探索信号减弱或奖励模型的内在限制)导致RL失效?这一经验表明,SFT阶段获取的知识是模型能力的基础,而RL主要用于解锁潜在能力,而非突破模型的固有能力边界。

为什么我们应该关心DATAMIND?

即使你不是AI专家,DATAMIND的技术进步也将直接影响你的工作和生活:

- 对非技术工作者:未来你可能只需用自然语言提问(如"上季度销售额最高的产品是什么?"),就能获得专业级的数据分析结果,无需学习复杂的数据工具

- 对数据科学家:DATAMIND能自动化处理繁琐的数据预处理和基础分析,让你专注于更高价值的洞察发现

- 对科研人员:加速科学发现过程,如论文中提到的"Scimaster: Towards general-purpose scientific AI agents"研究,将帮助研究人员更快地从数据中获取洞见

专有模型与开源模型性能对比

DATAMIND-14B以71.16%的平均得分显著优于最强专有模型GPT-5(69.44%)和DeepSeek-V3.1(70.58%),而DATAMIND-7B(68.10%)也优于所有开源模型。这一结果直观证明了DATAMIND方法论的有效性,打破了"专有模型必然优于开源模型"的固有认知。

从技术到人文

想象一下,五年前,只有专业数据科学家才能进行复杂的数据分析;今天,DATAMIND这样的技术正在将这种能力带给每一位知识工作者。就像Excel曾经让电子表格分析变得普及一样,DATAMIND正在让高级数据分析变得触手可及。

在论文中,研究团队将训练过程比喻为"培养孩子"——这不仅仅是一个技术类比,更反映了AI发展的人文维度。我们不是在创造取代人类的超级智能,而是在培养能与人类协作的"专业助手",它们擅长处理繁琐的技术细节,而人类则专注于更高层次的思考和决策。

DATAMIND提供了一套可复用的专业智能体构建框架,其核心价值不仅在于构建了高性能的数据分析智能体,更在于提供了一套可扩展的数据合成和智能体训练配方。研究团队强调"质量优先"的数据合成理念对开源社区的重要价值:尽管DATAMIND-12K仅包含12K轨迹,而TableLLM和OmniSQL分别使用20K和2.5M的训练数据,但DATAMIND系列模型在多个基准测试上仍取得最佳表现。

专业智能体训练如同"教育"过程的深刻启示值得重视:从指导到放手的渐进过程对模型能力发展至关重要。研究团队也坦承当前工作的局限性:a) 目前仅包含推理导向的数据分析任务,训练、预测和数据可视化任务被有意排除;b) 受限于计算资源,实验骨干模型仅限Qwen家族,模型规模上限为14B;c) 由于计算资源限制,尚未全面评估所有RL训练算法,且数据稀缺将RL运行限制在约350步。

GitHub代码库(https://github.com/zjunlp/DataMind)已提供。这些资源和方法论将助力研究者构建各自专业领域的智能体,共同推动"创新AI"愿景的实现,加速科学研究效率并促进科学发现。DATAMIND所展示的方法论框架,不仅适用于数据分析领域,也为构建其他专业领域的智能体提供了系统化指导。