1.引言

大家好,我是小米,一个31岁、依然热爱编码的程序员大哥哥~

今天给大家分享一个我最近在项目里踩坑无数、最后“高光时刻”拯救全组的进阶配置经验——LangChain4j 的 API 进阶配置四大件:日志、监控、重试、超时。

你以为 LangChain4j 就只是个 Java 包装器?错!配置对了,它能稳定、健壮、可观测,能用得安心、跑得漂亮!

那我们就从一个真实故事开始吧~

2.一场“大模型失联”事故的前因后果

事情要追溯到我在组里负责接入 OpenAI API,用的是 LangChain4j 框架,初上手一切顺利,团队里谁都没想到,这玩意在生产环境里——

会!掉!线!

是的,我们在凌晨 1 点,看到 AI 助理系统突然疯狂报错,日志里干干净净,连个错误栈都没有,用户问一个问题,系统沉默寡言,客服开始炸锅。

于是我火速起床开电脑,拉上 ChatOps、看日志、问 Ops……整个过程我心里只有一个念头:

“要是我早点配上日志、监控、重试、超时机制,就好了!!!”

第二天我就给 LangChain4j 做了全面进阶配置,之后系统稳定如老狗,再没掉链子。现在就来跟大家复盘我做了哪些配置吧~

3.开口说话的 LangChain ——日志 Logging 配置

最基础也是最关键的,就是日志配置了。LangChain4j 默认是用SLF4J

作为日志接口,我们可以用 Logback、Log4j2 这些作为实现。

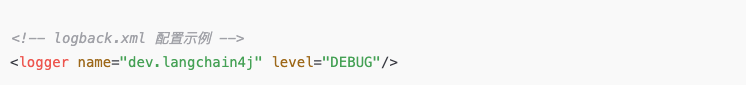

1)开启 DEBUG 日志

我们只需要配置一下日志级别,就可以看到完整的请求响应日志了:

图片

图片

然后你就可以在控制台里看到像这样的内容:

图片

图片

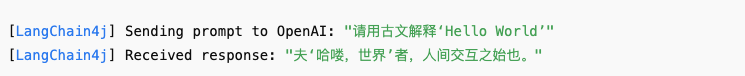

2)日志内容定制

LangChain4j 中很多组件都实现了 LoggingInterceptor,你可以自定义:

图片

图片

然后在注册 LLM client 时加上:

图片

图片

这样你就能优雅地监控每一轮对话过程了~

4.不是黑盒的 AI ——监控 Observability 配置

以前我们总觉得“AI 就是个黑盒”,但别忘了,LangChain4j 是 Java 世界的 AI 桥梁,我们可以完全把它变得可观测!

这里我引入了两个好帮手:

1)Micrometer + Prometheus 组合拳

LangChain4j 的核心组件支持自定义指标上报,你可以封装 Metrics 逻辑,比如:

图片

图片

然后就可以用 Prometheus + Grafana 画出超酷的监控面板,像这样:

- 每分钟请求数

- 平均响应时间

- 成功率 vs 错误率

是不是瞬间从“黑盒 AI”变成“智能透明玻璃盒”?

5.不给网络波动机会 ——重试机制 Retry Configuration

想象你调用大模型 API,结果网络抖了一下、OpenAI 响应超时、或返回 502……直接挂了多糟心!

LangChain4j 支持非常灵活的重试配置,基于 RetryPolicy 来实现。

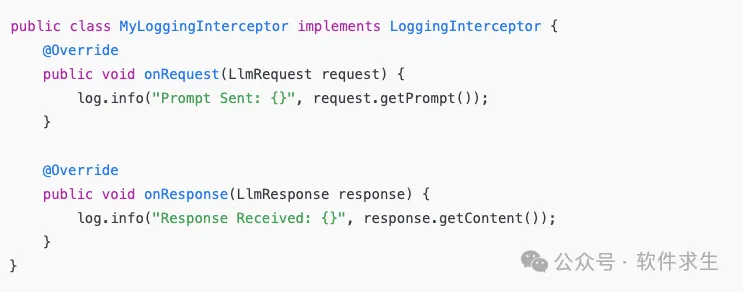

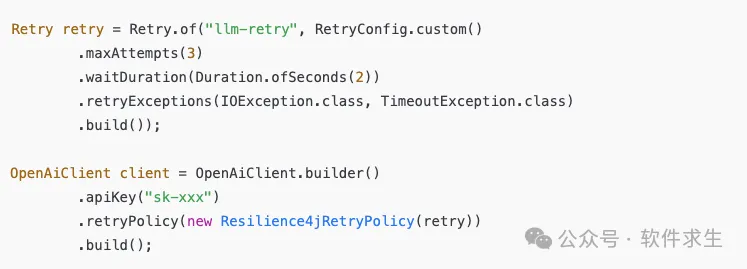

1)用 Resilience4j 实现重试

图片

图片

重点解释:

- maxAttempts(3):最多尝试三次

- waitDuration(2s):每次失败后等待 2 秒

- retryExceptions(...):只对网络异常进行重试,逻辑错误不重试(很合理)

注意:

你也可以设置 exponential backoff 策略,自动延长间隔时间,防止疯狂打 API~

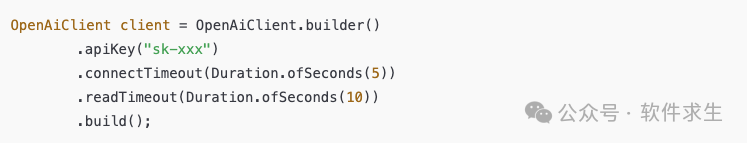

6.救你于“卡顿”边缘 ——超时配置 Timeout Configuration

超时配置也是我强烈建议大家立刻加上的一项,它能防止调用卡死系统线程。

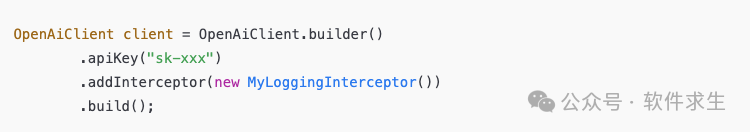

LangChain4j 支持在构建 Client 时配置 Timeout:

图片

图片

解释下两个 Timeout:

- connectTimeout:建立 TCP 连接的最大等待时间

- readTimeout:等待响应的最大时间

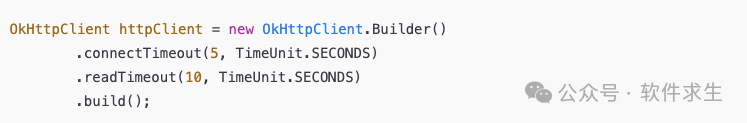

如果你用的是 HTTP 客户端如 OkHttp,还可以设置全局超时:

图片

图片

然后通过 LangChain4j 的自定义 HTTPClient 注入进去~

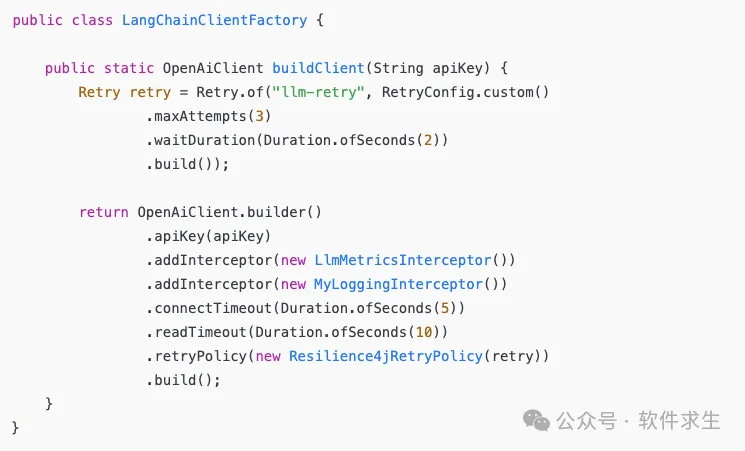

7.组合拳:配置模板封装(建议收藏!)

我建议大家把这四大配置封装成一个统一的 Client Builder 工具类,这样复用更方便:

图片

图片

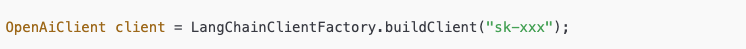

之后你就可以这样创建 LLM:

图片

图片

可观测、有日志、能重试、设了超时,一整套打包搞定,稳!

8.写在最后:别等挂了再补配置!

还记得开头那个凌晨1点的“大模型失联”事件吗?后来我做了这些进阶配置之后,组里谁都可以放心调用 LangChain4j,领导还夸我“提前预判、居安思危”。

总结一下,LangChain4j 四大必配项:

图片

图片