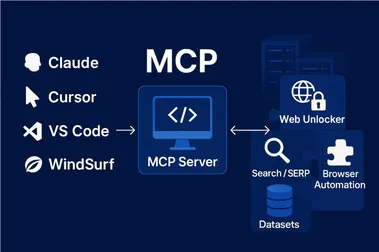

模型上下文协议(MCP)的出现,预示着人工智能应用生态系统即将发生根本性变革。 由 Anthropic 于2024年11月推出的 MCP,旨在规范 AI 应用程序与其训练数据之外的世界进行交互的方式。正如 HTTP 和 REST 为 Web 应用和服务间的连接奠定了基础,MCP 正在为 AI 模型与各种工具的连接建立统一的标准。

虽然关于 MCP 的技术解读已屡见不鲜,但其作为一项“标准”的真正力量往往被忽视。标准化的意义远不止于技术上的统一,它更能催生增长的飞轮效应。早期采纳者将能乘势而上,而忽视者则可能落后于时代。

从混乱走向情境:MCP 如何赋能 AI 应用

想象一下像 Lily 这样的产品经理,她需要同时在 Jira、Figma、GitHub、Slack、Gmail 和 Confluence 等多个工具之间切换,以推进项目。直到大型语言模型(LLM)出现,并在信息整合方面展现出卓越的能力,她才看到一线曙光。如果能将团队使用的所有工具都接入到一个模型中,就能实现自动更新、草拟沟通内容并按需解答疑问。

然而,当时的每个模型都有其连接服务的独特方式,这使得每次集成都将 Lily 更深地绑定在特定供应商的平台上。每当需要接入新的服务(例如 Gong 的通话记录)时,都意味着需要构建新的定制连接,这无疑增加了未来切换到更优 LLM 的难度。

MCP 的出现改变了这一切。这个开放协议标准化了上下文信息流向 LLM 的方式,并迅速获得了 OpenAI、AWS、Azure、Microsoft Copilot Studio 以及即将加入的 Google 等行业巨头的支持。官方 SDK 覆盖了 Python、TypeScript、Java、C#、Rust、Kotlin 和 Swift 等主流编程语言,社区也积极贡献了 Go 等其他语言的 SDK。MCP 的普及速度令人瞩目。

如今,Lily 可以通过 Claude 运行各种功能,并通过本地 MCP 服务器连接到她的工作应用。状态报告自动生成草稿,领导层更新只需一个简单的提示即可完成。随着新模型的出现,她可以轻松替换底层模型,而无需重新构建任何集成。甚至在她编写代码时,也可以在 Cursor 中使用 OpenAI 的模型,并与 Claude 共享同一个 MCP 服务器,让 IDE 能够理解她正在构建的产品。MCP 让这一切变得无缝衔接。

标准的力量与影响:重塑 AI 生态系统

Lily 的故事揭示了一个朴素的真理:用户厌倦了碎片化的工具,反感被供应商锁定,企业也不希望每次更换模型都必须重写集成。人们渴望自由地选择和使用最佳工具,而 MCP 正是实现这一愿景的关键。

标准化带来的影响是深远的:

- 缺乏强大公共 API 的 SaaS 提供商将面临淘汰风险。 MCP 工具依赖于这些 API,客户将要求为其 AI 应用提供支持。随着事实标准的形成,缺乏开放 API 将不再是可接受的理由。

- AI 应用开发周期将大幅缩短。 开发者无需再为简单的 AI 应用编写自定义集成代码,而是可以直接将 MCP 服务器与现成的 MCP 客户端(如 Claude Desktop、Cursor 和 Windsurf)集成。

- 转换成本将显著降低。 由于集成与特定模型解耦,企业可以在 Claude、OpenAI 和 Gemini 等不同模型之间自由切换,甚至混合使用,而无需重建底层基础设施。未来的 LLM 提供商将受益于围绕 MCP 构建的现有生态系统,从而专注于提升模型本身的性价比。

利用 MCP 应对挑战:标准化进程中的摩擦

任何标准的推行都会带来新的挑战,MCP 也不例外:

- 信任至关重要。 目前涌现了大量的 MCP 注册中心和由社区维护的服务器,但如果无法控制或信任服务器的运营方,就可能面临将敏感信息泄露给未知第三方的风险。SaaS 公司应提供官方服务器,开发者应优先选择官方服务器。

- 质量参差不齐。 API 不断发展,维护不善的 MCP 服务器很容易与最新的 API 不同步。LLM 依赖高质量的元数据来选择合适的工具,而目前缺乏权威的 MCP 注册中心,这更加凸显了来自可信机构的官方服务器的重要性。SaaS 公司应随着 API 的更新维护其服务器,开发者应寻求官方服务器。

- 大型 MCP 服务器会增加成本并降低实用性。 将过多的工具捆绑到单个服务器中会增加 token 消耗,并使模型面临过多的选择,导致混淆。构建和分发小型化、专注于特定任务的服务器至关重要。

- 授权和身份验证挑战依然存在。 这些问题在 MCP 出现之前就已存在,MCP 并未完全解决。例如,赋予 LLM 发送邮件的能力时,需要谨慎控制其行为,避免超出预期范围的操作。对于高风险操作,人工监督仍然至关重要。

展望未来:MCP 引领 AI 应用基础设施变革

MCP 并非昙花一现的炒作,而是人工智能应用基础设施的根本性转变。

如同以往被广泛采纳的标准一样,MCP 正在构建一个自我强化的飞轮:每一个新的服务器、每一个新的集成、每一个新的应用程序都在增强其影响力。

新的工具、平台和注册中心正在不断涌现,旨在简化 MCP 服务器的构建、测试、部署和发现过程。随着生态系统的不断发展,AI 应用将提供更简洁的接口来接入新的功能。采用 MCP 协议的团队将能够更快地交付产品,并提供更完善的集成方案。提供公共 API 和官方 MCP 服务器的公司将能积极参与到集成生态中,而那些行动迟缓者则可能逐渐失去竞争力。

正如 Postman 的产品负责人 Noah Schwartz 所言,标准化正在成为驱动下一波人工智能创新浪潮的隐秘而强大的力量。