随着生成式人工智能技术的飞速发展,合成数据正日益成为大模型训练的重要组成部分。未来的 GPT 系列语言模型不可避免地将依赖于由人工数据和合成数据混合构成的大规模语料。

然而,这一趋势也带来了严峻挑战:合成数据如果不加控制地使用,可能引发 “模型崩溃”(Model Collapse)问题。即便仅在一次训练中混入较多比例的合成数据,也可能导致模型性能急剧下降,难以泛化到真实世界的数据中。

最近在 ICML 2025 会议上,来自上交大等研究机构的研究团队系统性地剖析了这一问题,并提出了一种创新的数据生成策略,Token-Level Editing,旨在有效避免模型崩溃。

- 论文标题:HOW TO SYNTHESIZE TEXT DATA WITHOUT MODEL COLLAPSE?

- 论文链接:https://arxiv.org/pdf/2412.14689

不同于直接使用生成数据,该方法在真实数据上引入细粒度的 “微编辑” 操作,从而构建出结构更稳定、泛化性更强的 “半合成” 数据,有效规避了模型崩溃风险。

非迭代式模型崩溃现象识别

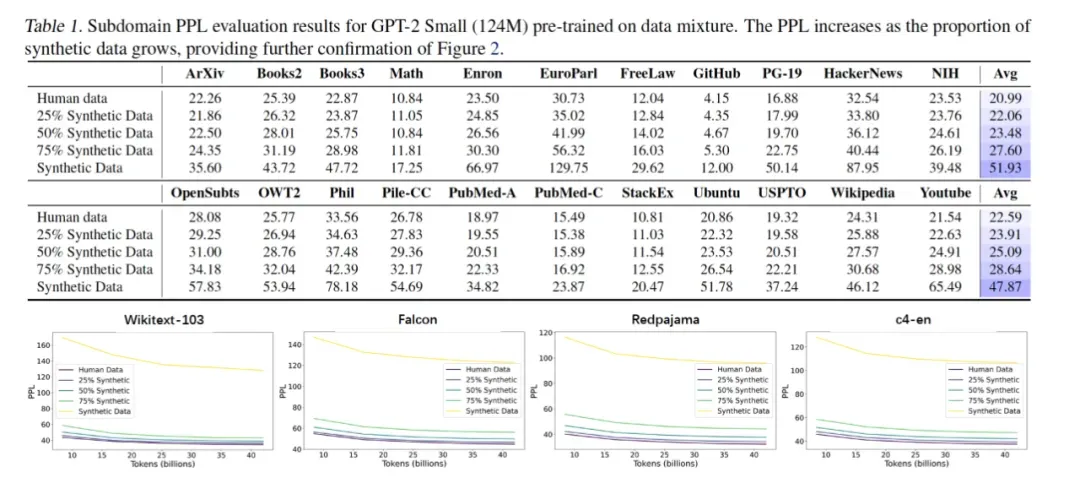

为了揭示合成数据对语言模型训练的影响,研究团队系统分析了不同合成比例下的模型训练行为。实验显示,即使只进行一次预训练,在数据中混入高比例的合成数据,也会显著导致性能下降。这种现象被称为非迭代式模型崩溃(Non-iterative Collapse),并在多个语言理解任务上得到了验证。

通过进一步统计分析,研究发现,合成数据相较于人工数据存在两类结构性缺陷:

- 分布覆盖收窄:缺乏低频与长尾样本,难以体现语言的多样性。

- 特征过度集中:n-gram 等语言特征分布密度过高,易导致模型过拟合。

Token-Level Editing

以编辑替代纯生成

更精细、更高质量的数据生成方式

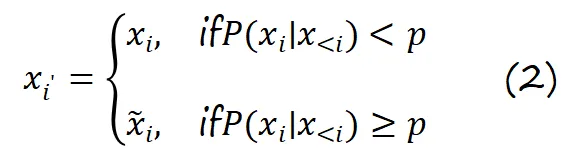

为了解决上述问题,作者团队提出了一种 Token-Level Editing 方法不依赖生成整段文本,而是在训练数据中仅针对模型 “过度自信” 的 token 进行替换,定义如下编辑规则:

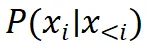

其中, 是模型对

是模型对  的条件概率估计,p 是编辑阈值,

的条件概率估计,p 是编辑阈值, 是从先验分布中重新采样的新 token。这一过程保留了原始数据的长尾结构,仅对 “重复高置信度区域” 进行微调。

是从先验分布中重新采样的新 token。这一过程保留了原始数据的长尾结构,仅对 “重复高置信度区域” 进行微调。

理论结果

测试误差有限上界,避免模型崩溃

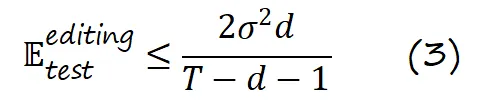

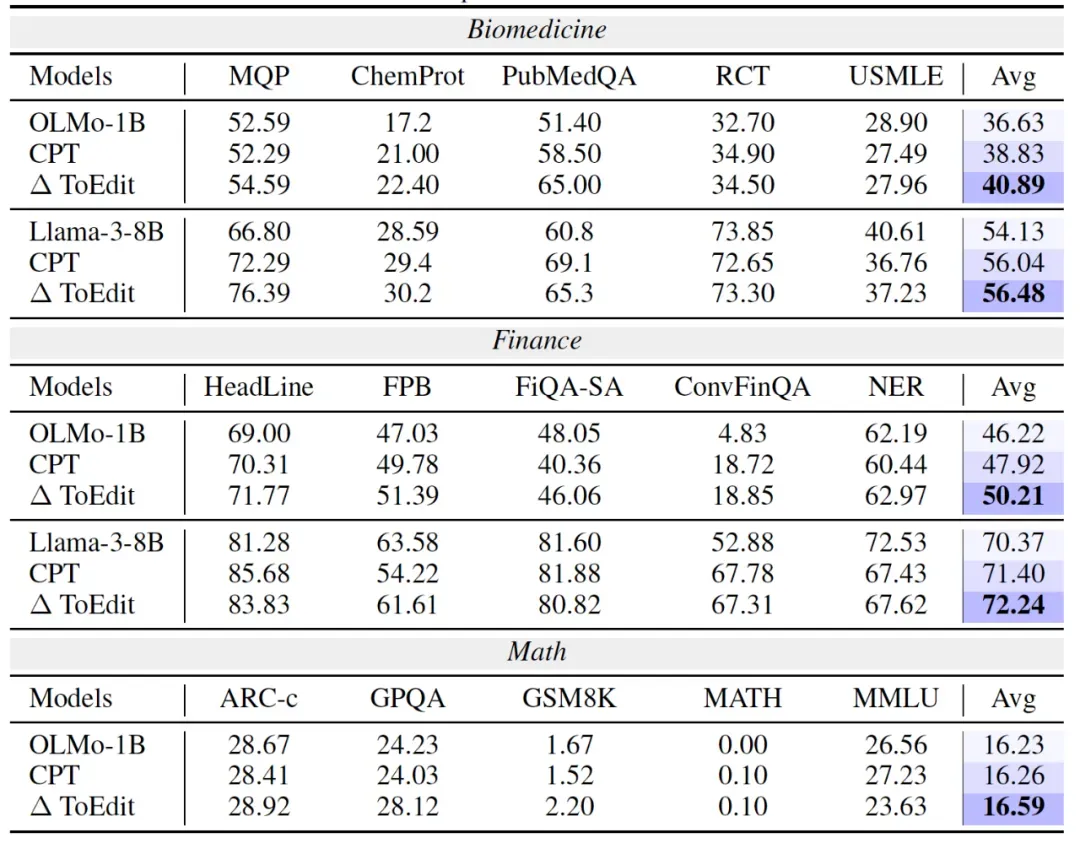

作者进一步构建了线性回归分析框架,并证明 Token-Level Editing 过程的测试误差存在固定上界:

相比模型崩溃中的误差线性上升,这里误差被严格约束,不随迭代轮次增长。其关键原理在于:

每轮编辑操作只对一小部分样本进行调整,模型始终保持对真实数据分布的覆盖,避免了分布转移和特征过度集中。

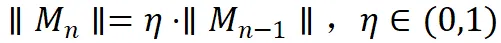

进一步地,如果编辑矩阵 M_n 的影响强度递减(满足  ),则最终误差上界进一步优化为:

),则最终误差上界进一步优化为:

该理论说明,即使在多轮训练中,Token-Level Editing 依然能够从数学上阻止误差的无界增长,实现 “理论上不崩溃” 的数据增强路径。

实验结果

从预训练到微调全面验证方法有效性

为全面验证 Token-Level Editing 的有效性,研究团队在语言模型训练的三个关键阶段进行了系统实验:

- 预训练阶段(Pre-training):在通用任务如 PIQA、BoolQ、Winogrande 等 benchmark 上,模型在引入编辑数据后表现持续优于纯合成数据方案。例如在 OLMo-1B 上,整体任务平均分提升了 +0.36 个百分点。

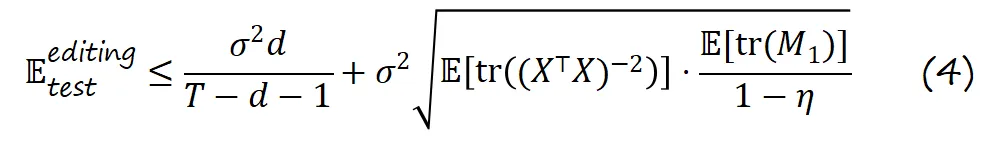

- 持续预训练阶段(Continual Pre-training):在生物医药、金融、数学等专业任务中,Token-Level Editing 带来了跨域的泛化提升。例如在 PubMedQA 任务中,准确率提升高达 +13.6%。

- 监督微调阶段(Supervised Fine-tuning):在指令理解与代码推理等复杂任务中,编辑数据同样展现了对多样语言指令的强鲁棒性。以 LLaMA-3 为例,平均提升 +0.4~0.5%,且在多个任务上保持一致性优势。

此外,为验证方法的稳健性,研究还进行了多轮消融实验,包括:

- 编辑阈值 p 的变化范围;

- 多种采样策略(Top-k、Top-p、拒绝采样);

- 不同 token 置信度分布下的替换比例。

结果显示:在不增加训练数据规模的前提下,该方法依然具备良好可控性与可迁移性,具备强大的实际落地潜力。