HyperAttention

全新近似注意力机制HyperAttention:对长上下文友好、LLM推理提速50%

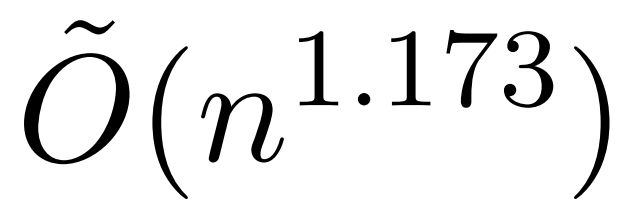

本文介绍了一项近似注意力机制新研究,耶鲁大学、谷歌研究院等机构提出了 HyperAttention,使 ChatGLM2 在 32k 上下文长度上的推理时间快了 50%。Transformer 已经成功应用于自然语言处理、计算机视觉和时间序列预测等领域的各种学习任务。虽然取得了成功,但这些模型仍面临着严重的可扩展性限制,原因是对其注意力层的精确计算导致了二次(在序列长度上)运行时和内存复杂性。这对将 Transformer 模型扩展到更长的上下文长度带来了根本性的挑战。业界已经探索了各种方法来解决二次时间注意力层的

11/13/2023 6:20:00 PM

机器之心

- 1

资讯热榜

标签云

人工智能

OpenAI

AI

AIGC

ChatGPT

AI绘画

DeepSeek

模型

数据

机器人

谷歌

大模型

Midjourney

智能

用户

开源

学习

GPT

微软

Meta

图像

AI创作

技术

论文

Gemini

马斯克

Stable Diffusion

算法

蛋白质

芯片

代码

生成式

英伟达

腾讯

神经网络

研究

Anthropic

计算

3D

Sora

机器学习

AI for Science

AI设计

开发者

GPU

AI视频

华为

场景

人形机器人

预测

百度

苹果

伟达

Transformer

深度学习

Claude

xAI

模态

字节跳动

大语言模型

搜索

驾驶

具身智能

神器推荐

文本

LLaMA

Copilot

训练

算力

视觉

安全

视频生成

干货合集

应用

科技

智能体

大型语言模型

亚马逊

AGI

DeepMind