从人体单图变身高保真3D模型,不知道伤害了多少程序猿头发的行业难题,竟然被港科广团队一招破解了!

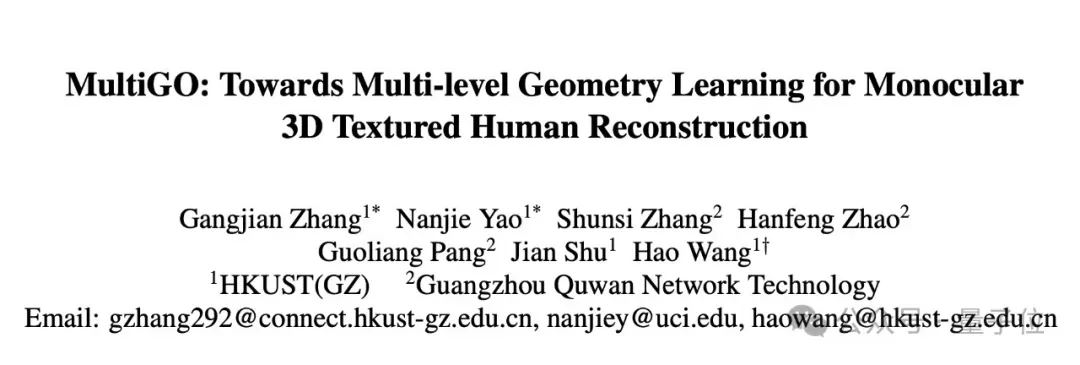

团队最新提出的MultiGO创新方案,借助分层建模思路——将人体分解为不同精度层级,从基础体型到衣物褶皱逐级细化。

这有点像在搭乐高积木:先大模块构建整体轮廓,再用小零件补充细节,最后再处理材质纹理。

相关研究成果目前已入选CVPR 2025,项目代码也在加紧开源的路上。

更多详情,让我们接着继续看~

技术改进路在何方?

传统方法的瓶颈

基于单目图像的三维人体重建存在固有深度歧义性,现有方法通常依赖SMPL-X等人体轮廓的预训练模板提供几何先验,但依然难以捕捉细节特征和特定解剖学结构。

这些方法往往聚焦于人体整体几何建模,而忽视了多层次结构(如骨骼、关节,以及手指、面部等部位的细密皱纹)。这种过度简化的建模方式导致骨骼重建不准确、关节位置偏差,以及衣物皱纹等细节模糊不清。

MultiGO创新框架

该研究提出三级几何学习框架实现突破:

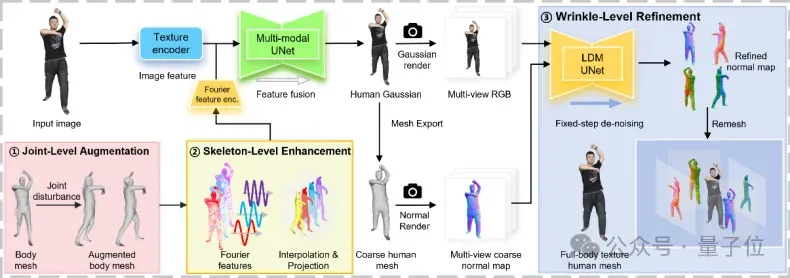

- 骨架增强模块:通过将3D傅里叶特征投影到2D空间,结合SMPL-X人体网格作为几何先验,增强人体骨架建模。傅里叶空间位置编码提升了3D模型与2D图像的语义对齐能力。

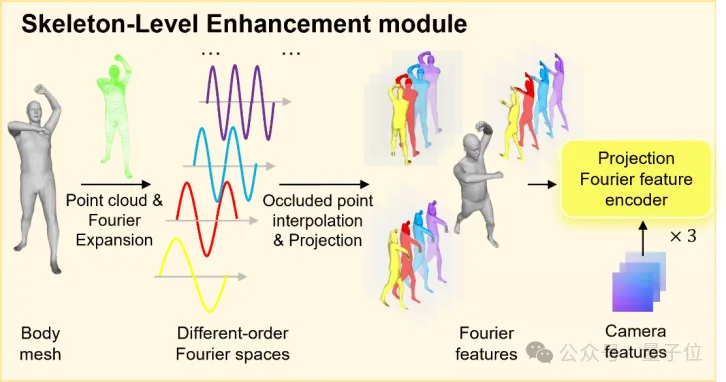

- 关节增强策略:在训练时对关节点位置施加扰动,提升模型对深度估计误差的鲁棒性。通过重点调整影响深度感知的参数,使模型能更好适应实际观测中的结构偏差。

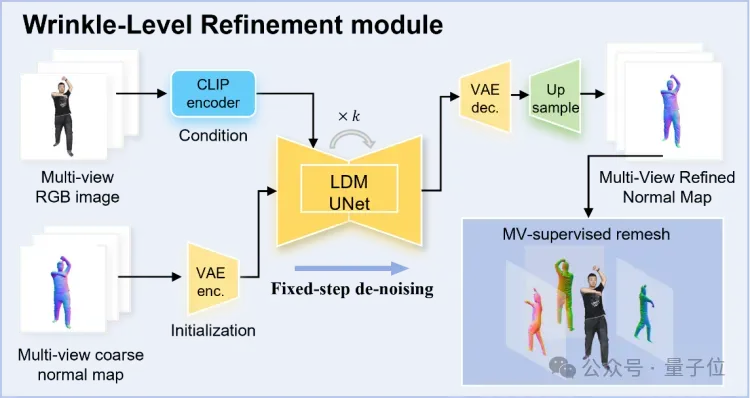

- 皱纹优化模块:采用类似扩散模型去噪的方法,将表面皱纹视为可优化的噪声模式。从粗糙的人体网格中,恢复出更精细化的高频细节。

MultiGO技术解剖

MultiGO方法的核心在于通过多层次几何学习框架全面提升单目纹理3D人体重建的质量。该方法基于现有物体高斯重建预训练模型,针对人体几何的不同粒度层级(骨骼、关节、皱纹)设计了协同优化的三重机制:

- 骨骼层级:骨架增强模块通过将3D傅里叶特征投影到输入图像一致的2D空间,使高斯重建模型能够充分融合先验的人体形态知识,从而精准捕捉人体姿态特征。这种特征投影机制有效解决了单目视角下3D结构信息缺失的问题。

- 关节层级:关节增强策略在训练阶段对真实的SMPL(X)模型的关节参数进行扰动。通过模拟深度不确定性,增强模型对推理过程中关节深度误差的鲁棒性。这种数据增强方式使模型能够学习更稳定的关节空间关系,避免因深度歧义导致的肢体位置重建不准。

- 微观几何细节层面:皱纹优化模块创新性地借鉴扩散理论思想。该模块将粗糙网格视为高斯噪声,而以重建的高质量高斯纹理作为条件输入,通过类似扩散模型去噪的过程逐步优化皱纹等细微几何特征。这种纹理引导的细化机制实现了亚毫米级表面细节的生成,弥补了传统方法在衣物褶皱等高频细节上的不足。

三个层级模块并非孤立运作,而是形成从宏观姿态到微观特征的递进式优化链条:骨架增强模块建立的准确骨骼框架为关节定位提供基础,关节增强策略稳定的关节预测又为皱纹细化创造了低噪声的几何环境。整个框架通过端到端训练实现多层次几何信号的联合优化,最终输出兼具准确拓扑结构和丰富表面细节的高保真3D人体模型。

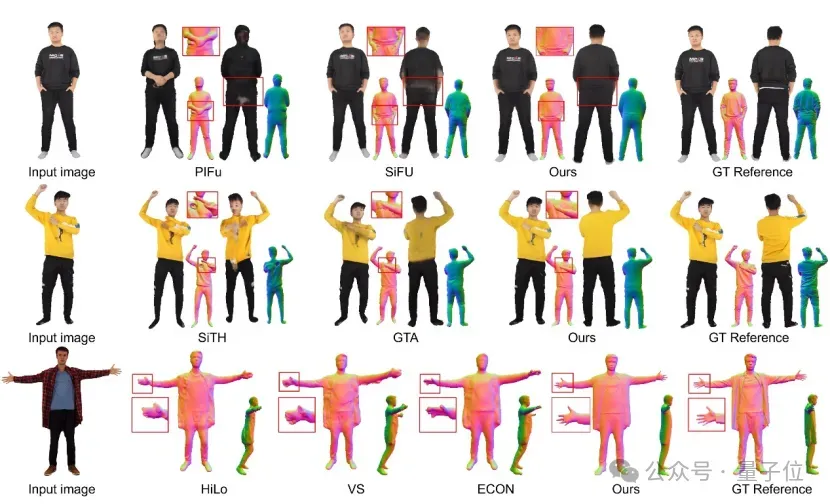

效果show time

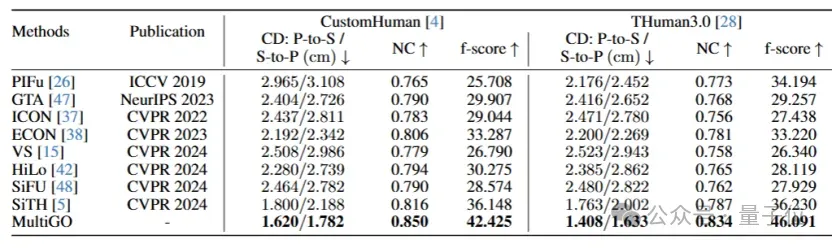

所提出的多层级几何学习框架在CustomHuman和THuman3.0两个测试集上实现了最先进的性能表现,在人体几何重建任务中显著优于其他现有技术:

在CustomHuman数据集上,倒角距离(CD)提升0.180/0.406,法向一致性(NC)提高0.034,f-score增加6.277;在THuman3.0数据集上,CD指标提升0.355/0.369,NC提高0.047,f-score大幅提升9.861。

这种性能突破源于我们提出的创新性解决方案——通过三级分层建模策略(而非传统单一层次建模)精细化处理人体几何特征,从多层次协同优化人体重建效果,从而实现了更精准的几何细节复原。

多场景应用

MultiGO的分层高斯建模技术通过将人体分解为不同精度层级(从基础体型到衣物褶皱和材质纹理逐级细化),并利用高斯溅射点作为3D基元实现高效、高保真的单图重建,使其在虚拟试衣与时尚电商 (实时生成可动态调整的3D人体与服装模型)、游戏与元宇宙 (快速创建个性化虚拟角色并支持细节编辑)以及影视特效 (高精度动态人体重建与后期分层调整)等领域具有突出优势,尤其适合需要快速生成且对真实感和多尺度细节还原要求高的应用场景。

虚拟试衣与时尚电商

消费者上传一张全身照片即可生成高保真3D人体模型,系统能自动模拟不同服装的穿着效果(包括衣物褶皱和材质细节),支持360度查看,提升在线购物体验。结合分层建模能力,可区分用户体型(基础层)与服装细节(精细层),实现动态布料仿真。

游戏与元宇宙角色生成

通过单张照片快速创建个性化的3D虚拟形象,分层结构支持灵活调整(如更换发型、配饰等)。高斯溅射点的特性可保留皮肤纹理和光影细节,增强虚拟角色的真实感。适用于社交元宇宙、NPC批量生成等场景,显著降低美术资源生产成本。

影视特效与虚拟制作

在特效制作中,仅需演员的单视角照片即可重建高精度3D模型,用于动作捕捉或替身合成。分层设计允许后期单独编辑特定层级(如调整肌肉线条或添加伤痕特效)。结合动态高斯溅射点技术,可进一步实现毛发、湿润皮肤等细微效果的实时渲染。

论文链接:https://arxiv.org/pdf/2412.03103项目链接:https://multigohuman.github.io/