KAN

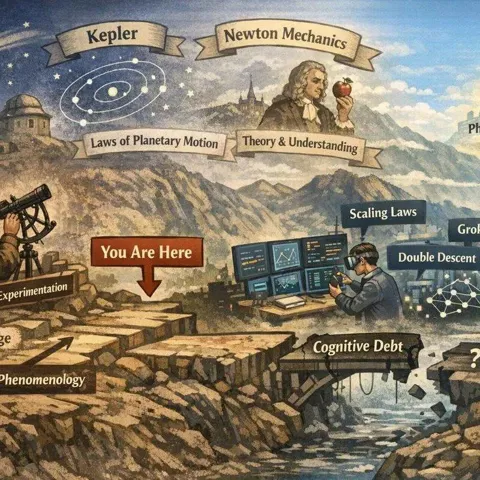

KAN作者刘子鸣:AI还没等到它的「牛顿」

大家新年快乐! 今天和大家分享 KAN 作者刘子鸣最新发布的一篇博客。 过去的一年,我们见证了 Scaling Laws 持续发力,模型能力不断刷新天花板。

爆火后反转?「一夜干掉MLP」的KAN:其实我也是MLP

KAN 作者:我想传达的信息不是「KAN 很棒」,而是「尝试批判性地思考当前的架构,并寻求从根本上不同的替代方案,这些方案可以完成有趣、有用的事情。」多层感知器(MLP),也被称为全连接前馈神经网络,是当今深度学习模型的基础构建块。MLP 的重要性无论怎样强调都不为过,因为它们是机器学习中用于逼近非线性函数的默认方法。但是最近,来自 MIT 等机构的研究者提出了一种非常有潜力的替代方法 ——KAN。该方法在准确性和可解释性方面表现优于 MLP。而且,它能以非常少的参数量胜过以更大参数量运行的 MLP。比如,作者表示

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

AI新词

大模型

机器人

数据

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

智能体

技术

Gemini

英伟达

马斯克

Anthropic

图像

AI创作

训练

LLM

论文

代码

AI for Science

腾讯

苹果

算法

Agent

Claude

芯片

Stable Diffusion

具身智能

xAI

蛋白质

开发者

人形机器人

生成式

神经网络

机器学习

AI视频

3D

RAG

大语言模型

字节跳动

Sora

百度

研究

GPU

生成

工具

华为

AGI

计算

AI设计

生成式AI

大型语言模型

搜索

视频生成

亚马逊

特斯拉

AI模型

DeepMind

场景

深度学习

Copilot

Transformer

架构

MCP

编程

视觉