随着 DeepSeek、GPT、Llama、Mistral 等大规模 LLM 的兴起,AI 从业者面临的最大挑战之一是确定需要多少 GPU 内存才能高效地服务于这些模型。GPU 资源昂贵且稀缺,因此优化内存分配至关重要。

本指南将引导您使用一个简单而有效的公式来估算服务 LLM 所需的 GPU 内存。无论您是部署模型进行推理,还是针对特定任务进行微调,这些知识都将帮助您有效地规划基础架构。

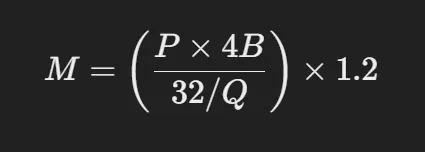

GPU内存估算公式

为了计算服务 LLM 所需的 GPU 内存,我们使用以下公式:

参数说明:

M:所需的 GPU 内存(以千兆字节 (GB)为单位)

P:模型中的参数数量(例如,7B 模型有 70 亿个参数)

4B:每个参数 4 个字节(假设全精度 FP32)

32:4 个字节有 32 位

Q:每个参数用于模型存储的位数(例如,FP16 = 16 位、INT8 = 8 位等)

1.2:表示激活存储、注意键值缓存等额外内存需求的20% 开销。

此公式可帮助您确定在考虑不同量化级别和开销的同时将模型加载到内存中需要多少 GPU 内存。

示例

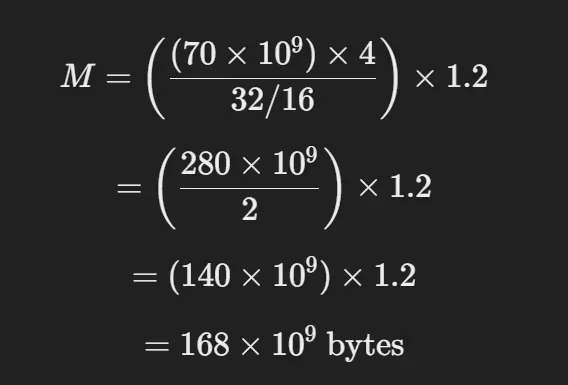

假设您想估算FP16 精度的Llama 70B所需的 GPU 内存。

鉴于:

P = 70B(700亿个参数)

Q = 16(因为我们使用 FP16 精度)

开销系数 = 1.2

现在,应用公式:

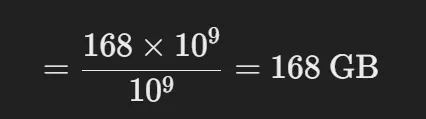

转换为GB:

由于1 GB = 10⁹ 字节,我们除以10⁹:

因此,要在FP16中加载 Llama 70B,您需要168GB 的 GPU 内存。

量化会发生什么?

量化使我们能够以较低的精度存储模型权重,从而减少内存需求。以下是 Llama 70B 在不同位格式下所需的内存量:

- 精度 (Q) GPU 内存要求

- FP32(32 位)336 GB

- FP16(16位)168 GB

- INT8(8位)84 GB

- 4位量化42GB

关键要点:

精度较低的模型所需的GPU 内存明显较少。

4 位量化非常节省内存,大量模型可以适应 RTX 4090(24GB VRAM)等消费级 GPU。

FP16 是平衡性能和内存使用情况的行业标准。

优化模型部署

如果你的 GPU 内存有限,这里有一些优化策略:

- 使用量化:将模型转换为 8 位或 4 位以减少内存占用。

- 卸载到 CPU:一些权重可以卸载到 CPU,从而减少 GPU 内存使用量。

- 使用模型并行性:在多个 GPU 之间分割模型权重。

- 优化KV Cache:减少存储注意键值对的数量。

- 利用高效的服务框架:使用 vLLM 或 TensorRT-LLM 等工具进行优化推理。

小结

计算用于服务 LLM 的 GPU 内存对于高效扩展 AI 应用程序至关重要。使用上面的简单公式,您可以估算不同精度级别所需的 VRAM,并相应地优化部署。

如果您正在处理像 Llama 70B 这样的大规模模型,量化和并行性是控制 GPU 成本的最佳方法。通过应用这些优化,您可以运行强大的 AI 模型,而无需在高端硬件上投入巨资。