刚刚,ICLR 2025时间检验奖公布!

斩获大奖的是,xAI工程师、Hinton高徒Jimmy Ba发表的Adam优化器。

获得亚军的是,Yoshua Bengio团队提出的「注意力机制」,为Transformer和大模型奠定了基础。

每年,ICLR时间检验奖都会颁给10年前发表,且对领域产生持久影响的论文。

滑铁卢大学CS助理教授Gautam Kamath做了一个总结:

- OpenAI联创Diederik P. Kingma已连续第二次拿下ICLR ToT大奖,去年因VAEs论文获奖

- 今年ToT冠军/亚军,全都授予加拿大高校的学者

- 2024年和2025年亚军来自NYU团队

时间检验奖

ICLR 2025时间检验奖公布,再次让所有人见证了深度学习领域的「黄金十年」。

Adam优化器让大模型训练更快更稳,注意力机制更是赋予了AI超强理解力,成为深度学习领域的重要里程碑。

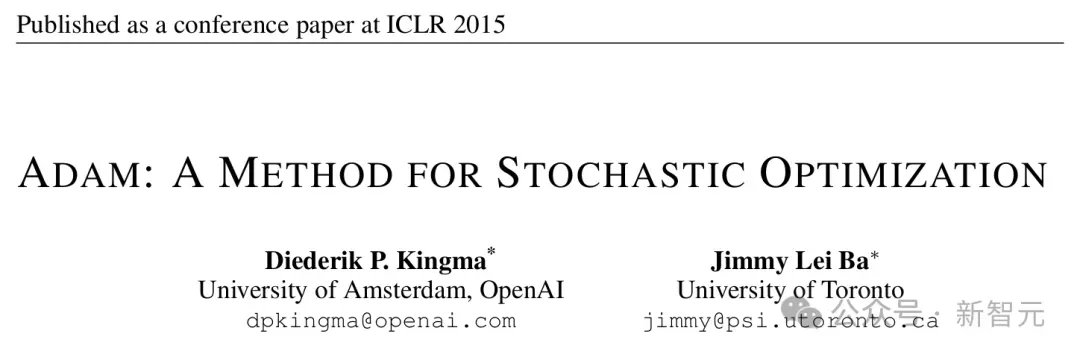

Adam优化器:深度学习「加速引擎」

标题:Adam: A Method for Stochastic Optimization

作者:Diederik P. Kingma, Jimmy Ba

机构:阿姆斯特丹大学/OpenAI、多伦多大学

论文地址:https://arxiv.org/abs/1412.6980

如果说深度学习是一辆飞驰列车,那么Adam优化器就是它的「超级引擎」。

2015年,由Diederik P. Kingma和Jimmy Ba提出的Adam算法,彻底改变了神经网络训练的方式。

Adam全称是Adaptive Moment Estimation,通过结合梯度算法的一阶矩和二阶矩,自动调整学习率,不仅加速了模型收敛,还提升了训练的稳定性。

它之所以成为深度学习领域,重要的算法之一,其魅力在于不同领域和神经架构中的通用性与高效性。

无论是CV、NLP、还是RL,Adam几乎成为所有深度学习模型的默认优化器,成为无数顶尖模型的基石。

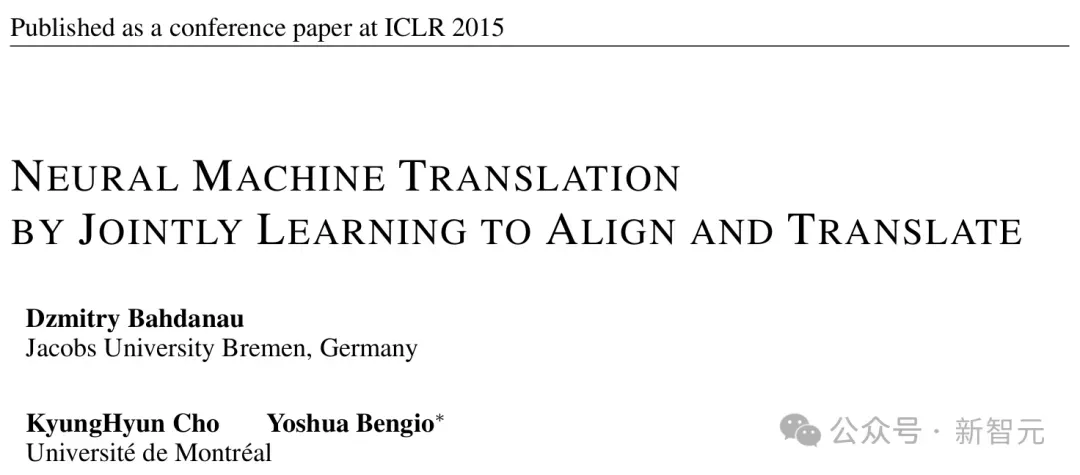

注意力机制:Transformer前世今生

标题:Neural Machine Translation by Jointly Learning to Align and Translate)

作者:Dzmitry Bahdanau, Kyunghyun Cho, Yoshua Bengio

机构:康斯特大学、蒙特利尔大学

论文地址:https://arxiv.org/abs/1409.0473

由Yoshua Bengio带队这篇论文,首次引入了注意力机制(Attention Mechanism),为现代深度学习架构奠定了基础。

它从根本上改变了序列到序列模型处理信息的方式。

在此之前,编码器-解码器架构通常将整个输入序列,压缩成固定长度向量,面对较长序列往往捉襟见肘。

Bengio团队的突破在于,让模型能够「动态关注」输入序列相关部分,极大地提升了翻译任务的性能。

要知道,这篇论文的影响力远远超出了机器翻译领域。

2017年,Attention is All You Need开山之作出世,注意力机制成为了Transformer模型的核心,催生了BERT、GPT系等大模型的繁荣。

如今,几乎所有顶尖的AI模型都离不开注意力机制的加持。

正因如此,这篇论文也被业界誉为「现代深度学习的基石」。

深度学习巨擘领衔

这两篇2015年里程碑式论文荣登榜首,分别是由图灵奖得主Yoshua Bengio,以及Jimmy Ba领衔。

正如Gautam Kamath所指出那样,加拿大在深度学习领域的领先地位。

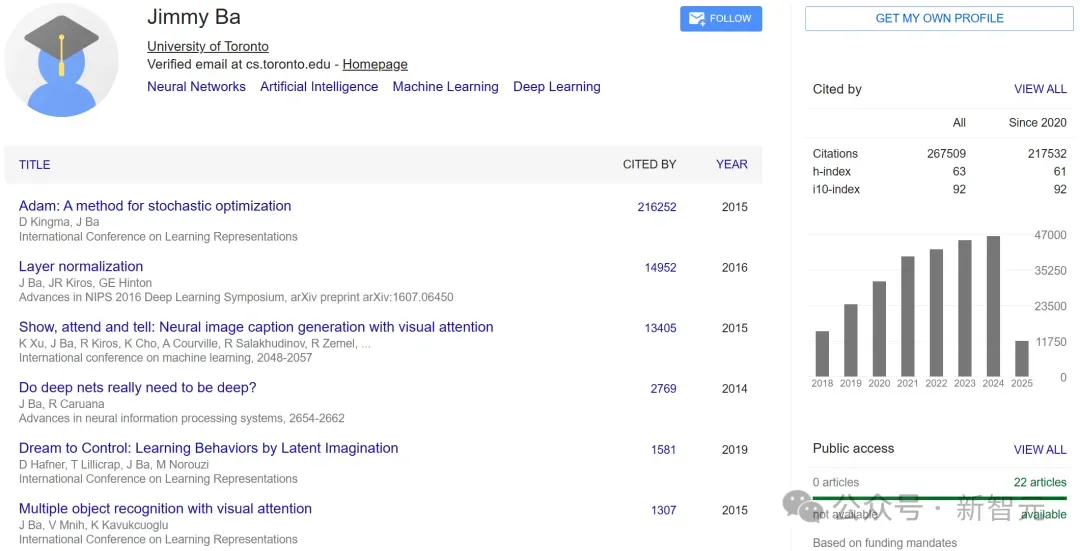

Jimmy Ba

作为Adam论文共同作者,Jimmy Ba的学术轨迹堪称耀眼。

他分别于2011年和2014年获得了多伦多大学本科与硕士学位,分别师从Brendan Frey和Ruslan Salakhutdinov教授。

博士期间,他又在多伦多大学跟着Geoffrey Hinton学习。

Jimmy Ba的长期研究目标致力于解决一个核心计算问题:如何构建具备类人效率和适应性的通用问题求解机器?

具体而言,他的研究聚焦于为深度神经网络开发高效的学习算法。

他的研究成果频频亮相NeurIPS、ICLR和ICML顶会,2016年更是摘得Facebook机器学习方向研究生奖学金(Facebook Graduate Fellowship)。

目前,Google Scholar主页显示,Adam这篇论文被引超20万。

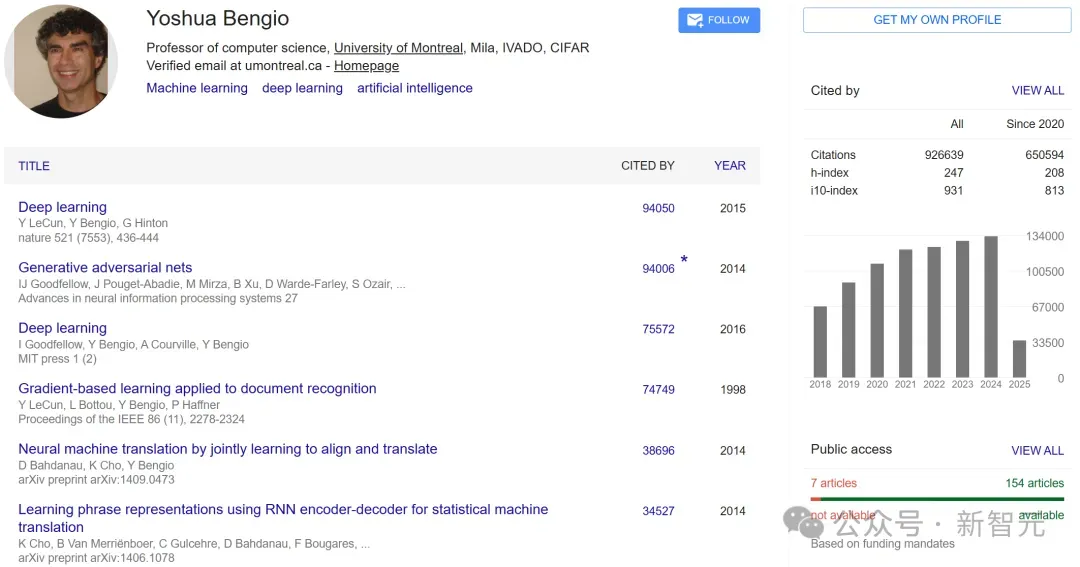

Yoshua Bengio

提到Yoshua Bengio,AI界无人不晓。

作为深度学习三巨头之一,他的每项研究都在改写AI的历史。

Yoshua Bengio,生于1964年3月5日是一位加拿大-法国籍计算机科学家,也是人工神经网络和深度学习领域的先驱。他是蒙特利尔大学的教授,也是AI研究所MILA的科学总监。

他在麦吉尔大学获得了理学学士学位(电气工程)、理学硕士学位(计算机科学)和博士学位(计算机科学)。

获得博士学位后,Bengio曾在MIT(导师是Michael I. Jordan)和AT&T贝尔实验室担任博士后研究员。

自1993年以来,他一直是蒙特利尔大学的教员,领导着MILA,并且是加拿大高等研究院(CIFAR)「机器与大脑学习」项目的联合主任。

2017年,Bengio被授予加拿大勋章。同年,他被提名为加拿大皇家学会会士,并获得了Marie-Victorin Quebec奖。

2018年,他与Geoffrey Hinton和Yann LeCun因其在深度学习领域的基础性工作,共同获得了计算领域的「诺贝尔奖」——ACM图灵奖。

2020年,他当选为英国皇家学会会士。2022年,他与Geoffrey Hinton、Yann LeCun和Demis Hassabis共同获得了「科学研究」类别的阿斯图里亚斯女亲王奖。

2023年,Bengio被授予法国最高荣誉勋章——荣誉军团骑士勋章。同年,被评为ACM Fellow。

2025年,Bengio与Bill Dally、Geoffrey E. Hinton、John Hopfield、Yann LeCun、黄仁勋和李飞飞共同获得了伊丽莎白女王工程奖。

Google Scholar个人主页中,Bengio总被引数破90万,其中被引量最高的论文便是与LeCun和Hinton共同撰写的「深度学习」的论文。

有趣的是,他的兄弟Samy Bengio也是一位在神经网络领域很有影响力的计算机科学家,目前担任苹果AI和机器学习研究高级总监。