科学界的一个共识是:即使是最复杂的现代人工智能,也难以媲美人类大脑的表现和效率。

研究者经常从大自然中寻找灵感,了解如何在人工智能领域取得进步,例如利用进化来合并模型、为语言模型进化出更高效的记忆或探索人工生命的空间。虽然人工神经网络近年来让人工智能取得了非凡的成就,但它们仍然是其生物对应物的简化表征。所以,能否通过结合生物大脑中的特征,将人工智能的能力和效率提升到新的水平?

他们决定重新思考认知核心的一个重要特征:时间。

刚刚,Transformer 作者之一 Llion Jones 联合创立的的Sakana AI 发布了「连续思维机器」(Continuous Thought Machine,CTM),这是一种将神经元活动同步作为其核心推理机制的人工智能模型,也可看作一种新型人工神经网络,它利用神经元动态之间的同步来完成任务。

- 博客地址:https://sakana.ai/ctm/

- 技术报告:https://pub.sakana.ai/ctm/paper/index.html

- 代码地址:https://github.com/SakanaAI/continuous-thought-machines/

与传统人工神经网络不同,CTM 在神经元层面使用定时信息,从而实现了更复杂的神经行为和决策过程。这一创新使该模型能够逐步「思考」问题,使其推理过程具有可解释性和类人性。

研究表明,在各种任务中,机器人解决问题的能力和效率都有所提高。

Sakana AI 表示,CTM 是弥合人工神经网络与生物神经网络之间差距的重要一步,有可能开启人工智能能力的新领域。

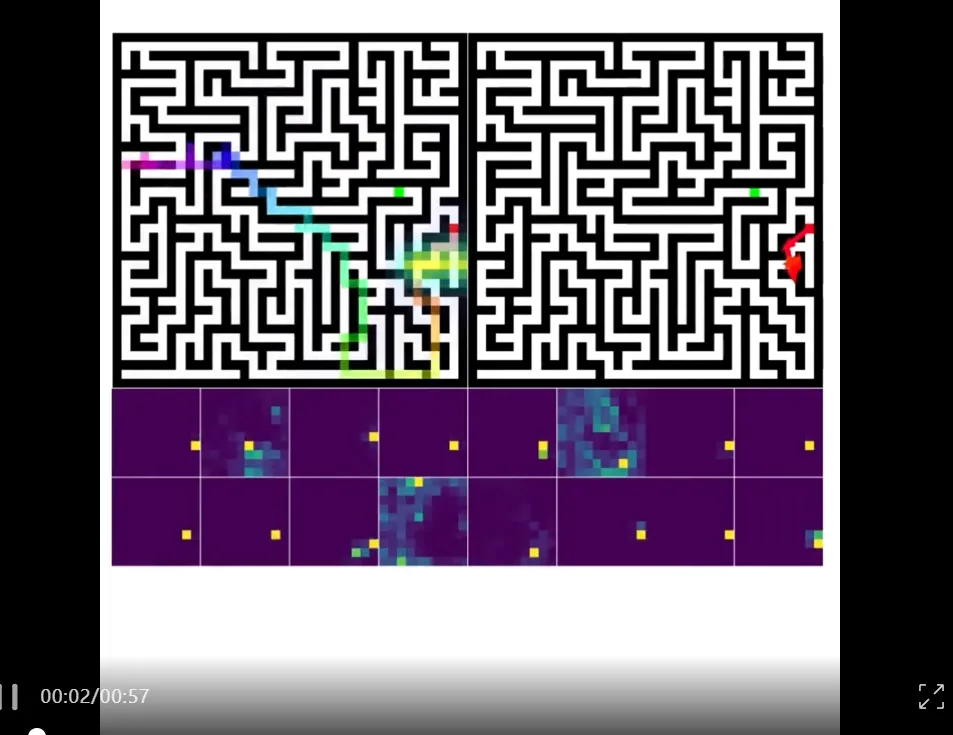

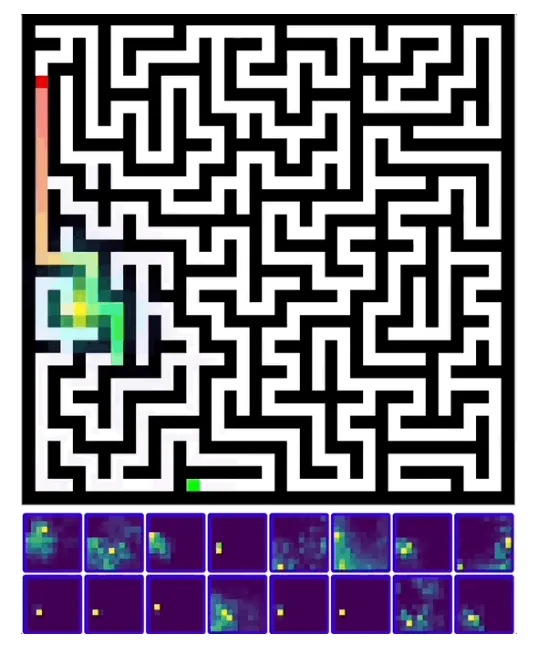

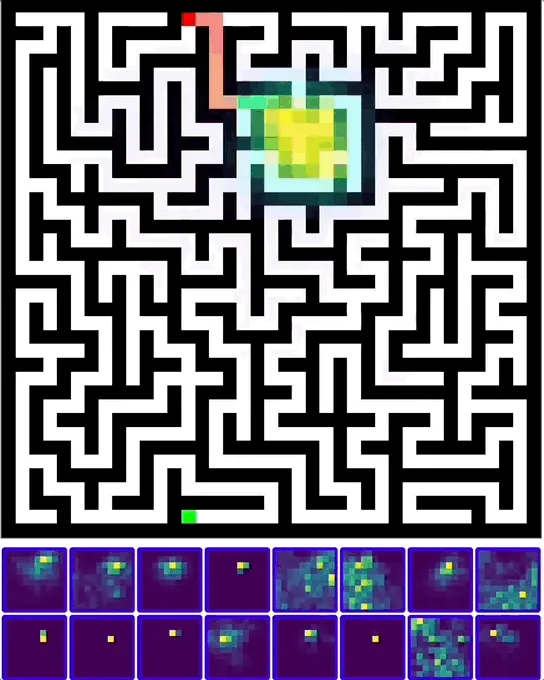

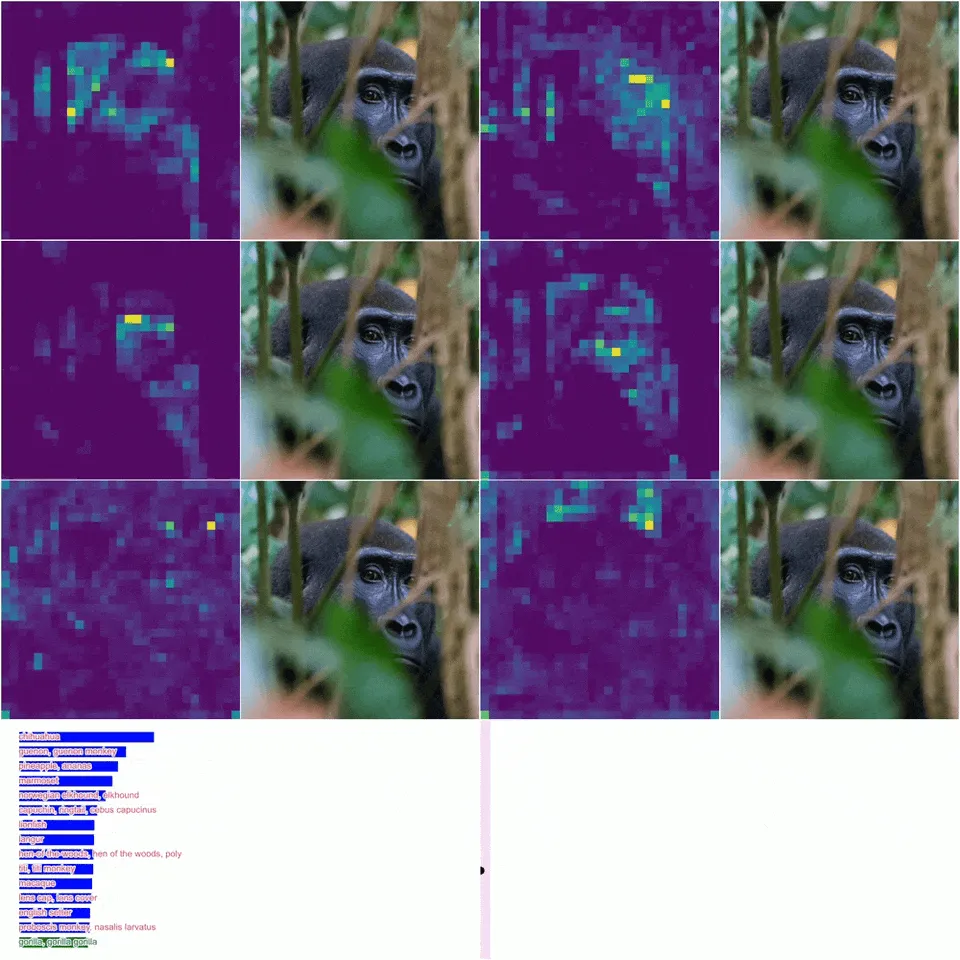

CTM 解迷宫和思考真实照片的可视化(图片来源:Alon Cassidy)。值得注意的是,尽管 CTM 的设计并不明确,但它在迷宫中学会的解法却非常容易解释,而且类似于人类,可以看到它在「思考」解法时描绘出通过迷宫的路径。对于真实图像,虽然没有明确的激励措施让它四处查看,但它会以直观的方式查看。

研究创新

尽管随着 2012 年深度学习的出现,人工智能的能力有了重大飞跃,但自 20 世纪 80 年代以来,人工智能模型中使用的人工神经元基本模型在很大程度上一直没有改变。研究人员仍然主要使用神经元的单一输出,这代表了神经元的激发情况,却忽略了神经元相对于其他神经元激发的精确时间。

不过,有力的证据表明,这种定时信息在生物大脑中至关重要,例如在依赖于尖峰定时的可塑性中,它是生物大脑功能的基础。

在新模型中,Sakana AI 用来表示这种信息的方法是让神经元访问自身的行为历史,并学习如何利用这些信息来计算自身的下一个输出,而不仅仅是知道自身的当前状态。这样,神经元就能根据过去不同时期的信息改变自己的行为。此外,新模型的主要行为是基于这些神经元之间的同步,这意味着它们必须学会利用这些时间信息来协调完成任务。研究者认为,与当代模型中观察到的情况相比,这将产生更丰富的动态空间和不同的任务解决行为。

在添加了这种定时信息后,Sakana AI 在许多任务中看到了一系列非同寻常的行为。他们看到的行为具有很强的可解释性:在观察图像时,CTM 会小心翼翼地在场景中移动其视线,选择关注最显著的特征,而且它在某些任务中的表现有所提高。这让研究者惊讶于神经元活动动态中的行为多样性。

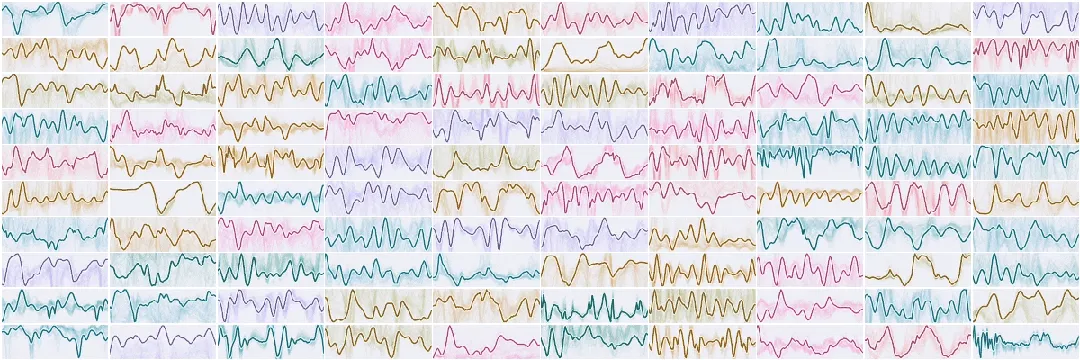

CTM 中的神经元动态样本,显示神经元如何随不同的输入而变化。CTM 显然学会了多种神经元行为。每个神经元(随机颜色)如何与其他神经元同步。研究者对其进行测量,并将其作为 CTM 的表征。

新模型的行为基于一种新的表征:神经元之间随时间的同步。研究者认为这更容易让人联想到生物大脑,但并非严格意义上的仿真。他们将由此产生的人工智能模型称为「连续思考机器」,它能够利用这种新的时间维度、丰富的神经元动态和同步信息来「思考」任务,并在给出答案前制定计划。

命名中使用「连续」一词,是因为 CTM 在推理时完全在内部「思考维度」运行。它对所消耗的数据是异步的:它可以以相同的方式对静态数据(如图像)或顺序数据进行推理。研究者在大量任务中测试了这一新模型,发现它能够解决各种问题,而且通常是以一种非常可解释的方式。

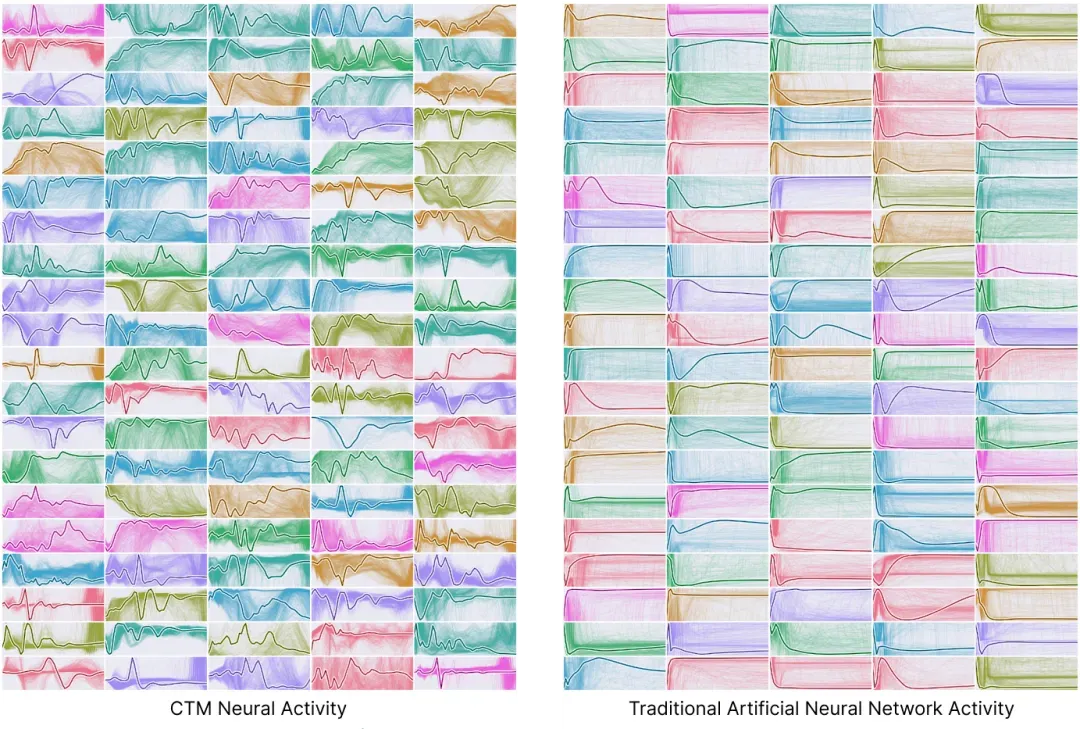

研究者观察到的神经元动态在某种程度上更像是在真实大脑中测量到的动态,而不是更传统的人工神经网络,后者表现出的行为多样性要少得多(请参阅下图与经典人工智能模型 LSTM 的比较)。CTM 显示了以不同频率和振幅振荡的神经元。有时,单个神经元会出现不同频率的振荡,而其他神经元只有在完成任务时才会出现活动。值得强调的是,所有这些行为都是完全突发的,并没有设计到模型中,而是作为添加定时信息和学习解决不同任务的副作用出现的。

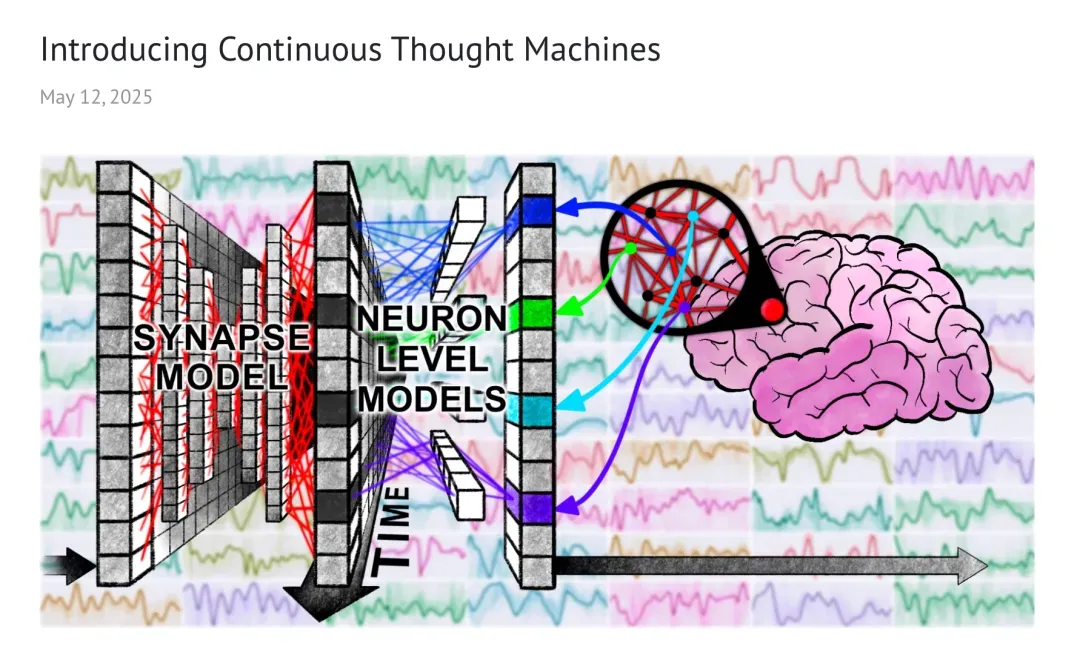

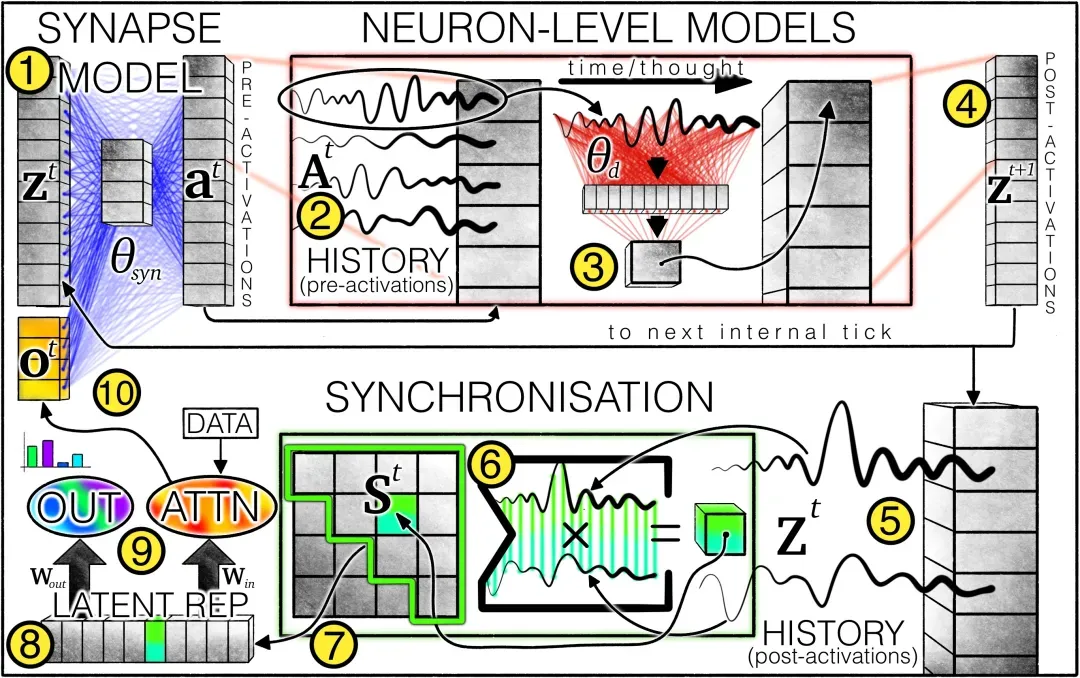

CTM 完整架构如下图所示,其中①为突触模型(权重用蓝线表示),建模跨神经元交互以产生预激活。对于每个神经元,②都会保留预激活的历史记录,其中最新的历史记录被 ③神经元级模型(权重用红线表示)用于产生④后激活。此外还会保留 ⑤ 后激活的历史记录,并用于 ⑥ 计算同步矩阵。从同步矩阵中选择⑦神经元对,从而产生⑧潜在表征。CTM 用这些表征⑨产生输出并通过交叉注意力机制调制数据。调制后的数据(例如注意力输出)将与后激活连接起来⑩,用于下一个内部时钟周期。

CTM 架构的测试效果

由于新增了时间维度,CTM 的一大优势在于:可以观察并直观地看到它如何随着时间的推移解决问题。传统的 AI 系统可能只需通过神经网络一次性对图像进行分类,而 CTM 可以分多个步骤来「思考」如何解决任务。

下面展示了两个任务:解迷宫和照片中的物体分类。

首先来看解迷宫(Maze Solving)任务。在这个任务中,CTM 会被呈现一个自上而下的 2D 迷宫,并被要求输出走出迷宫所需的步骤。这种模式尤其具有挑战性,因为模型必须理解迷宫构造并规划解决方案,而不是简单地输出路径的视觉表示。

CTM 内部连续的「思考步骤」使其能够制定计划,从而可以直观地看到它在每个思考步骤中关注迷宫的哪些部分。值得注意的是,CTM 学会了一种非常类似于人类的解迷宫方法 —— 在它的注意力模式中沿着迷宫路径前进。

CTM 的行为模式尤其令人印象深刻,因为它自然而然地从模型架构中涌现出来。研究者并没有特意设计 CTM 来追踪迷宫中的路径,它通过学习自行开发展了这种方法。他们还发现,当允许 CTM 进行更多思考步骤时,它会持续沿着训练好的路径前进,这表明它确实学会了解决这个问题的通用方法。

CTM 的行为模式尤其令人印象深刻,因为它自然而然地从模型架构中涌现出来。研究者并没有特意设计 CTM 来追踪迷宫中的路径,它通过学习自行开发展了这种方法。他们还发现,当允许 CTM 进行更多思考步骤时,它会持续沿着训练好的路径前进,这表明它确实学会了解决这个问题的通用方法。

接下来是图像识别任务。传统的图像识别系统只需一步即可做出分类决策,而 CTM 则需要多个步骤来检查图像的不同部分,然后再做出决策。这种循序渐进的方法不仅使人工智能的行为更易于解释,也提高了准确率:它「思考」的时间越长,答案就越准确。

研究者还发现,这种方法使得 CTM 能够减少在简单图像上思考的时间,从而节省算力。例如,在识别大猩猩时,CTM 的注意力会从眼睛转移到鼻子,再转移到嘴巴,这与人类的视觉注意力模式非常相似。

这些注意力模式为我们了解模型的推理过程提供了一个窗口,展示了它认为哪些特征与分类目标最相关。这种可解释性不仅有助于理解模型的决策,还可能有助于识别和解决偏差或故障模式。

结论

尽管现代人工智能以「人工神经网络」的形式建构在大脑之上,但即使在今天,人工智能研究与神经科学之间的重叠仍然少得惊人。AI 研究人员选择沿用上世纪 80 年代开发的极简模型,并且得益于简单易用、训练高效等属性,这些模型在推动人工智能发展方面持续取得成功。

另一方面,神经科学可以创建更精确的大脑模型,但其主要目的是理解大脑,而非试图创建更高级的智力模型。当然,两者之间可能存在某种关联。这些神经科学模型尽管更加复杂,但性能往往仍低于当前最先进的 AI 模型,因此,这类模型可能在人工智能应用领域缺乏进一步研究的吸引力。

尽管如此,研究者认为,如果现代人工智能在某些方面不能继续向大脑的工作方式靠拢,我们将错失良机。我们或许能够通过这种方式创建更强大、更高效的模型。2012 年,得益于受大脑启发的神经网络模型,AI 能力出现跃升,「深度学习革命」才出现。

为了继续推动这一进步,是否应该继续受到大脑的启发呢?CTM 是研究者首次尝试弥合这两个领域之间的差距,它展现出一些更像大脑行为的初步迹象,同时仍然是一个可以解决重要问题的实用人工智能模型。

研究者希望能够继续推动模型朝着这个受自然启发的方向发展,并探索可能出现的新功能。关于 CTM 在不同任务中的行为,请参阅原始技术报告。